「自然言語処理の技術比較:RNN、トランスフォーマー、BERT」

「美容とファッションの世界を彩るアイテムとトレンド」

自然言語処理(NLP)は、機械がテキストデータを理解する能力を持つための人工知能の分野です。NLPの研究は長い間存在してきましたが、ビッグデータの導入や高度な計算処理能力の向上に伴い、より注目を浴びるようになりました。

NLPの分野が大きくなるにつれ、多くの研究者がテキストデータの理解能力を向上させようと試みるようになりました。進歩を遂げるにつれて、多くの技術がNLPの分野で提案され、適用されています。

この記事では、NLPの分野におけるテキストデータの処理技術を比較します。この記事では、RNN、トランスフォーマー、BERTに焦点を当て、それらが研究でよく使用されるものとしています。さあ、始めましょう。

- 「深層学習による遺伝子制御の解明:オルタナティブスプライシングの理解に向けた新たなAIアプローチ」

- ‘LinkedInの仕事検索機能を支える埋め込みアーキテクチャの内部’

- Mistral-7B-v0.1をご紹介します:新しい大型言語モデルの登場’ (Misutoraru 7B v0.1 wo goshōkai shimasu Atarashii ōgata gengo moderu no tōjō)

再帰ニューラルネットワーク(RNN)

再帰ニューラルネットワーク、またはRNNは1980年に開発されましたが、最近になってNLPの分野で注目を浴びるようになりました。RNNは、連続データや他のデータと独立して処理できないデータのために使用される、ニューラルネットワークファミリー内の特定のタイプです。連続データの例としては、時系列データ、音声、またはテキストの文データなど、意味のある順序を持つあらゆる種類のデータが含まれます。

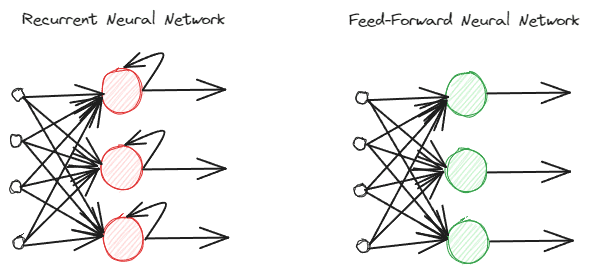

RNNは、通常の順送信型ニューラルネットワークとは異なる情報処理方法を使用します。通常の順送信では、情報はレイヤーに従って処理されますが、RNNでは情報入力にループサイクルを使用して処理されます。違いを理解するために、以下のイメージをご覧ください。

ご覧の通り、RNNモデルは情報処理中にループサイクルを実装しています。RNNは、この情報を処理する際に現在のデータ入力と前のデータ入力を考慮します。そのため、このモデルはあらゆる種類の連続データに適しています。

テキストデータの例を挙げると、文「私は午前7時に起きます」という文があり、単語が入力されるとします。順送信型ニューラルネットワークでは、単語「up」に到達すると、モデルは既に単語「私」、「起きる」、「up」を忘れてしまっています。しかし、RNNでは、各単語ごとに出力を使用し、それらをループバックさせるため、モデルが忘れないようになります。

NLPの分野では、RNNはテキスト分類や生成などの多くのテキストアプリケーションでよく使用されます。品詞タグ付け、次の単語の生成などのワードレベルのアプリケーションで頻繁に使用されます。

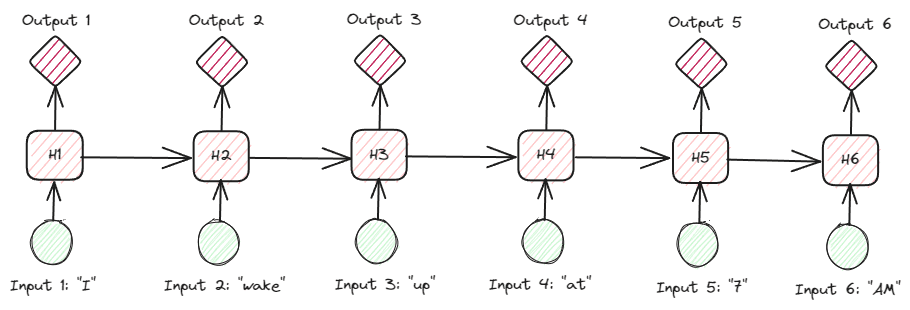

テキストデータの中でRNNをより詳しく見ると、さまざまな種類のRNNが存在します。例えば、以下のイメージは多対多のタイプです。

上のイメージを見ると、各ステップ(RNNのタイムステップ)の出力が一度に1つずつ処理され、すべての反復が常に前の情報を考慮していることがわかります。

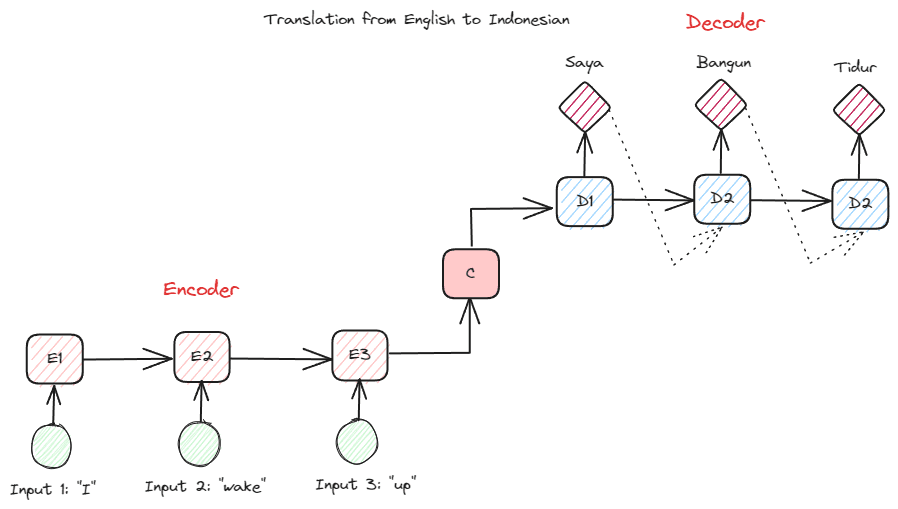

NLPの多くのアプリケーションで使用されるもう1つのRNNタイプは、エンコーダーデコーダータイプ(シーケンス対シーケンス)です。この構造は、以下のイメージで示されています。

この構造では、モデル内で使用される2つのパーツが導入されています。最初の部分はエンコーダーと呼ばれ、データシーケンスを受け取り、それに基づいて新しい表現を作成します。この表現はモデルの2番目のパートであるデコーダーで使用されます。この構造により、入力と出力の長さは必ずしも等しくする必要はありません。例えば、言語の翻訳では、入力と出力の間には同じ長さがないことがよくあります。

自然言語データを処理するためにRNNを使用することのさまざまな利点があります。具体的には、次のような点が挙げられます:

- RNNは制限のないテキスト入力を処理するために使用できます。

- モデルはすべてのタイムステップで同じパラメータを使用することができるため、同じ重みを共有します。

- 過去の入力の記憶を持つことにより、RNNはあらゆる連続データに適しています。

しかし、いくつかの欠点もあります:

- RNNは勾配消失および勾配爆発の両方に対して脆弱です。これは、勾配結果がほぼゼロの値(勾配消失)になり、ネットワークの重みがほんのわずかしか更新されないか、勾配結果が非常に重要な値(勾配爆発)になり、ネットワークに非現実的な極めて重要な意味を割り当てることがあるからです。

- モデルの順序的な性質のため、研修時間が長いです。

- 短期記憶は、モデルが訓練されるにつれて忘れ始めることを意味します。この問題を緩和するために、RNNの拡張であるLSTMがあります。

トランスフォーマー

トランスフォーマーは、以前のRNNで遭遇したシーケンス・トゥ・シーケンスのタスクを解決しようとするNLPモデルアーキテクチャです。前述のように、RNNは短期記憶に問題があります。入力が長いほど、モデルは情報を忘れることがより顕著になります。そのため、アテンションメカニズムがこの問題を解決するのに役立ちます。

アテンションメカニズムは、Bahdanau et al. (2014)によって紹介された論文で、特にエンコーダーデコーダータイプのRNNで長い入力問題を解決するために導入されました。アテンションメカニズムの詳細については説明しませんが、基本的にはモデルが出力予測を行う際にモデルの入力の重要な部分にフォーカスするためのレイヤーです。たとえば、単語入力の「Clock」は、翻訳の場合、インドネシア語で「Jam」と非常に関連している可能性が高いでしょう。

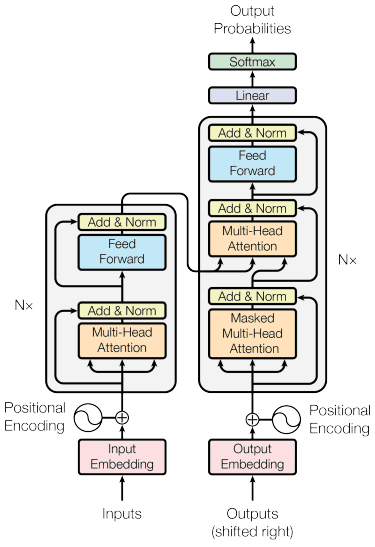

トランスフォーマーモデルは、Vaswani et al. (2017)によって紹介されました。このアーキテクチャはエンコーダーデコーダーRNNに触発され、アテンションメカニズムを考慮して構築され、データを順次処理しません。全体的なトランスフォーマーモデルは以下のように構造化されています。

上記の構造では、トランスフォーマーはデータベクトルシーケンスを単語の埋め込みにエンコードし、位置エンコーディングを使用してデータを元の形式に変換します。アテンションメカニズムが効果的に機能するため、エンコーディングは入力に応じて重要度を持つことができます。

トランスフォーマーは、他のモデルと比較していくつかの利点を提供しています:

- 並列化処理により、トレーニングおよび推論速度が向上します。

- より長い入力を処理することができ、コンテキストの理解を向上させます。

トランスフォーマーモデルにはまだいくつかの欠点があります:

- 高い計算処理および需要があります。

- アテンションメカニズムは、処理できる長さの制限のため、テキストを分割する必要がある場合があります。

- 分割が誤って行われるとコンテキストが失われる可能性があります。

BERT

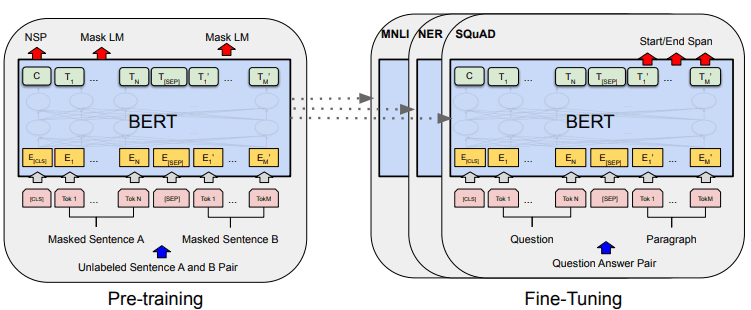

BERT、またはBidirectional Encoder Representations from Transformersは、Devlin et al. (2019)によって開発されたモデルで、モデルを作成するために2つのステップ(事前トレーニングと微調整)を経ます。BERTは、トランスフォーマーエンコーダーのスタックです(BERTベースは12層、BERTラージは24層です)。

BERTの全体的なモデル開発は、以下の図で示されます。

事前トレーニングタスクは、モデルのトレーニングを同時に開始し、完了したらモデルをさまざまなダウンストリームタスク(質問応答、分類など)に微調整できます。

BERTの特徴は、テキストデータに事前トレーニングされた最初の教師なし双方向言語モデルであることです。BERTは以前、Wikipedia全体と書籍のコーパスを対象に約30億語を事前トレーニングしました。

BERTは、ディレクショナルモデルとは異なり、テキスト入力を順次に読み取るのではなく、トランスフォーマーエンコーダーがシーケンス全体を同時に読み取るため、双方向と見なされ、モデルに入力データの全体的なコンテキストを理解させることができます。

双方向性を実現するために、BERTは2つの技術を使用しています:

- マスク言語モデル(MLM) — 単語のマスキング技術。この技術では入力単語の15%をマスキングし、マスクされていない単語に基づいてこのマスクされた単語を予測しようとします。

- 次の文予測(NSP) — BERTは文の関係を学ぼうとします。モデルはペアの文をデータ入力とし、後続の文が元のドキュメントに存在するかどうかを予測しようとします。

NLP領域でBERTを使用することにはいくつかの利点があります:

- BERTは、事前にトレーニングされたさまざまなNLP下流タスクに簡単に使用できます。

- 双方向性により、BERTはテキストの文脈をよりよく理解できます。

- コミュニティから非常に多くのサポートを受けている人気のあるモデルです

しかし、いくつかの欠点もあります:

- 一部の下流タスクの微調整には高い計算能力と長いトレーニング時間が必要です。

- BERTモデルは大容量のストレージを必要とする場合があります。

- シンプルなモデルを使用する場合とあまり変わらないため、複雑なタスクに使用する方が良いです。

結論

NLPは最近より注目されており、アプリケーションの改善に多くの研究が集中しています。この記事では、よく使用される3つのNLP技術について説明しました:

- RNN

- Transformers

- BERT

それぞれの技術には利点と欠点がありますが、全体的に見てモデルはより良い方向に進化していることがわかります。 Cornellius Yudha Wijayaはデータサイエンスのアシスタントマネージャーであり、データライターです。Allianz Indonesiaでフルタイムで働きながら、Pythonとデータのヒントをソーシャルメディアや執筆メディアで共有することが大好きです。

[Cornellius Yudha Wijaya](https://www.linkedin.com/in/cornellius-yudha-wijaya/)はデータサイエンスのアシスタントマネージャーであり、データライターです。Allianz Indonesiaでフルタイムで働きながら、Pythonとデータのヒントをソーシャルメディアや執筆メディアで共有することが大好きです。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「AWS上でクラウドネイティブなフェデレーテッドラーニングアーキテクチャを再発明する」

- 「Amazon SageMaker JumpStartで利用可能な自動音声認識のWhisperモデル」

- 新しい – Amazon SageMaker Canvasで利用可能なノーコード生成AI機能が追加されました

- 「メタのMusicGenを使用してColabで音楽を生成する」

- オリゴが警告を発しています:TorchServeの重大なセキュリティの問題により、ハッカーはサーバを乗っ取り、悪意のあるAIモデルを注入することができます

- このAIの論文は、FELM:大規模な言語モデルの事実性評価のベンチマーキングを紹介します

- 「Pythonにおける顧客セグメント分析:実践的なアプローチ」