説明可能AI(XAI)

XAI

アルゴリズムは今や何をしているのか、そしてなぜそれをしているのかを知っています!

イントロダクション:

こんにちは、テクノファイルと好奇心旺盛な人々。人工知能の次の章へようこそ。人工知能の謎にもっと深く入り込んでいきましょう。AIはこれまでにないほどの大きな波を起こしています!人工知能は、アルファ世代からZ世代、そしてベビーブーマーまで、すべての世代の注目を集めています。まるで驚きの宇宙を体験するために世代を集め、同時にビジネスを革新しているようです。まるで足りないと感じるアドレナリンのようなものです。

Instagramが私たちの話していることを理解し、友達と話していた内容の写真や正確な種類のものを表示し始めることに飽きたことはありますか?しかし、この話題が出るたびに具体的な回答はありません。インターネットがこう言うかもしれませんが、真実はどこにあるのでしょうか?そして、インターネットを信じても、その説明はどこにあるのでしょうか?私たちは人間です。法律制度とは異なり、何かを信じるためには証拠が必要です。だから心配しないでください、それが説明可能なAI、またはXAIの登場する場所です。

このブログでは、XAI理論にまっすぐ取り組み、その仕組みを明らかにし、さまざまな手法を調査し、もちろん、XAIの魔法を明確にするための関連性のある興味深い例を提供します!技術的に正確で楽しい航海を始める準備をしてください!人工知能の分野を一つずつ明確にしていきましょう!🌐🧩

A. 説明可能なAI(XAI)の定義と重要性:

AIによるローン:

以下のシナリオを考えてみてください:ローン(住宅ローン、車のローン、教育ローンなど)を申請したいと思っており、申請プロセスでAIシステムとやり取りしています。それが5年後に起こることです。説明なしにローンが断られました。そうです!私にとっても狂ったことですが、ここでXAIが登場し、なぜ断られたのかを理解し、具体的な理由を明らかにすることで、無機質で冷たいローン担当者と話しているような気持ちにならないようにサポートしてくれます。

AIによる医療:

説明可能なAIの重要性を理解するために、いくつかの例を見てみましょう:医療システムを想像してみてください。医師ではなくAIシステムと対話して診断を支援してもらうシステムです。狂ったことですね、私もAIを信頼しないでしょう!理由:推奨された薬の説明がないため、疑わしいです。しかし、XAIを使えば、その不安は理解に置き換えられます!システムは医学的な事実と、推奨の背後にある説明を提供するので、あなたは暗中模索することなく、自分が「ブラックミラー」のエピソードの一つにいるのかどうか心配する必要はありません!

AIとの連続視聴:

地球上のすべての個人が少なくとも一度は体験したことについて話しましょう。Netflixや他のストリーミングプロバイダーで連続してショーを見たことがありますか?その後、考えたこともなかったシリーズの奇妙な提案を受け取りましたか?私たちの電子機器が私たちを監視しているように感じますか?解釈可能なAIはウォッチパーティーに参加し、なぜアルゴリズムがあなたがその犯罪スリラーやロマンチック・コメディをお楽しみいただけると思ったのかを理解するのを助けることができます。ですので、もう秘密のアルゴリズムがこっそりと推奨をし、望まない提案を届けることはありません。

AIを活用した投資と取引:

最後の例は、トレーダーや投資家を対象としています。株式市場に取り組もうとするスマートな投資家を考えてみてください。その個人は既に知識があるため、AIを活用した取引システムを使用していますが、それはまるで暗闇でダーツを投げるゲームのようなものです。そのAIパワードシステムを信頼すべきかどうかわからないのです。しかし、心配しないでください、私たちの仲間の投資家やトレーダー、解釈可能なAIがここにあります。それは本当に予測の背後にある原因を説明することができますので、単にその気まぐれに従っているだけではありません。

皆が知っているように、すべての物語には良い面と悪い面の両方があり、AIも例外ではありません。しかし、私たちは悪い面を良い方向に変えることができます。それによって、AIは信頼を欠いて遠い・手の届かないものではなく、私たちの問題の解決に役立つ本当に理解可能なAIになる可能性が高くなります。本質的には人間のクローンですが、AIの形をとっています。

XAIの理解: ブラックボックスの解明

A. AIモデルにおけるブラックボックスとは何ですか?

では、非常に簡単な言葉で説明しましょう。入力を行い、出力(正しい結果)を受け取る機械を想像してみてくださいが、アルゴリズム内部で何が起こっているかはわかりません。それはすべて黒いままであり、デジタルのパンドラの箱のように魔法が起こる場所です!この秘密主義は興味深いですが、先述の重要な問題に取り組む際には進展がありません。例を挙げましょう。健康に関する重要な質問をAIアシスタントに尋ねると、奇妙な笑顔の絵文字が返ってくるだけです!それはおかしくありませんか?それが私が話していることです。

B. ブラックボックスモデルの制限と解釈可能性の必要性

ブラックボックスモデルは、内部の情報を提供することなく予測や結論を導く際にも効果的であり、その結論に至るまでの過程については理解できなくなるため、混乱を招くことがあります。

説明のためにいくつかの具体例を挙げましょう

ディープニューラルネットワーク(DNN):このテクニックについては、テック業界で話題となっています。一般的に、ディープニューラルネットワークは数千、もしくは数百万もの結びついたノードを持つ非常に複雑な構造であり、その膨大なパラメータと非線形変換のために理解することが難しいです。

基本的には、具体的な入力が何百万もの結びついたノードの中でどのリンクがどの特定の出力を生み出すのかを特定することは難しいです。それがブラックボックスモデルの古典的な例とまとめられます。

したがって、これらのモデルとその複雑な振る舞いについては、その複雑な数学的な式や変換は人間の脳にとってほぼ理解不可能なものであるが、同時にAIの歴史上最も強力で正確なモデルでもあります。ただし、上記で強調した多くの業務の信頼性と解釈可能性に関しては、これらのモデルには信頼を置くことができません。消費者の信頼性、信頼性、正当性を維持するために、展開する全てのAIに解釈可能性が必要な理由がここにあります。

C. XAIの主要な概念は何ですか?

まあ、説明可能なAIに取り組む際に覚えておくべき重要な原則は、結果を得た理由や方法について理由を与え、説明することができるアルゴリズム、具体的には機械学習モデルを開発することに焦点を当てているということです。主要な概念は以下の通りです:

- 解釈可能性: この概念は、人間の思考が理解できるものであると考えてください。これは、アルゴリズムがどのように動作するかを明確な説明で説明できる能力に関連しています。また、ユーザーがモデルの結果予測技術に対する洞察を得るのにも役立ちます。

- 透明性: 透明性は単にその言葉自体を指し、AIモデルの内部動作がユーザーに対して簡単にアクセス可能で透明であることを意味します。

- ローカル対グローバルの説明: これらの2つがどのように関連しているかを簡単に説明します。ローカル説明は、モデルの予測行動を指し、最後のコンポーネントです。一方、グローバル説明は、モデルの開始から結論までのすべてを含むモデル全体の振る舞いを指します。

- ヒューマン・コンピューター・インタラクション: コミュニケーションは重要です。それが人間と人間の間で行われるか、人間とコンピューターの間で行われるか、あるいはその逆であってもです。基本的には、ユーザーインターフェースは、アプリやコンピューターに事前の経験がない人々にとっても理解しやすく使いやすいものであるべきです。

説明可能なAIの手法:

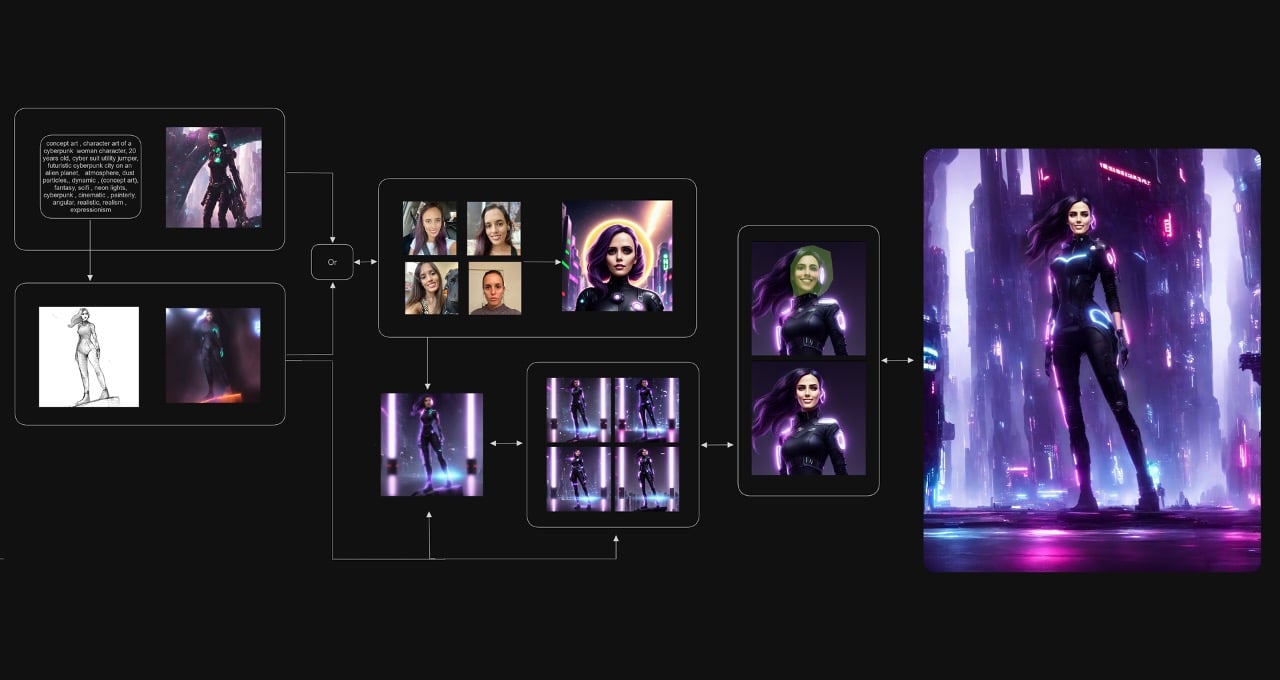

LIME、SHAP、DeepLIFTなどの強力な意思決定手法を使用して、AIモデルの神秘的な動作に光を当てるためにいくつかの手法を探ってみましょう。

- 特徴の重要性: この戦略は、モデルの予測に最も影響を与える属性を特定するのに役立ちます。多くのバリエーション戦略では、SHAP(SHAPLEY ADDITIVE EXPLANATIONS)やLIME(LOCAL INTERPRETATBLE)が強調されます。

- LIME(LOCAL INTERPRETATBLE MODEL-AGNOSTIC EXPLANATION): これは、起こっているすべてのことを知っている究極のスパイと考えてください。この戦略は、よりシンプルなモデル(例:線形回帰)を使用してブラックボックスモデルを解読することを可能にします。ある種のデータの存在により予測に変化が生じ、それを観察し、変更を記録し、モデルの振る舞いに関する情報と洞察を提供します。

- SHAP(SHAPLEY ADDITIVE EXPLANATION) VALUES: これはゲーム理論から派生した概念で、モデルの各特徴を調べ、予測に最も貢献する特徴を記録します。利用可能な特徴のサブセット全体で特徴の平均的なマージナル貢献を計算します。

- ルールベースの方法: 決定木やルールベースのモデルは、定義上理解しやすいです。特定の予測に寄与する明確な選択ルートを示すことができます。

- 可視化技術: グラフ、ヒートマップ、サリエンシーマップを使用して、さまざまな特徴が予測にどのように影響を与えるかを表示することができます。これにより、モデルの振る舞いを理解しやすくなります。

- カウンターファクトラルな説明: これらの戦略は、異なるモデル予測をもたらす代替入力状況を提供し、人々が「もしも」のシナリオを理解するのに役立ちます。

- 概念ベースの説明: これは、モデルの予測を人間が理解できる概念に変換することを意味します。例えば、画像の解析では、特定の予測に役立った興味深いアイテムや領域を強調することがあります。

- レイヤーワイズな関連伝播(LRP): LRPは、ディープニューラルネットワークの説明手法です。各ニューロンが生成する出力に対して重要性ランキングを提供し、最終的な予測の正確さに対する影響を反映します。

- アテンションメカニズム: アテンションメカニズムは、変換器などのモデルで視覚化することができ、特定の結果を作成するために入力のどの要素が最も重要かを理解するのに役立ちます。

- モデル蒸留: より複雑なモデルの振る舞いを模倣するために、より単純なモデル(線形回帰や決定木など)を訓練し、説明を提供するために使用することができます。

AIにおけるバイアスと公平性の解決:

まず、AIにおけるバイアスと公平性を議論することがなぜ重要なのかについて考えましょう。この問題がどのようなものかを把握するために、最近の事例を見てみましょう。おそらく、アマゾンのAI採用ツールに関する悩ましい事例については聞いたことがあるでしょう。このツールは女性の応募者に対して偏見を持っているということが発覚しました。また、他の事例としては、黒人患者に影響を与えた医療アルゴリズムにおける人種的な偏見があり、結果として医療部門における人種差別が起こりました。

こうして、すべての行動には結果があること、そしてAIも例外ではないことがわかりました。そのような結果を解決することは私たちの最優先事項であるべきです。なぜなら、最終的にはAIは私たちの生活をより便利にするために存在するべきであり、バイアスのメカニズムによって私たちを互いに敵対させるべきではないからです。システムのバイアスに対処することがなぜ重要なのかを理解しました。では、AIにおけるさまざまな種類のバイアス、意思決定の公平性、および偏見を打ち破るために使用されるアプローチについて見てみましょう。

A. AIシステムにおけるバイアスの理解:

人工知能の分野において、バイアスという問題に直面することは非常に重要です。AIシステムは提供されたデータに応じて機能するため、残念ながらバイアスのあるデータが浸透して彼らの選択に影響を及ぼすことがあります。バイアスは不当な差別を引き起こし、社会的な不平等の持続に寄与する可能性があります。AIシステムにおけるバイアスの存在と影響を理解することは、公正で透明性のある倫理的なモデルの開発に向けた第一歩です。人工知能の内部構造を調査し、コードのバイトごとに公正さと責任を保証するためには、もはや時間の問題です。

以下は、より一般的に発生し、しばしば相互に関連している最も一般的なバイアスのいくつかについて取り上げましょう:

- アルゴリズムのバイアス:この種のバイアスは、アルゴリズムが意図的にまたは偶然にバイアスを持っている場合に発生します。たとえば、男性に偏ったデータセットでトレーニングされたアルゴリズムは、男性に関する予測にバイアスを持つ可能性が高くなります。

- データのバイアス:この種のバイアスは、アルゴリズムのトレーニングに使用されるデータが偏っている場合に発生します。たとえば、データセットが白人に偏っている場合、アルゴリズムは白人に関する予測にバイアスを持つ可能性が高くなります。

- 社会的なバイアス:この種のバイアスは、アルゴリズムが社会的なバイアスを反映している場合に発生します。たとえば、STEM分野における女性に対する社会的なバイアスがある場合、STEMの卒業生のデータから学習したシステムは、女性に対してバイアスのある判断をする可能性があります。

B. 意思決定における公平性の重要性:

AIの意思決定において公平性は重要です。均等な就業機会、同じ信頼性、民族的平等などの公平性指標は、潜在的なバイアスを特定するのに役立ちます。バイアスを回避しつつ公平な結果を保証するためには、公平性を考慮したアルゴリズムと正規化手法を使用することができます。

ケーススタディ:

ソーシャルメディアにおけるXAI:ニュースフィードの推奨アルゴリズムのAIの理解

私たちは誰もがソーシャルメディアを楽しんでいるこの忙しい世界で、個人情報や家族や友人に関する情報を共有する暗い場所であることを否定することはできません。そして、最近の最も狂ったトレンドは人工知能のアルゴリズムです。私たちは彼らの意思決定プロセスを理解し、説明可能なAIがこのケースにおいて透明性をもたらす方法を探求することができます。

まずは、ソーシャルメディアのアルゴリズムについて理解しましょう:

- データ収集:ソーシャルメディアネットワークは、会話、好み、エンゲージメントの指標など、大量のユーザーデータを蓄積します。この情報はAIアルゴリズムの基礎となります。

- データ前処理:データの前処理は、生データを分析に適した形に洗練し、変更する作業です。この段階ではノイズを減らし、パターンを検出する能力を向上させます。

- 特徴抽出:AIアルゴリズムは、抽出したデータからユーザーの好み、情報の関連性、過去の相互作用などの情報を抽出します。これらの特徴は、推奨アルゴリズムに入力されます。

- 機械学習モデルの設計:AIシステムでは、協調フィルタリング、コンテンツベースのフィルタリング、ハイブリッド技術などの高度な機械学習手法が使用されます。これらのアルゴリズムは、ユーザーの特性を分析し、類似のプロファイルと比較して関連情報を見つけます。

ソーシャルメディアのためのアルゴリズムの設計方法を理解しましたが、このアルゴリズムは実際にどのように機能するのでしょうか?それでは、説明可能なAIに移りましょう👍

XAI:ブラックボックスの解明:

- XAIのアプローチは、ルールベースの説明を作成し、アルゴリズムが提案するために使用する具体的な要件を明示します。たとえば、「投稿は類似のユーザーの相互作用とコンテンツの関連性に基づいて推奨されます。」

- 特徴の帰属(前述) – XAIは特徴の帰属をサポートし、提案に重要な影響を与える特徴を強調します。「例えば、高い相互作用率を持つ友達の投稿が優先されます。」

- ユーザーレベルの説明:XAIはユーザーレベルの説明を提供することで、個々のフィードに特定のコンテンツが表示される理由を説明します。たとえば、「この投稿は、技術への興味と類似のコンテンツへの最近の関与のためにおすすめされました。」

結論:

XAIは、AIアルゴリズムと利用者とのギャップを埋める上で重要です。ソーシャルメディアのニュースフィード上で情報が推奨される理由を詳細に説明することにより、信頼を生み出し、利用者が知識に基づいた選択をすることを可能にします。ソーシャルメディアが進化する中で、XAIの透明性はより個別化された利用者中心のアプローチを提供し、バイアスに対抗し、責任あるAIコミュニティをサポートします。

AI学習を始めるためのおすすめ:

説明可能なAIのような複雑なトピックに取り組む際、理論的な知識だけでは限界があります。実践的な洞察を得るためには、実践的なプロジェクトの貴重な経験が必要です。これらのプロジェクトは、テキストや講義では伝えられない実践的な洞察を開く鍵となります。 ProjectProは、理論から実践への知識を推進するために設計された革新的な学習プラットフォームです。 ProjectProは、典型的なオンライン学習プラットフォームではありません。講義や評価を超えて、様々なドメインで厳選されたプロジェクトの実践的で没入型な体験を提供します。

ProjectProは、AIや機械学習のコンセプトを具体的なシナリオに適用することを求める実世界のプロジェクトの幅広い選択肢を提供します。これらのプロジェクトに積極的に参加することで、学習者は問題解決能力を開発し、実世界の課題に取り組む自信を得ることができます。

[ウェブサイトを訪れて詳細を知るには- https://bit.ly/3OlIGoF ]

説明可能なAIメソッドについて学ぶことを始めましょう。あなたが誰であろうと関係ありません。以下は、始めるためのいくつかのおすすめ事項です:

EXPLAINABLE AI(XAI)- UDEMY COURSE:基礎から高度な技術まで、説明可能なAIで使用される技術を網羅しています。また、リアルライフのケーススタディも含まれており、適切な洞察を得ることができます。

[リンク: https://www.udemy.com/course/xai-with-python/ ]

INTERPRETABLE MACHINE LEARNING CLASS – HARVARD UNIVERSITY ON EDX:

説明可能なAIに関連する幅広いトピックをカバーしています。説明可能なAIモデルの異なる技術、倫理的および法的な影響、実世界の事例などについて説明します。

[link: https://blog.ml.cmu.edu/2020/08/31/6-interpretability/ ]

IBMによるPythonによる説明可能なAIの教育コース(COURSERAで提供):このコースでは、特徴抽出、反事実的な説明、モデルの内省などのテーマに関して、Pythonを使用してAIモデルを説明する方法を学びます。

[link: https://www.coursera.org/projects/scene-classification-gradcam ]

データナイツとMicrosoft Reactorの共同による説明可能なAI(XAI)コース:このコースでは、説明可能なAIの理論と実践、およびユースケースをカバーしています。AIの説明を生成するだけでなく、それらの説明をステークホルダーに効果的に伝える方法も学びます。私にとっては必見のコースです。

[link: https://learn.microsoft.com/en-us/events/learn-events/reactor-explainableaicourse/ ]

ソーシャルメディアプラットフォームで私たちをフォローして、ご意見を共有してください。AI愛好家のコミュニティに参加し、一緒にジェネレーティブAIの領域を広げ続けましょう。一緒に素晴らしいことを成し遂げることができます!🔐❤️

データサイエンスとサイバーセキュリティのLinkedInグループに参加してください!最新のマテリアルブログ、独占コンテンツ、および同じような熱狂的な人々が見つかります。🔥

グループのリンク: https://www.linkedin.com/groups/9378874/

同じような楽しさを提供するデータサイエンスのブログや記事をフォローしてください: 💙

メールアドレス: [email protected]

LinkedIn: https://www.linkedin.com/company/dsmcs/

Instagram: https://www.instagram.com/datasciencemeetscybersecurity/?hl=en

Github: https://github.com/Vidhi1290

Twitter: https://twitter.com/VidhiWaghela

VoAGI: https://medium.com/@datasciencemeetscybersecurity-

ウェブサイト: https://www.datasciencemeetscybersecurity.com/

— データサイエンスミーツサイバーセキュリティチーム 💙❤️

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles