なぜ無料のランチがあるのか

Why is there free lunch?

神経科学と人工知能におけるパターンの普遍性について

「昼食はタダではない。」- ロバート・A. ハインライン

機械学習の領域における「タダではない昼食」の定理は、数学の世界におけるゲーデルの不完全性定理を思い起こさせます。

これらの定理は頻繁に引用されますが、深く説明されることはめったにありません。現実世界の応用に対する影響はしばしば不明確です。ゲーデルの定理が完全で自己整合的な形式体系に対する20世紀初頭の数学者の信念にとってのトゲとなったように、「タダではない昼食」の定理は、一般的な機械学習アルゴリズムの有効性への信仰に挑戦します。しかし、これらの定理が日常的な実践に与える影響はしばしば小さく、ほとんどの実践者はこれらの理論的制約に束縛されずに進みます。

本記事では、「タダではない昼食」の定理が何を意味するかを探求し、視覚、転移学習、神経科学、人工汎用知能との関連について深く掘り下げたいと思います。

- 自動化、Ansible、人工知能

- 大規模言語モデル(LLM)に関する驚くべき8つの事実

- ChatArenaをご紹介します:複数の大規模言語モデル(LLMs)間のコミュニケーションとコラボレーションを容易にするために設計されたPythonライブラリです

「タダではない昼食」の定理は、1997年にウォルパートとマクレディによって提唱され、しばしば機械学習の文脈で使用されます。この定理は、「すべての問題に対して普遍的に最適なアルゴリズムは存在しない」ということを示しています。魔法のような、一つの解決策がすべてに適用できるわけではありません。アルゴリズムは、あるタスクに対して非常に優れた性能を発揮するかもしれませんが、別のタスクに対しては性能が低下する場合があります。

機械学習の基本的な目的の一つは、異なるデータから意味のあるパターンを見出すことです。しかし、アルゴリズムの有効性は、しばしば手元のデータの具体的な性質に依存します。あるタイプのデータに対しては非常に有用かもしれませんが、別のタイプのデータに適用すると効果が低下する場合があります。

これは、私たちが遭遇するさまざまなデータタイプを考えると明らかになります。コインを投げることなど、単純な確率分布を生成する場合でも、2つのパターンを生成します。

一方、画像データやテキストデータなど、実際にはより複雑な例が多くあります。500×500の画像の可能な構成の数は指数関数的に増加するため、想像を絶するほどの大きさになります。

このような空間の大きさを考慮すると、私たちはどのようにしてデータから意味のあるものを学ぶことができるのでしょうか?

答えの重要な部分は、関心のあるサンプルのほとんどは、ランダムサンプリングと比較して、大量の事前に存在する構造を持っているということです。

言語データは、もう一つの典型的な例です。ある言語のすべての単語の合計は、文字のすべての組み合わせの集合と比較して、はるかに低次元の空間に存在するパターンのサブセットで構成されています。これは、最初の単純な統計的言語モデルで使用されたものであり、私はマルコフ連鎖についての記事でこれを詳しく探求しました。

機械学習者にとって、多くの種類の入力データには、いくつかの繰り返しのパターンがあるということは非常に良いニュースです。これは、私たちがこれらのパターンを抽出することを学ぶモデルを訓練し、おそらくは別のアプリケーションで同様のパターンを抽出するためにモデルを再利用できることを意味します。

転移学習の技術は、現実世界の多くの問題が共通の構造を持つという事実を明示的に利用しています。

転移学習は、既に大規模なデータセットからパターンを学習した事前学習済みモデルを使用して、異なるが関連するタスクに適応し、「微調整」することを目的としています。画像データのオブジェクト認識を学習するモデルは、エッジや色のグラデーションなどの低レベルの特徴や、形状などの高レベルの特徴を学習することができます。これらの学習された特徴は、手書き数字の認識や医療画像の腫瘍の分類など、関連するタスクに適用することができます。

HubelとWieselは、視覚皮質が階層的な層で構成され、ますます複雑なパターンを扱うことを示したことで、1981年にノーベル賞を受賞しました。畳み込みニューラルネットワーク(CNN)の登場以来、彼らの仕事は機械学習アルゴリズムに関連して広く議論されています。

例えば、視覚野の単細胞は、縁や色の勾配を検出し、複雑な細胞はこれらの単細胞の出力を集約して、動きや特定の形状など、より広いパターンを認識します。視覚システムのより深い部分に進むと、ニューロンが認識するパターンはますます複雑になり、単純な幾何学的形状から顔や複雑なオブジェクトに移り、最後には(有名な)祖母ニューロンに至ります。このニューロンは、あなたが祖母を見たとき(または子供のころに貰ったマドレーヌを味わったとき)にのみ発火します。

同様に、CNNのレイヤーは、ますます複雑な特徴を抽出します。初期のレイヤーでは、CNNは線、角度、色の塊などの単純な構造を検出することができます。レイヤーを進むにつれて、これらの単純な特徴が結合され、より複雑な表現が形成されます。円、四角形、そして最終的には猫、犬、象のように見える識別可能なオブジェクトです。

おそらくこれらの類似性は驚くべきことではありません。視覚データに内在する構造を利用するために、両方のシステムが進化し、設計されたと考えられます。あらゆる種類の視覚シーンで最も頻繁に発生するパターンの理解は、異なるが関連するタスクを処理するために再利用または転送できます。これは、以前に議論したように、転移学習と脳の適応能力が重要な役割を果たす場所です。

自転車を認識するこどもは、オートバイを認識するときにゼロから始める必要がありません。彼らは、自分の基本的な構造の理解を別の文脈に転送します。同様に、様々な画像でトレーニングされたCNNは、顔を認識するから手書きの数字を認識するに切り替える際に、「エッジ」の概念を再学習する必要はありません。

私たち自身の脳も、転移学習と機械学習の「無料の昼食」の基盤となる構造が存在することを発見しています。私たちが役に立つ世界は一様にランダムではなく、繰り返しパターンや構造で満たされているという真実に私たちの脳はハードワイヤードされています。

私たちが興味を持つパターンが何であるかを理解することは、異なるが関連のあるタスクを処理するために再利用または転送することができます。私たちの脳は、構造的な先行知識に基づいて視覚入力を選択的に知覚するようにハードワイヤードされているため、ノイズとして認識されないように、突出したパターンにバイアスがかかっています。

私たちが「赤いリンゴ」として知覚するものは、リンゴそのものではなく、私たちを栄養豊富な食べ物に導く表現です。したがって、私たちの知覚システムは、私たちの既存のモデルに合わない大量のデータをフィルタリングする強力な先行知識を課しています。これは、機械学習の「無料の昼食」と転移学習の基盤となる構造を反映しています。

私たちの脳の活動は、制御された幻覚のようなものであるとAnil Sethのような科学者が言及していることも、Donald Hoffmanの提唱する現実に対する反論のような考えにもつながっています。

例えば、コンピューターのデスクトップにあるアイコンは、マシン内部で何が起こっているかを明らかにするのではなく、コンピューターを使用することを容易にするインターフェースを提供しています。同様に、私たちが赤いリンゴとして知覚するものは、栄養豊富な食べ物を導く表現であり、私たちの知覚システムは、私たちの既存のモデルに合わない大量のデータをフィルタリングする強力な先行知識を課しています。このように、私たちの知覚は、私たちの先行知識に基づいて解釈されることになります。

私たちの脳は、世界の特定のパターンに焦点を合わせることを学んだ事前学習済みモデルのようであり、新しい感覚入力の一定の強襲に対処するのに役立っています。

年を取るにつれて、私たちは見えないパターンが現れたときにモデルを反転して微調整する可能性が低くなり、自己認識された自由昼食の極致となる頭の推論機械を持って歩くようになります。『古い白人男性』というミームに従って、『古い白人男性』とは、彼がすでに確立された世界モデルを通して遭遇するすべての学習問題に自由昼食を手に入れる普遍的なアルゴリズムであると彼が思っているレンズを通してすべてを説明しようとする人物のことを指します。

冗談はさておき、モダリティ内の転移学習は重要ですが、現在の多モーダル設定における神経科学と機械学習の両方における現在の進展に関しても、私たちの議論はすっきりと拡張されます。

脳は、脳卒中やその他の感覚喪失の劇的な例によく見られるように、驚くべき再編成能力である神経可塑性を持っています。

感覚喪失は、しばしば特定の脳領域の再利用をもたらします。例えば、盲目の人は聴覚と触覚のタスク中に通常は視覚情報を処理する視覚皮質が活性化することが研究で示されています(David Eagleman の Livewired という本は、神経可塑性が脳で果たす中心的な役割を素晴らしい形で説明しています)。

まるで脳が視覚タスクのために事前学習されたニューラルネットワークを取り、視覚入力を受け取らなくなったことに気づき、それを微調整して聴覚と触覚情報を処理するようにしたかのようです。

同様に、ろう者はブローカ領域やウェルニッケ領域など、話された言語の処理に通常関連付けられている脳の領域を使用しながら手話を使用することがわかっています。これらの領域は、コミュニケーションを、そのコミュニケーションの特定のモダリティに関係なく、より広く扱うことに専念しています。脳の言語ネットワークは、話された言語、書かれた言語、または手話など、異なる形式のコミュニケーションを扱うために十分な柔軟性を持っています。

これらの神経可塑性の例は、私たちの脳の計算が、特定の感覚モダリティに一般的に関連付けられているパターンだけでなく、幅広いパターンを処理することができる普遍的な学習アルゴリズムに基づいていることを示しています。このアルゴリズムが正確に何に基づいているかは議論の余地があります(たとえば Jeff Hawkin の thousand brains 、Kurzweil の pattern recognizers などの人気のある神経科学的説明、そして Pedro Domingues の The Master Algorithm のコンピュータサイエンスの観点などがあります)、しかし、神経可塑性は明らかにそれが存在することを示しています。

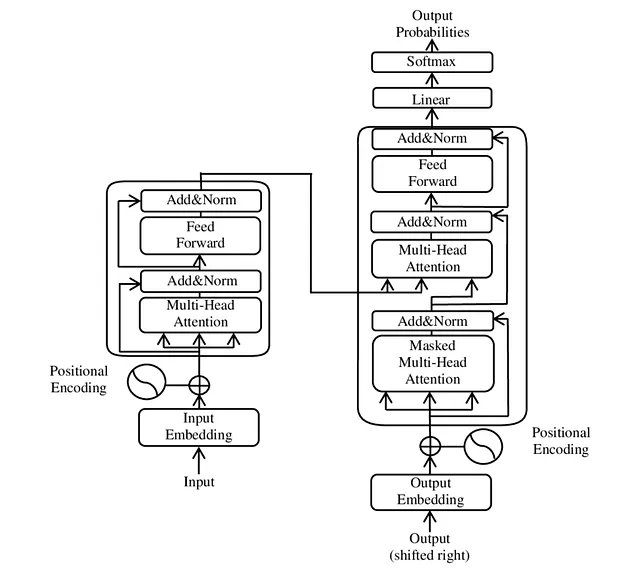

脳の多様性は、私たちの最も先進的な機械学習モデルでも反映されています。Transformers は最初に自然言語処理に対応するように開発されましたが、現在では、画像や音声、時系列データなど、様々なデータタイプに適用されています(これが主に現在の彼らに対するハイプの結果であるかどうかは論争の余地があります)。盲人の視覚皮質が聴覚や触覚のタスクに再利用されるように、Transformers は異なるデータタイプに適応されることができ、特定の入力モダリティに関係なくこれらのモデルが捕捉できる普遍的なパターンの存在を示唆しています(公正を期すために、これは彼らが現在の計算アーキテクチャに最適に最適化されているためでもあります。彼らは非常に並列化されることができます)。

Wolpert と Macready のオリジナル NFL 論文を引用すると、「あらゆる最適化アルゴリズムは、すべての可能な問題に対してそのパフォーマンスが平均化された場合に等しい」となります。しかし、オーウェルを言い換えると、私たちが本当に関心を持つほとんどの問題を見ると、いくつかの最適化アルゴリズムは他よりも平等です。

例えば、Transformer を画像データに適用することで、ビジョン Transformer のようなモデルが生成され、画像をパッチのシーケンスとして扱い、同じ自己注意メカニズムを適用します。

このアイデアは、複数のタイプのデータを同時に処理し理解することができるマルチモーダルトランスフォーマーによってより具体的に示されています。CLIPモデルなどのテキストと画像の埋め込みは、画像とそれに関連するテキストの説明を同時に理解するためにトレーニングされています。CLIPは、両方のモダリティを共通の埋め込み空間に組み込むことで関係性を学習します。

このようなモデルは、さまざまなデータタイプ間の共通構造を活用し、それらの間に「翻訳」システムを効果的に作成します。CLIPのこの能力の驚くべき例は、ほとんどの人にとって既に馴染み深いものです:DALL-Eなどの拡散ベースのモデルの基盤を提供することで、テキストの説明だけから印象的な画像を生成することができます。

これがうまく機能するのも、偶然ではないかもしれません。言語の意味の基本単位、例えば「猫」、「犬」、「愛」などは短く、言語は視覚的シーンと同じ概念に沿って構造化されています。インターネットには、ノイズの多い色の塊よりも、猫の写真の方が多いと思われます。より一般的には、言語は既に導出されたモダリティであり、大勢の人々が共同で開発し、最も重要なことを簡潔な象徴的表現に凝縮するためのものです。

最も重要なのは、『無料の昼食がある』という事実が人工汎用知能(AGI)に関連していることです。AGIは、ほとんどのアプリケーションから無料の昼食を手に入れるアルゴリズムです。

Chat-GPTを考えてみてください。GPTモデルは完全にテキストでトレーニングされていますが、テキストデータの制限を超えて、世界を理解し、推論し、コミュニケーションする能力を示し始めています。これらのモデルは、テキストデータを予測するためだけにトレーニングされたにもかかわらず、テキストを超える普遍的なロジックを発掘するように思われます。

特に他のモダリティと共同トレーニングされた場合、LLMはそのモダリティのテキスト説明を超えて基礎となるパターンを理解し、それらから新しいアイデアを生成することができます。これは、脳が行うことに似ています。

LLMが一般化された知能を達成することに成功したことについて、私を含め多くの人々が驚いた理由の1つは、私たちが知覚世界がすでに普遍性のあるパターンと、私たちの脳の学習アルゴリズムの対応する普遍性に依存している程度を集合的に過小評価していたことです。

無料の昼食定理は理論的に正しいですが、私たちが最も関心を持っている問題の大部分は、統計的には全く普遍的ではありません。代わりに、それらは主にビジョン、言語、音に関係する低次元空間を占め、人間の関心と重要性の主要な範囲です。

マルチモーダル大規模言語モデルの出現により、これらの低次元およびクロスモーダル表現を活用したアルゴリズムフレームワークが提供されています。これはAGIの可能性と、それが私たちの世界と私たちの世界の理解を変える方法について、興味深く、少し怖い先取りを提供しています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles