トムソン・ロイターが6週間以内に開発したエンタープライズグレードの大規模言語モデルプレイグラウンド、Open Arena

Thomson Reuters' enterprise-grade large-scale language model playground, Open Arena, developed within 6 weeks.

この投稿は、Thomson ReutersのShirsha Ray Chaudhuri、Harpreet Singh Baath、Rashmi B Pawar、およびPalvika Bansalによって共同執筆されました。

グローバルなコンテンツとテクノロジーを中心に展開するThomson Reuters(TR)は、数十年にわたり、人工知能(AI)と機械学習(ML)を専門情報製品に活用してきました。同社の専門のイノベーションチームであるThomson Reuters Labsは、AIと自然言語処理(NLP)の先駆的な取り組みにおいて重要な役割を果たしてきました。その一つの重要なマイルストーンは、1992年にWestlaw Is Natural(WIN)を導入したことです。この技術は、より効率的で自然な法律研究のためにNLPを使用した最初のものの一つでした。2023年になり、Thomson Reutersは、迅速なイノベーション、創造的なソリューション、パワフルなテクノロジーを通じて、プロフェッショナルの未来を定義し続けています。

生成型AIの導入により、Thomson Reutersは顧客と協力して彼らの業務方法を再び進化させる機会を得ることができます。プロフェッショナルが洞察を得てワークフローを自動化し、時間を最も重要な領域に集中させることを支援するために、AIを活用するツールの使用方法について考える際に、同社はどのようにこのテクノロジーの力を自社のチームに活用しているのでしょうか?

Thomson Reutersは、AIに関する認識と理解を企業内のすべてのチームとビジネスエリアの同僚に向けて高めることに非常に力を入れています。AIとは何か、そしてMLはどのように機能するのかという基本的な原則から始まり、ウェビナーやトレーニング資料、パネルディスカッションなど、企業全体にわたるAIの認識向上のためのローリングプログラムを提供しています。これらのセッションでは、同僚たちがAIを使用して日常のタスクを効率化し、顧客に役立つツールをどのように使用するかについてのアイデアが浮かび始めました。

この投稿では、Thomson Reuters LabsがOpen Arenaを作成した方法について説明します。Open Arenaは、Thomson Reutersの企業全体で利用できる大規模な言語モデル(LLM)のプレイグラウンドであり、AWSとの共同開発によって開発されました。このオリジナルのコンセプトは、Simone Zucchet(AWSソリューションアーキテクト)とTim Precious(AWSアカウントマネージャー)の支援を受けたAI / MLハッカソンで生まれ、AWSのサポートを受けて6週間以内に本番環境に開発されました。AWS Lambda、Amazon DynamoDB、Amazon SageMakerなどのAWS管理型サービス、およびHugging Face Deep Learning Containers(DLC)のプリビルドがイノベーションのペースに貢献しました。Open Arenaは、安全かつ制御された環境で生成型AIの企業全体での実験を可能にするのに役立ちました。

さらに詳しく見ていくと、Open Arenaは、LLMを活用した成長するツールセットで実験できるウェブベースのプレイグラウンドです。これにより、コーディングのバックグラウンドを持たないThomson Reutersの従業員でも、トレンドである生成型AIの可能性を自由に探索することができます。Open Arenaは、カスタマーサポート担当者のためのクイックな回答、ウェブサイトからのクイックな回答のためのソリューション、文書の要約とポイントの検証のためのソリューションなど、複数のコーパスから迅速な回答を得るために開発されました。Open Arenaの機能は、Thomson Reutersの従業員の経験によって新たなアイデアが生まれることや、生成型AIの分野で新たなトレンドが出現することによって、さらに拡大しています。これは、ソリューションの基盤となるモジュラーサーバーレスAWSアーキテクチャによって実現されています。

Open Arenaの展望

Thomson Reutersの目標は明確でした。安全で安全なユーザーフレンドリーなプラットフォームである「オープンアリーナ」を企業全体のプレイグラウンドとして構築することです。ここでは、内部チームが自社内で開発されたさまざまなLLMやAWSやHugging Faceのパートナーシップなど、オープンソースコミュニティからのLLMを試験し、Thomson Reutersの豊富な企業データと組み合わせることで、ユニークなユースケースを発見することができます。このようなプラットフォームは、チームが革新的なソリューションを生み出し、Thomson Reutersがクライアントに提供できる製品とサービスを改善する能力を向上させます。

構築するOpen Arenaは、多面的なプロセスでした。AWSのサーバーレスとMLサービスの能力を活用して、最新のLLMを試験するためにThomson Reutersの従業員がシームレスに使用できるソリューションを作成することを目指しました。これらのサービスのポテンシャルは、スケーラビリティと管理性だけでなく、コスト効果の面でも提供できると考えました。

ソリューションの概要

モデルのデプロイと微調整のための堅牢な環境の作成から、データの緻密な管理、シームレスなユーザーエクスペリエンスの提供まで、TRは各側面が複数のAWSサービスと統合することが必要でした。Open Arenaのアーキテクチャは、複雑さと使いやすさのバランスを取りながら、包括的かつ直感的に設計されました。次の図は、このアーキテクチャを示しています。

SageMakerはバックボーンとして機能し、SageMakerエンドポイントとしてモデルの展開を容易にし、モデルの微調整に堅牢な環境を提供しました。私たちはAWSが提供するSageMaker DLC上のHugging Faceを活用し、展開プロセスを向上させました。さらに、SageMaker Hugging Face Inference ToolkitとAccelerateライブラリを使用して、推論プロセスを高速化し、複雑でリソースを多く必要とするモデルの実行の要求を効果的に処理しました。これらの包括的なツールは、LLMsの迅速かつシームレスな展開を確実にするために不可欠でした。Amazon API GatewayによってトリガーされるLambda関数は、データの細心な前処理と後処理を確実に行い、APIを管理しました。

シームレスなユーザーエクスペリエンスを提供するために、セキュアなAPI Gatewayを採用し、Amazon Simple Storage Service(Amazon S3)にホストされたフロントエンドとLambdaバックエンドを接続しました。フロントエンドはS3バケットに静的サイトとして展開し、Amazon CloudFrontと当社のシングルサインオンメカニズムの支援により、ユーザー認証を確保しました。

Open Arenaは、REST APIを介して複数のLLMsとシームレスに統合するように設計されています。これにより、プラットフォームは迅速に反応し、新しい最先端のモデルが急速に発展する生成AIの領域に迅速に統合する柔軟性がありました。Open Arenaの設計段階から、Thomson Reutersの従業員が最新のLLMをリリースされるとすぐに試すことができる安全でセキュアなエンタープライズAI/MLプレイグラウンドを提供することが目的でした。SageMakerでHugging Faceモデルを使用することで、データがすべて暗号化され、仮想プライベートクラウド(VPC)を離れないため、モデルの微調整を安全な環境で行うことができました。データはプライベートかつ機密性が保たれます。

私たちが選んだNoSQLデータベースサービスであるDynamoDBは、ユーザーのクエリ、レスポンス、レスポンスタイム、ユーザーデータなど、さまざまなデータを効率的に格納および管理しました。開発および展開プロセスを効率化するために、私たちは継続的インテグレーションおよび継続的デリバリー(CI/CD)のためにAWS CodeBuildおよびAWS CodePipelineを使用しました。インフラストラクチャのモニタリングと最適な動作の確保は、Amazon CloudWatchによって実現され、カスタムダッシュボードと包括的なログ機能が提供されました。

モデルの開発と統合

Open Arenaの中心は、オープンソースおよび内部開発モデルの多様なアシスタントモデルです。これらのモデルは、特定のユーザーのプロンプトに応じて応答を提供するように微調整されています。

Open Arenaでは、Flan-T5-XL、Open Assistant、MPT、Falcon、およびパラメータ効率の良い微調整技術を使用して利用可能なオープンソースデータセットでFlan-T5-XLを微調整するなど、さまざまなユースケースに異なるLLMsを試してきました。さまざまな量子化技術を試すために、Hugging Faceからbitsandbytesインテグレーションを使用しました。これにより、パフォーマンスと効率性を向上させるためにLLMsを最適化することができ、さらなるイノベーションの道を開きました。これらのユースケースのバックエンドとしてモデルを選択する際には、以下のような異なる側面を考慮する必要がありました。

- LLMsを使用したアプリケーションの構築時の効率の向上 – AWS上で実行されるアプリケーションとワークロードに最新のLLMsを迅速に統合・展開するために、AWSの幅広いコントロールと統合を使用することができます

- セキュアなカスタマイズ – LLMsの微調整に使用されるすべてのデータが暗号化され、VPCを離れないことを確保します

- 柔軟性 – 多様な選択肢の中から、AWSネイティブおよびオープンソースのLLMsを選択して、さまざまなユースケースに適したモデルを見つけることができます

私たちは、大型モデルの高いコストが大幅なパフォーマンス向上に見合っているかどうか、これらのモデルは長い文書を処理できるかなど、このような質問をしてきました。

以下の図は、モデルのアーキテクチャを示しています。

私たちは、これらのモデルをオープンソースの法務データセットとThomson Reutersの内部データセットで前述の側面で評価し、特定のユースケースに適しているかどうかを評価してきました。

コンテンツベースのユースケース(特定のコーパスからの回答を必要とするエクスペリエンス)では、リトリーバルオーグメンテッドジェネレーション(RAG)パイプラインを使用して、クエリに対して最も関連性の高いコンテンツを取得します。このようなパイプラインでは、ドキュメントはチャンクに分割され、埋め込みが作成されてOpenSearchに保存されます。最適なマッチングドキュメントまたはチャンクを取得するために、バイエンコーダーおよびクロスエンコーダーモデルに基づくリトリーバル/リランカーアプローチを使用します。取得された最適なマッチは、クエリとともにLLMに入力され、最適な応答を生成するために使用されます。

トムソン・ロイターの内部コンテンツとLLM(Legal, Risk & Compliance)体験の統合は、ユーザーがこれらのモデルからより関連性の高い洞察に基づく結果を抽出するのを支援する上で重要な役割を果たしています。さらに重要なことは、それが全てのチームの間でアイデアを引き起こし、彼らのビジネスワークフローにAIを活用したソリューションを導入する可能性についての可能性を生み出したことです。

オープンアリーナタイル:ユーザーの相互作用を容易にする

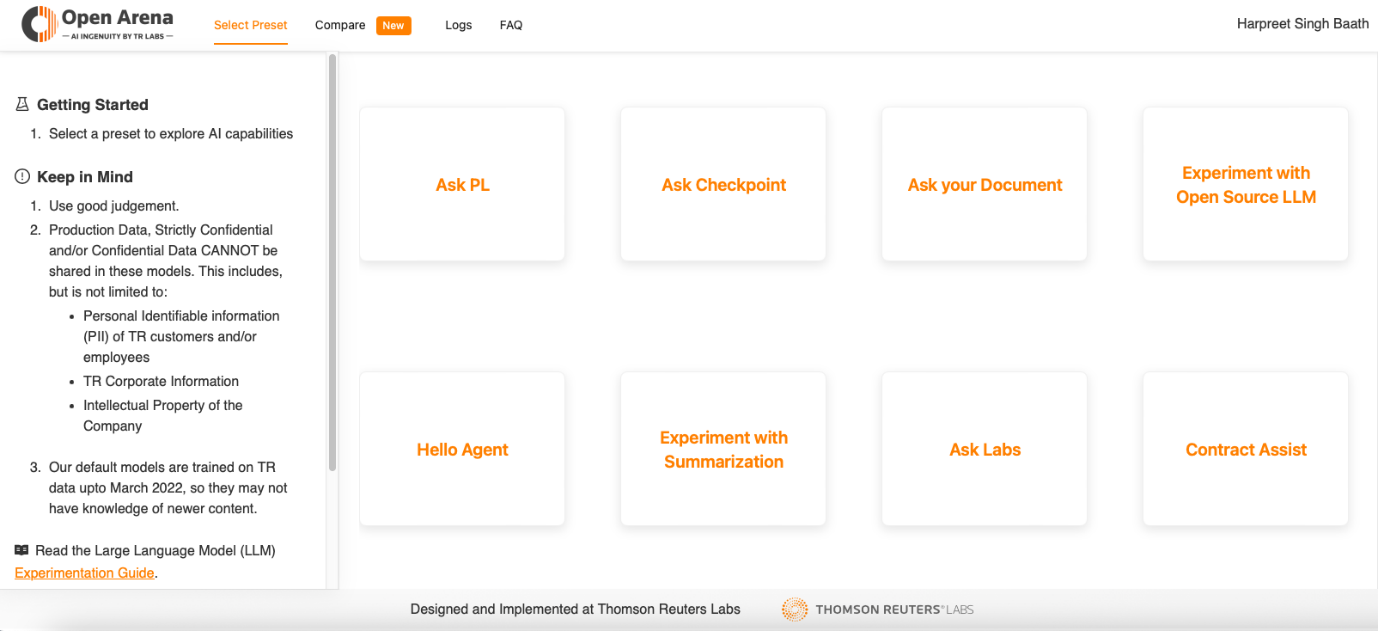

オープンアリーナは、各体験に事前に設定された有効化タイルを備えたユーザーフレンドリーなインターフェースを採用しています。以下のスクリーンショットに示すように、これらのタイルはユーザーの特定の要件に対応するための事前に設定された相互作用として機能します。

例えば、オープンソースLLMの実験タイルは、オープンソースのLLMとのチャットのような相互作用チャネルを開きます。

「ドキュメントを尋ねる」タイルでは、ユーザーはドキュメントをアップロードし、LLMからのコンテンツに関連する特定の質問をすることができます。また、「要約の実験」タイルでは、大量のテキストを簡潔な要約にまとめることができます。以下のスクリーンショットに示すように。

これらのタイルは、AIを活用した作業ソリューションのユーザー消費およびプラットフォーム内のナビゲーションプロセスを簡素化し、創造性を刺激し、革新的なユースケースの発見を促進します。

オープンアリーナの影響

オープンアリーナの開始は、トムソン・ロイターがイノベーションと協力の文化を育むための重要なマイルストーンとなりました。プラットフォームの成功は否定できず、その利点は会社全体で急速に明らかになりました。

オープンアリーナの直感的でチャットベースのデザインは、大きな技術的知識を必要とせず、世界中の異なるチームや異なる役職の人々にアクセス可能でした。この使いやすさはエンゲージメントレベルを向上させ、より多くのユーザーがプラットフォームを探索し、革新的なユースケースを明らかにすることを促しました。

1か月未満で、オープンアリーナはトムソン・ロイターのグローバルなユーザーから1,000人以上の月間内部ユーザーに対応し、ユーザーあたりの平均相互作用時間は5分になりました。内部のTR LLMの実験を促進し、LLMの使用事例のクラウドソーシングを目指すことを目標として、オープンアリーナの開始は新たな使用事例の流入をもたらし、トムソン・ロイターの広範なデータリソースと組み合わせたLLMの力を効果的に活用しました。

以下は、オープンアリーナについていくつかのユーザーのコメントです:

「オープンアリーナは、会社のあらゆる部門の従業員にLLMを実践的かつ実践的な方法で試す機会を提供しています。AIツールについて読むことと、自分で使うことは違います。このプラットフォームは、トムソン・ロイター全体でのAI学習の努力を加速させます。」

– アビー・ピント、人材開発ソリューションリード、人事機能

「OA(オープンアリーナ)は、通常の翻訳ソフトウェアでは対応できないトリッキーなニュース翻訳問題を実験することを可能にしました。また、実際のストーリーを使用してデータ漏洩の心配をせずに安全な環境で行うことができました。OAのチームは、新機能の提案に対して非常にレスポンシブであり、他のソフトウェアでは夢のようなサービスです。」

– スコット・W・スティーブンソン、ドイツ語サービスのシニアニュース記者、ドイツ・ベルリン

「オープンアリーナを使用したときに、カスタマーサポートエージェントのチーム向けに類似のインターフェースを作成するアイデアを得ました。このプレイグラウンドは、GenAIとの可能性を再考するのに役立ちました。」

– マルセル・バチスタ、ゲレンテ・デ・サービス、オペレーションカスタマーサービス&サポート

「AWSサーバーレスサービス、Amazon SageMaker、およびHugging Faceによってパワードされたオープンアリーナは、同僚に最先端のLLMと生成AIツールを迅速に公開するのに役立ち、企業全体のイノベーションを推進しました。」

– シルシャ・レイ・チョウドゥリ、リサーチエンジニアリングディレクター、トムソン・ロイター・ラボ

より広範囲で考えると、オープンアリーナの導入は会社に深い影響を与えました。それは従業員のAIへの認識を高めるだけでなく、革新と協力の精神を刺激しました。このプラットフォームは、チームを結集させ、探求し、実験し、アイデアを生み出すための環境を育むことで、画期的なコンセプトを現実にすることができる場を提供しました。

さらに、オープンアリーナはトムソン・ロイターズのAIサービスや製品にもポジティブな影響を与えています。このプラットフォームはAIのサンドボックスとして機能し、チームがAIアプリケーションを特定し、改善することができる環境を提供しています。その結果、トムソン・ロイターズのAIサービスの開発と向上が加速し、お客様には常に進化し、技術の最先端にあるソリューションが提供されています。

結論

AIの急速な進展の世界で、進歩を続けることが重要であり、トムソン・ロイターズはそのことにコミットしています。オープンアリーナのチームは、Amazon BedrockやAmazon SageMaker JumpstartなどのAWSサービスを利用して、より多くの機能を追加し、プラットフォームの能力を向上させるために常に取り組んでいます。我々は急速に進化する生成AIとLLMsの景色に遅れを取らないように進んでいきます。AWSは、TRが常に進化する生成AIフィールドに遅れを取らずに進むために必要なサービスを提供しています。

オープンアリーナプラットフォームの進行中の開発に加えて、プラットフォームによって生成された多数のユースケースの本番化にも積極的に取り組んでいます。これにより、お客様の特定のニーズに合わせたより高度で効率的なAIソリューションを提供できるようになります。さらに、イノベーションと協力の文化を育成し続け、チームがAI技術の新しいアイデアやアプリケーションを探求できる環境を提供し続ける予定です。

このエキサイティングな旅に乗り出すにあたり、オープンアリーナがトムソン・ロイターズ全体でのイノベーションと協力を推進する重要な役割を果たすと確信しています。AIの進歩の最先端にとどまることで、当社の製品とサービスが進化し続け、お客様の変化する要求に応えることを確実にします。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- マイクロソフトは、エンタープライズ向けにカスタマイズされたAzure ChatGPTを発表しました

- 「Cheetorと会ってください:幅広い種類の交互に織り交ぜられたビジョン言語の指示を効果的に処理し、最先端のゼロショットパフォーマンスを達成する、Transformerベースのマルチモーダルな大規模言語モデル(MLLMs)」

- メタAIのハンプバック!LLMの自己整列と指示逆翻訳による大きな波を起こしています

- 「3D-VisTAに会いましょう:さまざまな下流タスクに簡単に適応できる、3Dビジョンとテキストの整列のための事前学習済みトランスフォーマー」

- 「なぜOpenAIのAPIは英語以外の言語に対してより高価なのか」

- 「大規模言語モデル(LLM)を実世界のビジネスアプリケーションに移す」

- 「AIのプロセス」