このAIニュースレターがあれば、あなたは全てが揃った!#70

『このAIニュースレターがあれば、美容とファッションに関する全てが手に入ります!#70』

ルイによる今週のAIニュース

今週のAIニュースでは、2つの新しいエージェントモデルのリリースに特に興味を持っていました。NvidiaはEurekaというAIエージェントを発表しました。このエージェントは、複雑なタスクを自律的に実行するためにロボットをガイドするために設計されています。このエージェントはGPT-4によって駆動されており、83%のタスクで人間の専門家のパフォーマンスを上回る報酬関数を独自に生成することができ、平均的には52%の向上を達成しています。会社が共有した魅力的なデモでは、エージェントがロボティックハンドに迅速なペン回しの技を教える能力を示しています。このライブラリは、生成型AIと強化学習を利用して複雑なタスクを解決するために使用されます。

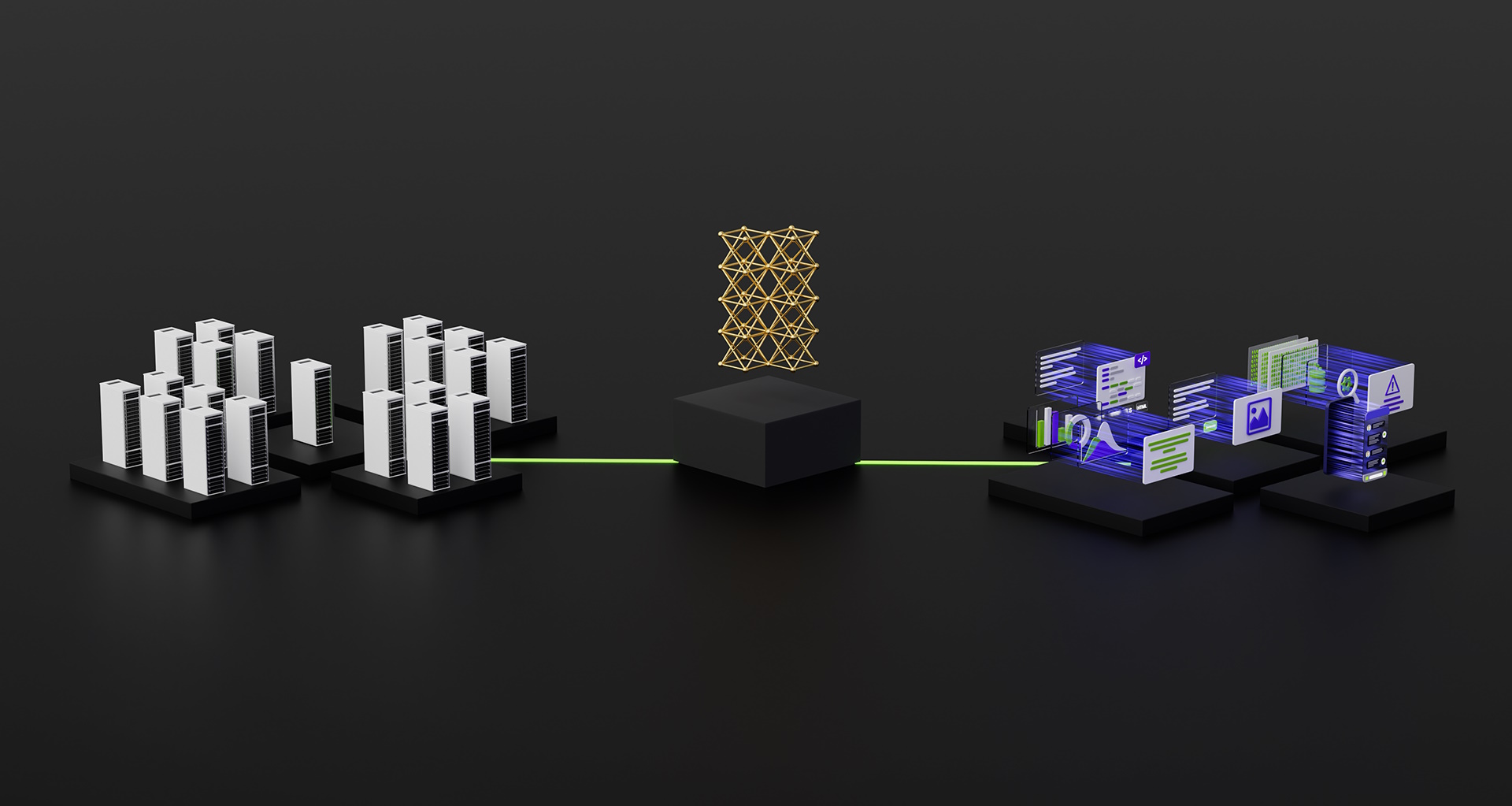

他のエージェントのニュースでは、Adeptの研究者がFuyuという名前のマルチモーダルなAIエージェントアーキテクチャを導入しました。このモデルは、8つのビリオンパラメータを持っています。このモデルは、画像とテキストを処理することができるデコーダーのみのアーキテクチャを採用しており、ネットワークの設計、スケーラビリティ、展開を簡素化することができます。さらに、既存のモデルとは異なり、異なる寸法の画像を受け入れることができるため、エージェントでの使用において貴重な追加となります。このモデルは、大きな画像に対する応答をわずか100ミリ秒で生成することができます。物理的およびオンラインアプリケーション用のAIエージェントの最近の進展にワクワクしています。商業化はまだ初期段階ですが、環境と複雑なタスクとの独立した相互作用が可能なエージェントは、新しいAI製品とアプリケーションの多くの機会を生み出します。

− ルイ・ピーターズ — Towards AI 共同創設者兼CEO

注目のニュース

OpenAIは、ChatGPTなどのAIアプリケーションの計算費用を削減するためにAIモデルArrakisの開発計画を中止しました。しかし、この逆境にもかかわらず、OpenAIの成長勢いは続いており、年間売上高は13億ドルの予測です。ただし、Googleの今後のAIモデルGeminiやAI安全サミットにおける検証など、課題に直面する可能性もあります。

- クラウドストライクは、Fal.Con 2023におけるAI駆動のセキュリティに関するビジョンを概説します

- 「リトリーバルの充実は長文の質問応答にどのように影響を与えるのか? このAIの研究は、リトリーバルの充実が言語モデルの長文での知識豊かなテキスト生成にどのような影響をもたらすかについて新しい示唆を提供します」

- 「VADERによる感情分析の洞察:感情とコミュニケーションの言語」

IBMは、外部メモリへのアクセスを減らすことでAIの速度と効率を大幅に向上させる、脳の働きを模倣したコンピュータチップ(NorthPole)を開発しました。NorthPoleは、それぞれ独自のメモリを持つ256個の計算ユニット、またはコアから構成されています。

NVIDIAの研究者たちは、Eurekaという名前のAIエージェントを作成しました。このエージェントは、ロボットを訓練するためのアルゴリズムを自動生成することができ、複雑なスキルをより速く学習することができます。Eurekaが生成した報酬プログラムは、80%以上のタスクで専門家によって書かれたものよりも優れた結果を出します。

4. AIエージェントのためのFuyu-8B:マルチモーダルアーキテクチャ

Adeptは、Fuyu-8Bという強力なオープンソースのビジョン・ランゲージモデルを紹介しました。このモデルは、画像、チャート、図表、ドキュメントに関する質問に対して理解し、応答する能力を持っています。Fuyu-8Bは、QWEN-VLとPALM-e-12Bに比べて2Bおよび4Bのパラメーターが少ないにも関わらず、3つのメトリックスのうち2つで改善されます。

5. ChatGPTの影響後、Stack Overflowは従業員の28%を解雇

Stack Overflowは、ChatGPTなどのAI技術の進歩により、従業員の28%を解雇します。ChatGPTのようなチャットボットは、Stack Overflowなどのサイトからのコンテンツに重点を置いて効率的なコーディング支援を提供します。ただし、データを収集するがソースに利益をもたらさないチャットボットの持続可能性について重要な問題が発生します。

5つの5分間の読み物/動画で学び続ける

この記事では、大規模な言語モデル(LLM)を扱う際に必要な数値や方程式について説明します。計算要件、計算の最適化、最小データセットのサイズ、最小ハードウェアパフォーマンス、推論のメモリ要件などのトピックをカバーしています。

2. LLaVa-1.5がオープンソースのAIにとって偉大な勝利である理由

LLaVa-1.5は、OpenAIのGPT-4 Visionの代わりとなる小型でありながらパワフルなオープンソースのモデルであり、大規模なマルチモーダルモデル(LMM)の可能性を証明しています。これはAIにおけるマルチモーダリティの理解の重要性を強調し、オープンソースのアプローチの実現可能性に関する疑念を払拭しています。

ビジョンプロンプトインジェクションは、攻撃者がOpenAIのGPT-4において画像を介して有害なデータをプロンプトに注入することができる脆弱性です。これにより、システムのセキュリティが危険にさらされ、攻撃者は認可されていない操作を実行したり、データを抽出したりすることが可能となります。この脆弱性への対処は複雑であり、モデルの利便性にも影響を及ぼす可能性があります。

GPT-4は、特に99パーセンタイルにおいて応答速度を急速に向上させています。GPT-4とGPT-3.5は、低いレイテンシ-トークン比を維持しており、効率的なパフォーマンスを示しています。

スタンフォード大学、MIT、プリンストン大学の研究者チームが商用ファウンデーションモデルの透明性レベルを評価するために開発した透明性指数の紹介です。この指数は、ファウンデーションモデル企業の主要な透明性の100の異なる側面を評価し、結果は改善の余地があることを示しています。

論文とリポジトリ

BitNetは、大規模な言語モデル(LLMs)におけるメモリ効率の向上とエネルギー消費の削減を目的とした1ビットトランスフォーマーアーキテクチャです。8ビットおよびFP16量子化法を上回り、効率とパフォーマンスの利点を維持しながらより大きなLLMsに効果的にスケーリングする潜在能力を示しています。

2. HyperAttention:ほぼ線形時間での長いコンテキストに対する注意力

HyperAttentionは、言語モデルにおけるより長いコンテキストの計算上の課題に対処する革新的なソリューションです。ローカリティセンシティブハッシング(LSH)を利用した既存の手法を上回り、速度を大幅に向上させます。長いコンテキストのデータセットで優れた性能を発揮し、推論を高速化しながら適切な困惑度を維持します。

3. Self-RAG:自己反映を通じた検索、生成、批判の学習

この論文では、Self-RAGと呼ばれる新しいフレームワークを紹介しています。これは言語モデルが「反映トークン」を使用してパッセージに対して反省することで、検索を強化した生成(RAG)を改善するモデルです。この改善により、QA、推論、ファクトベリフィケーションなどの知識集約型タスクにおけるより良い応答が可能となります。

4. PaLI-3 Vision Language Models:より小型で、より高速、より強力

この論文では、PaLI-3という10倍大きな類似モデルと比較して有利な性能を持つ、より小型で、より高速で、より強力なビジョン言語モデル(VLM)を紹介しています。これはコントラスティブ目的で訓練されたViTモデルを活用し、マルチモーダルベンチマークで優れた成績を収めます。

5. DeepSparse:CPU上でGPUレベルの推論を可能にする

DeepSparseは、スパースカーネル、量子化、プルーニング、アテンションキー/バリューのキャッシュなどを組み込むことによって、CPU上のディープラーニングを強化する堅牢なフレームワークです。主流のCPU上でGPUのようなパフォーマンスを実現し、専用のアクセラレータなしでモデルを効率的かつ頑健に展開することができます。

これらの論文とニュースの要約を楽しんでいますか? メールで毎日の要約を受け取る!

学びのAIコミュニティセクション!

今週のミーム!

sikewalkによって共有されたミーム

Discordの注目コミュニティ投稿

G.huyは、CUDA-Cを使用した並列計算のコード例とリソースを含むリポジトリを作成しました。これは、初心者が並列計算の概念を理解し、GPUのパワーを利用して計算集中型のタスクを高速化するための出発点となります。まずGitHubでチェックして、他のコミュニティメンバーをサポートしましょう。フィードバックや質問はスレッドで共有してください。

今週のAI投票!

Discordのディスカッションに参加してください。

TAIキュレーションセクション

今週の記事

RAGアプリケーションデザインの実践的な考慮事項 by Kelvin Lu

RAG(Retrieval Augmented Generation)アーキテクチャは、LLM(Long-form Language Model)入力長の制限と知識の切り捨て問題を克服するために効果的であることが実証されています。現在のLLM技術スタックでは、RAGはディスカッションされたアプリケーションをローカルの知識に基づいて接地し、幻想を軽減し、LLMアプリケーションを監査可能にするための基盤の一つです。この記事では、RAGアプリケーション開発の実践的な詳細について説明しています。

必読記事

ディフュージョンモデルの謎を解く:詳細な探求 by Youssef Hosni

機械学習への入門:多様な形式の探索 by RaviTeja G

QLoRA:16GB GPUで学習する大規模言語モデル by Pere Martra

Towards AIで公開したい場合は、ガイドラインを確認して登録してください。編集ポリシーと基準を満たしていれば、当社のネットワークにあなたの作品を公開します。

求人情報

Machine Learning Engineer, Large Language Model & Generative AI @Hireio, Inc. (Seattle, WA, USA)

インターンシップ: 物理を応用した科学的な機械学習 @三菱電機研究所(Cambridge, MA, USA)

ピクセルリンクス(フリーランサー/ ベルリン、ドイツ)の機械学習エンジニア

Instructor, AI/Machine Learning, Simplilearn (Part-time) @Fullstack Academy (Remote)

ここで求人情報を共有したい方は、[email protected]にお問い合わせください。

次の機械学習の面接に備えている場合は、ぜひ私たちの主要な面接準備ウェブサイト

confettiをチェックしてみてください!

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 自然言語処理ツールキット(NLTK)感情分析クイックリファレンス

- 予測分析がテクノロジーの意思決定を革命化している方法

- 『冬-8Bに出会ってください:冴えたプラットフォームの背後にある非常にユニークなファンデーションモデル』

- 「Mini-DALLE3と出会おう:大規模な言語モデルによるテキストから画像へのインタラクティブアプローチ」

- 『Talent.com』において

- PyTorchEdgeはExecuTorchを発表しました:モバイルおよびエッジデバイス向けのオンデバイスでの推論をエンパワーメント

- 『BOSSと出会ってください:新しい環境で新しい課題を解決するためにエージェントをトレーニングする強化学習(RL)フレームワーク、LLMガイダンス』