マイクロソフトとコロンビア大学の研究者が提案する「LLM-AUGMENTER」は、ブラックボックスLLMに一連のプラグアンドプレイモジュールを追加するAIシステムです

The LLM-AUGMENTER proposed by researchers from Microsoft and Columbia University is an AI system that adds a series of plug-and-play modules to the black box LLM.

大規模言語モデル(LLM)の例としてGPT-3は、広範な世界知識を持つため、一貫性のある情報豊かな自然言語テキストを生成する能力について広く認識されています。しかし、LLMにこの知識をエンコードすることは情報の損失を伴い、メモリの歪曲を引き起こし、使命遂行上重要なタスクに悪影響を及ぼす幻覚を引き起こすことがあります。さらに、一部のアプリケーションにはLLMが必要な情報をすべてエンコードすることができず、ニュースの質問応答のような時間的に敏感なタスクには適していません。外部の知識を使用してLLMを強化するためのさまざまな手法が提案されてきましたが、これらは通常、LLMパラメータの微調整を必要とするため、高額な費用がかかることがあります。そのため、使命遂行上のタスクでパフォーマンスを向上させるために固定のLLMに追加できるプラグアンドプレイモジュールが必要です。

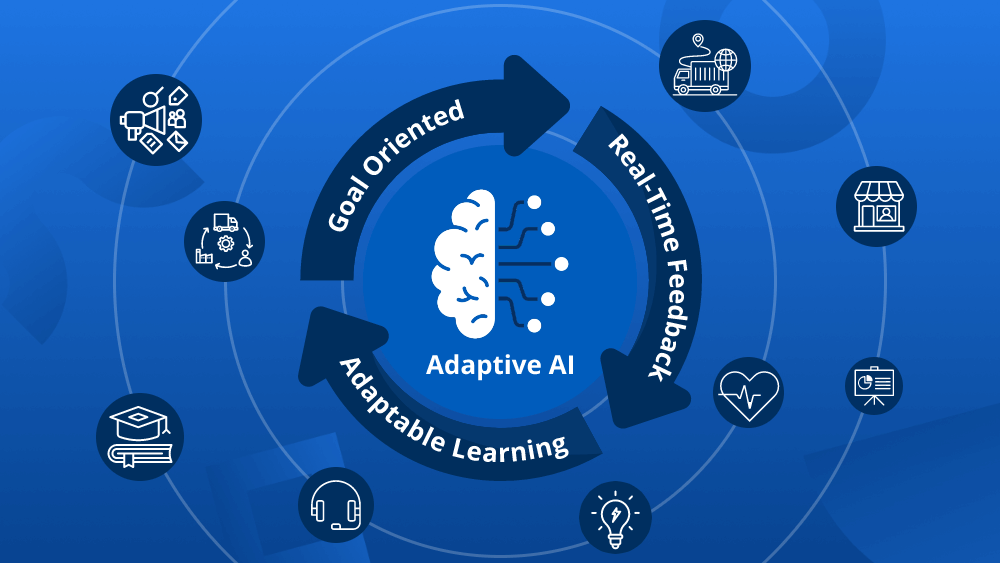

本論文では、大規模言語モデル(LLM)を使命遂行上のアプリケーションに適用する課題に取り組むためのLLM-AUGMENTERというシステムを提案しています。このシステムは、タスク固有のデータベースに格納された外部の知識を用いてブラックボックスLLMを拡張するためのプラグアンドプレイモジュールを備えています。また、LLMが生成した応答の信憑性スコアを向上させるために、ユーティリティ関数によって生成されるフィードバックを用いた反復的なプロンプトの修正も含まれています。このシステムの有効性は、タスク指向の対話およびオープンドメインの質問応答シナリオで経験的に検証されており、幻覚を大幅に減らす一方で反応の流暢さと情報量を損なうことなく改善しています。システムのソースコードとモデルは公開されています。

LLM-Augmenterのプロセスは、主に3つのステップで構成されています。まず、ユーザーのクエリが与えられると、ウェブ検索やタスク固有のデータベースなどの外部の知識源から証拠を取得します。また、取得した生の証拠を関連するコンテキストに結び付け、結合して「証拠の連鎖」を作成することもできます。次に、LLM-Augmenterは、統合された証拠を使用してChatGPTなどの固定LLMにプロンプトを与え、証拠に基づいた応答を生成します。最後に、LLM-Augmenterは生成された応答をチェックし、対応するフィードバックメッセージを作成します。このフィードバックメッセージは、候補の応答が検証要件を満たすまでChatGPTのクエリを修正して反復します。

- イタリアの新しいAI研究は、音楽合成と音源分離の両方が可能な拡散ベースの生成モデルを紹介しています

- マイクロソフトの研究者が提案するNUWA-XL:極長ビデオ生成のための新しい拡散オーバー拡散アーキテクチャ

- 新しいAI研究が「方向性刺激プロンプティング(DSP)」を導入:望ましい要約を生成するためにLLMをより適切に導くための新しいプロンプティングフレームワーク

本研究で示されている作業は、LLMとユーザーとの相互作用に関連する外部の知識をブラックボックスLLMに効果的に追加するLLM-Augmenterアプローチを示しています。この拡張により、LLMによって生成される応答の流暢さと情報の質を損なうことなく、幻覚の問題を大幅に軽減することができます。

LLM-AUGMENTERのパフォーマンスは、情報検索対話タスクにおいて自動評価と人間の評価を使用して評価されました。モデルの出力と人間の応答の真の値との重複や、データセット収集時に参照として使用された人間の知識との重複を評価するために、Knowledge F1(KF1)やBLEU-4などの一般的に使用されるメトリックが使用されました。さらに、DSTC9およびDSTC11のカスタマーサポートタスクにおいて人間の判断と最も相関するこれらのメトリックも含まれています。また、対話のテキスト生成において最も優れたパフォーマンスを発揮するBLEURT、BERTScore、chrF、BARTScoreなどの他のメトリックも考慮されました。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- スタンフォード大学とDeepMindの研究者が、大規模な言語モデル(LLMs)をプロキシ報酬関数として使用するアイデアを提案しました

- スタンフォード研究所がFlashAttention-2を発表:長い文脈の言語モデルの速度と効率の飛躍

- 「Google DeepMindの最新研究、ICML 2023にて」

- GoogleのAI研究者は、HyperDreamBoothを紹介しましたこれは、人の単一の画像から個別の重みを効率的に生成するAIアプローチであり、DreamBoothよりも小さく、25倍高速です

- KAISTとGoogleの研究者は、コラボレーションスコア蒸留(CSD)を導入しましたこれは、一貫した視覚合成のためのテキストから画像への拡散モデルの単数形を拡張したAIの手法です

- スタンフォードの研究者が提案する「EVAPORATE:言語モデルの推論コストを110倍削減する新しいAIアプローチ」

- スタンフォード大学の新しい人工知能研究は、説明が意思決定時のAIシステムへの過度の依存を軽減する方法を示しています