スタンフォード大学とMilaの研究者は、多くの大規模言語モデルの中核構築ブロックの代替として、注目しないHyenaを提案しています

Stanford University and Mila researchers propose Hyena as an alternative to the core building block of many large-scale language models.

我々は皆、ChatGPTやBardなどの驚異的な生成モデル、およびそれらの基盤技術であるGPT3やGPT4などの開発競争がAI界を大きく揺るがしていることを知っています。しかし、これらのモデルのアクセシビリティ、トレーニング、および実際の実現可能性には、私たちの日常問題に関連する多くのユースケースにおけるまだ多くの課題があります。

もし誰かがこのようなシーケンスモデルを試してみたことがあるなら、確実に興奮を台無しにする問題があるかもしれません。それは、モデルに送信できる入力の長さです。

もし彼らがこれらの技術の核心に踏み込んでカスタムモデルをトレーニングしたいという熱心な人々ならば、最適化プロセス全体が非常に困難な課題になるでしょう。

- 研究者たちは、画期的な自己感知人工筋肉を開発しました

- チューリッヒ大学の研究者たちは、スイスの4つの公用語向けの多言語言語モデルであるSwissBERTを開発しました

- 「MITの研究者が、おそらくほぼ正確な(PAC)プライバシーによる機械学習モデルのプライバシー保護において、ブレークスルーを達成」

これらの問題の核心には、シーケンスモデルが利用するアテンションモデルの最適化の二次の性質があります。最大の理由の一つは、そのアルゴリズムの計算コストとこの問題を解決するために必要なリソースです。特にスケールアップしたい場合、これは非常に高価なソリューションになります。その結果、ごく少数の集中した組織だけがこのようなアルゴリズムを理解し、制御することができる明確な感覚を持っています。

単純に言えば、シーケンスの長さに対してアテンションは二次のコストを示します。アクセス可能なコンテキストの量を制限し、それをスケールアップすることは高価な作業です。

しかし、心配しないでください。NLPコミュニティで注目されている新しいアーキテクチャ「ハイエナ」が登場し、私たちが必要としている救世主として称えられています。それは既存のアテンションメカニズムの支配に挑戦し、研究論文ではその潜在能力を示しています。

主要な大学の研究者チームによって開発されたハイエナは、最適化の観点で、さまざまなサブ二次のNLPタスクにおいて印象的なパフォーマンスを誇っています。この記事では、ハイエナの主張を詳しく見ていきます。

この論文は、サブ二次演算子がパラメータと最適化コストの観点でアテンションモデルの品質に匹敵することを示唆しています。対象となる推論タスクに基づいて、著者たちはそのパフォーマンスに寄与する3つの最も重要な特性を抽出しています。

- データ制御

- 線形未満のパラメータスケーリング

- 制約のないコンテキスト

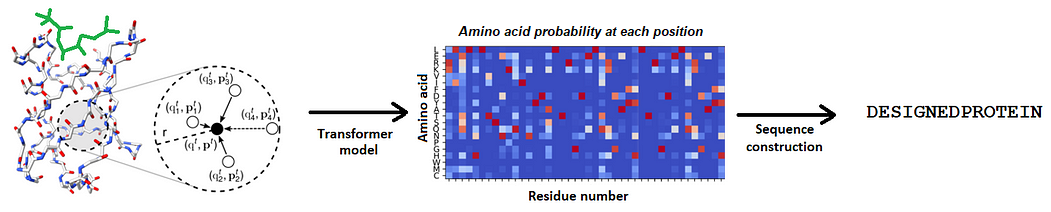

これらのポイントを念頭に置いて、彼らはハイエナ階層を導入します。この新しい演算子は、長い畳み込みと要素ごとの乗算ゲーティングを組み合わせることで、アテンションの品質をスケールできるだけでなく、計算コストを削減します。

行われた実験は驚くべき結果を明らかにしました。

- 言語モデリング

ハイエナのスケーリングは、自己回帰言語モデリングでテストされました。WikiText103やThe Pileといったベンチマークデータセットの困惑度で評価された結果、ハイエナは合計FLOPSの20%削減で、GPTの品質に匹敵する初めてのアテンションフリー、畳み込みアーキテクチャです。

WikiText103の困惑度(同じトークナイザー)。∗は(Dao et al., 2022c)の結果です。より深くて細いモデル(Hyena-slim)はより低い困惑度を実現

The Pileの困惑度(合計トークン数ごとの異なる実行)。すべてのモデルは同じトークナイザー(GPT2)を使用します。FLOPのカウントは、150億トークン実行の場合です。

- 大規模画像分類

この論文は、ハイエナを画像分類の一般的なディープラーニング演算子としての潜在能力を示しています。画像変換では、ハイエナ演算子をビジョントランスフォーマー(ViT)のアテンションレイヤーと置き換え、ViTと同等のパフォーマンスを達成しています。

私たちはCIFAR-2Dで、標準的な畳み込みアーキテクチャでHyenaの長い2D畳み込みフィルターをテストしました。このモデルは、精度を向上させるだけでなく、8%の高速化と25%のパラメーター削減を実現しています。なお、このモデルは、2Dロング畳み込みモデルS4ND (Nguyen et al., 2022) よりも優れた結果を出しています。

10億パラメータースケールでの有望な結果は、注意力だけでは十分ではなく、シンプルなサブクァドラティック設計(Hyenaなど)が効率的な大規模モデルの基盤となる可能性を示唆しています。これらの設計は、シンプルなガイドラインとメカニスティックな解釈性のベンチマークでの評価に基づいています。

このアーキテクチャがコミュニティに与える波及効果を考えると、Hyenaが最後に笑うことができるかどうか興味深いです。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「SimCLRの最大の問題を修正する〜BYOL論文の解説」

- 「信頼性の高い医療用AIツールの開発」

- ETHチューリッヒとマイクロソフトの研究者らが提案したX-Avatarは、人間の体の姿勢と顔の表情をキャプチャできるアニメーション可能な暗黙の人間アバターモデルです

- GoogleがNotebookLMを導入:あなた専用の仮想研究アシスタント

- DeepMindからの新しいAI研究では、有向グラフに対して二つの方向と構造に敏感な位置符号化を提案しています

- 新たな人工知能の研究が、言語モデルの中でマルチモーダルな連鎖思考推論を提案し、ScienceQAにおいてGPT-3.5を16%上回る結果を示しました(75.17% → 91.68%)

- 「UTオースティン大学の研究者が、安定した拡散を用いたAI手法「PSLD」を紹介追加のトレーニングなしにすべての線形問題を解決する」