Stability AIが初の日本語ビジョン言語モデルをリリース

Stability AI releases first Japanese vision language model

単一かつ包括的なモデルを作成し、さまざまなユーザー定義のタスクを処理できるようにすることは、人工知能(AI)研究の分野で長い間関心を持たれてきました。これは特に「指示チューニング」という自然言語処理(NLP)において顕著であり、広範な自然言語の指示を通じて、大規模な言語モデル(LLM)を改善することにより、モデルが任意の指示を適切に実行できるようになる方法です。

その一例が「ビジョン・ランゲージ・モデル」の使用です。「ビジョン・ランゲージ・モデル」(VLM)は、テキストと画像を入力として理解することに長けた人工知能の一種です。これらは、画像のキャプション作成、ビジュアルな質問応答、ビジュアルな風景のテキスト化や言語間およびビジュアル表現の翻訳など、さまざまなビジュアルとテキストのデータの連携を必要とするタスクを実行するために使用されます。

最近、Stability AIの研究者が初の日本語ビジョン・ランゲージ・モデル、Japanese InstructBLIP Alphaのリリースを発表しました。ビジョン・ランゲージ・モデルは多く存在していますが、これが初めて日本語のテキスト記述を生成するものです。この新しいアルゴリズムは、写真に対する日本語のテキスト記述や画像に関連するクエリに対するテキスト応答を生成することを目的としています。

- 「低コスト四足ロボットはパルクールをマスターできるのか? アジャイルなロボット運動のための革命的な学習システムを公開する」

- 「ジュラシックパークへの待ち時間は終わりましたか?このAIモデルは、イメージからイメージへの変換を使用して、古代の化石を生き返らせます」

- 「密度プロンプトのチェーンを通じたGPT-4要約の強化」

研究者は、モデルが特定の日本のランドマークを認識できることを強調しています。これにより、ロボット工学から観光まで、必要な地域特有の意識が提供されます。さらに、モデルはテキストと画像を処理できるため、視覚的な入力に基づくより複雑なクエリを処理できます。

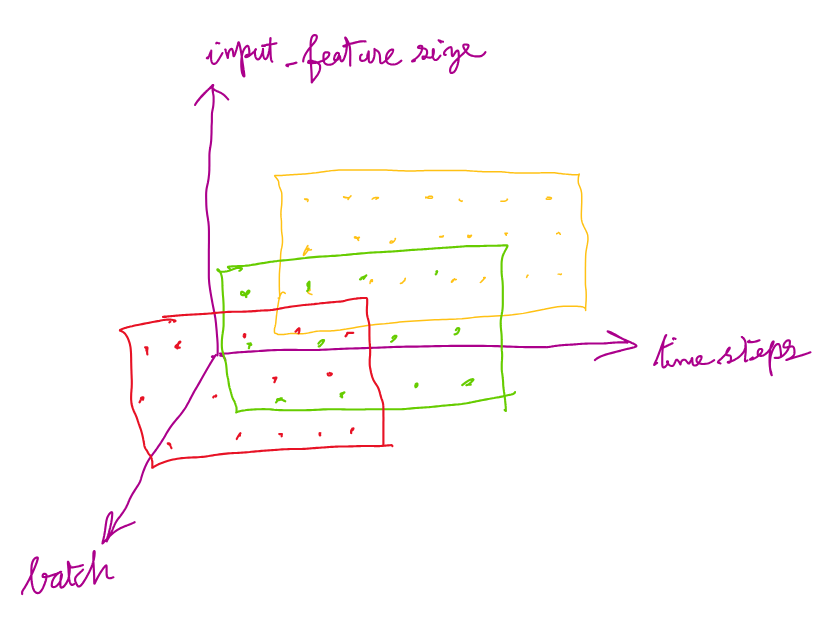

研究者は、このモデルを開発するために徹底的な研究を行い、多様な指示データを使用してモデルをトレーニングしました。そのためにモデルをイメージエンコーダ、LLM、クエリトランスフォーマ(Q-Former)でトレーニングし、Q-Formerを指示チューニングのために微調整し、イメージエンコーダとLLMは凍結しました。

さらに、研究者は公開されている26のデータセットを収集し、幅広い機能と任務をカバーするように指示チューニング形式に変換しました。モデルは13のデータセットでトレーニングされ、すべての13の保持データセットで最先端のゼロショットパフォーマンスを示しました。研究者はまた、個々の下流タスクで微調整された場合も最先端のパフォーマンスを示すことを強調しました。また、指示に特化した情報要素を抽出する指示意識のあるクエリトランスフォーマも設計しました。

彼らは、「指示に応じて柔軟かつ有益な特徴を抽出する」点を示唆する「指示意識のあるビジュアル特徴抽出」という考え方を提示しました。Q-Formerが凍結された画像エンコーダから指示意識のあるビジュアル特徴を抽出するために、テキストの指示は凍結されたLLMとQ-Formerの両方に送られます。また、データセット間で学習の進行を同期させるためにバランスの取れたサンプリング技術も行いました。

研究者は、モデルの有用性と効果にもかかわらず、潜在的なバイアスや制約について注意を喚起しています。人間の判断による正確性と適切性に基づいて、応答を判断する必要があると警告しています。日本語のビジョン・ランゲージ・タスクにおけるモデルのパフォーマンスは、継続的な研究と開発により改善される必要があります。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles