RT-2 新しいモデルは、ビジョンと言語をアクションに変換します

RT-2新モデルは、ビジョンと言語をアクションに変換する

ロボティックトランスフォーマー2(RT-2)は、ウェブデータとロボットデータの両方から学習し、この知識をロボット制御の汎用的な命令に変換する画像言語行動(VLA)モデルです。

高容量の画像言語モデル(VLM)はウェブスケールのデータセットで訓練されており、これらのシステムは視覚的なパターンや言語パターンを認識し、異なる言語での操作を非常に得意としています。しかし、ロボットが同じレベルの能力を持つためには、オブジェクト、環境、タスク、状況ごとにロボットデータを直接収集する必要があります。

本論文では、ウェブデータとロボットデータの両方から学習し、この知識をロボット制御の汎用的な命令に変換する画像言語行動(VLA)モデルであるRobotic Transformer 2(RT-2)を紹介しています。さらに、ウェブスケールの機能を維持しながら、RT-2は改善された汎化能力と意味理解、視覚理解を示します。

この研究は、マルチタスクのデモンストレーションで訓練されたRobotic Transformer 1(RT-1)に基づいています。RT-1は、ロボットデータで見られるタスクとオブジェクトの組み合わせを学習することができます。具体的には、13台のロボットを17ヶ月間オフィスのキッチン環境で収集したRT-1のロボットデモンストレーションデータを使用しました。

- DeepMindの研究者たちは、正確な数学的定義を用いて、連続した強化学習を再定義しました

- イギリスのインペリアル・カレッジ・ロンドンとディープマインドの研究者たちは、AIフレームワークを設計しましたこのフレームワークは、言語をRLエージェントの中核的な推論ツールとして使用します

- CMUの研究者が「WebArena」を導入:有用なエージェントのベンチマーキングを行うための4つ以上の現実的で再現可能なWeb環境となる4つ以上の現実的なWebアプリを備えたもの

RT-2は、ロボットデータから学習した知識を超えて、改善された汎化能力と意味理解、視覚理解を示します。これには、新しいコマンドの解釈やユーザーコマンドへの応答において、オブジェクトのカテゴリや高レベルの説明に関する推論などの基本的な推論を行う能力も含まれます。

また、連鎖思考の推論を組み込むことで、RT-2は、例えば岩を使った即席のハンマーとして使用できるオブジェクトや、疲れた人に最適な飲み物のタイプなど、多段階の意味的推論を行うことができます。

ロボット制御のためのVLMの適応

RT-2は、1つまたは複数の画像を入力として受け取り、通常は自然言語テキストを表すトークンのシーケンスを出力するVLMを基にしています。このようなVLMは、ビジュアルな質問応答、画像キャプショニング、オブジェクト認識などのタスクをウェブスケールのデータで成功裏に訓練することができます。私たちの研究では、Pathways Language and Image model (PaLI-X)とPathways Language model Embodied (PaLM-E)をRT-2のバックボーンとして適応しています。

ロボットを制御するためには、アクションを出力するようにロボットを訓練する必要があります。この課題には、モデルの出力でアクションをトークンとして表現し、標準的な自然言語のトークナイザで処理できる文字列としてアクションを記述することで対処しています。

文字列は、現在のエピソードを続行するか終了するかを示すフラグで始まり、次のコマンドを実行せずに現在のエピソードを終了する場合にはその後に位置と回転の変更コマンド、およびロボットグリッパーの所望の拡張コマンドが続きます。

RT-1と同様に、ロボットアクションの離散化バージョンを使用し、文字列表現に変換することで、VLMモデルをロボットデータで訓練できることを示しています。

一般化と出現スキル

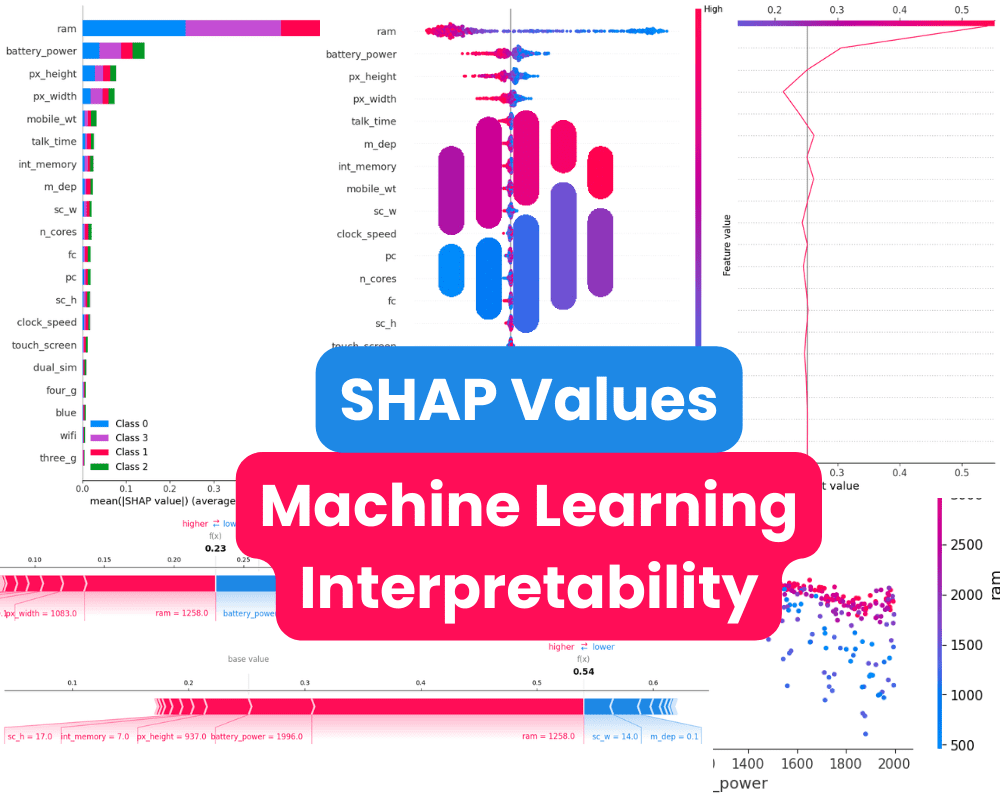

私たちはRT-2モデルについて、6,000回以上のロボットトライアルで一連の質的および量的な実験を行いました。RT-2の出現能力を探求するため、まずウェブスケールのデータとロボットの経験から知識を組み合わせる必要があるタスクを探し、その後、シンボル理解、推論、人間の認識の3つのスキルのカテゴリを定義しました。

各タスクでは、視覚的-意味的な概念を理解し、これらの概念に対してロボット制御を行う能力が必要でした。ロボットデータには存在しないオブジェクトやシナリオに対して「テーブルから落ちそうなバッグを持ち上げる」といったコマンドや「2プラス1の合計にバナナを移動する」といったコマンドなど、知識をウェブベースのデータから翻訳して操作する必要がありました。

すべてのカテゴリにおいて、以前のベースラインである以前のRT-1モデルやVisual Cortex (VC-1)などの大規模な視覚データセットで事前学習されたモデルと比べて、一般化のパフォーマンスが向上しました(3倍以上の改善)。

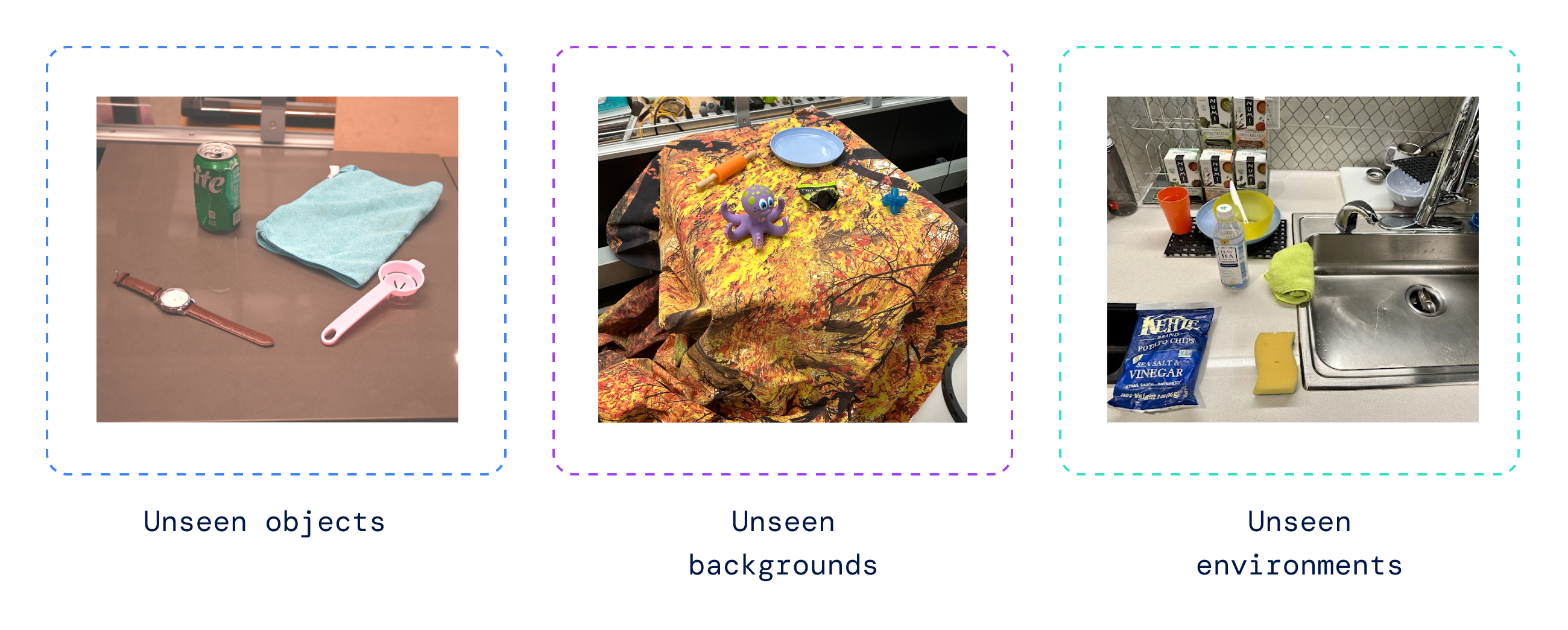

また、ロボットデータで元のRT-1タスクから開始し、ロボットがVLMの事前学習から一般化を学ぶ必要のある以前に見たことのないオブジェクト、背景、環境の程度を変えながら、一連の定量評価も行いました。

RT-2はロボットデータでの元のタスクのパフォーマンスを維持し、以前のRT-1の32%から62%に改善し、大規模な事前学習の利点を示しました。

さらに、ビジュアルのみのタスクで事前学習されたVC-1やロボット操作のための再利用可能な表現(R3M)などのベースライン、およびオブジェクトの識別にVLMを使用するアルゴリズムであるオープンワールドオブジェクトの操作(MOO)に対しても、大幅な改善が見られました。

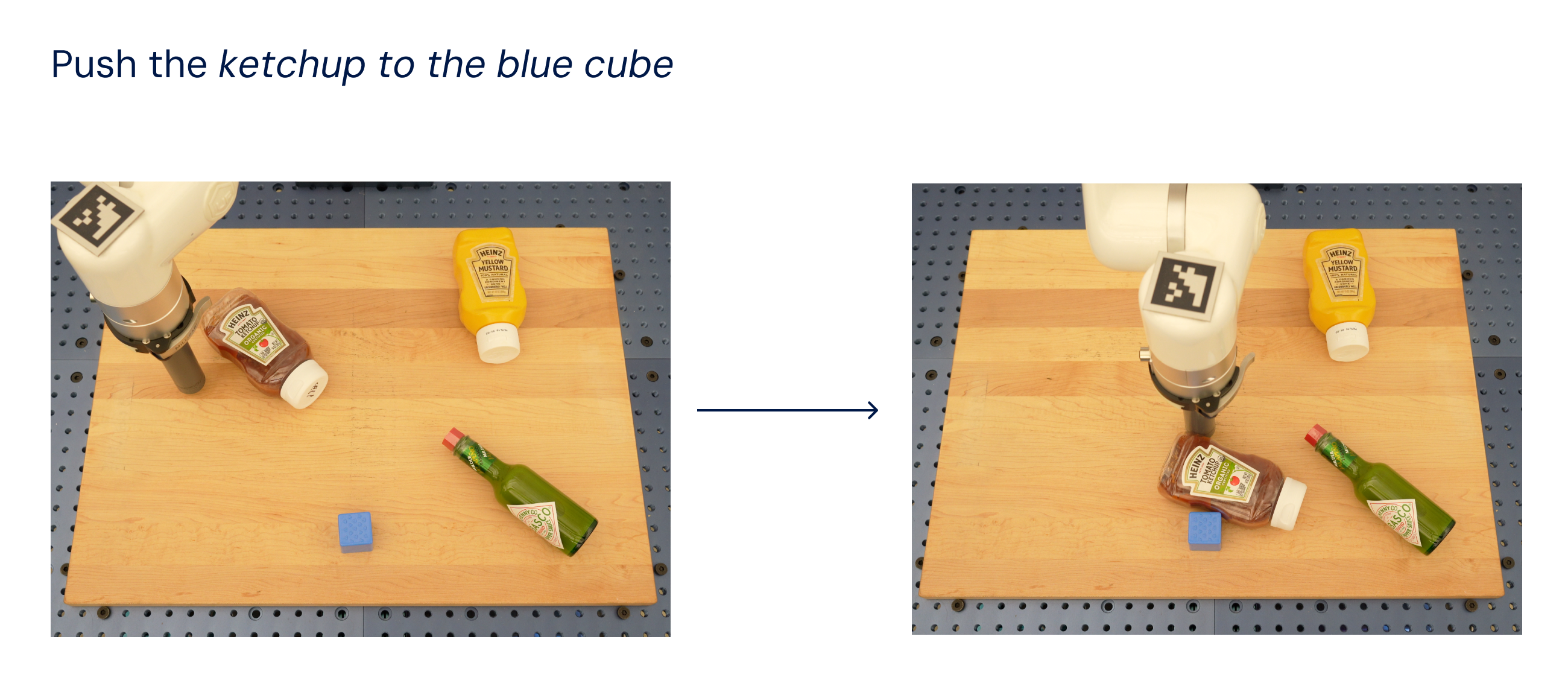

オープンソースのLanguage Table suiteのロボットタスクでモデルを評価した結果、シミュレーションでは90%の成功率を達成し、以前のベースラインであるBC-Z(72%)、RT-1(74%)、およびLAVA(77%)よりも大幅に改善しました。

次に、同じモデルを実世界で評価しました(シミュレーションと実データでトレーニングされたため)、以下に示すように、青いキューブ以外のオブジェクトはトレーニングデータセットに存在しませんでしたが、新しいオブジェクトに一般化する能力を示しました。

言語モデルにおける連鎖思考のプロンプティング手法に触発されて、私たちはロボット制御と連鎖思考の推論を組み合わせて、単一のモデル内で長期計画と低レベルのスキルの学習を可能にしました。

具体的には、RT-2の変種を微調整して、数百回の勾配ステップだけでその言語とアクションを共同で使用する能力を向上させました。そして、データを追加して、「Plan」という追加のステップを含めました。最初にロボットが自然言語で行うアクションの目的を説明し、「Action」とアクショントークンが続きます。以下にそのような推論とロボットの結果の行動の例を示します:

このプロセスにより、RT-2はユーザーの指示を達成するために必要な中間のステップについての推論を行う必要があるより複雑な命令を実行できます。VLMのバックボーンのおかげで、RT-2は画像とテキストの両方のコマンドから計画を立てることができ、現在のような計画とアクションを行う手法(SayCanなど)では実世界を見ることができず、完全に言語に依存しています。

ロボット制御の進化

RT-2は、ビジョン言語モデル(VLM)をパワフルなビジョン言語アクション(VLA)モデルに変換できることを示しています。これにより、VLMの事前トレーニングとロボットデータを組み合わせて直接ロボットを制御することができます。

PaLM-EとPaLI-Xに基づくVLAsの2つの具体例により、RT-2は非常に改善されたロボットポリシーを実現し、さらに重要なことに、ウェブスケールのビジョン言語事前トレーニングから引き継がれる大幅に向上した汎化性能と新たな能力をもたらします。

RT-2は既存のVLMモデルに対する単純かつ効果的な改良だけでなく、現実世界でさまざまなタスクを実行するための推論、問題解決、情報の解釈を行うことのできる汎用の物理ロボットの構築の可能性を示しています。

論文を読む:https://robotics-transformer2.github.io/assets/rt2.pdf

キーワードで詳細を学ぶ:https://blog.google/technology/ai/google-deepmind-rt2-robotics-vla-model/

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「INDIAaiとMetaが連携:AIイノベーションと共同作業の道を開く」

- 研究者たちは「絶対的に安全な」量子デジタルペイメントを実証

- ロボットが太陽エネルギー研究を推進

- スタンフォード大学の研究者たちは、「ギスティング:言語モデルにおける効率的なプロンプト圧縮のための新しい技術」というものを紹介しました

- メタAIとケンブリッジ大学の研究者は、大規模言語モデル(LLM)が音声認識能力でプロンプトされる方法を調査しました

- 「CMUの研究者たちは、TIDEEを提案します:明示的な指示なしで、これまで見たことのない部屋を整理することができる具現化エージェント」

- USCの研究者は、新しい共有知識生涯学習(SKILL)チャレンジを提案しましたこのチャレンジでは、分散型のLLエージェントの集団が展開され、各エージェントが個別に異なるタスクを順次学習し、全てのエージェントが独立かつ並行して動作します