「野心的なAI規制に対する力強いプロセス:オックスフォード研究からの3ステップソリューション」

Powerful process for ambitious AI regulation 3-step solution from Oxford research.

もしあなたがAccountable Manager、Product Owner、Project Manager、またはData Scientistであり、AIプロジェクトに関与している場合、Oxford ResearchはあなたをAI規制の主要な関係者として特定しています。

EU AI Actがあなたにとって何を意味するのか、Oxford Researchがどのように準拠を提案しているのかを事前に把握してください。

もし楽しんだ場合は拍手ボタンを押してください(ヒント:押し続けると最大50回の拍手をすることができます!)

AI:イノベーション vs. 規制

人工知能の規制は世界中の政府の心配事です。この注目のトピックに関する政策はまだ初期段階ですが、政策立案者には明確なトレードオフの選択があります。

イノベーション vs 規制

それは古くからの物語です。AIの利益と危険を経済に解き放ち、自由市場がそれを解決していくことを期待するのか、ビジネス投資の削減という犠牲を払ってAIの主要な危険を制限し回避するのか?

前回の投稿で議論したように、欧州連合は自らの立場を明確にしました。

人工知能法-グローバルに影響を与えるEU法

欧州連合の提案された人工知能法の範囲は驚くべきものです。これには以下のような影響があります…

VoAGI.com

EUのAI法はEU市場内でのAIの使用に対する厳しい姿勢です。EU内外の誰もがAI製品/システムでEUにアクセスしたい場合は、AI法に従う必要があります。これはデータ保護のためのGDPRに相当するAI版です。

AIの定義も広くなっており、意図的にそうなっています。この草案の前文では、AIの技術的な構成よりもAIの使用に焦点を当てています。AI法の定義は以下の領域をカバーしています:

機械学習のアプローチ:教師あり学習、教師なし学習、強化学習、ディープラーニング

論理または知識ベースのアプローチ:知識表現、帰納(論理)プログラミング、知識ベース、推論および演繹エンジン、(象徴的な)推論とエキスパートシステム

統計的アプローチ:ベイジアン推定、検索および最適化手法

彼らの提案された法律の中心的な部分は、ハイリスクと見なされるAIシステムの適合評価です。これには、AIシステムがリスクを軽減し、信頼の欠如を認識し善意で解決する努力をする必要があるという基本的な考え方が使用されます。

より具体的には:

AI技術の設計、開発、使用の慎重なモニタリング、およびこれらの技術の倫理的、法的、社会的な影響の評価

(Credit — CapAI)

上記の引用は、Oxfordの研究者による彼らのAI適合評価プロセスcapAIの出版物からです。

これに慣れてください。おそらく次の2〜3年間はこれについて聞くことになるでしょう。

注:以下にcapAIのテキストを直接参照しています。自分で読みたい場合は、リンクはこちらです。

capAI-オックスフォードの適合評価

それでは、capAIとは何でしょうか?それは欧州連合の人工知能法に準拠したAIシステムの適合評価を実施する手順です。これは高い倫理規範がデザイン、実装、使用方法にどのように反映されるかを形作る手続きに関する具体的なガイダンスです。

研究者たち自身の言葉で言えば、それは大まかに2つの使用ケースを考えています。

「高リスクAIシステム」の提供業者は、EUのAI法に適合性を示さなければなりません。

「低リスクAIシステム」の提供業者は、自主的な行動規範に対する取り組みを実施する必要があります。

(クレジット:CapAI)

適合性評価自体には、IRP、SDS、ESCの3つの要素があります。

- 内部レビュープロトコル(IRP)

- 概要データシート(SDS)

- 外部スコアカード(ESC)

(これらを一緒に見ると、CTRL、ALT、DELを思い出してしまいます)

研究者たちは、これらが結合してAI法に適合性を示す包括的な監査を提供すると主張しています。内部レビュープロセスは最も包括的な要件であり、検討すべきポイントが多数示されています。

それぞれの要素を見てみましょう:

内部レビュープロトコル(IRP)

これは品質保証とリスク管理のための内部ガバナンスモデルです。

- 内部文書。一般公開されることを意図していません。

- 技術文書の起草を支援します。

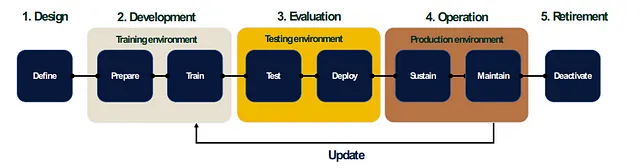

- ステークホルダーがAIシステムを運営するための「AIライフサイクル」の5つのステージに焦点を当てます。

- 設計、開発、評価、運用、廃止

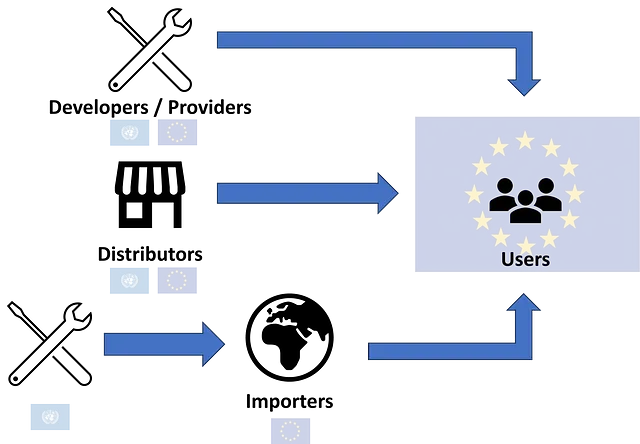

- 各ステージにおける4つの主要ステークホルダーの役割と責任、考慮事項を明記します。

- 責任者、プロジェクトマネージャー、製品オーナー、およびデータサイエンティスト

例えば、データサイエンティストは、開発および評価のステージに深く関与しています。データサイエンティストとして、これらを考えたことがありますか?それらを証明することはできますか?他の関係者との回答で一致していますか?

開発 – モデル開発の文書化:

- 組織は、トレーニング環境でのAIのパフォーマンスを文書化しましたか?

- ハイパーパラメータの設定は文書化され、正当化されましたか?

評価 – モデルテスト:

- 組織は、テスト環境でのAIのパフォーマンスを文書化しましたか?

- テストは、堅牢性や差別リスクをカバーしていますか?テストする項目について把握していますか?これらは、プロジェクトマネージャーが特定したリスクに含まれていましたか?

- モデルは、極値と保護対象属性でのパフォーマンステストが行われましたか?

- 障害のパターンが特定されています(FMEA – 障害モードおよび有効性分析)、例えば、エラーカーブ、オーバーフィッティング分析、不正確な予測の探索。

- 主要な障害モードは対処されましたか?

概要データシート(SDS)

AI法の一つの義務は、ステークホルダーが公にAIシステムを登録することです。これはガイダンスを提供します。

- 一般公開される文書

- AIシステムの目的、機能、性能の概要

外部スコアカード(ESC)

- 一般公開される文書

- IRPの主要な要素を一般の参照のために要約します

- 目的、価値、データ、ガバナンス

まとめ

ここには理解するべきことがたくさんあります。最初は困難に思えるかもしれません。capAIチームに賞賛を送ります。これはかなり幅広い法律に対するガイダンスの重要な進歩です。

法律自体は2025年まで最終化されない見込みであり、適合までの2年間の期限が設けられています。しかし、研究は待っていませんし、この作業の背後にいる人々は確かに準備をしています。

この法律に備えるためには、組織内の部門間での協力が必要です。組織が大きければ大きいほど、関係者間での一貫性を保つことは難しくなります。小規模企業にとっては、(高リスクシステムの場合)EU市場への展開前に適合と文書管理の負担は、リソース管理と専門知識の課題となります。

お読みいただきありがとうございます!もし気に入ったら拍手をして、データサイエンス/製品オーナーへの影響についても詳しく掘り下げます。

もし、これがお客様のビジネスにどのような影響を与えるか心配な場合や、詳細を聞きたい場合は、お気軽にお問い合わせください!

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles