AIの声 Voice Of AGI - Page 725

‘Perceiver IO どんなモダリティにも対応するスケーラブルな完全注意モデル’

TLDR 私たちはPerceiver IOをTransformersに追加しました。これは、テキスト、画像、音声、ビデオ、ポイントクラウドなど、あらゆる種類のモダリティ(それら...

より小さく、より速い言語モデルのためのブロック疎行列

空間と時間を節約する、ゼロを一つずつ 以前のブログ投稿では、疎行列とそのニューラルネットワークへの改善効果について紹介しました。 基本的な仮定は、完...

TransformersとRay Tuneを使用したハイパーパラメータの検索

Anyscale チームの Richard Liaw によるゲストブログ投稿 最先端の研究実装や数千ものトレーニング済みモデルへの簡単なアクセスが可能な Hugging Face trans...

fairseqのwmt19翻訳システムをtransformersに移植する

Stas Bekmanさんによるゲストブログ記事 この記事は、fairseq wmt19翻訳システムがtransformersに移植された方法をドキュメント化する試みです。 私は興味深...

エンコーダー・デコーダーモデルのための事前学習済み言語モデルチェックポイントの活用

Transformerベースのエンコーダーデコーダーモデルは、Vaswani et al.(2017)で提案され、最近ではLewis et al.(2019)、Raffel et al.(2019)、Zhang et ...

🤗 APIのお客様のためにTransformerの推論を100倍高速化する方法

🤗 トランスフォーマーは、データサイエンティストが世界中で利用するデフォルトのライブラリとなり、最新のNLPモデルを探索し、新しいNLP機能を構築するため...

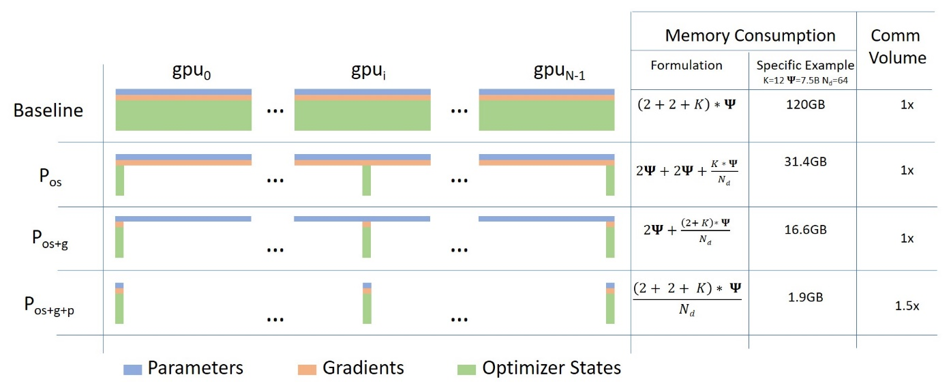

ZeROを使用して、DeepSpeedとFairScaleを介してより多くのフィットと高速なトレーニングを実現

Hugging FaceフェローであるStas Bekmanによるゲストブログ投稿 最近の機械学習モデルは、新しくリリースされたカードに追加されるGPUメモリ量よりもはるかに...

Hugging Face Transformersでより高速なTensorFlowモデル

ここ数か月、Hugging FaceチームはTransformersのTensorFlowモデルの改良に取り組んできました。目標はより堅牢で高速なモデルを実現することです。最近の改...

PyTorch / XLA TPUsでのHugging Face

お気に入りのトランスフォーマーをPyTorch / XLAを使用してCloud TPUsでトレーニングする PyTorch-TPUプロジェクトは、Facebook PyTorchチームとGoogle TPUチ...

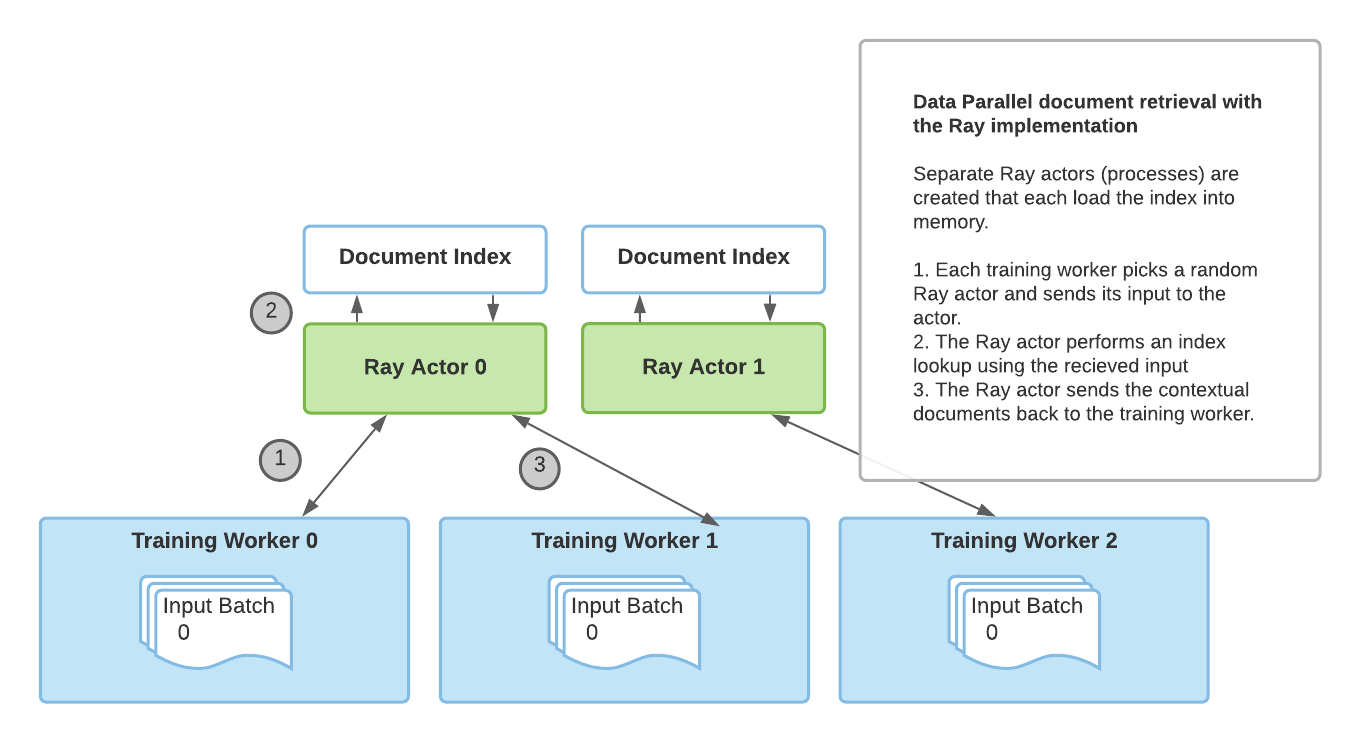

Huggingface TransformersとRayを使用した検索増強生成

アノスケールのチームからのゲストブログ投稿:Amog Kamsetty氏 Huggingface Transformersは最近、Retrieval Augmented Generation(RAG)モデルを追加しまし...

- You may be interested

- 大規模言語モデルの探索-パート2

- 大規模なMLライフサイクルの統治、パート1...

- 「アソシエーテッド・プレスがジャーナリ...

- 「A.I.ブームで最も不可欠な賞を必死に追...

- 「初心者のためのバイトペアエンコーディ...

- 「アデプトは、冬ゲームでマルチモーダル...

- パンダのプレイブック:7つの必須の包括的...

- AI音楽のソース分離:その仕組みとなぜ難...

- ML プレゼンテーションに PowerPoint を使...

- 「Flapjax プロットリーとフラスクを使っ...

- 「現実的なシミュレーションを用いたデー...

- オリゴが警告を発しています:TorchServe...

- データ体験の再発明:生成的AIと現代的な...

- Note This translation conveys the same ...

- 「Pythia 詳細な研究のための16個のLLMス...