Learn more about Search Results GSM8K - Page 3

- You may be interested

- 「光子チップ ‘レゴのようにはめ込...

- 特徴変換:PCAとLDAのチュートリアル

- 「教師たちはAIチュータリングボットを試...

- PROsに対する推論

- AIをトレーニングするために雇われた人々...

- 「現代の自然言語処理:詳細な概要パート3...

- MatplotlibとSeabornを使ったビジュアルの...

- 「ジュリアを無視するのをやめて!今すぐ...

- データ再構築の革命:広範な情報検索にお...

- 「ディズニーの新たなタスクフォースがAI...

- 「ランバード効果と聴覚障害への役立ち方」

- 開発者の生産性向上:DeloitteのAmazon Sa...

- 『私をすばやく中心に置いてください:主...

- コンピュータモデルが猫の嗅覚を説明します

- 大規模言語モデルにおける文脈の長さの拡張

「Google DeepMindの研究者たちは、PROmptingによる最適化(OPRO)を提案する:大規模言語モデルを最適化器として」

人工知能の分野では、自然言語処理、自然言語生成、自然言語理解、およびコンピュータビジョンなどのサブフィールドがますます人気を集めています。最近注目を浴びている大規模言語モデル(LLM)は、最適化のための最適化器として使用されています。その能力は最適化手法の向上のために自然言語の理解に利用されています。最適化はさまざまな産業やコンテキストで実用的な意味を持っています。派生ベースの最適化手法は、さまざまな問題をうまく処理することが実証されています。 これには、グラデーションが現実的な状況では時々しか利用できない場合があるため、困難な問題が生じます。この問題に対処するために、Google DeepMindの研究者チームは、Optimisation by PROmpting (OPRO) と呼ばれる独自のアプローチを提案しました。LLMを最適化器として使用することで、OPROは直感的で非常に強力な技術を提供します。この場合、主な新しさは、最適化タスクを表現するために日常言語を使用することで、プロセスがより簡単でアプローチしやすくなることです。 OPROは、最適化問題の自然言語での説明を提供することから始まります。これにより、問題が複雑な数式ではなく簡単な言語で表現されるため、理解しやすくなります。次に、反復的な解生成が提供されます。LLMは、与えられた自然言語プロンプトに基づいて、各最適化ステップごとに新しい候補解を作成します。このプロンプトは重要であり、以前に作成された解とそれに関連する値の詳細を含んでいます。これらの従来のオプションは、さらなる開発の出発点として機能します。 更新および評価された解が開発され、そのパフォーマンスまたは品質が評価されます。次の最適化ステップのプロンプトには、これらの解が検査された後に含まれます。反復プロセスが進むにつれて、解は徐々に改善されます。OPROの有効性を示すために、いくつかの実用的な例が使用されています。最初に、OPROは2つのよく知られた最適化問題、線形回帰問題と巡回セールスマン問題に取り組むために使用されました。これらの問題は顕著であり、手法の有効性を評価するための基準となります。OPROは、これらの問題に対して優れた解を見つける能力を示しました。 次に、OPROはプロンプトの最適化に使用されました。OPROは、特定の最適化問題に対処するだけでなく、プロンプト自体の最適化にも取り組んでいます。タスクの精度を向上させる指示を見つけることが目標です。特に自然言語処理を含むタスクでは、プロンプトの構造と内容が結果に大きな影響を与えることがあります。 チームは、OPROによって最適化されたプロンプトが一貫して人間が作成したものよりも優れていることを示しました。ある例では、OPROはBig-Bench Hardのワークロードのパフォーマンスを驚異的な50%向上させ、GSM8Kベンチマークでは最大8%向上させました。これは、OPROが最適化結果の改善において非常に大きな潜在能力を持っていることを示しています。 結論として、OPROは大規模言語モデルを利用した最適化の革新的な手法を提案しています。OPROは、最適化問題を通常の言語で説明し、解を繰り返し生成および改善することで、一般的な最適化問題の解決とプロンプトの改善において、従来の手法に比べて著しいパフォーマンスの向上を示しています。特に、グラデーション情報が利用できないか収集が困難な場合には、その効果が顕著です。

「言語モデルにアルゴリズム的な推論を教える」

Posted by Hattie Zhou, MILAの大学院生、Hanie Sedghi, Googleの研究科学者 GPT-3やPaLMなどの大規模言語モデル(LLM)は、モデルとトレーニングデータのサイズを拡大することで、近年驚異的な進歩を遂げています。それにもかかわらず、LLMが象徴的に推論できるか(すなわち、論理的なルールに基づいて記号を操作できるか)という長年の議論がありました。たとえば、LLMは、数字が小さい場合には簡単な算術演算を実行できますが、数字が大きい場合は苦労します。これは、LLMがこれらの算術演算を実行するために必要な基本的なルールを学習していないことを示唆しています。 ニューラルネットワークはパターンマッチング能力に優れていますが、データ中の偶発的な統計的パターンに過学習しやすいです。これは、トレーニングデータが大きく多様であり、評価が分布内である場合には良いパフォーマンスに影響しません。ただし、加算などのルールベースの推論を必要とするタスクでは、LLMは分布外の一般化に苦労し、トレーニングデータの偶発的な相関は真のルールベースの解決策よりもはるかに容易に利用されることがしばしばあります。その結果、さまざまな自然言語処理タスクでの重要な進展にもかかわらず、加算などの簡単な算術タスクのパフォーマンスは依然として課題のままです。MATHデータセットでのGPT-4のささやかな改善にもかかわらず、エラーは主に算術と計算のミスによるものです。したがって、重要な問題は、LLMがアルゴリズム的な推論が可能かどうかということです。アルゴリズム的な推論は、アルゴリズムを定義する一連の抽象的なルールを適用してタスクを解決することを含みます。 「コンテキスト学習を通じたアルゴリズム的な推論の教育」では、コンテキスト学習を活用してLLMにアルゴリズム的な推論能力を可能にするアプローチについて説明しています。コンテキスト学習とは、モデルがモデルのコンテキスト内でそれに関するいくつかの例を見た後にタスクを実行できる能力を指します。タスクはプロンプトを使用してモデルに指定され、重みの更新は必要ありません。また、より困難な算術問題においてプロンプトで見られるものよりも強力な一般化を実現するための革新的なアルゴリズム的プロンプティング技術を提案しています。最後に、適切なプロンプト戦略を選択することで、モデルが分布外の例でアルゴリズムを信頼性を持って実行できることを示しています。 アルゴリズム的プロンプトを提供することで、コンテキスト学習を通じてモデルに算術のルールを教えることができます。この例では、LLM(単語予測)は、簡単な加算の質問(例:267 + 197)をプロンプトとして入力すると正しい答えを出力しますが、桁数の長い類似の加算の質問に対しては失敗します。ただし、より困難な質問に加算のアルゴリズム的プロンプトを追加すると(単語予測の下に表示される青いボックスと白い+)、モデルは正しく答えることができます。さらに、モデルは一連の加算計算を合成することによって乗算アルゴリズム( X )をシミュレートすることができます。 アルゴリズムをスキルとして教える モデルにアルゴリズムをスキルとして教えるために、アルゴリズムプロンプトを開発します。これは、他の根拠に基づいたアプローチ(スクラッチパッドや思考の連鎖など)を基に構築されます。アルゴリズムプロンプトは、LLMからアルゴリズム的な推論能力を抽出し、他のプロンプトアプローチと比較して2つの注目すべき特徴があります。 1)アルゴリズミックな解決策に必要な手順を出力してタスクを解決し、2)LLMによる誤解釈の余地がないように、各アルゴリズミックな手順を十分な詳細で説明します。 アルゴリズム的なプロンプトの直感を得るために、2つの数字の加算のタスクを考えてみましょう。スクラッチパッドスタイルのプロンプトでは、右から左に各桁を処理し、各ステップでキャリー値(現在の桁が9より大きい場合は次の桁に1を追加します)を追跡します。ただし、キャリーのルールはキャリー値の数例を見た後ではあいまいです。キャリーのルールを明示するために明示的な方程式を含めると、モデルは関連する詳細に焦点を当て、プロンプトをより正確に解釈することができることがわかります。この洞察を活用して、2つの数字の加算のためのアルゴリズム的なプロンプトを開発しました。計算の各ステップに対して明示的な方程式を提供し、曖昧さのない形式でさまざまなインデックス操作を説明します。 さまざまな加算のプロンプト戦略のイラスト。 答えの桁数が最大5桁までの加算のプロンプト例を3つだけ使用して、19桁までの加算のパフォーマンスを評価します。正確性は、答えの長さに均等にサンプリングされた合計2,000の例において測定されます。以下に示すように、アルゴリズムのプロンプトの使用により、プロンプトで見られる以上に長い質問に対しても高い正確性が維持されており、モデルが入力に関係ないアルゴリズムを実行することによってタスクを解決していることが示されています。 異なるプロンプトのメソッドによる加算問題のテスト正確性の長さの増加。 アルゴリズム的なスキルを道具として活用する モデルがより一般的な推論プロセスにおいてアルゴリズミックな推論を活用できるかどうかを評価するために、学校の数学のワードプロブレム(GSM8k)を使用してパフォーマンスを評価します。具体的には、GSM8kからの加算計算をアルゴリズミックな解決策で置き換える試みを行います。…

「5つの最高のオープンソースLLM」

人工知能(AI)の急速に進化する世界では、大規模言語モデル(LLM)が中心となり、革新を推進し、私たちが技術とのやり取りを再構築する方法を変えましたこれらのモデルがますます洗練されるにつれて、それらへのアクセスを民主化することが重視されています特にオープンソースのモデルは、この民主化において重要な役割を果たしています[…]

メタのラマ2:商業利用のためのオープンソース言語モデルの革命化

メタは、Llama 1言語モデルの画期的な後継機である、大いに期待されているLlama 2のリリースにより、再びAIの限界を押し上げました最新の先進機能を誇る…

このAIニュースレターは、あなたが必要とするすべてです #56

今週、オープンソースとクローズドモデルの両方で、LLMの世界にいくつかの新しい競合他社が登場しました印象的な機能を持つにもかかわらず、LLaMAモデルの最初のバージョンにはライセンスの問題がありました...

「クロード2の探索:アントロピックの次世代AIへの野心的な一歩」

人工知能の常に進化する世界において、元OpenAIのリーダーが共同設立したスタートアップ企業Anthropicは、産業の支配を目指してさらなる一歩を踏み出しました彼らは最近、AIチャットボットのClaude 2のデビューを発表し、これはOpenAIやGoogleのようなAIの巨人たちと並ぶ存在として自社を確立するための重要なマイルストーンとなりましたAnthropicの誕生は[…]

アンソロピックは、以前のモデルと比べて、コーディング、数学、論理思考において大幅な改善を果たしたClaude 2モデルをリリースしました

Anthropicは、Claude 2という新しいモデルを発表しました。このモデルは、改善されたパフォーマンス、より長い応答時間、APIと公開ベータウェブサイトを通じたアクセシビリティを誇っています。ユーザーはClaudeの会話能力、明確な説明、有害な出力の生成確率の低減、前のモデルと比較してのメモリの改善に対して称賛しています。特に、Claude 2は、コーディング、数学、推論タスクにおいて優れたパフォーマンスを発揮しました。例えば、バー試験の多肢選択問題のセクションで76.5%のスコアを獲得し、前任者の73.0%を上回りました。大学院入学試験を受験する大学生と比較して、Claude 2はGREのリーディングとライティングの試験で90パーセンタイル以上の成績を収め、量的推論の試験では中央値の応募者と同等の成績を収めました。 開発者は、Claudeを友好的で熱心なバーチャルな同僚やパーソナルアシスタントと位置付け、さまざまなタスクをサポートするための自然言語の指示を理解する能力を持つ存在としています。ビジネス向けのClaude 2 APIは、先代モデルであるClaude 1.3と同じ価格で利用できます。また、アメリカとイギリスの個人は既にベータ版のチャット体験を利用することができます。 Claudeモデルのパフォーマンスと安全性の向上に努めています。入力と出力の長さが増え、ユーザーは最大100,000トークンまでのプロンプトを入力することができます。これにより、Claudeは広範な技術文書や書籍を処理し、メモ、手紙、物語など、数千のトークンから成る長い文書を生成することができます。 最新のモデルであるClaude 2は、コーディングスキルが大幅に向上しました。Codex HumanEval Pythonコーディングテストで71.2%のスコアを獲得し、前任者のClaude 1.3の56.0%を上回りました。GSM8kの数学問題セットでは、Claude 2は88.0%のスコアを獲得し、前任者の85.2%を上回りました。将来の計画には、Claude 2の能力向上を徐々に展開することが含まれています。 有害で攻撃的な出力を減少させるために、安全対策に注力しています。内部のレッドチーミング評価では、Claudeモデルを有害なプロンプトの代表的なセットに対して評価し、自動テストと手動のチェックを組み合わせています。Claude 2は、Claude 1.3と比較して無害な応答を提供する効果が2倍でした。望ましくない出力に完全に免疫を持つモデルは存在しませんが、安全技術と包括的なレッドチーミングは、出力の総合的な品質の向上に役立っています。 多くの企業がClaude APIを採用しており、JasperやSourcegraphなどのパートナーはClaude 2の機能を活用しています。ジャスパーは、多様なユースケース向けの最先端モデルとの互換性を強調し、長文、低遅延のアプリケーションにおける強みを強調しています。ソースグラフは、コーディングアシスタントのCodyにClaude 2の改善された推論能力を組み込み、ユーザーのクエリに対してより正確な回答を提供し、最大100,000のコンテキストウィンドウを通じてコードベースのコンテキストを伝えることができます。Claude 2の最新データでのトレーニングにより、Codyはより新しいフレームワークとライブラリに関する知識を備えており、開発者がソフトウェアをより効率的に構築することができます。…

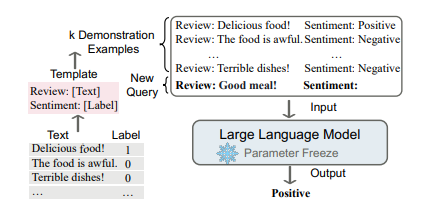

大規模な言語モデルにおけるコンテキストに基づく学習アプローチ

言語モデリング(LM)は、単語のシーケンスの生成的な尤度をモデル化することを目指し、将来の(または欠損している)トークンの確率を予測します言語モデルは自然言語処理の世界を革新しました...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.