Learn more about Search Results SDXL 1.0 - Page 2

- You may be interested

- 実験から展開へ:MLflow 101 | パート02

- 「アマゾンベッドロックを使った商品説明...

- Langchain、Weviate、およびStreamlitを使...

- ダブルマシンラーニングの簡素化:パート2...

- お客様との関係を革新する:チャットとRea...

- ロボット用の物理シミュレータを公開する

- 新しいNVIDIA GPUベースのAmazon EC2イン...

- (「AI ga hontōni watashitachi o zenmets...

- 「Plotly Expressのサンバーストチャート...

- A.I.が建築家に職場デザインの変革をもた...

- 『AI入門』

- ファインチューニングLLM パラメータ効率...

- 「Powderworldに出会おう:AIの汎化理解の...

- コロンビア大学とDeepMindの研究者が、GPA...

- 「自然再造プロジェクトのグローバルな潜...

「生成モデルを本番環境に展開する際の3つの課題」

OpenAI、Google、Microsoft、Midjourney、StabilityAI、CharacterAIなど、誰もがテキストからテキスト、テキストから画像、画像から画像、画像からテキストへのモデルの最良の解決策を提供するために競争しています...

「クロスファンクションの機械学習プロジェクトの20の学び」

「クロスチームのプロジェクトでリーダーシップを取るか、または助けるかに関わらず、それは圧倒的なものとなるかもしれませんそして、締め切りを追い、時には複雑な状況を管理するストレスは、常に「何をすればいいのか」という感覚を持つことがあります...」

2024年に探索するべきトップ12の生成 AI モデル

はじめに 近年、人工知能(AI)は非凡な変革を遂げ、創造性の風景を再構築するだけでなく、多様な産業における自動化の新たな基準を設定する先駆的な技術となっています。2024年に入ると、これらの先進的なモデルは画期的な能力、広範な応用、そして世界に紹介する先駆的なイノベーションにより、その地位を固めました。本記事では、今年の主要な生成型AIモデルについて詳しく探求し、彼らの革新的な能力、様々な応用、そして世界にもたらすパイオニア的なイノベーションについて包括的に説明します。 テキスト生成 GPT-4:言語の神童 開発者:OpenAI 能力:GPT-4(Generative Pre-trained Transformer 4)は、文脈の深い理解、微妙な言語生成、およびマルチモーダルな能力(テキストと画像の入力)で知られる最先端の言語モデルです。 応用:コンテンツの作成、チャットボット、コーディング支援など。 イノベーション:GPT-4は、規模、言語理解、多様性の面でこれまでのモデルを上回り、より正確かつ文脈に即した回答を提供します。 この生成型AIモデルにアクセスするには、こちらをクリックしてください。 Mistral:専門家の混合体 開発者:Mistral AI 能力:Mistralは、専門的なサブモデル(エキスパート)に異なるタスクを割り当てることで効率と効果を向上させる、洗練されたAIモデルです。 応用:高度な自然言語処理、パーソナライズされたコンテンツの推薦、金融、医療、テクノロジーなど、様々なドメインでの複雑な問題解決など、幅広い応用があります。 イノベーション:Mistralは、ネットワーク内の最適なエキスパートにタスクを動的に割り当てることによって特徴付けられます。このアプローチにより、専門的で正確かつ文脈に適した回答が可能となり、多面的なAIの課題処理において新たな基準を設定します。 このMistral AIにアクセスするには、こちらをクリックしてください。 Gemini:多面的なミューズ 開発者:Google AI Deepmind…

このAIニュースレターはあなたが必要とするものです#76

今週、私たちはトランスフォーマーや大規模な言語モデル(LLM)の領域を超えた重要なAIの進展に焦点を当てました最近の新しいビデオ生成拡散ベースのモデルの勢いについて…

「DreamSyncに会ってください:画像理解モデルからのフィードバックを用いてテキストから画像の合成を改良する新しい人工知能フレームワーク」

カリフォルニア大学南部、ワシントン大学、バール・イラム大学、およびGoogle Researchの研究者は、人間の注釈、モデルアーキテクチャの変更、または強化学習の必要性を排除して、拡散ベースのテキストから画像への変換(T2I)モデルにおける整列と美的魅力の向上の問題に取り組むDreamSyncを紹介しました。これは、候補画像を生成し、Visual Question Answering(VQA)モデルを使用して評価し、テキストから画像へのモデルを微調整することにより、その目的を達成しています。 以前の研究では、TIFAなどのVQAモデルを使用してT2I生成を評価することが提案されていました。 TIFAでは、4Kのプロンプトと25Kの質問を使用して、12のカテゴリにわたる評価を実施できます。 SeeTrueやRLHFなどのトレーニング関連手法やトレーニングアダプタなどは、T2Iの整列に取り組んでいます。 SynGenやStructuralDiffusionなどのトレーニングフリーテクニックは、整列の推論を調整します。 DreamSyncは、特定のアーキテクチャやラベル付きデータに依存せずに、ユーザーの意図と美的な魅力に対する忠実度を向上させるT2Iモデルの課題に取り組むためのモデル非依存のフレームワークを採用しています。ビジュアル-言語モデル(VLM)を利用して生成された画像と入力テキストとの相違点を特定するモデル非依存のフレームワークを導入しています。この方法では、複数の候補画像を作成し、VLMを使用して評価し、T2Iモデルを微調整します。 DreamSyncはベースラインの手法を上回る画像の整列を提供し、さまざまな画像特性を向上させることができ、整列改善に限定されない応用範囲を持っています。 DreamSyncは、VLMからのフィードバックを使用してT2I生成の整列を行うためのモデル非依存のフレームワークを採用しています。このプロセスでは、プロンプトから複数の候補画像を生成し、それらをテキストの忠実度と画像の美的魅力のために専用のVLMで評価します。 VLMのフィードバックによって選択された最良の画像は、収束するまで反復してT2Iモデルを微調整するために使用されます。また、反復的なブートストラッピングを導入し、VLMを教師モデルとして使用して、T2Iモデルのトレーニングのためのラベルのないデータをラベル付けします。 DreamSyncは、SDXLとSD v1.4のT2Iモデルの両方を向上させ、SDXLの3つのイテレーションでは、TIFAで忠実度が1.7ポイントおよび3.7ポイント向上しました。ビジュアルの美的感覚も3.4ポイント向上しました。DreamSyncをSD v1.4に適用すると、TIFAで忠実度が1.0ポイント向上し、絶対スコアが1.7ポイント増加し、美的感覚が0.3ポイント向上します。比較研究では、DreamSyncは整列においてSDXLを上回り、より適切なコンポーネントを持つ画像と3.4個の正しい回答を生成します。それはTIFAとDSGのベンチマークで視覚的な忠実度を妥協することなく優れたものを達成し、反復による徐々の改善を示しています。 結論として、DreamSyncは難しいT2Iベンチマークで評価された多目的なフレームワークであり、配布内および配布外の設定の両方で整列と視覚的魅力の重要な改善を示しています。このフレームワークは、ビジョン-言語モデルからの二重フィードバックを組み込んでおり、人間の評価と好み予測モデルによって検証されています。 DreamSyncの将来の改善点には、ミスアライメントの特定のための詳細なアノテーション(バウンディングボックスなど)を使用したフィードバックの作成が含まれます。各イテレーションでプロンプトを調整することにより、テキストから画像への合成において特定の改善を目指します。言語構造と注意マップの探求により、属性-オブジェクトの結びつきを向上させることを目指しています。人間のフィードバックで報酬モデルをトレーニングすることで、生成された画像をユーザーの意図に合わせることができます。DreamSyncの応用範囲を他のモデルアーキテクチャに拡大し、パフォーマンスの評価および多様な設定での追加の研究を行うことは、現在の調査の領域です。

パフォーマンスの向上と最適化されたリソース使用のためのダイナミックなLoRAローディング

私たちは、拡散モデルに基づくLoRAのハブ内の推論速度を大幅に高速化することができました。これにより、計算リソースを節約し、より良いユーザーエクスペリエンスを提供することができました。 モデルへの推論を行うには、2つのステップがあります: ウォームアップフェーズ – モデルのダウンロードとサービスのセットアップ(25秒)。 推論ジョブ自体(10秒)。 これらの改善により、ウォームアップ時間を25秒から3秒に短縮することができました。数百の異なるLoRAに対する推論を、たった5つのA10G GPU以下で提供することができます。さらに、ユーザーリクエストへの応答時間は35秒から13秒に短縮されました。 一つのサービスで多くの異なるLoRAを動的に提供するために、Diffusersライブラリで開発された最近の機能を活用する方法についてもっと話しましょう。 LoRA LoRAは「パラメータ効率」(PEFT)メソッドの一環である、微調整技術です。このメソッドは、微調整プロセスによって影響を受けるトレーニング可能なパラメータの数を減らすことを試みます。微調整の速度を高めながら、微調整済みチェックポイントのサイズを減らすことができます。 モデルの全ての重みに微小な変更を行うことによってモデルを微調整する代わりに、ほとんどの層を固定し、注意ブロック内の特定の一部の層のみをトレーニングします。さらに、これらの層のパラメータに触れず、二つの小さな行列の積を元の重みに加えることで、これらの層のパラメータを更新します。これらの小さな行列は微調整プロセス中に更新され、ディスクに保存されます。これにより、元のモデルのパラメータはすべて保存され、適応方法を使用してLoRAの重みを上にロードすることができます。 LoRA(Low Rank Adaptation)という名前は、先ほど言及した小さな行列から来ています。このメソッドについての詳細は、この記事または元の論文をご覧ください。 上記の図は、LoRAアダプタの一部として保存される二つの小さなオレンジ色の行列を示しています。後でこれらのLoRAアダプタをロードし、青いベースモデルと結合して黄色の微調整モデルを取得することができます。重要なことは、アダプタをアンロードすることも可能なので、いつでも元のベースモデルに戻すことができるということです。 言い換えると、LoRAアダプタは、必要に応じて追加および削除が可能なベースモデルのアドオンのようなものです。AとBの小さなランクのため、モデルサイズと比較して非常に軽量です。したがって、ロード時間は全体のベースモデルをロードするよりもはるかに高速です。 例えば、多くのLoRAアダプタのベースモデルとして広く使用されているStable Diffusion XL Base 1.0モデルリポジトリを見ると、そのサイズは約7 GBです。しかし、このモデルのような典型的なLoRAアダプタは、わずか24 MBのスペースしか使用しません!…

簡単なアプリの統合に最適な安定した拡散APIのトップ5

イントロダクション APIは人工知能の時代における解決策であり、AIモデルをソフトウェアやアプリケーションに統合する際の高い計算要件を管理する企業にとって重要な課題です。その解決策として、Application Programming Interfaces(API)が存在します。APIはメンテナンスの手間を省き、ビジネスロジックとユーザーエクスペリエンスに集中できるようにしてくれます。つまり、誰でもこれらのAPIを活用してアプリを構築し、商品化できます。本記事では、画像生成に焦点を当てた一連のGenerative AIモデルであるStable Diffusion APIsについて詳しく説明します。 まずは非常に効率的かつ効果的なオプションであるSegmind APIについて見ていきましょう。これらのAPIは、開発者、デザイナー、クリエイターが視覚コンテンツの生成に取り組む方法を革新しました。トップ5のStable Diffusion APIsを探求し、その特徴、使用用途、価格などをハイライトします。 学習目標 Stable Diffusionモデルに関する洞察を得る。 Stable Diffusionモデルの基礎を理解する。それには、その応用も含まれます。 現代のソフトウェア開発におけるAPIの理解。 APIがソフトウェアおよびアプリケーションの開発を簡素化する際に果たす重要な役割の探求。 この記事はData Science Blogathonの一環として公開されました。 Stable Diffusionモデルの理解 Stable…

このAI論文は、高度な潜在的一致モデルとLoRA蒸留によってテキストから画像を生成するタスクを革新するLCM-LoRAを紹介しています

潜在拡散モデルは機械学習における生成モデルであり、特に確率モデリングで使用されます。これらのモデルはデータセットの潜在的な構造や潜在変数を捉えることを目指しており、リアルなサンプルの生成や予測に焦点を当てています。これらは時間とともにシステムの進化を記述します。これは、一連のステップや拡散プロセスを通じて初期分布から目的の分布へのランダム変数のセットの変換を指すことができます。 これらのモデルはODE-Solverのメソッドに基づいていますが、推論ステップの数を減らす一方で、特にクラシファイアフリーガイダンスを組み込む場合にはかなりの計算オーバーヘッドを要求します。Guided-Distillなどの蒸留法は有望ですが、その計算要件が高いため改善が必要です。 こうした課題に取り組むために、潜在一貫性モデルの必要性が浮かび上がってきました。彼らのアプローチでは、Augmented Probability Floe ODE問題として逆拡散プロセスを取り扱い、潜在空間での解を予測し、数値ODEソルバーを介した反復的な解決の必要性を回避します。これにより、高解像度画像の顕著な合成にはわずか1〜4の推論ステップがかかります。 清華大学の研究者は、LoRA蒸留をStable-Diffusionモデル(SD-V1.5、SSD-1B、SDXLなど)に適用することで、LCMの潜在的な可能性を拡大しました。彼らは、優れた画像生成品質を実現することで、メモリ消費を大幅に削減しながら大規模なモデルにLCMの適用範囲を広げました。アニメ、フォトリアル、ファンタジー画像などの特殊なデータセットでは、Latent Consistency Distillation(LCD)を使用して事前学習されたLDMをLCMに蒸留するか、LCFを使用してLCMを直接微調整するなど、追加のステップが必要です。しかし、カスタムデータセットにおいて高速でトレーニングフリーな推論を実現することは可能でしょうか。 チームは、これに答えるためにさまざまなStable-Diffusionで微調整されたモデルに直接接続できるトレーニングフリーの高速化モジュールであるLCM-LoRAを紹介します。LoRAのフレームワークの中で、得られたLoRAパラメータは元のモデルパラメータにシームレスに統合することができます。チームは、潜在一貫性モデル(LCMs)の蒸留プロセスにLoRAを使用することの実現可能性を示しました。LCM-LoRAパラメータは他のLoRAパラメータと直接組み合わせることができ、特定のスタイルのデータセットで微調整することができます。これにより、追加のトレーニングなしで特定のスタイルで画像を生成することができます。したがって、これらは多様な画像生成タスクにおいて普遍的に適用可能なアクセラレータを表します。 この革新的なアプローチにより、反復ステップの必要性が大幅に削減され、テキスト入力からの高信頼性画像の迅速な生成が可能となり、最先端のパフォーマンス基準を設定しています。LoRAはパラメータの変更する必要のあるボリュームを大幅に削減し、計算効率を向上させ、データが少なくてもモデルの改良を可能にします。

Segmind APIsを使用した安定した拡散モデルのサーバーレスAPIの活用

紹介 現代のソフトウェア開発において、サーバーレスコンピューティングの登場により、アプリケーションの構築と展開の方法が革命されました。利用可能なツールとテクノロジーの中で、サーバーレスAPIは堅牢でスケーラブル、効率的なアプリケーションを作成するためのエンエーブラーとなっています。また、現代のソフトウェアシステムに< a href=”https://www.voagi.com/midjourney-vs-stable-diffusion-ai-image-generators-battle.html”>Stable Diffusionモデルなどの人工知能技術を統合する必要性があるため、これらのサーバーレスAPIを使用する能力は有用です。本記事では、サーバーレスAPIの概念を探求し、AIおよび機械学習システムのリーディングカンパニーであるSegmindが提供する幅広いサーバーレスAPIをプロジェクトに統合する方法について説明します。 学習目標 現代のアプリケーション開発におけるサーバーレスAPIの理解 SegmindのサーバーレスAPIとその応用の習得 SegmindのAPIをNode.jsとPythonで使用する方法の学習 APIに関連するセキュリティ上の問題に対処する この記事は、データサイエンスブロガソンの一部として掲載されました。 サーバーレスAPIの理解 SegmindのサーバーレスAPIに入る前に、サーバーレスAPIとは何か、なぜ現代のソフトウェア開発において画期的な存在なのかについて理解しましょう。 サーバーレスAPI:簡潔な歴史 サーバーレスAPIは、オンライン取引を容易にするために設計されたアプリケーションプログラミングインタフェースの一形態であり、開発者が外部サービスとのやり取りを行う方法を変革しました。従来、開発者は特定のタスク(例:支払い処理、マッピングサービスなど)のためにゼロから関数を構築する必要がありました。このアプローチはしばしば時間がかかり、リソースが多く必要でした。 サーバーレスAPIは異なります。支払い認証、マッピング、天気データなど、目的を果たすための小型アプリケーションのようなものです。革新的な点は、これらのAPIがサーバーレスバックエンドによって動作することで、開発者は物理サーバーの管理やサーバーメンテナンスの複雑さを心配する必要がなくなったということです。 サーバーレスAPIの利点は何ですか? サーバーレスAPIの利点は多岐に渡ります: サーバー管理が不要:サーバーレスAPIなら物理サーバーの管理の手間をかけることなく、新しいAPIやアプリケーションの開発に集中することができます。これにより、開発リソースの効率的な活用が可能になります。 スケーラビリティ:サーバーレスAPIはスケーラブルであり、ユーザーの需要の急増にも問題なく対応することができます。オンデマンドのスケーラビリティにより、トラフィックの増加時でも一貫したユーザーエクスペリエンスを提供します。 レイテンシーの低減:サーバーレスAPIはオリジンサーバーにホストされ、そこからアクセスされます。これにより、レイテンシーが低減し、アプリケーションの全体的なパフォーマンスと応答性が向上します。これは、Stable DiffusionやLarge Language Models(LLM)などの大規模モデルにも有用です。これはSegmindのサーバーレスAPIからも利益を得られます。…

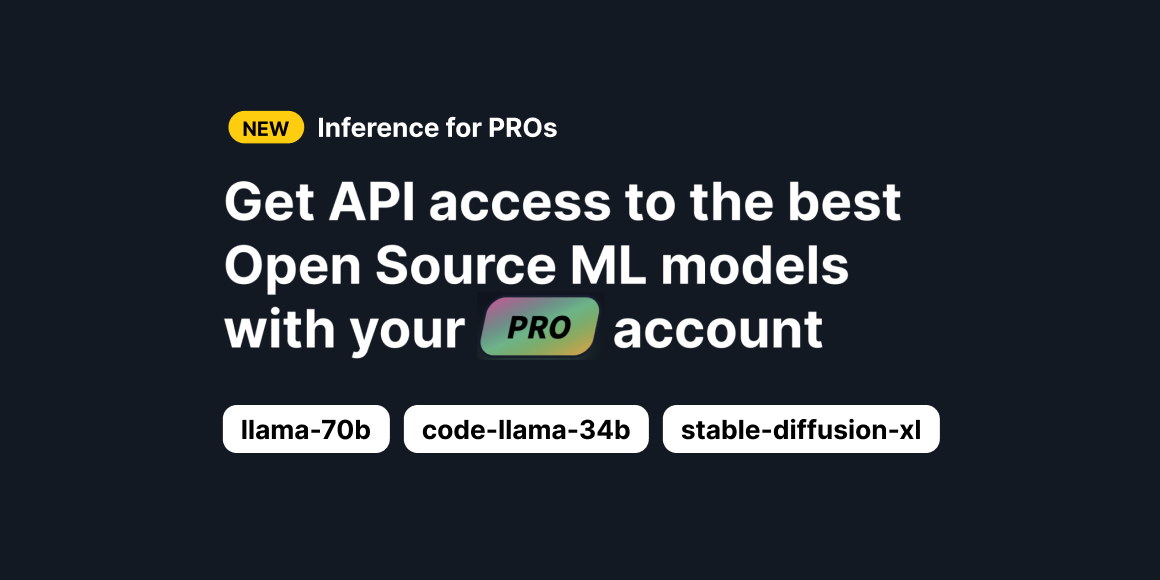

PROsに対する推論

今日は、PROユーザー向けのInferenceを紹介します。これは、最もエキサイティングなモデルのAPIへのアクセス、無料Inference APIの使用に対する改善されたレート制限を提供するコミュニティオファリングです。PROに登録するためには、以下のページをご利用ください。 Hugging Face PROユーザーは、テキスト生成推論による超高速推論の恩恵を受けるパワフルなモデルのカリキュレーションエンドポイントに独占的にアクセスすることができます。これは、すべてのHugging Faceユーザーが利用できる無料の推論APIの上にある特典です。PROユーザーは、これらのモデルに対してより高いレート制限を享受するだけでなく、今日最も優れたモデルへの独占的なアクセスも楽しむことができます。 目次 サポートされているモデル PRO向けInferenceの始め方 アプリケーション Llama 2とCode Llamaでのチャット Code Llamaを使用したコード補完 Stable Diffusion XL 生成パラメータ テキスト生成の制御 画像生成の制御 キャッシング ストリーミング PROに登録する…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.