AIにおける幻覚の克服:事実に基づく強化学習ハイブリッドフレームワークが大規模な多モーダルモデルのビジョン・言語の整合性を最適化する方法

『AIの幻覚を克服する方法:強化学習と事実に基づくハイブリッドフレームワークによる大規模な多モーダルモデルのビジョン・言語整合性の最適化』

追加の事前訓練による画像とテキストのペアリング、または専門的なビジュアルインストラクションチューニングデータセットでの微調整を通じて、大規模言語モデルは多様なモーダルドメインに潜入し、パワフルな大規模マルチモーダルモデルを生み出すことができます。しかし、LMM(Large Multimodal Models)を構築する上で障害があります。特に、多様なデータとテキストのみのデータセットの質と量の間には食い違いがあります。例えば、LMMモデルLLaVAは、事前訓練されたビジュアルエンコーダとインストラクション用に調整された言語モデルを初期化したものです。このモデルは、1800のタスクに対して100M以上の例を使用するテキストのみのモデルと比較して、はるかに少ないインスタンスでトレーニングされます。具体的には、このモデルはわずか150Kの人工的な画像ベースの会話でトレーニングされます。このようなデータ制約のため、ビジュアルと言語のモダリティが正確に整列しない場合があります。

その結果、LMMは、画像が与える文脈と不正確に関連付けられた幻覚的な出力を生成する可能性があります。UC Berkeley、CMU、UIUC、UW-Madison、UMass Amherst Microsoft Research、MIT-IBM Watson AI Labの研究者たちは、LLMMトレーニングのための高品質なビジュアルインストラクションチューニングデータの不在によって引き起こされる問題に対処するために、改良されたマルチモーダル整列のために訓練されたビジョン言語モデルLLaVA-RLHFを提示しています。彼らの主な貢献の1つは、マルチモーダルの整列を強化するために、強化学習からの人間のフィードバックによって報酬信号をキャリブレーションすることです。この手法では、幻覚の認識に焦点を当てた人間の好みを収集し、それらの好みを強化学習に使用します。

この戦略により、比較的安価(例えば、10Kの人間の好みを収集するために$3000)でマルチモーダルの整列が改善される可能性があります。彼らの知識と既存の人間の好みデータに基づいて、報酬モデルが既存の言語モデルを適切に使用できるようにすることを試みる、よりデータ効率の良いオプションが提案されています。

- 『Qwen Large Language Models(LLMs)Seriesについて知っておくべきすべて』

- 「AIガバナンスの12のコア原則」

- ビデオアクション認識を最適化するにはどのようにすればよいのでしょうか?深層学習アプローチにおける空間的および時間的注意モジュールの力を明らかにします

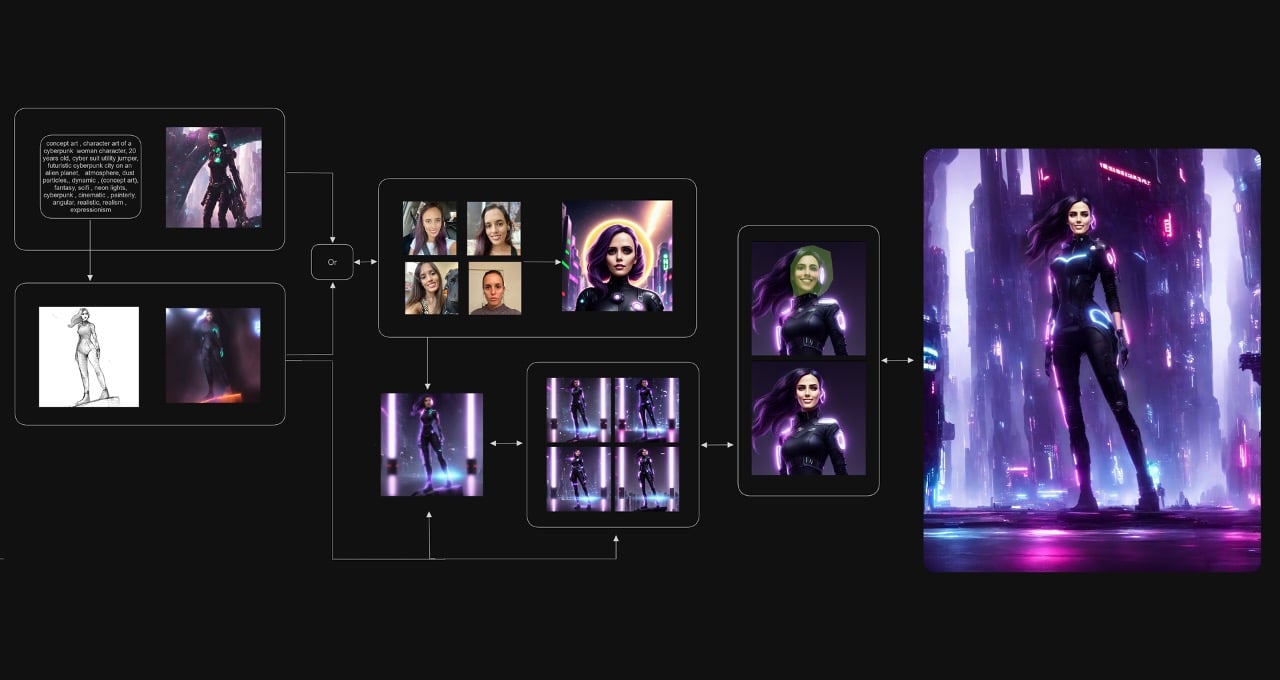

図1:LLMMトレーニングの教示された微調整(SFT)フェーズ中の幻覚の可能性と、報酬モデルの容量が低い問題に対処するために、事実に基づくRLHFがSFTモデルから初期化される方法を示すダイアグラムです。

まず、より高解像度の優れたビジュアルエンコーダと大きな言語モデルを使用して、報酬モデルの全体的な機能を向上させます。第二に、図1に示すように、写真の説明や確定的なマルチチョイスオプションなどの追加情報で報酬信号を補完するファクチュアル・オーグメントドRLHFアルゴリズムを提案します。さらに、Supervised Fine-Tuningステージでは、既存の高品質な人間によるマルチモーダルデータを会話形式に変換して、合成ビジョンインストラクションチューニングデータを拡張することで、LMMの一般的な能力を向上させます。具体的には、Flickr30kをスポットキャプショニングの課題に変換し、VQA-v2とA-OKVQAをマルチラウンドQAタスクに変換し、新しいデータセットを使用してLLaVA-SFT+モデルをトレーニングします。

最後に、実世界の状況でのLMMのマルチモーダルの整列を評価する方法について考えます。特に、幻覚を罰することに注意を払います。彼らが開発したベンチマーク質問であるMMHAL-BENCHは、COCOの12の主要なオブジェクトカテゴリを網羅し、8つのジョブ種別から成ります。彼らの分析によると、このベンチマークデータセットは、特に反幻覚のためのスコアが考慮される場合、人間の評価に非常に近いものです。RLHFでトレーニングされた最初のLMMとして、LLaVA-RLHFは実験的評価で優れたパフォーマンスを発揮しました。LLaVA-Benchでは94%の改善、MMHAL-Benchでは60%の改善、MMBenchでは52.4%の新記録、POPEでは82.7% F1の新記録を達成しました。GitHubでは、コード、モデル、データを一般に提供しています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Reka AIは、視覚センサと聴覚センサを備えたマルチモーダル言語アシスタントであるYasa-1を紹介しますYasa-1は、コードの実行を通じてアクションを起こすことができます

- 「教師なし学習を用いた秋の検出モデルの作成」

- 「私たちはAIとの関係をどのように予測できるのか?」

- 「マルチモーダルAIの最新の進歩:(ChatGPT + DALLE 3)+(Google BARD + 拡張)など、さまざまなものがあります….」

- セールスフォースAIがGlueGenを導入:効率的なエンコーダのアップグレードとマルチモーダル機能により、テキストから画像へのモデルが革新的になります

- コンセプト2ボックスに出会ってください:知識グラフにおける高レベルの概念と細粒度なエンティティとのギャップを埋める – 二重幾何学的アプローチ

- エッジ上でのビジュアル品質検査のためのエンドツーエンドのMLOpsパイプラインの構築-パート1