3B、4B、9B のスケールで 5 つの新しいマルチモーダルモデルを備えた OpenFlamingo チームが、前モデルを上回る OpenFlamingo v2 をリリースしました

OpenFlamingoチームは、3B、4B、9Bのスケールで5つの新しいマルチモーダルモデルを持つOpenFlamingo v2をリリースしました

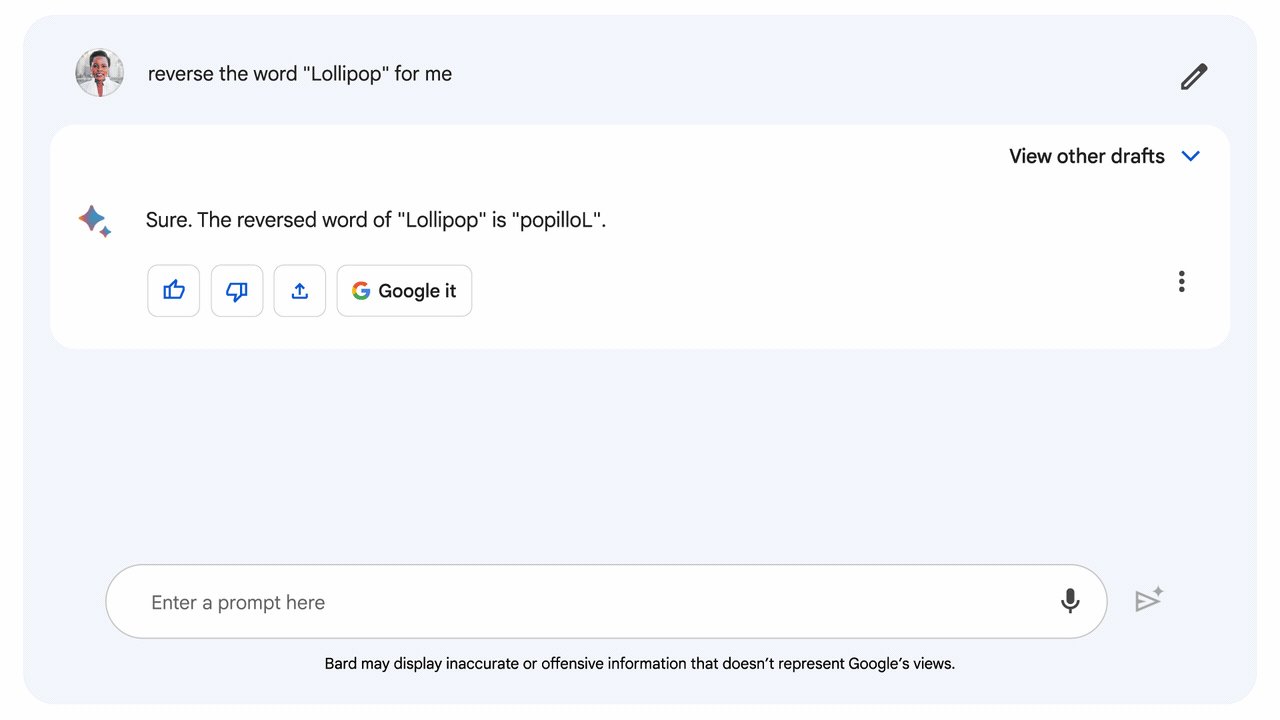

ワシントン大学、スタンフォード大学、AI2、UCSB、Googleの研究者グループは、最近OpenFlamingoプロジェクトを開発しました。このプロジェクトはDeepMindのFlamingoチームと同様のモデルを構築することを目指しています。OpenFlamingoモデルは、任意の混合テキストと画像のシーケンスを処理し、テキストを出力することができます。キャプショニング、ビジュアルクエスチョンアンサリング、画像分類などが、このモデルの能力とコンテキストでのサンプリングを活用することができる活動の一部です。

現在、チームはv2のリリースを発表しました。このリリースには、3B、4B、9Bのレベルでトレーニングされた5つのOpenFlamingoモデルが含まれています。これらのモデルは、LLaMAよりも制約の緩いオープンソースモデルから派生しており、MosaicのMPT-1Bと7B、Together.XYZのRedPajama-3Bなどが含まれています。

研究者たちは、すでにプリトレーニングされた静的言語モデルのレイヤーに視覚的な特徴を追加することで、Flamingoモデリングパラダイムを使用しました。ビジョンエンコーダーと言語モデルは静的なままですが、接続モジュールはFlamingoと同様にWebスクレイピングされた画像テキストのシーケンスを使用してトレーニングされます。

- 大規模な言語モデルにおけるコンテキストに基づく学習アプローチ

- Unityは、Museというテキストからビデオゲームを作成するプラットフォームのリリースを発表しましたこのプラットフォームでは、自然言語でテクスチャ、スプライト、アニメーションを作成することができます

- FastSAMとは、最小限の計算負荷で高性能のセグメンテーションを実現する画期的なリアルタイムソリューションです

チームは、キャプショニング、VQA、および分類モデルをビジョン言語データセットでテストしました。その結果、チームはv1リリースとOpenFlamingo-9B v2モデルの間で大きな進歩を遂げたことがわかりました。

彼らは7つのデータセットと5つの異なるコンテキストからの結果を組み合わせて、モデルの有効性を評価しました。コンテキストのないショット、4つのショット、8つのショット、16のショット、32のショットの評価を行いました。OpenFlamingo (OF)のOF-3BおよびOF-4BレベルのモデルをFlamingo-3BおよびFlamingo-9Bレベルのモデルと比較し、平均してOpenFlamingo (OF)はFlamingoの性能の80%以上を達成していることがわかりました。研究者たちはまた、自身の結果をPapersWithCodeで公開された最適化されたSoTAと比較しました。オンラインデータのみで事前トレーニングされたOpenFlamingo-3BおよびOpenFlamingo-9Bモデルは、32のコンテキストインスタンスで微調整された性能の55%以上を達成しています。OpenFlamingoのモデルは、0ショットではDeepMindの平均10%、32ショットでは15%遅れています。

チームは引き続きトレーニングと最先端のマルチモーダルモデルの提供に取り組んでいます。次に、事前トレーニングに使用するデータの品質を向上させることを目指しています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- もし、口頭および書面によるコミュニケーションが人間の知能を発展させたのであれば… 言語モデルは一体どうなっているのでしょうか?

- Webスケールトレーニング解放:DeepMindがOWLv2とOWL-STを紹介、未知語彙物体検出の革新的ツール、前例のない自己学習技術によって駆動されます

- 製造品の品質におけるコンピュータビジョンの欠陥検出を、Amazon SageMaker Canvasを使用したノーコード機械学習で民主化する

- エンタープライズAIとは何ですか?

- DORSalとは 3Dシーンの生成とオブジェクトレベルの編集のための3D構造拡散モデル

- Hugging FaceとGradioを使用して、5分でAIチャットボットを構築する

- LOMO(LOw-Memory Optimization)をご紹介します:メモリ使用量を削減するために、勾配計算とパラメータの更新を1つのステップで融合する新しいAIオプティマイザです