NVIDIA H100 GPUがMLPerfベンチマークのデビューで生成型AIの標準を設定

NVIDIA H100 GPU sets the standard for generative AI in MLPerf benchmarks debut.

主要のユーザーと業界標準のベンチマークによれば、NVIDIAのH100 Tensor Core GPUは特に生成型AIを駆動する大規模言語モデル(LLMs)において、最高のAIパフォーマンスを提供しています。

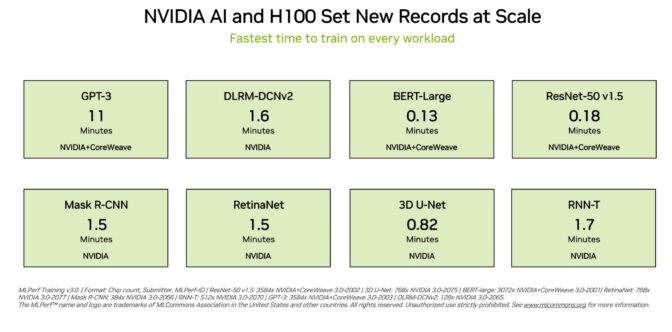

H100 GPUは、最新のMLPerfトレーニングベンチマークのすべての8つのテストで新記録を樹立し、生成型AIの新しいMLPerfテストでも優れた性能を発揮しました。この優れた性能は、単一のアクセラレータあたりの性能だけでなく、大規模サーバーでの性能も提供されています。

たとえば、スタートアップのInflection AIとGPUアクセラレートワークロードに特化したクラウドサービスプロバイダーであるCoreWeaveが共同開発した3,584台のH100 GPUを搭載した商用クラスターでは、GPT-3ベースの大規模トレーニングベンチマークを11分以下で完了しました。

「当社のお客様は、数千のH100 GPUが高速で低レイテンシのInfiniBandネットワーク上で稼働しているため、現在スケールで最先端の生成型AIおよびLLMを構築しています。」と、CoreWeaveの共同設立者でありCTOであるブライアン・ベンチュロ氏は述べています。「NVIDIAとの共同MLPerfサブミッションにより、お客様が享受できる優れたパフォーマンスが明確に示されました。」

本日利用可能な最高のパフォーマンス

Inflection AIは、そのパフォーマンスを活用して、パーソナルAI「Pi」の先進的なLLMを構築しました。同社はAIスタジオとして、ユーザーが簡単で自然な方法で対話できるパーソナルAIを作成します。

「当社の最先端の大規模言語モデルは、CoreWeaveの強力なH100 GPUネットワークでトレーニングされたものであり、誰でも今日からパーソナルAIの力を体験できます。」と、Inflection AIのCEOであるムスタファ・スレイマン氏は述べています。

2022年初頭にMustafaとDeepMindのKarén Simonyan、Reid Hoffmanが共同設立したInflection AIは、NVIDIA GPUを使用して世界で最大のコンピューティングクラスターの1つを構築するためにCoreWeaveと協力することを目指しています。

トップパフォーマンスが利用可能に

これらのユーザー体験は、今日発表されたMLPerfベンチマークで示されたパフォーマンスを反映しています。

H100 GPUは、大規模言語モデル、推薦システム、コンピュータビジョン、医療画像処理、音声認識を含むすべてのベンチマークで最高のパフォーマンスを発揮しました。NVIDIA AIプラットフォームの多様性を示すことができる唯一のチップでした。

スケールでの優れたパフォーマンス

トレーニングは通常、多数のGPUが協調して実行するジョブです。すべてのMLPerfテストで、H100 GPUはAIトレーニングのための新しいスケールにおける性能記録を樹立しました。

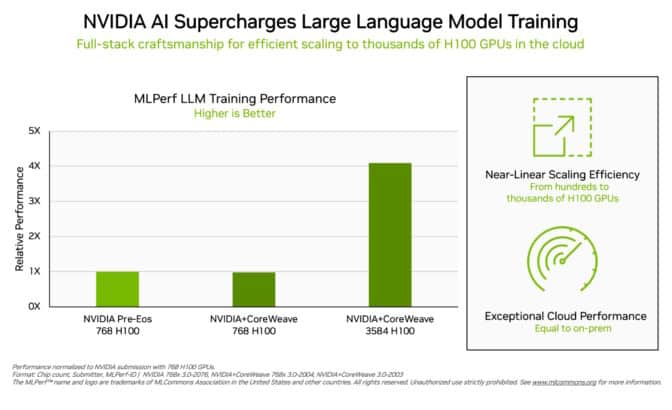

テクノロジースタック全体での最適化により、提出が数百から数千のH100 GPUにスケールアップするにつれて、要求の厳しいLLMテストでほぼ線形の性能スケーリングが可能になりました。

さらに、CoreWeaveは、NVIDIA Quantum-2 InfiniBandネットワークを使用して、ローカルデータセンターで実行されたAIスーパーコンピューターからNVIDIAが達成したのと同様の性能をクラウドから提供しました。これは、CoreWeaveが使用する低レイテンシのネットワークの証明です。

今回、MLPerfは推薦システムのベンチマークを更新しました。

新しいテストでは、より大きなデータセットとより現代的なAIモデルを使用し、クラウドサービスプロバイダーが直面する課題をよりよく反映しています。NVIDIAは強化されたベンチマークで唯一の企業でした。

拡大するNVIDIA AIエコシステム

今回、NVIDIAプラットフォームでの結果を提出した企業は約11社あり、機械学習における業界で最も広範なエコシステムに支えられていることを示しています。

提出は、ASUS、Dell Technologies、GIGABYTE、Lenovo、QCTを含む主要なシステムメーカーから行われました。H100 GPUで実行された提出は30件以上に上ります。

このような参加度の高さにより、ユーザーは、クラウド内および自社データセンターで実行されるサーバーでもNVIDIA AIで優れたパフォーマンスを得ることができると知ることができます。

すべてのワークロードでのパフォーマンス

NVIDIAエコシステムのパートナーは、AIプラットフォームやベンダーを評価するために価値のあるツールであると認識しているため、MLPerfに参加しています。

ベンチマークは、コンピュータビジョン、翻訳、強化学習、生成型AI、および推薦システムを含む、ユーザーが関心を持つワークロードをカバーしています。

テストは透明性があり、客観的であるため、ユーザーはMLPerfの結果を信頼して購入の決定を行うことができます。これらのベンチマークは、Arm、Baidu、Facebook AI、Google、Harvard、Intel、Microsoft、Stanford、トロント大学などの幅広いグループからの支援を受けています。

MLPerfの結果は、AIトレーニング、推論、HPCのベンチマークにおいて、H100、L4、NVIDIA Jetsonプラットフォーム上で利用可能です。今後はNVIDIA Grace HopperシステムでもMLPerfに提出する予定です。

エネルギー効率の重要性

AIの性能要件が高まるにつれ、その性能を達成する方法の効率を拡大することが重要です。それが、加速されたコンピューティングが行うことです。

NVIDIA GPUを使用したデータセンターは、より少ないサーバーノードを使用するため、ラックスペースとエネルギーをより少なく使用します。加速されたネットワーキングも効率と性能を向上させ、継続的なソフトウェアの最適化により、同じハードウェア上でXファクターの利得が得られます。

エネルギー効率の高いパフォーマンスは、地球とビジネスにとって良いことです。パフォーマンスの向上により、市場投入までの時間を短縮し、より高度なアプリケーションを構築できるようになります。

また、データセンターにNVIDIA GPUを加速することで、コストが削減されます。実際、NVIDIAは最新のGreen500リストで上位30のスーパーコンピューターのうち22を駆動しています。

誰にでも利用可能なソフトウェア

NVIDIA AI Enterprise、NVIDIA AIプラットフォームのソフトウェアレイヤーは、主要な加速されたコンピューティングインフラストラクチャーで最適化されたパフォーマンスを実現します。このソフトウェアには、企業データセンターでAIを実行するために必要なエンタープライズグレードのサポート、セキュリティ、信頼性が付属しています。

これらのテストで使用されるすべてのソフトウェアは、MLPerfリポジトリから利用可能であり、ほぼ誰でもこれらの世界クラスの結果を得ることができます。

最適化は、NGC、NVIDIAのGPUで加速されたソフトウェアのカタログで利用可能なコンテナに継続的に折り込まれています。

NVIDIAのMLPerfパフォーマンスと効率に燃料を供給する最適化については、この技術ブログを読んでください。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles