NLPの探求- NLPのキックスタート(ステップ#4)

NLPの探求- NLPのキックスタート(ステップ#4)

私の「NLPの探求」シリーズが初めての方は、こちらの紹介記事をご覧ください。

NLPの探求と習得 – 深淵への旅

こんにちは、私はディープティ・スダルサンと申します。私は人工知能の学士課程3年生です。既に私は…

VoAGI.com

おかえりなさい!今回のシリーズでは、(主に)POSタギングについての私のノートを共有します。特に、この学期私にこのコースを提供してくださったアムリタ・コインバトール校のCENのサチン・クマールS先生に感謝申し上げます。ここに集められた情報や画像の一部は、彼が提供または作成したリソースや教材から得られたものです。

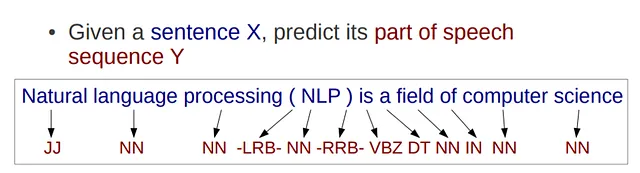

POS(品詞)タギング:

これは構文解析の最も基本的なレベルです。単語に品詞タグを割り当てる作業です。

- Mentatと出会ってください:コマンドラインからのあらゆるコーディングタスクを支援するAIツールで、複数のファイルでの編集を調整することができます

- アンサンブル学習:決定木からランダムフォレストへ

- 「GETMusicに会ってください:統一された表現と拡散フレームワークで、統一された表現と拡散フレームワークを使用して任意の音楽トラックを生成できます」

このようなシーケンスラベリングは、ゲノム解析で遺伝子配列にラベルを付ける際にも見られます。

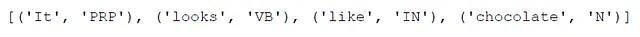

例えば、文「It looks like chocolate」という文に対して、POSタグは次のようになります:

PRPは人称代名詞、VBは動詞、INは前置詞または従属接続詞、Nは名詞を表します。

開放クラスと閉じたクラス:

開放クラスは新しい単語が頻繁に追加されるクラスです。例えば、名詞、動詞などです。一方、閉じたクラスは、そのクラスに属する予め定義された単語のセットを持っています。例えば、冠詞などです。

POSタギングでは、単語には複数のPOSタグが割り当てられるという曖昧さの問題があります。例えば、「like」はINタグとVBタグの両方が割り当てられる可能性があります。

タグの種類には、粗い粒度と細かい粒度の2つのタイプがあります。

- 粗い粒度のタグの例:名詞、動詞、形容詞など

2. 細かい粒度のタグの例:特定の名詞、過去形の動詞、単純な形容詞など

POSタグの見つけ方:

- ポイント予測 – クラシファイアを使用して各トークンのタグを個別に予測する

- 生成型シーケンスモデル – 隠れマルコフモデル(HMM)を使用する

- 識別型シーケンスモデル – 条件付きランダムフィールド(CRF)、構造化予測など

POSタギングのためのHMM:

観測可能な状態 – 与えられた単語のシーケンス/文に含まれる単語

隠れ/観測できない状態 – POSタグ

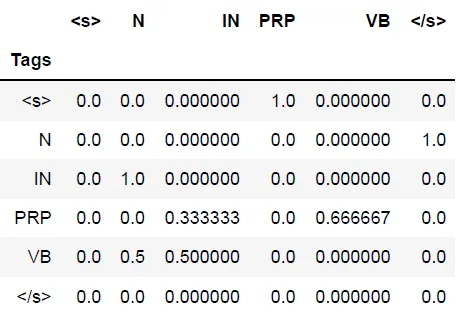

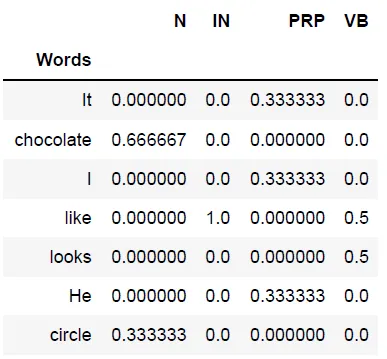

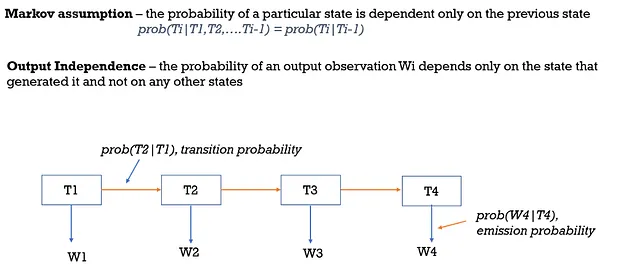

HMMでは、特定のタグのシーケンスに関連付けられた確率を計算するために、遷移確率と発射確率が使用されます。

- 遷移は、1つの隠れ状態から別の隠れ状態への移行を意味し、遷移確率として知られる確率が関連付けられます。

- 発射は、隠れ状態からトークンを生成することを意味します。特定の隠れ状態には、トークンを生成するための確率が関連付けられます。

HMMでの仮定:

ブルートフォース:

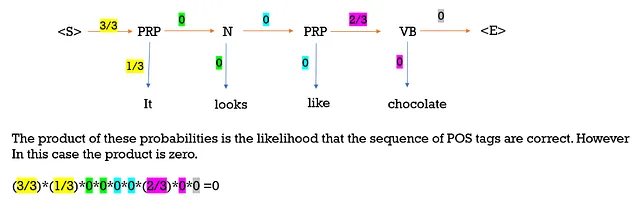

ランダムなPOSタグで文をタグ付けしましょう。例えば、「It/PRP looks/N like/PRP chocolate/VB」とします。次に、シーケンスの確率を計算しましょう。

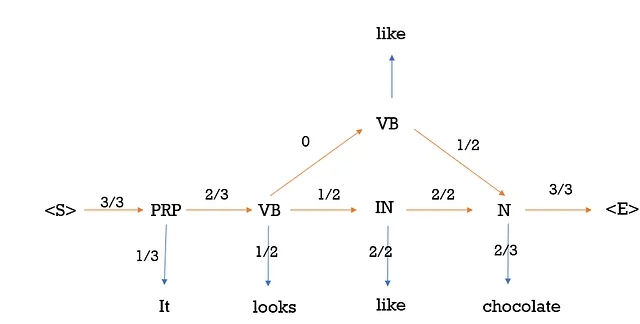

正しいPOSタグで文をタグ付けしましょう。例えば、「It/PRP looks/VB like/IN chocolate/N」とします。次に、シーケンスの確率を計算しましょう。

Viterbiアルゴリズム:

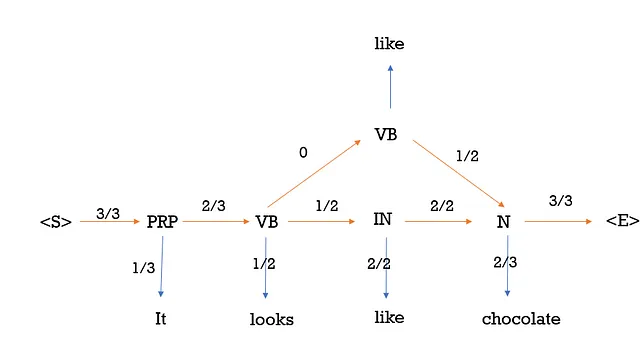

Viterbiアルゴリズムは、最も確率の高いタグまたは隠れた状態のシーケンスを見つけるための動的計画法の一種です。これは、HMMを最も確率の高い隠れた状態を見つけるために最適化する方法です。

与えられた文「It looks like Chocolate」では、トークン「like」にはVBとINの2つのPOSタグがあります。最も確率の低いパスが削除され、逆方向のパスがパスまたはシーケンスを与えます。

この例では、シーケンス<S> PRP VB VB N <E>の確率は0になります。

参考文献:

- https://universaldependencies.org/docsv1/en/pos/all.html#al-en-pos/ADJ

- https://universaldependencies.org/u/pos/

- https://youtu.be/IqXdjdOgXPM

- https://www.freecodecamp.org/news/an-introduction-to-part-of-speech-tagging-and-the-hidden-markov-model-953d45338f24/

- https://www.mygreatlearning.com/blog/pos-tagging/

- Speech and Language, Jurafsky

このシリーズの以前のパート:

パート1:https://medium.com/@deepthi.sudharsan/exploring-nlp-kickstarting-nlp-step-1-e4ad0029694f

パート2:https://medium.com/@deepthi.sudharsan/exploring-nlp-kickstarting-nlp-step-2-157a6c0b308b

パート3:https://medium.com/@deepthi.sudharsan/exploring-nlp-kickstarting-nlp-step-3-e6ea6963679d

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles