新しいツールと機能の発表:責任あるAIイノベーションを可能にする

責任あるAIイノベーションを促進する、新たなツールと機能の発表

生成AIの急速な成長は、有望な新しいイノベーションをもたらすと同時に、新たな課題を提起しています。これらの課題には、バイアスや説明可能性など、生成AI以前から存在していたものも含まれますが、ファウンデーションモデル(FM)に特有の新しい課題もあります。これらの課題には、幻覚や毒性といったものが含まれます。AWSでは、教育、科学、およびお客様を優先し、人々に焦点を当てたアプローチを取りながら、責任ある生成AIの開発に取り組んでいます。これには、エンドツーエンドのAIライフサイクル全体にわたって責任あるAIを統合することが含まれます。

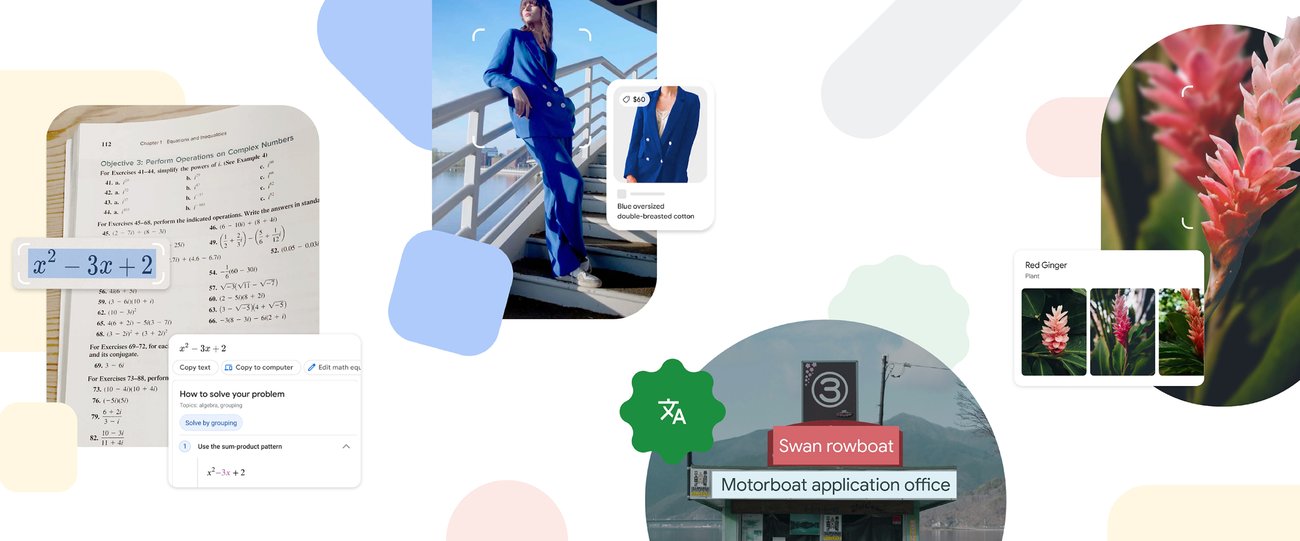

過去1年間で、私たちは生成AIアプリケーションやモデルの新しい機能を導入してきました。例えば、Amazon CodeWhispererにおける組み込みのセキュリティスキャニング、Amazon Titanにおける有害なコンテンツの検出とブロックのためのトレーニング、Amazon Bedrockにおけるデータプライバシー保護などです。私たちの安全で透明性の高い責任ある生成AIへの投資には、グローバルコミュニティや政策立案者との連携も含まれています。私たちは、米国政府の「ホワイトハウス ボランタリー AI プロジェクト」や英国の「AI安全サミット」を支持し、共同で取り組んでいます。また、Amazon SageMaker ClarifyやAmazon SageMakerによるMLガバナンスなど、目的に合わせたツールを提供するために、お客様と協力しています。

新たな責任あるAIイノベーションの紹介

生成AIが新たな産業、組織、およびユースケースにスケーリングするにつれて、持続的なFM開発への投資が求められます。お客様は、彼らのFMが安全性、公正性、セキュリティを考慮して構築されることを望んでおり、それによって責任あるAIを展開することができます。今年のAWS re:Inventでは、新たな機能を発表し、ビルトインツール、顧客保護、透明性向上のためのリソース、ディスインフォメーションとの戦いに役立つツールなど、幅広い機能における責任ある生成AIイノベーションを促進することに興奮しています。お客様がFMを毒性や堅牢性などの責任あるAIの重要な要件に対して評価できる情報を提供し、顧客のユースケースと責任あるAIポリシーに基づいてセーフガードを適用するためのガードレールを導入します。同時に、お客様は自身の組織内でそれらを使用する際に、AIサービスやFMの安全性、公正性、セキュリティなどの特性についてより良く理解したいと考えています。私たちは、AWSのAIサービスに関する情報を提供し、お客様の要望に応えるための透明性を提供するためのさらなるリソースを発表することを楽しみにしています。

- AWS ジェネラティブ AI イノベーションセンターのアンソロポジック・クロード向けのカスタムモデルプログラムをご紹介します

- GPUマシンの構築 vs GPUクラウドの利用

- 「OpenAIモデルに対するオープンソースの代替手段の探索」

セーフガードの実装:Amazon Bedrockのガードレール

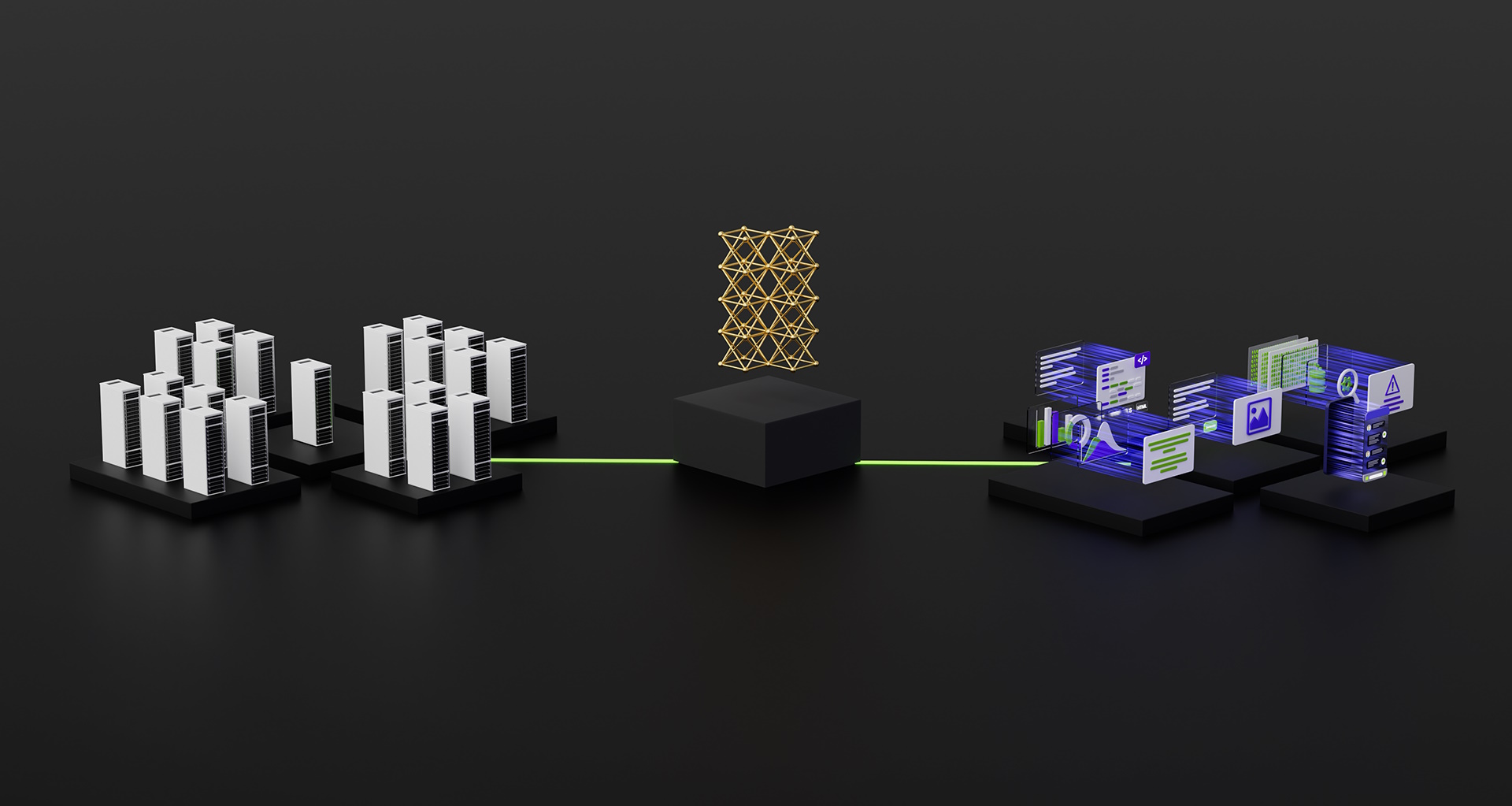

スケールで生成AIを導入する際には、安全性が最優先です。組織は、有害な言語や不適切な行為を回避し、企業のポリシーと一致するような、お客様と生成AIアプリケーションとの安全なインタラクションを促進したいと考えています。それを実現するためには、組織全体で一貫したセーフガードを設けることが最も簡単です。私たちは昨日、Amazon Bedrockのガードレールのプレビューを発表しました。これは、顧客のユースケースと責任あるAIポリシーに基づいて、アプリケーション固有のセーフガードを簡単に実装できる新機能です。

ガードレールは、Amazon Bedrock上のFMsが応用プログラム内の望ましくないコンテンツにどのように対応するかを一貫性を持って補完します。お客様は、Amazon Bedrock上の大規模な言語モデルだけでなく、微調整モデルやAmazon Bedrock用のエージェントとの組み合わせでもガードレールを適用することができます。ガードレールでは、回避すべきトピックを指定し、制限されたカテゴリに該当するクエリと応答を自動的に検出し防止します。お客様は、ヘイトスピーチ、侮辱、性的言語、暴力などのカテゴリを横断してコンテンツフィルタの閾値を設定して、有害コンテンツを希望するレベルで除外することもできます。たとえば、オンラインバンキングのアプリケーションは、投資アドバイスを提供しないように設定し、不適切なコンテンツ(ヘイトスピーチ、侮辱、暴力など)を制限するように設定することができます。将来的には、お客様はユーザー入力とFMsの応答中の個人を特定できる情報(PII)を伏せること、卑猥な言葉フィルタを設定すること、ユーザーとFMs間のやり取りでブロックするカスタムワードのリストを提供することができるようになり、コンプライアンスの向上と更なるユーザー保護が可能になります。ガードレールを使用することで、企業のポリシーに合致した保護とセーフガードを維持しながら、ジェネラティブAIによるイノベーションをより迅速に行うことができます。

特定のユースケースに最適なFMの特定:Amazon Bedrockでのモデル評価

現在、組織はジェネラティブAIアプリケーションをパワーするためのさまざまなFMオプションを持っています。組織は、重要な責任あるAIおよび品質メトリックに基づいて、正確性とパフォーマンスの適切なバランスを見つけるために、効率的にモデルを比較し、最適なオプションを見つける必要があります。モデルを評価するために、組織はまずベンチマークを識別し、評価ツールを設定し、評価を実行するために数日間を費やさなければなりません。さらに、これらのテストは、煩雑で時間のかかる人間レビューワークフローを通じて判断される(ブランドの声、関連性、スタイルなど)主観的な基準を評価するのには役立ちません。これらの評価には時間・専門知識・リソースが必要であり、新しいユースケースごとに評価を行うことは、顧客に対して最も正確で安全な体験を提供するモデルを評価するのに困難を伴います。

プレビュー版でご利用いただけるAmazon Bedrock上のモデル評価では、お客様はカスタムメトリック(正確性や安全性など)に基づいて、自動評価または人間による評価を使用して、特定のユースケースに最適なFMを評価、比較、選択することができます。Amazon Bedrockコンソールでは、お客様は質問応答やコンテンツ要約などの特定のタスクのために比較したいFMを選択します。自動評価では、お客様は予め定義された評価基準(正確性、頑健性、有害性など)を選択し、独自のテストデータセットをアップロードするか、組み込みの公開データセットから選択します。主観的な基準や細かい内容を判断する必要がある場合、お客様はわずか数回のクリックで人間による評価ワークフローを簡単に設定することができます。これらのワークフローでは、お客様の社内チームを活用するか、AWSが提供する管理労働力を使用して、モデルの応答を評価します。人間による評価では、お客様はユースケースに特化したメトリック(関連性、スタイル、ブランドの声など)を定義します。お客様がセットアッププロセスを完了すると、Amazon Bedrockは評価を実行し、レポートを生成します。これにより、お客様はキーの安全性と正確性の基準に沿ってモデルのパフォーマンスを簡単に理解し、ユースケースに最適なモデルを選択することができます。

これらのモデルの評価能力はAmazon Bedrockに限定されるものではありません。お客様は、Amazon SageMaker Clarifyでもモデルの評価を容易に行い、正確性、頑健性、有害性などの主要な品質と責任に関連するメトリックを基に、最適なFMオプションを選択することができます。

ディスインフォメーションの対処:Amazon Titanの透かし

本日、プレビュー版のAmazon Titan Image Generatorが発表されました。これにより、お客様は迅速にスケールを拡大した高品質な画像を生成・強化することができます。私たちは、モデル開発プロセスの各段階で責任あるAIを考慮しました。トレーニングデータの選択、不適切なユーザー入力やモデル出力の検出と削除機能の構築、モデル出力の人種的多様性の向上など、すべてにおいて責任あるAIを考慮しました。すべてのAmazon Titan生成画像にはデフォルトで目に見えない透かし(ウォーターマーク)が含まれており、AIが生成した画像を識別するための控えめなメカニズムとしてデザインされています。AWSは、画像出力に組み込まれた改ざんに対して耐性のあるビルトインの透かしを広くリリースする最初のモデルプロバイダの一つです。

信頼構築:インデムニティによるモデルとアプリケーションのバックアップ

お客様への信頼構築は、AWSの中心的な価値です。創業以来、私たちはお客様との共同の旅をしてきました。そして、生成AIの成長と共に、革新的なテクノロジーの構築に取り組むことをお約束します。お客様が私たちの生成AIの力を活用するためには、彼らが保護されていることを知る必要があります。AWSは、以下のAmazon生成AIサービスの成果物向けに著作権免責保証のカバレッジを提供しています:Amazon Titan Text Express、Amazon Titan Text Lite、Amazon Titan Embeddings、Amazon Titan Multimodal Embeddings、Amazon CodeWhisperer Professional、AWS HealthScribe、Amazon Lex、およびAmazon Personalize。これは、モデルを責任を持って使用するお客様が、これらのサービスによって生成された成果物に対する第三者主張による著作権侵害の訴えから保護されることを意味します(サービス利用規約のセクション50.10を参照)。さらに、サービスの利用に関する標準の知的財産免責保証により、サービスとそれらを訓練に使用したデータに対する第三者の知的財産侵害の主張からお客様を保護します。言い換えれば、上記のAmazon生成AIサービスを使用して、知的財産権の侵害で誰かがあなたを訴えた場合、AWSはその訴訟を弁護し、あなたに対する判決または和解費用をカバーします。

私たちは自身の生成AIサービスを支持し、引き続き改善に取り組んでいます。AWSが新しいサービスを発表し、生成AIが進化し続けるにつれて、AWSはお客様の信頼を獲得し続けることに真摯に取り組んでいます。

透明性の向上:Amazon Titan Text用AWS AIサービスカード

私たちは2022年のre:InventでAWS AIサービスカードを導入しました。これは、お客様が当社のAWS AIサービスをよりよく理解するための透明性のあるリソースです。AIサービスカードは、自社のAIサービスの利用目的と制限、責任あるAIの設計選択、展開とパフォーマンス最適化のベストプラクティスに関する情報を一元化して提供するものです。これらは公平性、説明可能性、真実性と堅牢性、ガバナンス、透明性、プライバシーとセキュリティ、安全性、コントロール性などに対応する責任ある開発プロセスの一環です。

今年のre:Inventでは、基礎モデルの透明性を高めるための Amazon Titan Text用の新しいAIサービスカードを発表しています。また、Amazon Comprehend Detect PII、Amazon Transcribe Toxicity Detection、Amazon Rekognition Face Liveness、およびAWS HealthScribeの4つの新しいAIサービスカードを発表します。これらのカードは、AWSのウェブサイトでご覧いただけます。生成AIの成長と進化に伴い、技術の開発、テスト、使用方法に関する透明性は組織とお客様の信頼を得るために重要な要素となります。AWSは、AIサービスカードのような透明性リソースを広範なコミュニティに提供し続けること、そして進むべき最善の方法についてのフィードバックを反映し、集め続けることに取り組んでいます。

責任あるAIへの投資:生成AIライフサイクル全体にわたる取り組み

今週のre:Inventで発表された新しいイノベーションに興奮しています。これにより、顧客はより安全にジェネレーティブAIを構築し利用するためのさらなるツール、リソース、および組み込みの保護機能を提供されます。モデル評価からガードレールまで、顧客はリスクを軽減しながら、より迅速にジェネレーティブAIを組織に導入することができるようになりました。IP保護やAIサービスカードなどの新しい顧客向け保護策や透明性向上のための新たなリソースなども、私たちの技術企業、政策立案者、コミュニティグループ、科学者など幅広い関係者との信頼構築への取り組みの重要な例です。私たちは、お客様が安全かつ安心してAIをスケール拡大できるように、責任あるAIへの重要な投資を継続して行っています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「Bingチャットは、最新のリアルタイムな知識を提供する点でChatGPTを上回るのか? 検索補完強化ジェネレーション(RAG)によるご紹介」

- インフレクション-2はGoogleのPaLM-2を超える:AI言語モデルのブレークスルー

- 「AIシステムのリスク評価方法を学びましょう」

- 「このAI論文は、超人的な数学システムの追求において、認知科学と機械学習の融合を探る」という記事です

- 「NVIDIAは、最大級のAmazon Titan Foundationモデルのトレーニングを支援しています」

- NVIDIAのGPUはAWS上でOmniverse Isaac Simにおいて2倍のシミュレーションの進化を提供し、スマートなロボットの加速を実現します

- 「NVIDIA BioNeMoがAWS上での薬剤探索のための生成型AIを可能にする」