チャートの推論に基づくモデルの基盤

Model foundation based on chart inference.

グーグルリサーチのリサーチソフトウェアエンジニア、ジュリアン・アイゼンシュロスによる投稿

ビジュアル言語は、情報を伝えるためにテキスト以外の絵文字を使用するコミュニケーション形式です。アイコノグラフィ、情報グラフィック、表、プロット、チャートなどの形でデジタルライフで普及しており、道路標識、コミックブック、食品ラベルなどの現実世界にも広がっています。このようなメディアをコンピュータがより理解できるようにすることは、科学的コミュニケーションと発見、アクセシビリティ、データの透過性に役立ちます。

ImageNetの登場以来、学習ベースのソリューションを使用してコンピュータビジョンモデルは大きな進歩を遂げてきましたが、焦点は自然画像にあり、分類、ビジュアルクエスチョンアンサリング(VQA)、キャプション、検出、セグメンテーションなどのさまざまなタスクが定義され、研究され、いくつかの場合には人間の性能に達成されています。しかし、ビジュアル言語は同じレベルの注目を集めていません。これは、この分野における大規模なトレーニングセットの不足のためかもしれません。しかし、PlotQA、InfographicsVQA、ChartQAなどの視覚言語イメージにおける質問応答システムの評価を目的とした新しい学術データセットが、ここ数年で作成されています。

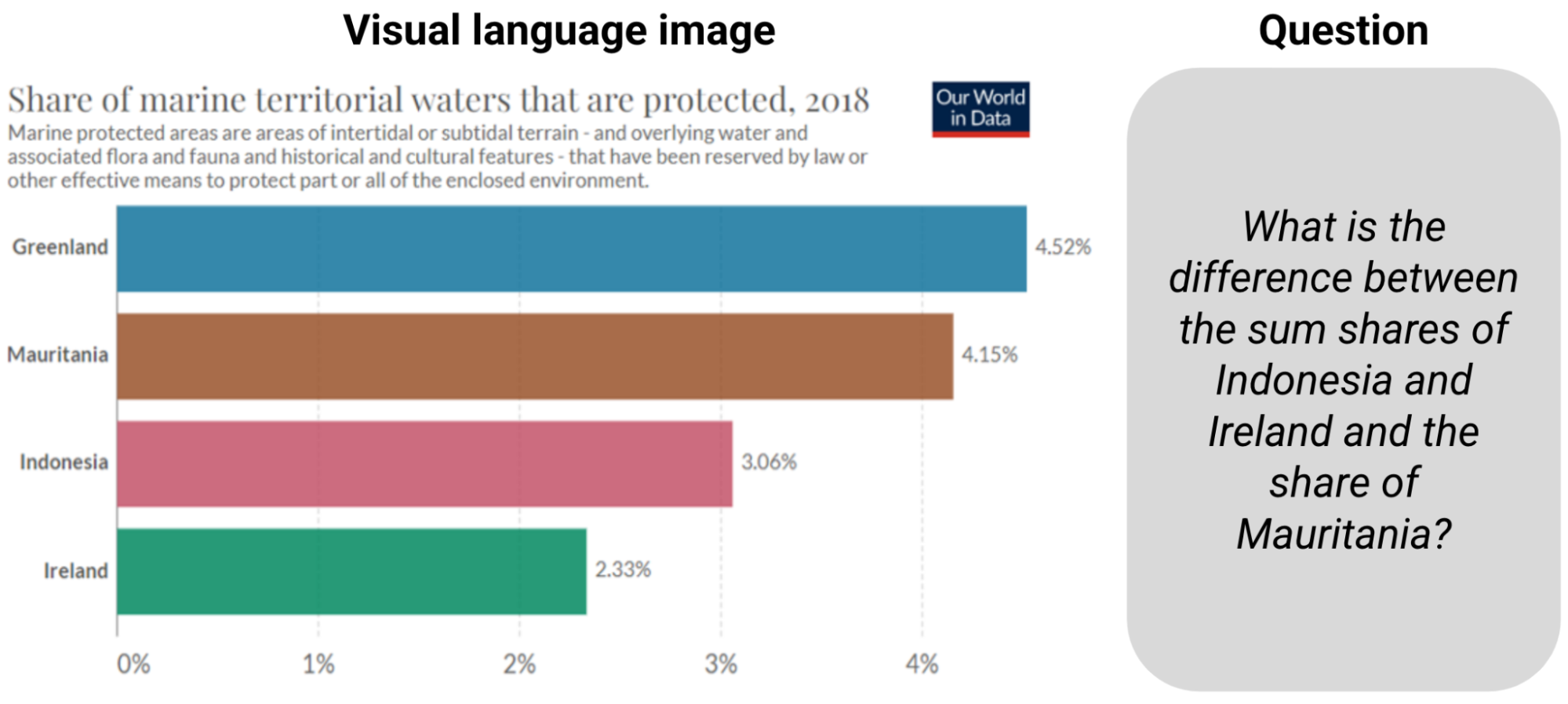

|

| ChartQAからの例。質問に答えるには、情報を読み取り、合計と差を計算する必要があります。 |

これらのタスクに対して構築された既存のモデルは、光学的文字認識(OCR)情報とその座標を大規模なパイプラインに統合することに頼っていましたが、プロセスはエラーが発生しやすく、遅く、一般化が悪いです。既存の畳み込みニューラルネットワーク(CNN)またはトランスフォーマーに基づくエンドツーエンドのコンピュータビジョンモデルは、自然画像で事前にトレーニングされたモデルを簡単にビジュアル言語に適応させることができなかったため、これらの方法が広く使用されていました。しかし、既存のモデルは、棒グラフの相対高さや円グラフのスライスの角度を読み取り、軸のスケールを理解し、色、サイズ、テクスチャでピクトグラムを伝説値に正しくマッピングし、抽出された数字で数値演算を実行するなど、チャートの質問に対する課題には準備ができていません。

- 検索増強視覚言語事前学習

- AVFormer:凍結した音声モデルにビジョンを注入して、ゼロショットAV-ASRを実現する

- ビジュアルキャプション:大規模言語モデルを使用して、動的なビジュアルを備えたビデオ会議を補完する

これらの課題に対応するために、「MatCha:数学推論とチャートディレンダリングを活用したビジュアル言語の事前トレーニングの強化」という提案を行います。 MatChaは数学とチャートを表す言葉であり、2つの補完的なタスクでトレーニングされたピクセルからテキストへの基礎モデル(複数のアプリケーションでファインチューニングできる組み込み帰納バイアスを備えた事前トレーニングモデル)です。1つはチャートディレンダリングであり、プロットまたはチャートが与えられた場合、画像からテキストモデルはその基礎となるデータテーブルまたはレンダリングに使用されるコードを生成する必要があります。数学推論の事前トレーニングでは、テキストベースの数値推論データセットを選択し、入力を画像にレンダリングし、画像からテキストモデルが回答をデコードする必要があります。また、「DePlot:プロットからテーブルへの翻訳によるワンショットビジュアル言語推論」という、テーブルへの翻訳を介したチャートのワンショット推論にMatChaの上に構築されたモデルを提案します。これらの方法により、ChartQAの以前の最高記録を20%以上超え、パラメータが1000倍多い最高の要約システムに達成します。両方の論文はACL2023で発表されます。

チャートディレンダリング

プロットやチャートは、基礎となるデータテーブルとコードによって通常生成されます。コードは、図の全体的なレイアウト(タイプ、方向、色/形状スキームなど)を定義し、基礎となるデータテーブルは実際の数字とそのグループ化を確立します。データとコードの両方がコンパイラ/レンダリングエンジンに送信され、最終的な画像が作成されます。チャートを理解するには、イメージ内の視覚パターンを発見し、効果的に解析してグループ化し、主要な情報を抽出する必要があります。プロットレンダリングプロセスを逆転するには、すべてのこのような機能が必要であり、したがって理想的な事前トレーニングタスクとして機能することができます。

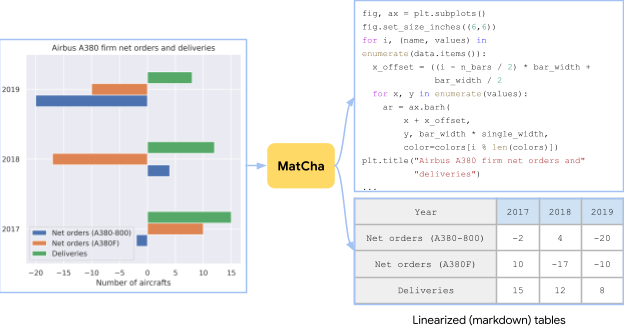

|

| ランダムなプロットオプションを使用して、Airbus A380 Wikipediaページの表から作成されたチャートです。MatChaの事前トレーニングタスクは、イメージからソーステーブルまたはソースコードを回復することです。 |

チャート、その基礎となるデータテーブル、およびそのレンダリングコードを同時に取得することは、実践的には困難です。事前トレーニングデータを十分に収集するために、[chart、code]および[chart、table]のペアを独立して蓄積します。[chart、code]の場合、適切なライセンスを持つすべてのGitHub IPythonノートブックをクロールし、図を含むブロックを抽出します。図とそれに直前にあるコードブロックは、[chart、code]ペアとして保存されます。[chart、table]のペアについては、2つのソースを調査しました。最初のソースは、合成データで、TaPasコードベースからWebクロールされたWikipediaテーブルを手動でコードに変換します。列のタイプに応じて、いくつかのプロットオプションをサンプリングして組み合わせます。さらに、事前トレーニングコーパスを多様化するために、PlotQAで生成された[chart、table]ペアも追加します。2番目のソースはWebクロールされた[chart、table]ペアです。Statista、Pew、Our World in Data、OECDの4つのWebサイトから合計約20,000ペアを含むChartQAトレーニングセットでクロールされた[chart、table]ペアを直接使用します。

数学的推論

MatChaに数値推論知識を組み込むために、テキスト数学データセットから数学的推論スキルを学習します。事前トレーニングには、MATHとDROPの2つの既存のテキスト数学推論データセットを使用します。MATHは合成的に作成され、各モジュール(タイプ)の質問ごとに200万のトレーニング例を含んでいます。DROPは読解型のQAデータセットで、入力はパラグラフのコンテキストと質問です。

DROPでの質問を解決するには、モデルがパラグラフを読み、関連する数字を抽出し、数値計算を実行する必要があります。私たちは、両方のデータセットが補完的であることを発見しました。MATHには、異なるカテゴリーにわたる多数の質問が含まれており、モデルに明示的に注入する必要がある数学的操作を特定するのに役立ちます。DROPの読解形式は、モデルが情報抽出と推論を同時に実行する典型的なQA形式に似ています。実際には、両方のデータセットの入力を画像にレンダリングします。モデルは答えをデコードするように訓練されます。

|

| MATHとDROPからの例をMatChaの事前トレーニング目的に取り込むことにより、MatChaの数学的推論スキルを向上させます。入力テキストを画像としてレンダリングします。 |

エンドツーエンドの結果

Webサイト理解に特化した画像からテキストへの変換トランスフォーマーであるPix2Structモデルバックボーンを使用し、上記の2つのタスクで事前トレーニングを行います。MatChaの強みを示すために、表の基礎にアクセスできない質問応答や要約のためのチャートやプロットを含むいくつかの視覚言語タスクで微調整します。MatChaは、以前のモデルの性能を大幅に上回り、基礎となるテーブルにアクセスできると仮定する以前の最先端も上回ります。

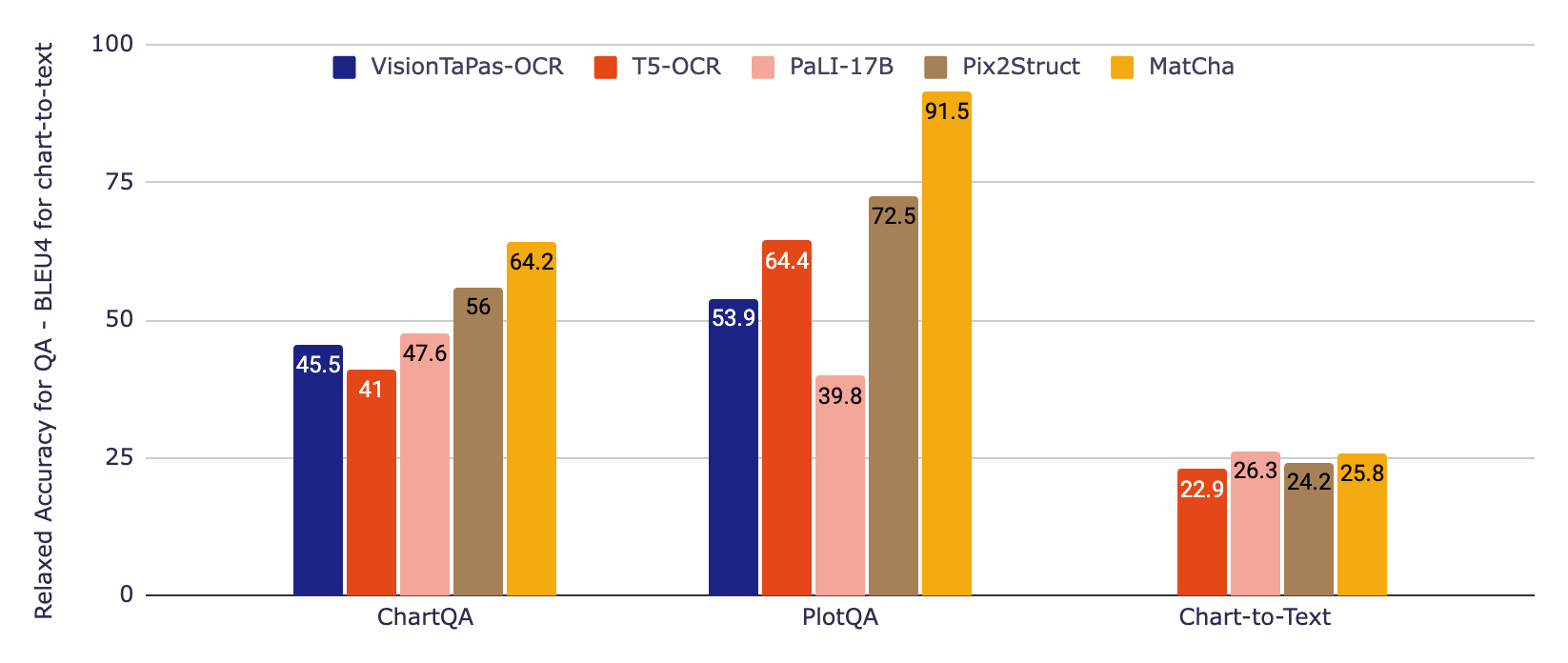

以下の図では、チャートと作業するための標準的なアプローチであったOCRパイプラインから情報を取り込んだ2つのベースラインモデルを最初に評価します。最初のものはT5に基づき、2番目のものはVisionTaPasに基づきます。また、PaLI-17BとPix2Structのモデル結果を報告します。PaLI-17Bは、多様なタスクでトレーニングされた大型(他のモデルの約1000倍)のイメージプラステキスト・トゥ・テキスト・トランスフォーマーですが、テキストやその他の視覚言語の読み取り能力に限界があります。最後に、Pix2StructとMatChaのモデル結果を報告します。

|

| QAベンチマークチャートQA&PlotQA(緩和された正確さを使用)およびチャート要約ベンチマークチャートトゥテキスト(BLEU4を使用)の実験結果。MatChaは、QAにおいては大型モデルと比較して大幅な改善が見られ、要約においてはこれらの大型モデルに匹敵する結果を示しています。 |

QAデータセットについては、数値出力において小さな相対エラーを許容する公式の緩和された正確度指標を使用しています。チャート・トゥ・テキスト要約については、BLEUスコアを報告しています。MatChaは、質問回答のベースラインに比べて著しく改善された結果を示し、大型サイズおよび広範な長いテキスト/キャプション生成のプレトレーニングがこのような長いテキスト生成に有利である要約においてPaLIと同等の結果を示しました。

デレンダリングプラス大規模言語モデルチェーン

パラメーターの数に対して非常に高いパフォーマンスを発揮するが、特に抽出タスクにおいて、ファインチューニングされたMatChaモデルがエンドツーエンドの複雑な推論(例:大きな数または複数のステップを含む数学的操作)に苦戦する場合があることが観察されました。そのため、次の2つのステップを提案してこれに対処することを提案します:1)モデルがチャートを読み取り、その後、基盤となるテーブルを出力する、2)大規模言語モデル(LLM)がこの出力を読み取り、テキスト入力のみに基づいて質問に答えることを試みます。

最初のモデルについては、MatChaをチャート・トゥ・テーブル・タスクのみでファインチューニングし、出力シーケンス長を増やしてチャート内の情報のすべてまたはほとんどを回復できるようにしました。DePlotはその結果得られたモデルです。2つ目の段階では、任意のLLM(FlanPaLMやCodexなど)がタスクに使用でき、LLMのパフォーマンスを向上させるための標準的な方法に頼ることができます。例えば、思考の連鎖や自己整合性などです。複雑な演算をオフロードするためにモデルが実行可能なPythonコードを生成するプログラム・オブ・ソウツも試行しました。

|

| DePlot+LLMメソッドのイラスト。これはFlanPaLMとCodexを使用した実際の例です。青いボックスはLLMの入力であり、赤いボックスにはLLMが生成した答えが含まれています。各回答の主要な推論ステップのいくつかを強調表示しています。 |

上記の例に示すように、DePlotモデルとLLMsの組み合わせは、特に人間が提示したChartQAの部分で、より自然な質問でありながらより困難な推論を要求する場合に、ファインチューニングされたモデルよりも大幅に優れた性能を発揮します。さらに、DePlot+LLMはトレーニングデータへのアクセスなしでこれを行うことができます。

私たちは、新しいモデルとコードをGitHubリポジトリでリリースしました。こちらでColabで自分で試すことができます。MatChaとDePlotの論文をチェックして、実験結果の詳細を確認してください。私たちは、私たちの結果が研究コミュニティに利益をもたらし、グラフやプロットの情報がより多くの人々にアクセスしやすくなることを願っています。

謝辞

この作業は、Fangyuのインターンシッププロジェクトの一環として、私たちの言語チームのFangyu Liu、Julian Martin Eisenschlos、Francesco Piccinno、Syrine Krichene、Chenxi Pang、Kenton Lee、Mandar Joshi、Wenhu Chen、Yasemin Altunによって行われました。ケンブリッジのNigel Collierも共同研究者でした。私たちは、貴重なコメントと提案をくださったJoshua Howland、Alex Polozov、Shrestha Basu Mallick、Massimo Nicosia、William Cohenに感謝したいと思います。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles