「高次元のカテゴリ変数に対する混合効果機械学習 – 第二部 GPBoostライブラリ」

Mixing Effects Machine Learning for High-Dimensional Categorical Variables - Part 2 GPBoost Library

実世界のデータを使用したPython&RでのGPBoostのデモ

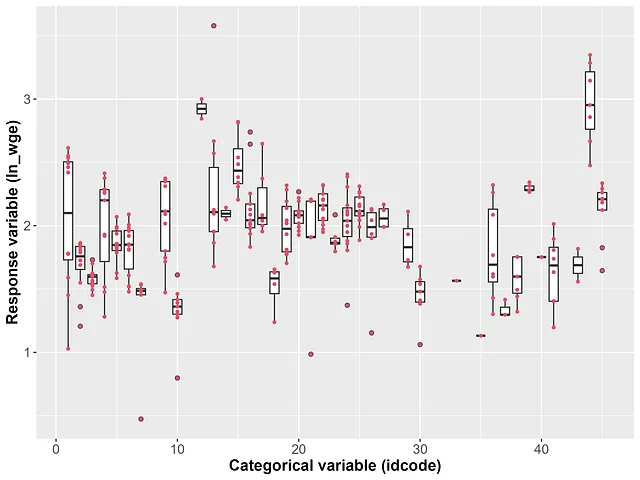

高基数のカテゴリカル変数は、データセットのサンプルサイズに対して異なるレベルの数が大きい変数です。このシリーズの第1部では、さまざまな機械学習手法の実証的な比較を行い、ランダム効果がGPBoostアルゴリズムを用いた高基数のカテゴリカル変数の処理に効果的であり、予測精度が最も高いことがわかりました [Sigrist、2022、2023]。この記事では、ツリーブースティングとランダム効果を組み合わせたGPBoostアルゴリズムを、PythonおよびRパッケージのGPBoostライブラリでどのように適用するかを示します。このデモでは、GPBoostライブラリのバージョン1.2.1を使用しています。

目次

∘ 1 紹介∘ 2 データ:説明、読み込み、サンプル分割∘ 3 GPBoostモデルのトレーニング∘ 4 チューニングパラメータの選択∘ 5 予測∘ 6 解釈∘ 7 さらなるモデリングオプション · · 7.1 カテゴリカル変数と他の予測変数との相互作用 · · 7.2 (一般化)線形混合効果モデル∘ 8 結論と参考文献

1 紹介

GPBoostモデルの適用には、次の主なステップがあります:

- 以下を指定する

GPModelを定義する: — ランダム効果モデル:group_dataを介したグループ化されたランダム効果と/またはgp_coordsを介したガウス過程 —likelihood(固定効果およびランダム効果に条件付けられた応答変数の分布) - 応答変数(

label)と固定効果の予測変数(data)を含むDatasetを作成する - 関数

gpb.grid.search.tune.parametersを使用して、チューニングパラメータを選択する - モデルをトレーニングする

- トレーニングされたモデルの予測と/または解釈を行う

以下では、これらのポイントをステップバイステップで説明します。

- ソフトウェア開発の革命:AIとコードのダイナミックなデュオ

- ウィスコンシン大学の新しい研究では、ランダム初期化から訓練された小さなトランスフォーマーが、次のトークン予測の目標を使用して効率的に算術演算を学ぶことができるかどうかを調査しています

- このAI論文では、LLMsの既存のタスクの新しいバリアントに適応する能力が評価されています

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「ディープランゲージモデルは、コンテキストから次の単語を予測することを学ぶことで、ますます優れてきていますこれが本当に人間の脳が行っていることなのでしょうか?」

- 「DeepOntoに会ってください 深層学習を用いたオントロジーエンジニアリングのためのPythonパッケージ」

- 「3Dで動作する魔法の筆:Blended-NeRFはニューラル放射場におけるゼロショットオブジェクト生成を行うAIモデルです」

- 「MosaicMLは、AIユーザーが精度を向上し、コストを削減し、時間を節約するのを支援します」

- 「自然界がコンピュータビジョンの未来を支える」

- ダブルマシンラーニングの簡略化:パート1 – 基本的な因果推論の応用

- 「Azure B シリーズの仮想マシンのパワー」