マイクロソフトの研究者たちは、人間のフィードバックを用いた強化学習のためのメモリ効率の高い解決策であるHydra-RLHFを紹介しました

Microsoftの研究者は、Hydra-RLHFというメモリ効率の高い強化学習の解決策を紹介しました

知名度が高まった以来、ChatGPT、GPT-4、Llama-2ファミリーモデルは、さまざまな仕事の有用な助手としての汎用性により、ユーザーを魅了してきました。RLHFを使用したモデルの整列と、他の多くの基盤モデルは、その効果の一因です。巨大な言語モデルをトレーニングすると、多くの知識を持つネットワークが作成されます。ただし、ネットワークがその情報を区別するように教えられていないため、望ましくない行動を示す場合があり、社会的な害を引き起こすことさえあります。モデルの振る舞いを変えることにより、整列はこの問題に対処し、安全で管理可能な基盤モデルの開発において重要な要素となっています。

RLHFはモデルの整列を向上させますが、PPO中に多数のモデルを読み込みおよびトレーニングする際の高い複雑さと大きなメモリ要件により、使用は制限されています。この適用はまだ初期段階であるため、RLHFの速度とパフォーマンスの変動を評価することが重要です。彼らはこの目標を達成するために、一般的なRLHFPPOのトレーニング手順とモデルアーキテクチャを調査しました。彼らの調査では、参照/報酬モデルとアクター/クリティックモデル間でのモデル共有によるメモリ/計算コストの削減の可能性が明らかになりました。

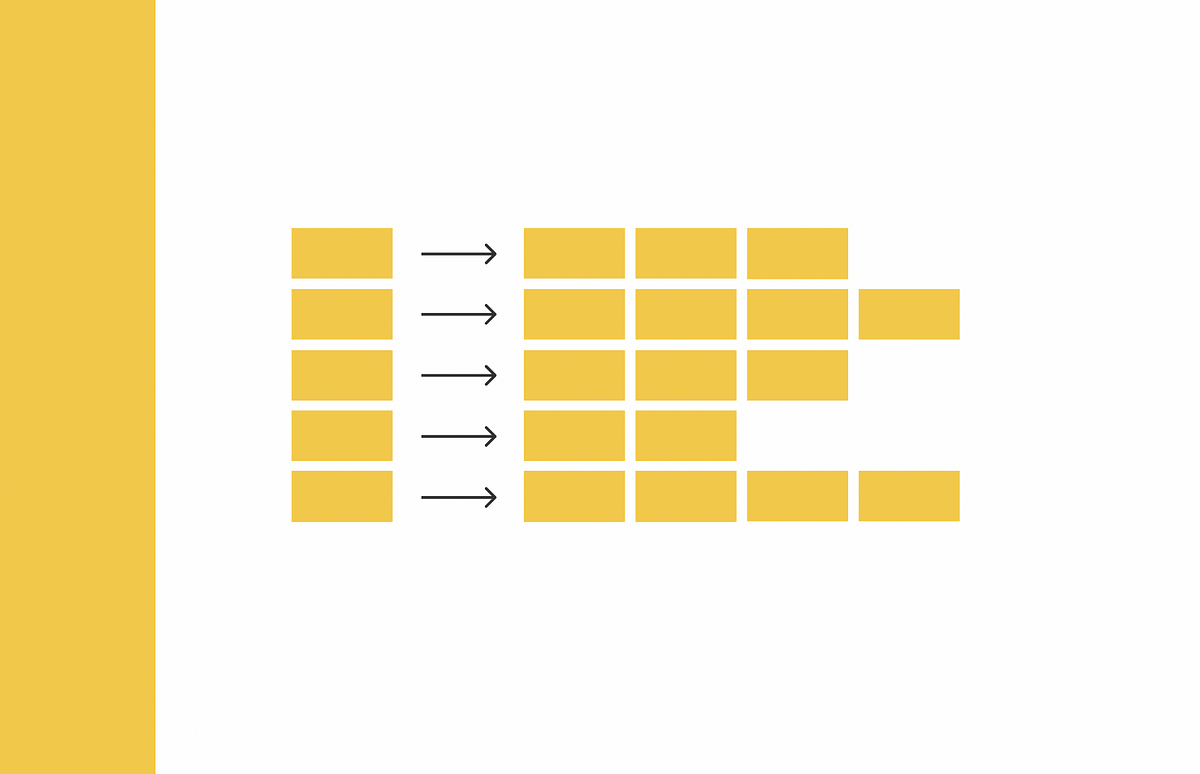

Microsoftの研究者は、これらの結果に基づいて、PPO中に学習されたモデルと静的モデルの保存量を最小化するHydra-PPOを提案しています。これにより、これらのメモリの節約は、ランタイムとパフォーマンスの比較によれば、PPOのパーサンプルのレイテンシを最大で65%減少させるために使用できます。彼らはHydra-RLHFと呼ばれる一連のRLHFの改良を提案しています。彼らは、2つの線形ヘッドを持つデコーダベースのモデルであるHydraを作成します:

- 「MITの研究者が提案するAskIt:ソフトウェア開発における大規模言語モデルの統合を効率化するためのドメイン固有言語」

- 「Appleの研究者たちは、暗黙的なフィードバックを持つ協調フィルタリングのための新しいテンソル分解モデルを提案する」

- このAI研究は、ポイントクラウドを2D画像、言語、音声、およびビデオと一致させる3Dマルチモダリティモデルである「Point-Bind」を紹介します

1)シーケンスの後に来るトークンを予測する因果関係ヘッド

2)同じ入力に関連する即時報酬を提供する報酬モデルヘッド

マルチヘッドモデルは、一般的に研究が進められ、強化学習においても詳細に研究されています。

彼らは、GPT-4によって測定されるいくつかのモデル整列手法の効果を評価する比較研究を実施しました。彼らは、LoRA-PPOがFFTよりも優れた整列を持つが、より高価であることを発見しました。彼らは、メモリ使用量を削減しながら速度を維持するための方法として、参照モデルと報酬モデルを組み合わせ、PPO中に現在のLoRAモジュールを動的に切り替えるHydra-RLHFを紹介しています。Hydra-RLHFにより、追加のRAMを使用してより大きなバッチサイズでトレーニングすることで、パーサンプルのレイテンシを最大で65%高速化することができます。Hydra-RLHFのおかげで、コミュニティはより広範なモデルとアプリケーションにRLHFを使用することができるようになりました。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「MITキャンパスでのAIパイロットプログラムは、エネルギー使用量と排出物を削減することを目指しています」

- 「このAI研究は、深層学習と進化アルゴリズムを用いて、シリコンMach-Zehnderモジュレータの設計を革新します」

- 「UCLAの研究者たちは、広帯域の回折光学ニューラルネットワークに基づいて設計されたマルチスペクトルQPIシステムを紹介する」

- 『キャタリスト研究の変革:テキスト入力を使用したエネルギー予測のために設計された Transformer ベースの AI モデル、CatBERTaに出会ってください』

- 「産業界が音声AIを活用して消費者の期待に応えている方法」

- 「Google Researchが探求:AIのフィードバックは、大規模な言語モデルの効果的な強化学習において人間の入力を置き換えることができるのか?」

- UCLAとGoogleの研究者が、AVISという画像質問応答の自律情報検索のための画期的なAIフレームワークを提案しています