「大規模なコンピュートプロジェクトにおいて、オープンソースのLLMを活用して大幅なコスト削減を実現した方法」

Method for achieving significant cost reduction in large-scale compute projects using open source LLM

オープンソースLLMとGPUレンタルによる大規模計算プロジェクトのコスト効率化

はじめに

大規模な言語モデル(LLM)の世界では、計算のコストは特に大規模なプロジェクトにとって重要な壁となる場合があります。私は最近、入力の平均トークン数が1000、出力の平均トークン数が200の4,000,000のプロンプトを実行する必要があるプロジェクトに取り組みました。それは約50億のトークンです!一般的なGPT-3.5やGPT-4のようなモデルで一トークンごとに支払う従来のアプローチでは、莫大な請求書が発生してしまいます。しかし、オープンソースのLLMを活用し、コンピュート時間ごとに支払う価格設定モデルに切り替えることで、かなりの節約が可能であることがわかりました。この記事では、私が取ったアプローチを詳細に説明し、それぞれを比較・対比します。価格に関する私の経験を共有していますが、これらは変更される可能性があり、地域や具体的な状況によって異なる場合があります。ここで重要なポイントは、特定の引用価格ではなく、オープンソースのLLMとGPUを1時間ごとにレンタルすることで得られる潜在的なコスト削減です。ご自身のプロジェクトで私のおすすめのソリューションを利用する予定がある場合は、本文の最後にいくつかのアフィリエイトリンクを残しています。

ChatGPT API

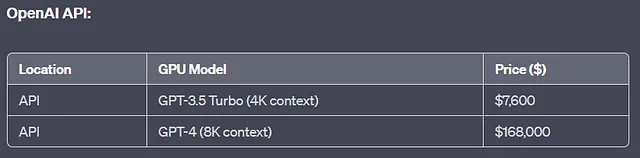

私はGPT-3.5とGPT-4を私のプロンプト入力データの一部を用いて初期テストしました。両モデルとも優れたパフォーマンスを示しましたが、GPT-4の方が多くのケースでGPT-3.5よりも優れたパフォーマンスを発揮しました。コストの目安を示すために、Open AI APIを使用して4,000,000のプロンプトをすべて実行する場合は、以下のようになります:

GPT-4は一部のパフォーマンスの恩恵を受けられるものの、コストが増えすぎており、出力に対して追加されたパフォーマンスと比較して不釣り合いな高さでした。逆に、GPT-3.5 Turboはより手頃な価格でしたが、パフォーマンスの点では不足しており、プロンプト入力の2-3%で明らかなエラーが発生しました。これらの要素を考慮すると、私は$7,600を投資する用意がありませんでした…

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles