「LLMはナレッジグラフを取って代わるのか? メタリサーチャーが提案する『ヘッド・トゥ・テイル』:大規模言語モデルの事実知識を測るための新たな基準」

Meta researcher proposes 'Head to Tail' a new criterion for measuring factual knowledge of large-scale language models, replacing the Knowledge Graph with LLM.

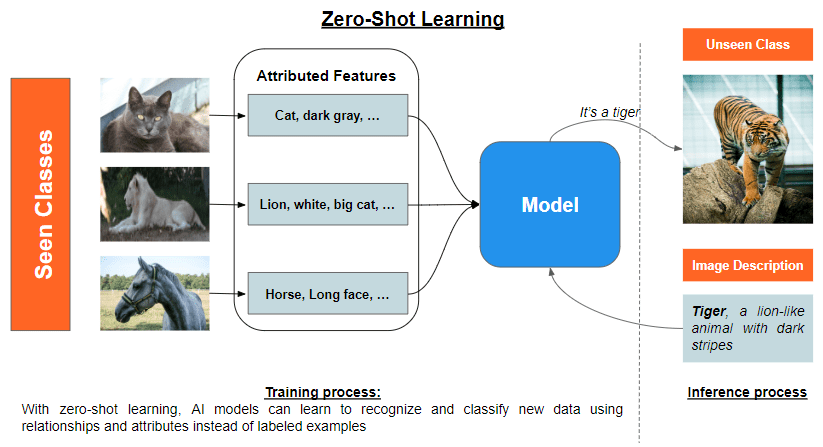

大規模言語モデルは、その超すばらしい能力によって多くの評価を集めています。彼らは人間を模倣し、人間のようにコンテンツを生成することができます。ChatGPTやLLaMAなどの事前学習済みの大規模言語モデル(LLM)は、素晴らしい能力を持っており、素材を理解し、頻繁なクエリに応答することができます。いくつかの研究では、彼らは知識を内面化し、問い合わせに応答する能力を示しています。しかし、LLMは大きく進化しているものの、特定のドメインの微妙なニュアンスを高度に理解することができず、幻覚として誤った情報を生成する傾向があります。これは、LLMの正確性を向上させ、幻覚的な応答の発生率を減らすための重要な障害を示しています。

LLMに関連する議論は、主に以下の3つの主要な領域に焦点を当てています。それは、LLMが生成した応答の幻覚を減らすこと、LLMの事実的な正確性を向上させること、そしてLLMが世界の知識を象徴的な形式で記憶する手段として知識グラフ(KG)をいずれ置き換える可能性についての推測です。最近、Meta Reality Labsの研究チームは、これらの問いに答える新しいアプローチを取り、LLMが実際にどれだけの情報を持っているかを判断しようと試みました。

知識に関してLLMがどれだけ精通しているかという問いには、2つの側面があります。まず第一に、LLM内に含まれる知識を直接的に問いかけることは困難かもしれません。モデルのパラメータに既に組み込まれている知識であっても、知識の不足や生成モデルの誤作動によって幻覚が引き起こされる可能性があります。この研究では、LLMの中に含まれる知識の程度をある基準として正確さを使用することを提案しています。これは、「バスケットボール選手のマイケル・ジョーダンはどこで生まれましたか?」のような明確で正確な質問に対するモデルの回答能力を評価するものです。LLMには簡潔な回答を提供するように求められ、自信が低い場合には「unsure」という言葉を使用して不確実性を認めるようにします。

- アリババの研究者は、Qwen-VLシリーズを紹介しますこれは、テキストと画像の両方を認識し理解するために設計された大規模なビジョン・ランゲージ・モデルのセットです

- 研究者たちは、ロボットが手全体を使って複雑な計画を立てることができるようにするAIを開発しました

- 『広範な展望:NVIDIAの基調講演がAIの更なる進歩の道を指し示す』

第二に、ユーザーの関心の多様性や世界の情報の広がりを正確に反映する利用可能なベンチマークは存在しません。最も包括的な知識グラフでも、知識のギャップが存在し、特にあまり知られていない事実に関しては顕著です。LLMや検索エンジンのクエリログは一般に利用できません。

これらの制限に対処するために、チームは「Head-to-Tail」というベンチマークを作成しました。このベンチマークは、人気のある主題に基づいてヘッド、トルソー、テールの事実に分けられた18,000の質問と回答(QA)のセットで構成されています。これらのカテゴリには異なる一般的な認知レベルが反映されています。チームは、LLMが適切に吸収した知識の幅を密接に反映する評価方法と一連の尺度を作成し、LLMが保持する知識を評価するために使用しています。

研究の中心は、一般の人々に利用可能な14のLLMの評価です。その結果、既存のLLMは事実データの理解を完全に習得する点でまだ大幅な改善が必要であることが示されました。特に、トルソーからテールの領域に含まれる、あまり知られていない組織に関する情報については、これが当てはまります。

結論として、この研究は最近提案されたベンチマークと最新の評価技術を使用してLLMの事実的な知識を検証しています。この研究は、重要な研究課題を扱い、具体的な結果を示すことにより、大規模言語モデルが事実情報を組み込む上での信頼性と将来の進展に関する継続的な議論に重要な貢献をしています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「この新しいAI研究は、事前学習されたタンパク質言語モデルを幾何学的深層学習ネットワークに統合することで、タンパク質構造解析を進化させます」

- スタンフォードの研究者たちは、DSPyを紹介します:言語モデル(LM)と検索モデル(RM)を用いた高度なタスクの解決のための人工知能(AI)フレームワーク

- 「ATLAS研究者は、教師なし機械学習を通じて異常検出を行い、新しい現象を探求しています」

- 「大規模な言語モデルは、多肢選択問題の選択の順序に敏感なのか」という新しいAI研究に答える

- CMU(カーネギーメロン大学)と清華大学の研究者が提案した「Prompt2Model:自然言語の指示から展開可能なAIモデルを生成する汎用メソッド」

- ETHチューリッヒの研究者が、大規模な言語モデル(LLM)のプロンプティング能力を向上させるマシンラーニングフレームワークであるGoT(Graph of Thoughts)を紹介しました

- UCSFとUC Berkeleyの研究者たちは、脳幹の脳卒中による重度の麻痺を持つ女性がデジタルアバターを通じて話すことができるようにする脳-コンピューターインタフェース(BCI)を開発しました