「プリズマーに会いましょう:専門家のアンサンブルを持つオープンソースのビジョン-言語モデル」

Let's meet Prizma An open-source vision-language model with an ensemble of experts.

最近の多くのビジョン言語モデルは、非常に注目すべき多様な生成能力を示しています。しかし、通常、それらは膨大なモデルと膨大なデータセットのトレーニングを必要とします。研究者たちは、データとパラメータの効率的なビジョン言語モデルであるPrismerを紹介し、スケーラブルな代替手法としています。Prismerは、公開されている事前トレーニング済みのドメインエキスパートからほとんどのネットワークの重みを受け継ぎ、トレーニング中にそれらを凍結することで、わずかなコンポーネントのトレーニングのみを必要とします。

大規模な事前トレーニングモデルの汎化能力は、さまざまなタスクにおいて非常に優れています。しかし、これらの機能には高い価格が付いており、トレーニングデータと計算リソースが大量に必要です。数千億のトレーニング可能なパラメータを持つモデルは、言語領域では一般的であり、yottaFLOPスケールの計算予算が必要です。

ビジュアル言語学習に関連する問題は、より困難に解決することが求められます。この分野は言語処理のスーパーセットでありながら、ビジュアルおよびマルチモーダルな思考の専門知識も必要とします。Prismerは、予測されるマルチモーダル信号を使用したデータ効率の良いビジョン言語モデルであり、さまざまな事前トレーニング済みエキスパートを使用します。ビジュアルクエスチョンアンサリングや画像キャプションなど、ビジョン言語推論のタスクの例として扱うことができます。Prismerは、プリズムを例にして、一般的な推論タスクをいくつかのより小さな、より管理しやすいチャンクに分割します。

- 「アニメート・ア・ストーリー:高品質で構造化されたキャラクター主導のビデオを合成する、検索補完型ビデオ生成によるストーリーテリング手法による出会い」

- ディープネットワークの活性化関数の構築

- 「Human Sketchesが物体検出にどのような役割を果たすことができるのか?スケッチベースの画像検索に関する洞察」

研究者たちは、視覚的に条件付けられた自己回帰テキスト生成モデルを開発しました。Prismerの最も重要な設計特徴の2つは、(i)ビジョンのみのモデルをWebスケールの知識のためのコアネットワークバックボーンとして使用し、(ii)モダリティに特化したビジョンエキスパートが、深度などの低レベルのビジョン信号からインスタンスやセマンティックラベルなどの高レベルのビジョン信号まで、対応するネットワークの出力から直接補助的な知識をエンコードすることです。研究者たちは、探索的なビジョン言語推論タスクにおいて、さまざまな事前トレーニング済みドメインエキスパートをより良く活用するために、視覚的に条件付けられた自己回帰テキスト生成モデルを開発しました。

Prismerは、公開されている画像/代替テキストデータの13Mの例でのみトレーニングされていますが、画像キャプション、画像分類、ビジュアルクエスチョンアンサリングなどのタスクにおいて、強力なマルチモーダル推論性能を示し、多くの最先端のビジョン言語モデルと競合しています。研究者たちは、Prismerの学習習慣を徹底的に調査し、いくつかの良い特徴を見つけました。

モデル設計:

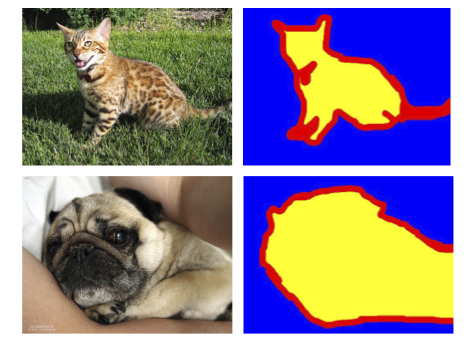

Prismerモデルは、エンコーダ-デコーダトランスフォーマーのバージョンで表示され、トレーニングプロセスを高速化するために、既にトレーニング済みの専門家の大きなプールを活用しています。このシステムは、ビジョンエンコーダと自己回帰言語デコーダで構成されています。ビジョンエンコーダは、RGBとマルチモーダルラベル(凍結された事前トレーニング済みのエキスパートから予測される深度、表面法線、セグメンテーションラベル)のシーケンスを入力として受け取り、RGBとマルチモーダルの特徴のシーケンスを出力します。このクロスアテンショントレーニングの結果、言語デコーダはテキストトークンの文字列を生成するように条件付けられます。

利点:

- Prismerモデルにはいくつかの利点がありますが、最も注目すべきは、トレーニング中に非常に効率的にデータを使用することです。Prismerは、Webスケールの知識を利用するために事前トレーニングされたビジョンのみと言語のみのバックボーンモデルの上に構築されており、他の最先端のビジョン言語モデルと同等の性能を得るために必要なGPU時間を大幅に削減します。これらの事前トレーニングされたパラメータを使用して、利用可能な大量のウェブスケールの知識を利用することができます。

- 研究者たちは、ビジョンエンコーダのためのマルチモーダル信号入力も開発しました。作成されたマルチモーダルの補助的な知識は、入力画像の意味と情報をより良く捉えることができます。Prismerのアーキテクチャは、わずかなトレーニング可能なパラメータでトレーニング済みエキスパートの使用を最大限に活用するように最適化されています。

研究者は、Prismerに2種類の事前トレーニング済みエキスパートを含めました:

- バックボーンの専門家 テキストと画像を意味のあるトークンのシーケンスに変換するための事前トレーニング済みモデルを、それぞれ「ビジョンのみ」と「言語のみ」と呼びます。

- ディスコースモデルのモデレータ タスクをさまざまな方法でラベル付けするために使用されるデータに応じて、ディスコースモデルのモデレータはタスクにラベル付けを行います。

特性

- 知識豊富な人々が多ければ多いほど、結果は良くなります。Prismerのモダリティの専門家の数が増えるにつれて、パフォーマンスが向上します。

- より熟練した専門家、より優れた結果 研究者は、予測される深度ラベルの一部を一様分布からランダムノイズで置き換えて、破損した深度エキスパートを作成し、エキスパートの品質がPrismerのパフォーマンスに与える影響を評価しました。

- 無益な意見に対する耐性 研究結果は、ノイズ予測エキスパートが組み込まれた場合でも、Prismerのパフォーマンスが安定していることをさらに示しています。

弊社のPaperとGithubをご覧ください。この研究における全てのクレジットは、このプロジェクトの研究者に帰属します。また、最新のAI研究ニュースや素晴らしいAIプロジェクトなどを共有している26k+人のML SubReddit、Discordチャンネル、メールニュースレターにもぜひご参加ください。

Tensorleapの説明可能性プラットフォームでディープラーニングの秘密を解き放つ

この投稿は、MarkTechPostによるものです。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles