「大規模な言語モデルがコンパイラ最適化のメタAI研究者を驚かせる!」

Large language models surprise compiler optimization researchers!

「これは、LLMの明らかな不備についての論文だと思っていましたが、将来の賢いアイデアの動機づけとなるものとして役立つものです。しかし、私たちは非常に驚いたことに、十分に訓練されたLLMは、入力コードに最適な最適化を予測するだけでなく、コンパイラを使わずに直接最適化を行うことができることが多いことがわかりました!」。- Meta AIの研究者

Meta AIの研究者は、通常のコンパイラ(LLVMなど)が行うようなコードの最適化を、大規模な言語モデル(LLM)に行わせようとしていました。LLVMの最適化は非常に複雑であり、C++プログラミング言語で1百万行以上のコードに書かれた数千のルールとアルゴリズムがあります。

彼らは、LLMがこのような複雑さに対応できるとは思っていませんでした。なぜなら、LLMは通常、言語の翻訳やコードの生成などのタスクに使用されるからです。コンパイラの最適化には、さまざまな種類の思考、数学、複雑な技法が必要であり、LLMが得意であるとは思っていませんでした。しかし、手法の後、結果は驚くべきものでした。

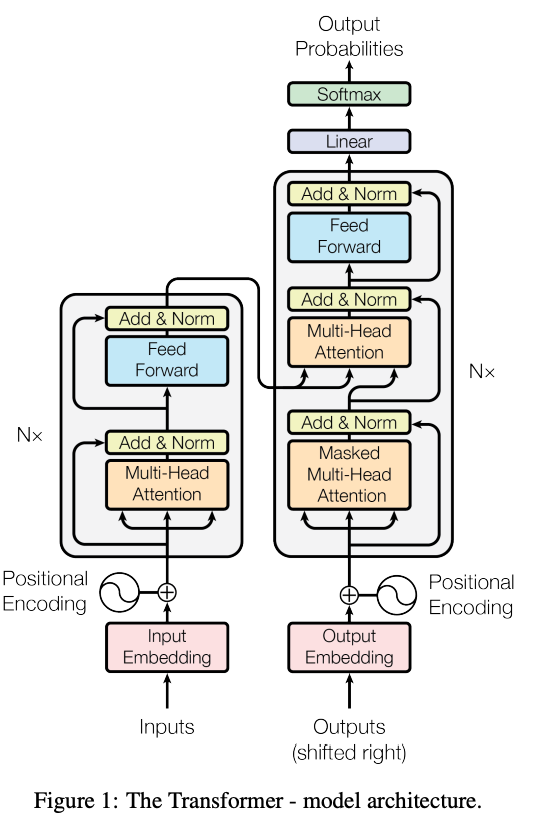

上記の画像は、訓練と推論中にモデルの入力(プロンプト)と出力(回答)を示す方法論の概要を示しています。プロンプトには最適化されていないコードが含まれます。回答には最適化パスのリスト、命令の数、および最適化されたコードが含まれます。推論中、最適化パスのリストのみが生成され、それがコンパイラにフィードされ、最適化されたコードが正しいことを保証します。

- 「大規模な言語モデルは、長い形式の質問応答においてどのようにパフォーマンスを発揮するのか?Salesforceの研究者によるLLMの頑健性と能力についての詳細な解説」

- 「UCSD研究者がオープンソース化したGraphologue:GPT-4のような大規模言語モデルの応答をリアルタイムでインタラクティブな図表に変換するユニークなAI技術」

- ソウル国立大学の研究者たちは、効率的かつ適応性のあるロボット制御のための革新的なAI手法であるロコモーション・アクション・マニピュレーション(LAMA)を紹介しています

彼らのアプローチはシンプルで、スクラッチから初期化された70億パラメータの大規模言語モデル(LLM)アーキテクチャを使用します。モデルは、各アセンブリごとに検索プロセスを通じて決定された最適なコンパイラオプションと、それらの最適化を適用した結果のアセンブリコードとペアになった数百万のLLVMアセンブリの例から成る広範なデータセットで訓練されます。これらの例だけで、モデルは驚くほど精度の高いコードの最適化能力を獲得します。

彼らの研究の注目すべき貢献は、LLMをコードの最適化のタスクに初めて適用したことにあります。彼らは、コンパイラの最適化に関して特に設計されたLLMが、2.5億回のコンパイルで5.0%の改善を達成する検索ベースのアプローチと比較して、単一のコンパイルで3.0%のコードサイズ削減を実現することを示しています。一方、最新の機械学習アプローチは回帰を引き起こし、数千回のコンパイルが必要です。研究者はまた、LLMがコードの推論における可能性と限界をより包括的に理解するための補足的な実験とコード例を提供しています。全体的に、彼らはこの文脈でのLLMの効果を非常に優れたものと見なし、その結果が広いコミュニティの関心を引くと考えています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「マイクロソフトと清華大学によるこのAI研究は、EvoPromptという新しいAIフレームワークを紹介しますこのフレームワークは、LLMと進化アルゴリズムを接続するための自動的な離散プロンプト最適化を実現します」

- 「ReLU vs. Softmax in Vision Transformers Does Sequence Length Matter? Insights from a Google DeepMind Research Paper」 ビジョン・トランスフォーマーにおけるReLU vs. Softmax:シーケンスの長さは重要か?Google DeepMindの研究論文からの洞察

- 東京大学の研究者たちは、攻撃者から機密性の高い人工知能(AI)ベースのアプリケーションを保護するための新しい技術を紹介しました

- 「MITの新しい機械学習の研究では、階層的な計画(HiP)のための組成的な基礎モデルを提案しています:長期的な課題の解決のために言語、ビジョン、行動を統合する」

- UCIと浙江大学の研究者は、ドラフティングと検証のステージを使用した自己推測デコーディングによるロスレスな大規模言語モデルの高速化を紹介しました

- 「挑戦的に、マイクロソフトの研究者はGPT-4に「人工知能の火花」を見つけたと述べる」

- 「ヌガットモデルを使用した研究論文の生成AI」