「オムニコントロール:拡張空間制御信号をテキスト条件付けされた人間の動作生成モデルに組み込むための人工知能アプローチ、拡散プロセスに基づく」

「オムニコントロール:テキスト条件付けされた人間の動作生成モデルに拡張空間制御信号を組み込むための人工知能アプローチ、拡散プロセスに基づく」

研究者は、テキスト条件付きの人間の動き生成において、いつでもあらゆる関節で空間制御信号を組み合わせる問題に取り組んでいます。現代の拡散ベースの技術は、多様でリアルな人間の動きを生成することができますが、多様な空間制御信号を組み込むのは困難です。多くのアプリケーションにとって重要な要素です。たとえば、モデルは、特定の場所と時間でカップに手を触れるために手の位置を調整し、カップを持ち上げるアクションを合成するために「拾う」意味を理解する必要があります。同様に、低い天井の部屋を移動する場合、モデルは頭の高さを一定の時間調整して事故を避ける必要があります。

これらの制御信号は、テキストのプロンプトでは説明が難しいため、関心のあるジョイントのグローバル位置として提供されることがよくあります。ただし、以前の埋め込みベースのアプローチでは、選択された相対的な人間の姿勢表現のために柔軟な制御信号を組み込むことができません。ほとんどは、ジョイントと左右の骨盤と前のフレームとの相対位置によって引き起こされています。制御信号で提供されたグローバルな骨盤の位置は、キーフレームに入力するために、前のフレームに対する相対的な位置に変換する必要があります。他のジョイントの位置を入力するように、骨盤のグローバルな位置も変換する必要があります。

ただし、拡散生成プロセスでの骨盤の相対的な位置は、両方のインスタンスでより現在または修正する必要があります。骨盤以外の関節に空間制御信号を統合するには、まず骨盤に対するスパース制約を適切に管理する必要があります。他の手法は2段階モデルを提案していますが、骨盤に対する制御信号の制限があるため、他の関節の調整にも問題があります。本研究では、ノースイースタン大学とGoogle Researchの研究者は、いつでもあらゆる関節に柔軟な空間制御信号を含めることができる革新的な拡散ベースの人間生成モデルであるOmniControlを提案しています。OmniControlをベースに、人間の動きの生成を調整するためのリアリズムガイドが追加されています。

- 「FastEmbedをご紹介:高速かつ軽量なテキスト埋め込み生成のためのPythonライブラリ」

- GoogleのAIがPaLI-3を紹介:10倍も大きい似たモデルと比べて、より小型、高速、かつ強力なビジョン言語モデル(VLM)です

- MITの新しいAI研究は、深層ニューラルネットワークが私たちとは異なる方法で世界を見ていることを示しています

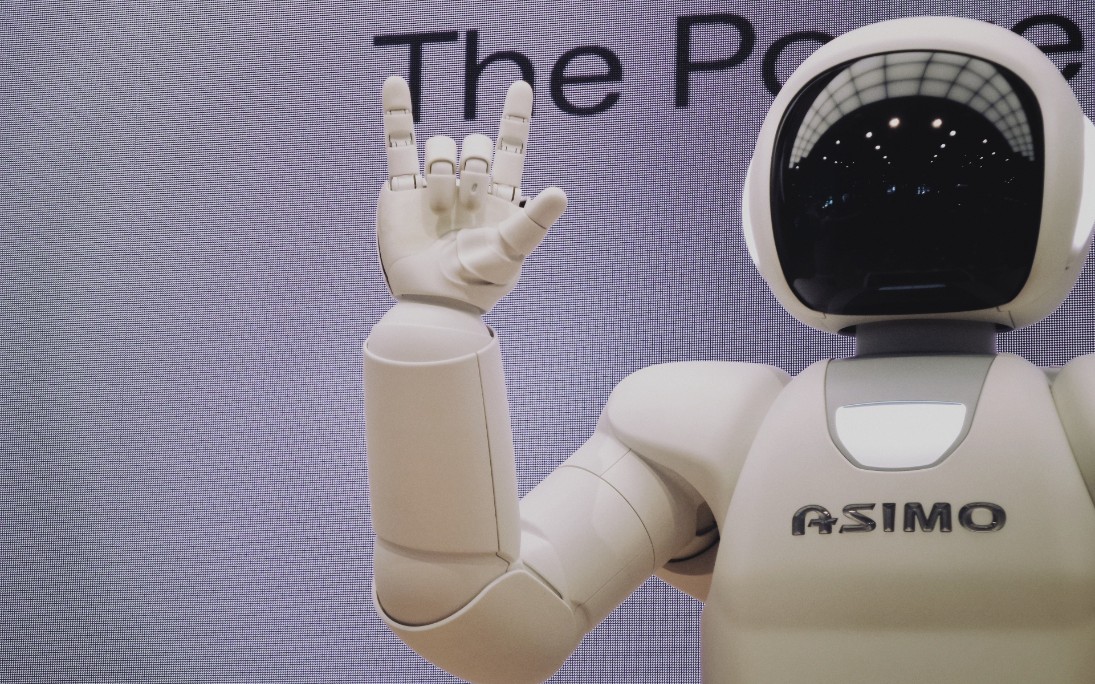

図1:テキストプロンプトと適応可能な空間制御信号を与えると、OmniControlは説得力のある人間のジェスチャーを生成することができます。シリーズの後のフレームは、より濃い色で示されています。入力制御信号は、緑色の線またはポイントで表示されます。

モデルがうまく機能するためには、入力と出力のために同じ相対的な人間の姿勢表現を使用します。しかし、彼らは、現在のアプローチとは対照的に、生成された動きをグローバル座標に変換して、空間ガイダンスモジュールで入力制御信号と直接比較することを提案しています。ここでは、エラーの勾配を使用して動きを改善するために、骨盤の相対位置に関する不確実性を解消します。さらに、以前の手法と比較して、生成された動きの動的な反復精緻化を可能にし、制御の精度を向上させます。

空間ガイダンスだけでは、しばしばドリフトの問題や異常な人間の動きが発生します。彼らはリアリズムガイドを提案し、制御された画像生成から着想を得て、モーション拡散モデルの各アテンションレイヤーの特徴に対する残差を出力して、これらの問題を解決します。これらの残差は、全身の動きを明示的にかつ密集して変化させることができます。空間制約を持つリアルな一貫した動きを生成するためには、空間ガイダンスとリアリズムガイドの両方が重要であり、制御の精度とモーションのリアリズムをバランスさせるために補完的です。

HumanML3DとKIT-MLを使用した研究によれば、OmniControlは、運動のリアリズムと制御精度の両方の観点で、最先端のテキストベースのモーション生成技術に比べて、骨盤制御においてはるかに優れた性能を発揮します。ただし、OmniControlの特長であるあらゆる関節であらゆる瞬間に空間制約を組み込むことができます。また、図1に示すように、左右の手首などを個別にではなく、複数の関節をまとめて制御するために、単一のモデルを訓練することもできます。

OmniControlのこれらの特徴により、周囲の風景やオブジェクトと結び付けた生成された人間の動きを行うなど、さまざまな下流アプリケーションが可能になります。彼らの簡潔な貢献は次のとおりです:(1)彼らが知る限りでは、OmniControlはいつでもあらゆる関節で空間制御信号を組み合わせることができる最初の戦略です。 (2)生成された動きの制御精度とモーションのリアリズムを成功裡にバランスさせるために、空間とリアリズムガイダンスを使用するユニークな制御モジュールを提案しています。 (3)テキストベースのモーション生成において単一のモデルを使用して追加の関節を制御できることを示すテストは、骨盤の制御を制御する新しい基準を提供し、人間の動き生成のさまざまなアプリケーションの可能性を開いています。

を日本語に翻訳すると次のようになります:

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「MatFormerをご紹介します:プラットフォーム間で柔軟なモデル展開を可能にする、汎用なネストされたTransformerアーキテクチャ」

- In Japanese, the title would be written as 「プロのようにChatGPT 4Visionを活用する7つの方法」(Puro no you ni ChatGPT 4Vision o katsuyou suru nanatsu no houhou).

- ジェネラティブ人工知能を解明:拡散モデルと視覚コンピューティングの進化についての詳細な解説

- SalesForce AIはCodeChainを導入:代表的なサブモジュールによる自己改訂の連鎖を通じたモジュラーコード生成のための革新的な人工知能フレームワーク

- QLoRA:16GBのGPUで大規模な言語モデルの訓練を行う

- 大規模なMLライフサイクルの統治、パート1:Amazon SageMakerを使用してMLワークロードを設計するためのフレームワーク

- 「自己改善のための生成AIと強化学習の統合」