Hugging Faceにおける推論ソリューションの概要

'Hugging Faceの推論ソリューションの概要'

毎日、開発者や組織はHugging Faceでホストされたモデルを採用し、アイデアを概念実証デモに、デモを本格的なアプリケーションに変えています。例えば、Transformerモデルは、自然言語処理、コンピュータビジョン、音声など、さまざまな機械学習(ML)アプリケーションの人気のあるアーキテクチャとなりました。最近では、ディフューザーがテキストから画像または画像から画像を生成するための人気のあるアーキテクチャとなりました。他のアーキテクチャも他のタスクで人気があり、私たちはそれらをすべてHF Hubでホストしています!

Hugging Faceでは、最新のモデルを最小限の摩擦でテストおよび展開できる能力は、MLプロジェクトのライフサイクル全体で重要です。コストとパフォーマンスの比率を最適化することも同様に重要であり、無料のCPUベースの推論ソリューションを提供していただいたインテルの友人に感謝申し上げます。これは私たちのパートナーシップにおけるさらなる大きな一歩です。また、Intel Xeon Ice Lakeアーキテクチャによる高速化を無料でお楽しみいただけるため、ユーザーコミュニティの皆様にとっても素晴らしいニュースです。

さあ、Hugging Faceでの推論オプションを見てみましょう。

無料推論ウィジェット

Hugging Faceハブでの私のお気に入りの機能の1つは、推論ウィジェットです。モデルページにある推論ウィジェットを使用すると、サンプルデータをアップロードして1クリックで予測することができます。

以下は、sentence-transformers/all-MiniLM-L6-v2モデルを使用した文の類似性の例です:

モデルの動作、出力、およびデータセットのいくつかのサンプルでのパフォーマンスを素早く把握する最良の方法です。モデルはサーバー上でオンデマンドでロードされ、必要なくなるとアンロードされます。コードを書く必要はありませんし、この機能は無料です。どこが好きではないですか?

無料推論API

推論APIは、推論ウィジェットの内部で動作しています。単純なHTTPリクエストで、ハブの任意のモデルをロードし、数秒でデータを予測することができます。モデルのURLと有効なハブトークンが必要です。

以下は、xlm-roberta-baseモデルを1行でロードして予測する方法です:

curl https://api-inference.huggingface.co/models/xlm-roberta-base \

-X POST \

-d '{"inputs": "The answer to the universe is <mask>."}' \

-H "Authorization: Bearer HF_TOKEN"推論APIは、開発およびテスト中のアプリケーションから直接呼び出すことができる予測サービスを簡単に構築するための最も簡単な方法です。特別なAPIやモデルサーバーは必要ありません。さらに、アプリケーションで瞬時にモデルを切り替え、パフォーマンスを比較することもできます。しかも、推論APIは無料で使用できます。

レート制限が適用されるため、本番環境では推論APIの使用はおすすめしません。代わりに、推論エンドポイントをご検討ください。

推論エンドポイントを使用した本番環境

MLモデルのパフォーマンスに満足したら、本番環境にデプロイする時が来ました。残念ながら、サンドボックスを離れると、セキュリティ、スケーリング、モニタリングなど、すべてが懸念事項になります。これは多くのMLプロジェクトがつまずき、時には失敗するところです。私たちは、この問題を解決するために推論エンドポイントを構築しました。

わずか数クリックで、推論エンドポイントを使用して、選択したAWSまたはAzureリージョンにホストされた安全でスケーラブルなインフラ上に、任意のハブモデルをデプロイできます。追加の設定には、CPUおよびGPUのホスティング、組み込みの自動スケーリングなどがあります。これにより、適切なコスト/パフォーマンス比を簡単に見つけることができます。価格は最低$0.06/時間から開始します。

推論エンドポイントは3つのセキュリティレベルをサポートしています:

-

パブリック:エンドポイントはパブリックなHugging Faceサブネットで実行され、認証なしでインターネット上の誰でもアクセスできます。

-

プロテクト:エンドポイントはパブリックなHugging Faceサブネットで実行され、適切なHugging Faceトークンを持つインターネット上の誰でもアクセスできます。

-

プライベート:エンドポイントはプライベートなHugging Faceサブネットで実行され、インターネット上ではアクセスできません。AWSまたはAzureアカウント内のプライベート接続を介してのみ利用可能です。これは最も厳格なコンプライアンス要件を満たします。

Inference Endpointsについて詳しくは、このチュートリアルとドキュメントをお読みください。

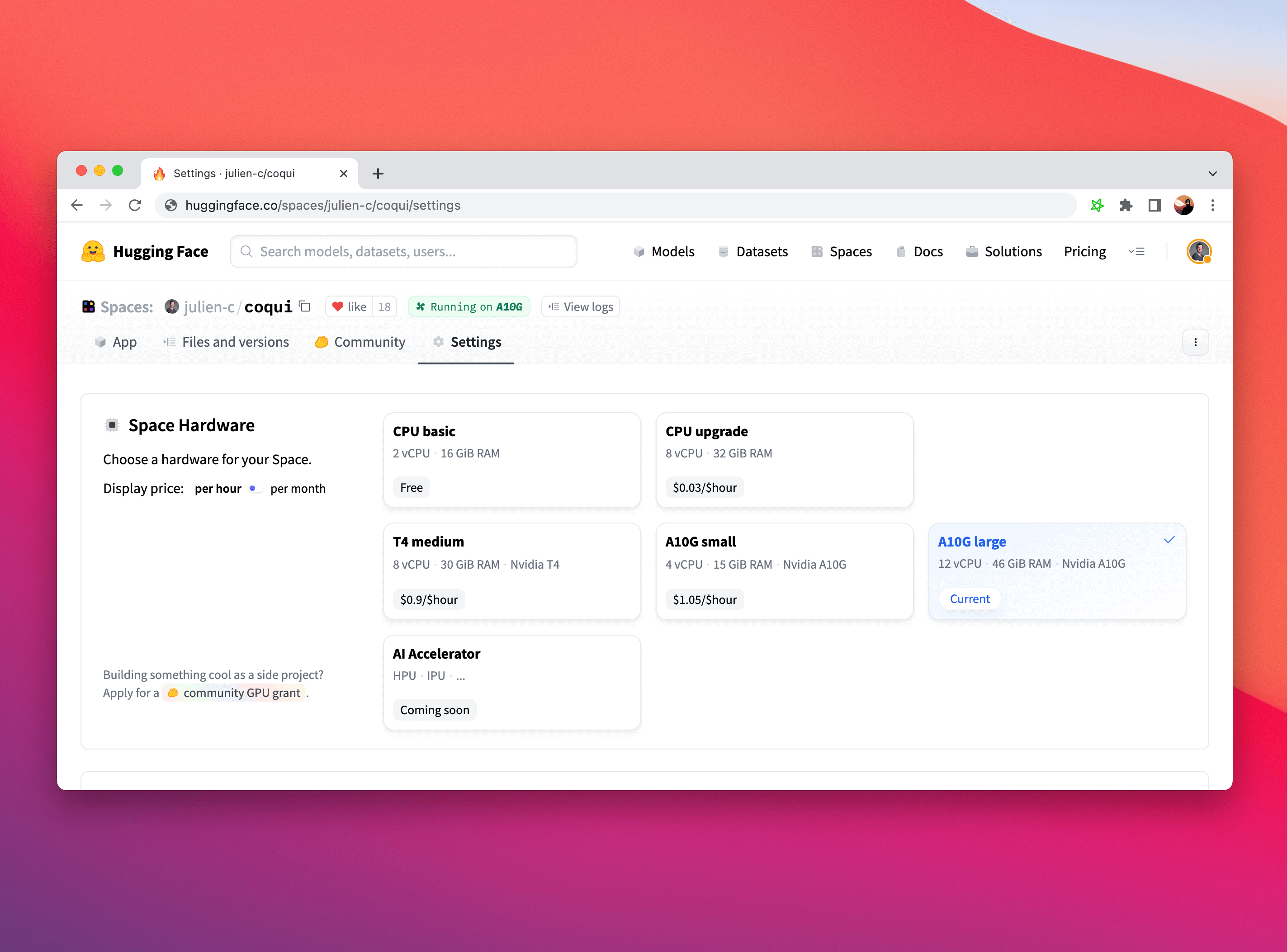

Spaces

最後に、Spacesは単純なUIフレームワーク(例:Gradio)を使用してモデルを展開するための本番環境対応のオプションです。また、高度なIntel CPUやNVIDIA GPUなどのハードウェアのアップグレードもサポートしています。モデルをデモするにはこれ以上の方法はありません!

Spacesについて詳しくは、ドキュメントを参照してください。また、フォーラムでの投稿や質問もお気軽にどうぞ。

始めるには

簡単な手順です。Hugging Faceハブにログインし、モデルを閲覧してください。気に入ったモデルが見つかったら、ページ上で直接Inference Widgetを試すことができます。”Deploy”ボタンをクリックすると、評価のための無料Inference APIでモデルを展開するための自動生成されたコードと、Inference EndpointsやSpacesで本番展開するための直接リンクが表示されます。

ぜひお試しください。Hugging Faceフォーラムでのフィードバックをお待ちしています。

読んでいただきありがとうございました!

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles