「GPTQまたはbitsandbytes:LLMsのためにどの量子化方法を使用するか — Llama 2の例」

GPTQまたはbitsandbytes:量子化方法の選択例

コンピュータ上での手頃なファインチューニングと推論のための大規模言語モデルの量子化

大規模言語モデル(LLM)は、パラメータが増えるにつれて大きくなりましたが、そのメモリ使用量を減らすための新しい技術も提案されています。

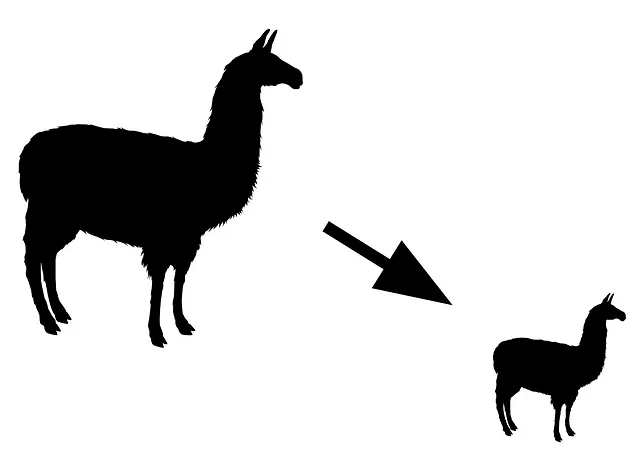

モデルのサイズをメモリ上で縮小するための最も効果的な方法の一つが量子化です。量子化は、LLMに対する圧縮技術として捉えることができます。実際には、量子化の主な目標は、LLMの重みの精度を16ビットから8ビット、4ビット、または3ビットに低下させ、パフォーマンスの低下を最小限に抑えることです。

LLMに対する2つの人気のある量子化手法があります:GPTQとbitsandbytesです。

本記事では、これら2つのアプローチの主な違いについて説明します。それぞれには利点と欠点があり、異なるユースケースに適している特徴があります。また、Llama 2を使用して、メモリ使用量と推論速度の比較を行い、以前の研究から得られた実験に基づいて性能について議論します。

注:量子化について詳しく知りたい場合は、Maxime Labonneによるこの優れた紹介記事を読むことをおすすめします:

重みの量子化への導入

8ビット量子化による大規模言語モデルのサイズ縮小

towardsdatascience.com

GPTQ:軽量ストレージと高速推論のための事後トレーニング量子化

GPTQ(Frantar et al.、2023)は、デプロイ準備が整ったモデルに最初に適用されました。言い換えれば、モデルが完全にファインチューニングされた後、GPTQがサイズを縮小するために適用されます。

GPTQは、重みの精度を4ビットまたは3ビットに低下させることができます。実際には、GPTQは主に4ビット量子化に使用されます。3ビットは非常に不安定とされています(Dettmers and Zettlemoyer、2023)。

GPTQは、モデル全体をメモリに読み込むことなく量子化を行います。代わりに、GPTQはLLMモジュールごとに読み込み、量子化を行います。量子化にはキャリブレーションのための少量のデータが必要であり、これには…以上の時間がかかる場合があります。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles