「密度プロンプティングチェーンでGPT-4サマリゼーションをアンロックする」

「美容とファッションのエキスパートが教える、密度プロンプティングチェーンを使ったGPT-4サマリゼーションのアンロック方法」

主なポイント

- Chain of Density(CoD)は、GPT-4のような大規模言語モデルの要約タスクを最適化するために設計された、新しいプロンプトエンジニアリング技術です

- この技術は、生成される要約の情報密度の制御に対処し、疎な部分でも密な部分でもないバランスの取れた出力を提供します

- CoDはデータサイエンスにおいて実用的な影響を与えます。特に、高品質で文脈に即した要約が必要なタスクにおいて重要です

要約に含める「適切な」情報量を選ぶことは困難な課題です。

イントロダクション

プロンプトエンジニアリングは、生成型AIの有効性の向上を可能にする燃料です。従来のプロンプトの中でも、Chain-of-ThoughtやSkeleton-of-Thoughtなどの存在は、構造化された効率的な出力に焦点を当てていますが、Chain of Density(CoD)という最近の技術は、テキストの要約の品質を最適化することを目指しています。この技術は、要約に「適切な」情報量を選択するという課題に対処し、疎な部分でも密な部分でもない要約を実現します。

Chain of Densityの理解

Chain of Densityは、GPT-4のような大規模言語モデルの要約能力を向上させるために開発されています。この技術は、生成される要約の情報密度を制御することに焦点を当てています。バランスの取れた要約は、複雑な内容を理解するための鍵であり、CoDはそのバランスを取ることを目指します。これには特別なプロンプトが使用され、AIモデルに対して必要なポイントを含める一方で不必要な詳細を避けるように誘導します。

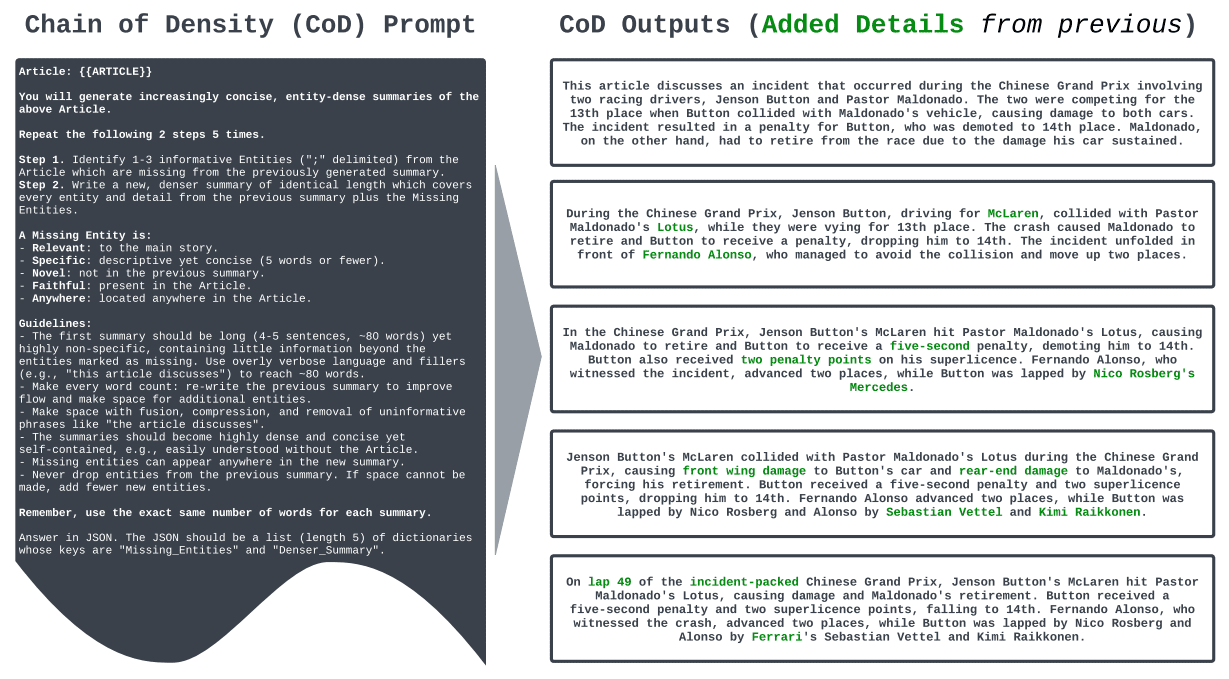

図1:Chain of Densityプロセスの例(Sparse to Dense: GPT-4 Summarization with Chain of Density Promptingから)(クリックして拡大)

図1:Chain of Densityプロセスの例(Sparse to Dense: GPT-4 Summarization with Chain of Density Promptingから)(クリックして拡大)

Chain of Densityの実装

CoDの実装には、モデルが要約を生成するためにガイドされる一連のチェーンプロンプトが使用されます。これらのプロンプトはモデルの焦点を制御し、重要な情報に向け、関係のない詳細からそれを導きます。たとえば、要約のための一般的なプロンプトから始めて、生成されるテキストの密度を調整するための具体的なプロンプトに続くことができます。

Chain of Densityプロンプトプロセスの手順

- 要約するテキストの特定:要約したいドキュメント、記事、またはその他のテキストを選びます。

- 初期プロンプトの作成:選択したテキストに合わせた初期の要約プロンプトを作成します。ここでは、Large Language Model(LLM)であるGPT-4を基本的な要約の生成に誘導することを目指します。

- 初期の要約の分析:初期プロンプトから生成された要約を確認します。要約が疎すぎる(主要な詳細が欠けている)か、密度が高すぎる(不要な詳細が含まれている)かを特定します。

- チェーンプロンプトの設計:初期の要約の密度に基づいて、要約の詳細レベルを調整するための追加のプロンプトを作成します。これらは「チェーンプロンプト」と呼ばれ、Chain of Density技術の中心です。

- チェーンプロンプトの実行:これらのチェーンプロンプトをLLMにフィードバックします。これらのプロンプトは、必要な詳細を追加することによって密度を高めるか、不必要な情報を削除することによって密度を低くすることを目的としています。

- 調整された要約の確認:チェーンプロンプトを実行して生成された新しい要約を確認します。必要なポイントをすべて捉えつつ、不必要な詳細を避けることを確認します。

- 必要に応じて繰り返す:要約が情報密度の要件を満たしていない場合は、ステップ4に戻り、チェーンプロンプトを適切に調整します。

- 要約の最終化:要約が所望の情報密度レベルを満たすようになったら、それは最終化され、使用する準備ができたと見なされます。

密度の連鎖プロンプト

次のCoDプロンプトは論文から直接引用されています。

記事:{{ ARTICLE }}

上記の記事について、ますます簡潔でエンティティ密度の高い要約を生成します。

以下の2つのステップを5回繰り返します。

ステップ1:以前に生成された要約に存在しない記事から1〜3つの情報提供エンティティ(「;」で区切られた)を特定します。ステップ2:前の要約と同じ長さの新しい、より密度のある要約を作成し、前の要約に加えて、すべてのエンティティと詳細情報をカバーします。

次の要素は、

– 主要なストーリーに関連します。

– 記述的であるが簡潔です(5語以下)。

– 前の要約には存在しません。

– 記事に存在します。

– 記事のどこにでも存在します。ガイドライン:- 最初の要約は長く(4〜5文、約80単語)、エンティティが足りないことを除いてはほとんど情報を含まず、過剰な冗長な言語やフィラー(「この記事では」という表現など)を使用して約80単語に達するようにします。- すべての単語が重要です:前の要約を書き直して流れを改善し、追加のエンティティのためにスペースを作ります。- 「記事では説明されています」といった情報量の少ないフレーズの融合、圧縮、除去でスペースを作ります。- 要約は非常に密度が高く、簡潔ですが、記事なしでも理解しやすくなります。- 新しい要約には、Missing Entitiesがどこにでも現れることがあります。- 前の要約からエンティティを削除しないでください。スペースを作ることができない場合は、新しいエンティティを少なく追加します。

忘れないでください、各要約にはまったく同じ単語数を使用してください。

JSONで回答してください。JSONは、「Missing_Entities」と「Denser_Summary」をキーとする辞書のリスト(長さ5)である必要があります。

密度の連鎖は一つのサイズフィットオールの解決策ではありません。タスクの特定のニーズに合わせて連鎖プロンプトを慎重に作成する必要があります。ただし、正しく実装されると、AIによる要約の品質と関連性を大幅に向上させることができます。

結論

密度の連鎖は、特に要約タスクの改善に向けたプロンプトエンジニアリングの新たなアプローチを提供します。情報密度の制御に焦点を当てることで、高品質な要約を生成するための貴重なツールとなります。次世代の言語モデルの高度な要約機能を利用するために、プロジェクトにCoDを取り入れてください。

Matthew Mayo(@mattmayo13)は、コンピュータサイエンスの修士号とデータマイニングの修了証を持っています。VoAGIの編集長として、Matthewは複雑なデータサイエンスの概念を理解しやすくすることを目指しています。自然言語処理、機械学習アルゴリズム、新興AIの探求を含む専門的な関心事があります。データサイエンスコミュニティにおける知識の民主化をミッションとしています。Matthewは6歳の時からコーディングをしています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles