「GoogleはDeepfakeへの対策として、AIによって生成された画像にウォーターマークを付けます」

Google adds watermarks to AI-generated images as a countermeasure against Deepfakes.

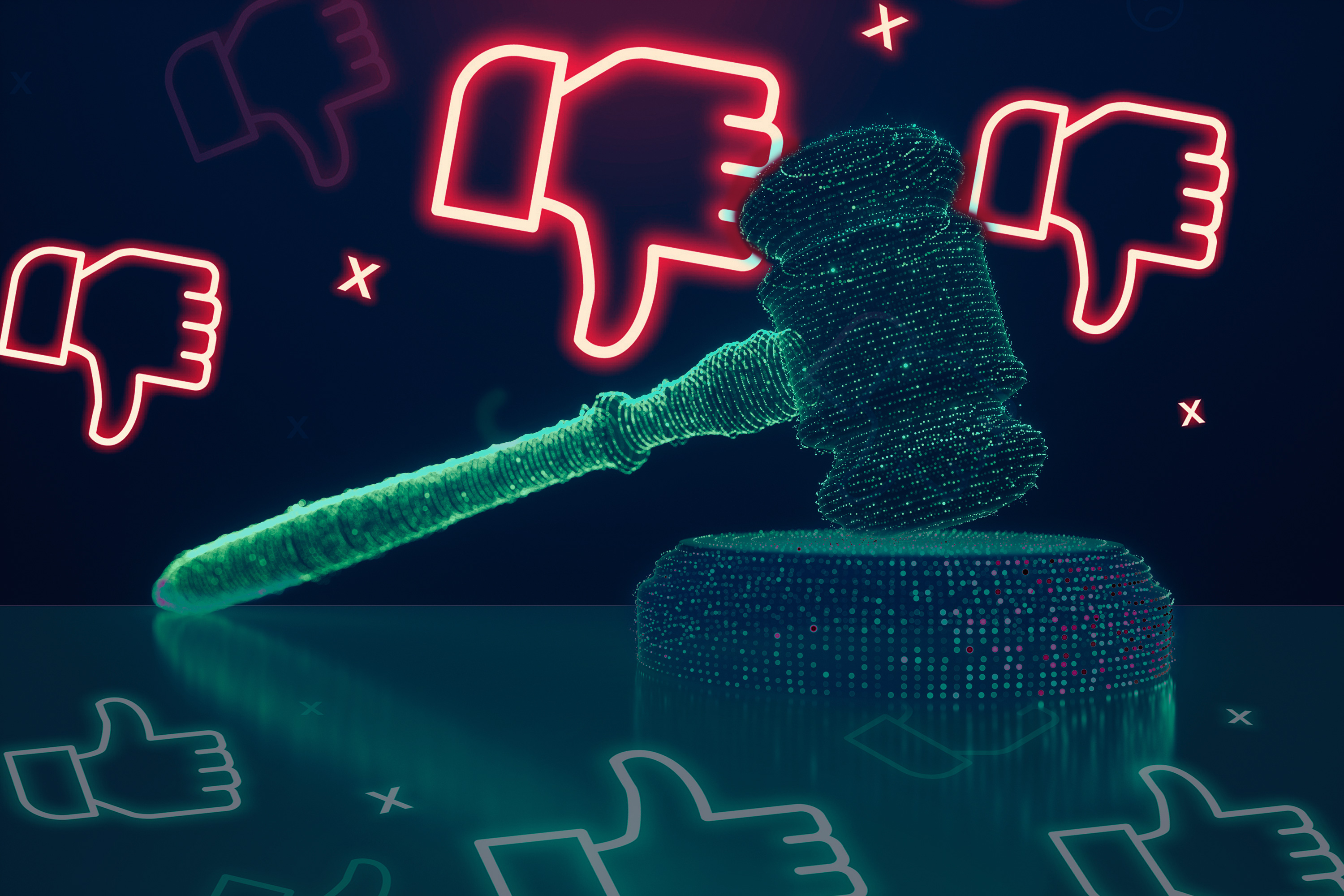

誤解を招くコンテンツの急増に対抗する重要な一歩として、Googleは革新的なソリューションを導入し、ディープフェイクに対する新たな防御層をもたらしています。この先駆的な取り組みは、AI技術を使用して作成された画像に秘密の盾のような見えない透かしを施すものです。透かしツールである「SynthID」は、Google Research、Google Cloud、Google DeepMindの革新的な連携によって生み出されました。この動きがオンラインの視覚的な信頼性を強化し、ディープフェイクとデジタルの誤情報に対する闘いに役立つ方法を探ってみましょう。

また読む:AIの時代にディープフェイクを検出・処理する方法は?

SynthID:信頼性の守護者

SynthIDという革命的なツールは、AIによって生成された作品の出自を示す見えないが消えない署名を画像に与えます。この透かしの革新は、ディープフェイクに対する強力な武器となると同時に、著作権で保護された画像を保護します。SynthIDのポテンシャルは、デジタル透かしを画像のピクセルに微妙に埋め込む能力にあります。この技術の素晴らしさは、人間の目にはほとんど見えないということですが、アルゴリズムのレンズを通じて検出可能な点にあります。

また読む:アメリカの裁判所、AIによって生成された芸術作品に著作権を認めず

- このAI研究は、深層学習システムが継続的な学習環境で使用される際の「可塑性の喪失」という問題に取り組んでいます

- Googleとジョージア工科大学の研究者が、セグメンテーションマスクを作成するための直感的な後処理AIメソッドであるDiffSegを紹介しました

- 「S-LabとNTUの研究者が、シーニメファイ(Scenimefy)を提案しましたこれは、現実世界の画像から自動的に高品質なアニメシーンのレンダリングを行うための画像対画像翻訳フレームワークであり、セミスーパーバイズド(半教師付き)手法を採用しています」

ステルスでありながら強靱

SynthIDは、AIによって生成された画像のダイナミックな状況に対処するために特別に設計された強力な機能を備えて戦場に参戦します。GoogleのAIアプリケーションとモデルを作成するためのプラットフォームであるVertex AI内のベータ版として動作するSynthIDは、Googleの先駆的なテキストから画像への変換モデルであるImagenを専用にサポートしています。この驚異的なツールは、SynthIDの透かしを持つ画像をスキャンすることで表面的なものを超えた機能を提供します。透かしの識別は、検出された、検出されていない、および可能性があるの3つの確実性レベルで測定されます。

また読む:EU、ディープフェイクとAIコンテンツの識別策を求める

二つのAIガーディアン

SynthIDの核心には、透かしを施すためのAIモデルと識別するためのAIモデルのシナジーがあります。これら2つの強力な力は、多様な画像セットを使用して共に訓練されました。この組み合わせた能力により、SynthIDはフィルタ、色の変更、または高度な圧縮といった変更の層を貫通し、AIによって生成された画像を識別する能力を保持します。

また読む:MITのPhotoGuard、AI画像の操作に対抗するためにAIを使用

SynthIDの確実性の盾

SynthIDは確実ではありますが、慎重です。透かしを施された画像を完全に識別する絶対的な確実性を自慢するわけではありませんが、透かしを持つ可能性がある画像とそれを持ちそうな画像との間を見極める洞察力を持っています。この戦略的なアプローチにより、SynthIDは正確さと慎重な分析の間の適切なバランスを取ることができます。

また読む:OpenAIのAI検出ツール、AIによって生成されたコンテンツの74%を検出できず

対策の波

Googleの画像透かしの革新的な取り組みは、競技場での唯一の試みではありません。ImatagやSteg.AIなどの企業も、クロッピング、リサイズ、編集に強い透かし技術で参入しています。Microsoftも、暗号化透かしに対する取り組みを公約しています。ShutterstockやMidjourneyも、AIによって生成されたコンテンツを示すマーカーを埋め込む独自のアプローチを進めています。OpenAIのDALL-E 2も、その創造物の証として微妙な透かしを組み込んでいます。

また読む:OpenAI、Google、Microsoft、Anthropicの4大テック企業が安全なAIのために結束

私たちの意見

生成型AIの領域は創造的な可能性で満ちていますが、同時に誤情報や欺瞞の可能性も大きくなっています。SynthID透かしの登場は、デジタルの世界での透明性と信頼性を確保するための賞賛すべき進歩です。このAIのシナジーによって支えられる見えない安全装置は、本物のコンテンツとAIによって生成された作品とを区別することでユーザーに力を与えます。デジタルの二重性に満ちた時代において、SynthIDの導入は単なる技術の進歩にとどまらず、真実を保護し、誤情報の拡散に対抗する戦略的な操作です。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- プリンストン大学の研究者が、MeZOというメモリ効率の高いゼロ次最適化器を紹介しましたこの最適化器は、大規模言語モデル(LLM)を微調整することができます

- 「SynthIDを使ったAI生成画像の識別」

- UCLとGoogleの研究者が提案する「AudioSlots:オーディオドメインの盲目的なソース分離のためのスロット中心の生成モデル」

- 初心者のための2023年の機械学習論文の読み方

- ワシントン大学とAI2の研究者が、VQAを介してAIが生成した画像の忠実度を測定する自動評価指標であるTIFAを紹介します

- Google Researchにおける責任あるAI:パーセプションの公平性

- Googleの研究者たちは、RO-ViTを紹介しますこれは、オープンボキャブラリー検出の改善のため、リージョンに意識を向けた方法でビジョントランスフォーマーを事前トレーニングするためのシンプルなAI手法です