「GoogleのAI Red Team:AIを安全にするための倫理的なハッカー」

GoogleのAI Red Team AIの安全性を確保する倫理的なハッカー

先月、私たちはSecure AI Framework(SAIF)を導入しました。これは、AIシステムへのリスクに対処し、技術のセキュリティ基準を責任ある方法で推進するために設計されました。

この勢いをさらに高めるために、本日、私たちはSAIFをサポートするために展開している重要な能力の1つであるレッドチーミングについての新しいレポートを公開します。私たちは、レッドチーミングがAIシステムへの攻撃に対して組織全体を準備するために決定的な役割を果たすと信じており、皆が安全にAIを活用できるように協力していくことを楽しみにしています。このレポートでは、AIレッドチームの設立に取り組んだ私たちの取り組みについて詳しく調査し、以下の3つの重要な領域を含んでいます:1)AIシステムのコンテキストでのレッドチーミングとそれがなぜ重要なのか、2)AIレッドチームがシミュレートする攻撃の種類、そして3)私たちが他の人と共有できる学びの教訓。

レッドチーミングとは何ですか?

Googleのレッドチームは、国家や知られた高度な持続的脅威(APT)グループからハクティビスト、個々の犯罪者、さらには悪意のある内部者まで、さまざまな敵対者をシミュレートするハッカーのチームです。この用語は軍から来ており、指定されたチームが「ホーム」チームに対して敵対的な役割(「レッドチーム」)を演じる活動を指していました。

10:25

10:25

- メタは、商用利用に無料のLLaMA 2をリリースしました

- 「メタのLlama 2の力を明らかにする:創発型AIの飛躍?」

- 「オムニスピーチは、次世代のAI音声アルゴリズムにより、自動車、モバイル、消費者、およびIoTの顧客により良いサービスを提供するために、ケイデンス・テンシリカ・オーディオ・ソフトウェア・パートナーとなりました」

Googleのセキュリティレッドチームについてもっと詳しく知りたい場合は、上記のビデオをご覧ください。

過去10年間で、私たちはレッドチーミングのコンセプトを最新の技術革新、AIを含むものに適用するために進化させてきました。AIレッドチームは、従来のレッドチームと密接に連携していますが、AIシステムに対して複雑な技術攻撃を実施するために必要なAIの専門知識も持っています。現実的な敵対者の活動をシミュレートするために、私たちのチームはMandiantやThreat Analysis Group(TAG)などの世界クラスのGoogle脅威インテリジェンスチーム、Trust & Safetyのコンテンツ悪用レッドチーミング、そしてGoogle DeepMindからの最新の攻撃に関する研究成果を活用しています。

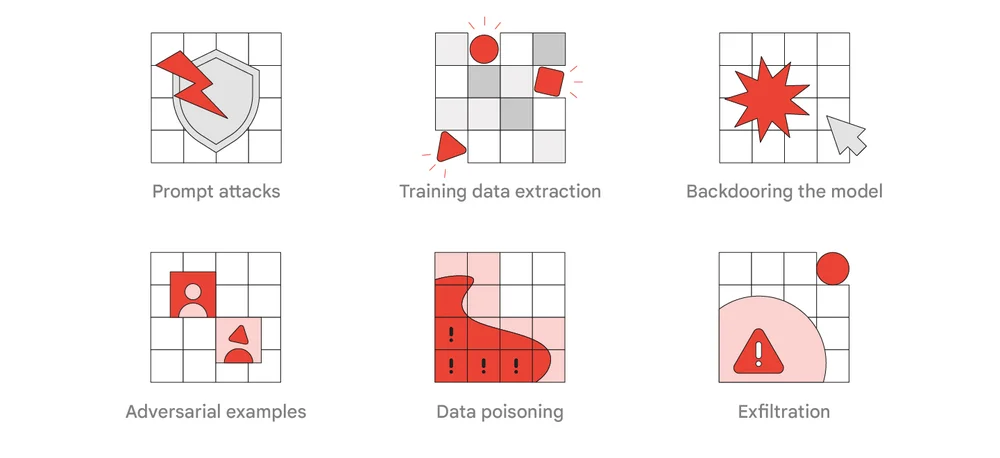

AIシステムへのレッドチーム攻撃の一般的なタイプ

GoogleのAIレッドチームの主な責任の1つは、関連する研究を取り上げ、AIを使用して実際の製品や機能に対して機能を学習させるためにそれを適用することです。このような演習は、展開される技術の場所や方法に応じて、セキュリティ、プライバシー、および乱用の分野で調査結果を得ることができます。私たちは攻撃者の戦術、技術、手順(TTP)を利用して、さまざまなシステム防御をテストすることで、これらの機会を特定し、安全性を向上させるための取り組みを行っています。今日のレポートでは、実際の世界の敵対者とレッドチーミングの演習に最も関連性があり現実的なと考えられるTTPのリストが含まれています。それには即時攻撃、トレーニングデータの抽出、モデルへのバックドアの設置、敵対的な例、データの汚染と流出などが含まれます。

学んだ教訓

私たちはすでに、AIの専門知識と能力を持つ攻撃シミュレーションへの投資が非常に成功していることを見ています。例えば、レッドチームの取り組みは、AIシステムに現れるいくつかの攻撃を予測するのに役立つ潜在的な脆弱性や弱点を明らかにしました。以下に、レポートで挙げた主な教訓を示します。

- 従来のレッドチームは良い出発点ですが、AIシステムへの攻撃はすぐに複雑になり、AIの専門知識が必要となります。

- レッドチームの調査結果に対処することは困難な場合があり、いくつかの攻撃には単純な修正方法がないかもしれません。そのため、組織はレッドチーミングを研究や製品開発の取り組みに活用することをお勧めします。

- システムやモデルの適切なロックダウンを確保するなど、従来のセキュリティ制御はリスクを大幅に軽減することができます。

- AIシステムへの多くの攻撃は、従来の攻撃と同じ方法で検出することができます。

今後の展望

Googleのレッドチームは、10年以上前に創設され、絶えず変化する脅威の状況に対応し、Google全体の防御チームの信頼できる相手となっています。このレポートが他の組織がどのようにこの重要なチームを使用してAIシステムを保護しているかを理解するのに役立ち、SAIFを進め、セキュリティ基準を向上させるための行動を促すことを願っています。大規模な公共システムにおける重要なAI展開を保護するため、私たちはすべての組織に定期的なレッドチームの演習を実施することをお勧めします。SAIFの実装、AIパイプラインのセキュリティ確保に関するさらなる情報については、また、今年のDEF CON AI Villageでの私の講演もご覧いただけます。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles