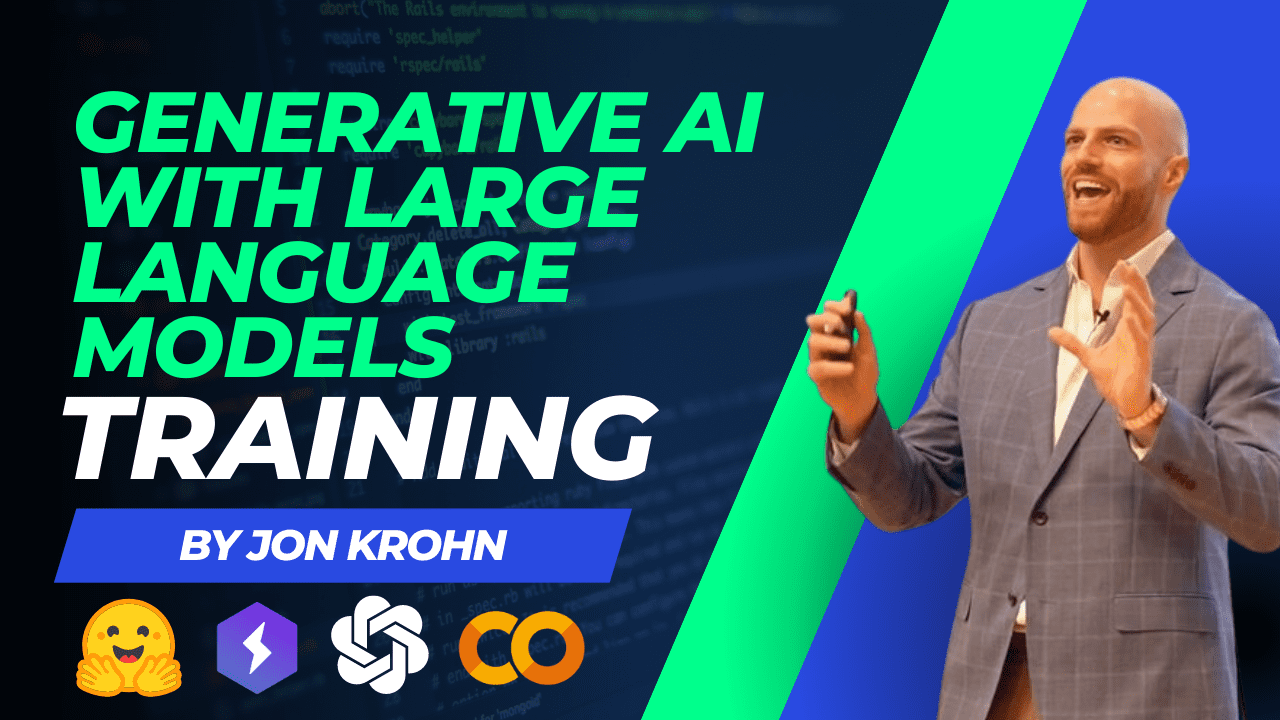

「大規模な言語モデルを使用した生成型AI:実践トレーニング」

Generating AI Using Large-scale Language Models Practical Training

イントロダクション

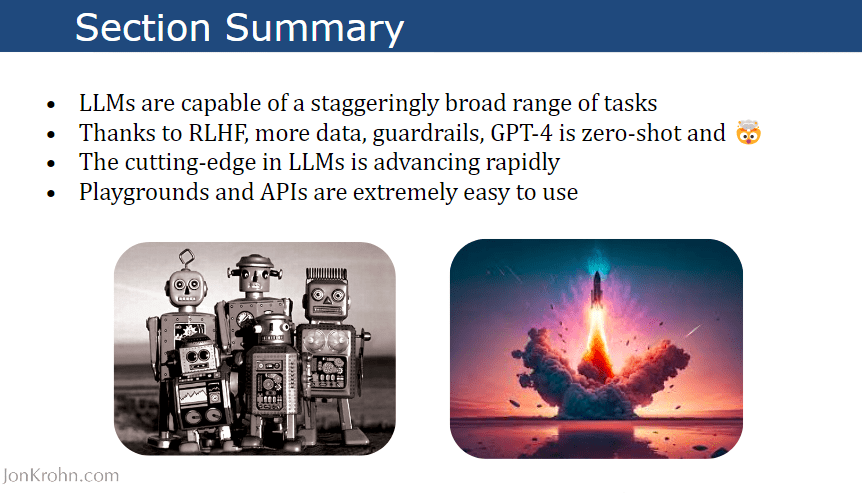

大規模言語モデル(LLM)の例としてGPT-4は、世界とデータサイエンスの分野を急速に変革しています。数年前までまるでSF映画のように思われていた機能が、今やLLMを通じて現実のものとなっています。

- 「RoboPianistに会いましょう:シミュレートされたロボットハンドを使用したピアノマスタリーにおける高次元制御のための新しいベンチマークスイート」

- このAI論文では、COLT5という新しいモデルを提案していますこのモデルは、より高品質かつ高速な処理のために条件付き計算を使用する、長距離入力のためのものです

- メタAIは、CM3leonを紹介します:最先端のテキストから画像生成を提供し、比類のない計算効率を実現するマルチモーダルのゲームチェンジャー

この「大規模言語モデルを使用した生成型AI:実践的なトレーニング」では、この革命を支えるディープラーニングの最新技術としてのトランスフォーマーアーキテクチャに焦点を当て、GPT-4のような最新のLLMが提供する驚異的な能力の広さを直接体験することができます。

LLMが機械学習モデルの開発と商業的な成功を根本から変えつつある方法を学び、データサイエンティストの創造力を加速し、洗練されたデータ製品マネージャーに導く手助けをします。

Hugging FaceとPyTorch Lightningを活用した実践的なコードデモンストレーションを通じて、このトレーニングではLLMの全ライフサイクルにわたる取り組み方を学びます。効率的なトレーニングテクニックから本番環境での最適な展開まで、LLMのパワーを解き放つために直接応用可能なスキルを身につけることができます。

この情報満載のセッションの終わりまでに、LLMの基礎的な理解とGPT-4の活用に関する実践的な経験を得ることができます。

トレーニングの概要

このトレーニングには、大規模言語モデルについての概要が含まれており、独自の大規模言語モデルをトレーニングし、サーバーに展開する方法を学ぶことができます。さらに、LLMに伴う商業的な価値についても学ぶことができます。

1. 大規模言語モデル(LLM)の紹介

- 自然言語処理の簡単な歴史

- トランスフォーマー

- サブワードトークン化

- 自己回帰モデルと自己符号化モデル

- ELMo、BERT、T5

- GPT(Generative Pre-trained Transformer)ファミリー

- LLMの適用領域

2. LLMの能力の広がり

- LLMプレイグラウンド

- GPTファミリーの進展

- GPT-4の主なアップデート

- GPT-4を含むOpenAI APIの利用

3. LLMのトレーニングと展開

- ハードウェアアクセラレーション(CPU、GPU、TPU、IPU、AWSチップ)

- Hugging Face Transformersライブラリ

- 効率的なLLMトレーニングのベストプラクティス

- パラメータ効率の高いファインチューニング(PEFT)と低ランク適応(LoRA)

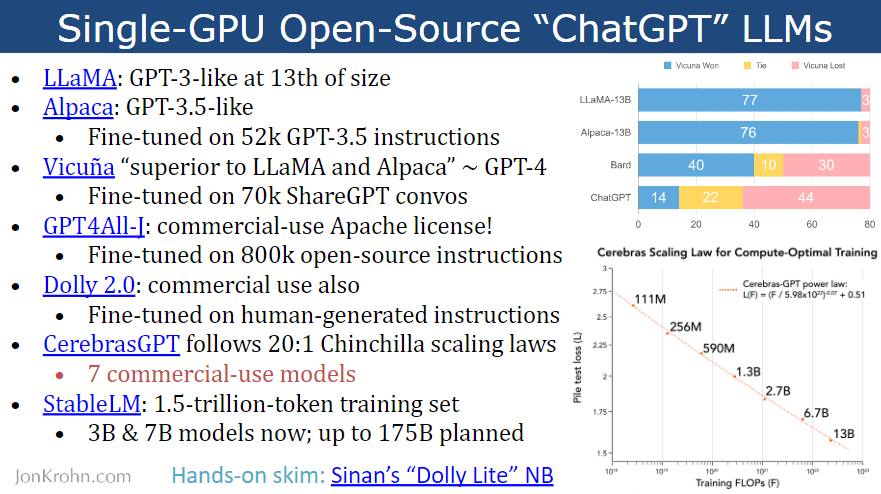

- オープンソースの事前トレーニング済みLLM

- PyTorch LightningによるLLMトレーニング

- マルチGPUトレーニング

- LLMの展開に関する考慮事項

- 本番環境でのLLMのモニタリング

4. LLMから商業的な価値を得る

- LLMによる機械学習のサポート

- 自動化できるタスク

- 補完できるタスク

- 成功するAIチームとプロジェクトのためのベストプラクティス

- AIの次のステップ

リソース

トレーニングには、ソースコード、プレゼンテーションスライド、Google Colabノートブックなどの外部リソースへのリンクが含まれています。これらのリソースは、自分のワークスペースに生成型AIを実装しているエンジニアやデータサイエンティストにとって、インタラクティブで有用なものとなっています。

ハグイングフェイスとPytorch Lightingを使用して、自分自身のLLMモデルを構築および展開するために必要な基本的なリソースのリストを以下に示します:

- プレゼンテーションスライド

- GitHubのコードソース

- Google Colab(T5-Finetune)

- YouTubeビデオ

- Jon Krohn(公式ウェブサイト)

わずか2時間で成功の秘訣を発見!もう待つ必要はありません!

アビド・アリ・アワン(@1abidaliawan)は、機械学習モデルの構築が大好きな認定データサイエンティストです。現在は、機械学習とデータサイエンス技術に関する技術的なブログの作成と執筆に重点を置いています。アビドはテクノロジーマネジメントの修士号と通信工学の学士号を保持しています。彼のビジョンは、精神疾患に苦しむ学生向けにグラフニューラルネットワークを使用したAI製品を構築することです。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「DERAに会ってください:対話可能な解決エージェントによる大規模言語モデル補完を強化するためのAIフレームワーク」

- マルチモーダル言語モデル:人工知能(AI)の未来

- マイクロソフトAIは、高度なマルチモーダルな推論と行動のためにChatGPTとビジョンエキスパートを組み合わせたシステムパラダイム「MM-REACT」を提案しています

- 「自動推論とツールの利用(ART)を紹介します:凍結された大規模言語モデル(LLM)を使用して、推論プログラムの中間段階を迅速に生成するフレームワーク」

- Concrete MLと出会ってください:プライバシーの保護と安全な機械学習を可能にするオープンソースのFHEベースのツールキット

- 新たなディープ強化学習(DRL)フレームワークは、シミュレートされた環境で攻撃者に対応し、サイバー攻撃がエスカレートする前に95%をブロックすることができます

- 『AI論文によると、大規模な言語モデルの一般的なパターンマシンとしての異なるレベルの専門知識を説明します』