フリーMITコース:TinyMLと効率的なディープラーニングコンピューティング

「フリーMITコース:TinyMLと効果的なディープラーニングコンピューティング」

イントロダクション

今日のテクノロジーに囲まれた世界では、私たちは驚くべきAIパワードの奇跡に囲まれています:私たちの質問に答える音声アシスタント、顔を識別するスマートカメラ、自動運転車など。それらは私たちのデジタル時代のスーパーヒーローのようです!しかし、これらの技術の奇跡を普段のデバイスでスムーズに動作させることは思っている以上に難しいです。これらのAIスーパーヒーローには、大幅な計算能力とメモリリソースという特別なニーズがあります。まるで小さなバックパックに図書館全体を詰め込もうとしているようです。そして、何と?私たちの普段使いのデバイス、例えば電話やスマートウォッチなどは、これらのAIスーパーヒーローを処理するのに十分な「脳の力」を持っていません。これはAI技術の普及において重大な問題です。

したがって、これらの大規模AIモデルの効率を向上させることは、アクセシビリティを確保するために非常に重要です。MIT HAN研究室の“TinyMLおよび効率的な深層学習コンピューティング“というコースは、この中核的な障壁に取り組んでいます。これはAIモデルを最適化するための手法を紹介し、それらが現実のシナリオで実用的であることを確認します。それが提供する内容を詳しく見てみましょう:

- あなたの言語モデルやAPIを活用するためのヒント

- 「DRESS」とは、自然言語フィードバックを通じて人々と調和し、対話する大規模なビジョン言語モデル(LVLM)です

- ディープシークLLM:中国の最新の言語モデル

コース概要

コース構成:

期間:2023年秋

時間:火曜/木曜日 3:35-5:00 pm Eastern Time

ティーチングアシスタント:Han Cai および Ji Lin

このコースは進行中のコースなので、ライブストリーミングをこちらのリンクから視聴することができます。

コースのアプローチ:

理論的基礎:まずは深層学習の基礎的な概念から始まり、効率的なAIコンピューティングのための高度な方法に進化していきます。

実践的な経験:学生が自分のラップトップ上でLLaMA 2などの大規模な言語モデルを展開して作業することで、実践的な経験を提供します。

コースモジュール

1. 効率的な推論

このモジュールでは、AI推論プロセスの効率を向上させることに焦点を当てています。推論操作をより速く、リソース効率が高いものにするためのプルーニング、スパース化、量子化などの技術について詳しく説明します。カバーされる主なトピックは以下の通りです:

- プルーニングとスパース化(パートI&II):パフォーマンスを損なうことなく不要な部分を削除する方法について探求します。

- 量子化(パートI&II):データとモデルをより少ないビットで表現するための技術で、メモリと計算リソースを節約します。

- ニューラルアーキテクチャサーチ(パートI&II):これらの講義では、特定のタスクに最適なニューラルネットワークアーキテクチャを自動的に探索するための手法について探求します。NLP、GAN、ポイントクラウド解析、姿勢推定など、さまざまな分野での実用的な使用例を示します。

- 知識蒸留:このセッションでは、コンパクトなモデルがより大きく、複雑なモデルの振る舞いを模倣するためにトレーニングされる知識蒸留というプロセスに焦点を当てています。これは、あるモデルから別のモデルへの知識の転送を目指しています。

- MCUNet:マイクロコントローラ上のTinyML:この講義では、AIを低消費電力のデバイスで効率的に動作させるためのTinyMLモデルの展開に焦点を当てたMCUNetを紹介します。TinyMLの本質、その課題、コンパクトなニューラルネットワークの作成、さらにはその多様な応用についてもカバーしています。

- TinyEngineと並列処理:この部分では、TinyEngineについて詳しく説明し、制約のあるデバイス上のAIモデルの効率的な展開と並列処理戦略(ループの最適化、マルチスレッディング、メモリレイアウトなど)について探求します。

2. ドメイン固有の最適化

ドメイン固有の最適化セグメントでは、AIモデルを特定のドメインに最適化するためのさまざまな高度なトピックをカバーしています:

- TransformerとLLM(パートI&II):Transformerの基礎、設計のバリエーションを掘り下げ、LLMの効率的な推論アルゴリズムに関連する高度なトピックをカバーしています。また、効率的な推論システムやLLMの微調整方法も探求しています。

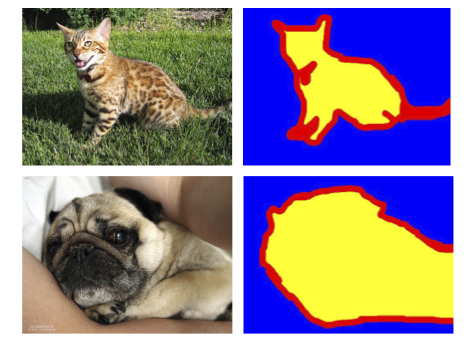

- Vision Transformer:このセクションでは、Vision Transformerの基礎、効率的なViT戦略、多様な加速技術について紹介しています。また、自己教師あり学習法や複数モーダルの大規模言語モデル(LLMs)を探求し、ビジョン関連のタスクでのAI能力を向上させる方法についても探求しています。

- GAN、ビデオ、およびポイントクラウド:この講義では、効率的なGAN圧縮技術(NAS+蒸留を使用)、ダイナミックコストのためのAnyCost GAN、データ効率のためのDifferentiable Augmentationなどを探求して、生成対抗ネットワーク(GAN)を向上させることに焦点を当てています。これらのアプローチは、GAN、ビデオ認識、およびポイントクラウド解析のためのモデルを最適化することを目指しています。

- 拡散モデル:この講義では、拡散モデルの構造、トレーニング、ドメイン固有の最適化、高速サンプリング戦略についての洞察を提供しています。

3. 効率的なトレーニング

効率的なトレーニングは、機械学習モデルのトレーニングプロセスを最適化するための手法の適用を指します。この章では、次の主要な領域をカバーしています:

- 分散トレーニング(パートI&II):複数のデバイスやシステムにトレーニングを分散するための戦略を探索します。帯域幅とレイテンシの制約を克服するための戦略、メモリ消費量の最適化、分散コンピューティング環境で大規模な機械学習モデルの効率を向上させるための効率的な並列化手法を提供します。

- オンデバイストレーニングと転移学習:このセッションでは、エッジデバイス上でモデルを直接トレーニングし、メモリ制約を扱い、新しいドメインへの効率的な適応に転移学習手法を使用することに焦点を当てています。

- 効率的なファインチューニングとプロンプトエンジニアリング:このセクションでは、BitFit、Adapter、Prompt-Tuningなどの効率的なファインチューニング手法を使用して大規模言語モデル(LLMs)を洗練することに焦点を当てています。さらに、プロンプトエンジニアリングの概念についても強調し、モデルのパフォーマンスと適応性を向上させる方法を示しています。

4. 高度なトピック

このモジュールでは、量子機械学習という新興の分野に関するトピックをカバーしています。詳細な講義はまだ利用できませんが、予定されているカバー対象のトピックは以下の通りです:

- 量子コンピューティングの基礎

- 量子機械学習

- ノイズロバストな量子ML

これらのトピックは、コンピューティングの量子原理についての基礎的な理解を提供し、これらの原理が量子システムのノイズによって引き起こされる課題に対処しながら機械学習手法を強化する方法について探求します。

このコースに興味がある場合は、以下のプレイリストをチェックしてください:

総括

このコースは、特にAI愛好家や専門家から素晴らしいフィードバックを受けています。このコースは2023年12月まで継続され、参加を強くお勧めします!もしこのコースを受講しているか、受講する予定がある場合は、あなたの経験を共有してください。TinyMLについておしゃべりし、小型デバイス上でAIをよりスマートにする方法について一緒に学びましょう。あなたの意見と洞察は貴重です!

[Kanwal Mehreen](https://www.linkedin.com/in/kanwal-mehreen1/)は、データサイエンスと医療へのAIの応用に強い関心を持つ、将来のソフトウェア開発者です。Kanwalは、APAC地域のGoogle Generation Scholar 2022に選ばれました。Kanwalは、トレンドのトピックに関する記事を書くことで技術知識を共有することが大好きで、テック業界での女性の代表性向上に情熱を持っています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles