最初のネイティブLLMは電気通信業界に最適化されました

最初のネイティブLLMは電気通信業界に最適化された

Kineticaは2016年に設立され、陸軍のためにイノベーションイニシアチブを開発し、国家安全保障の脅威を追跡・分析し、リアルタイムの分析を提供するための取り組みを行いました。

現在、彼らはGPUパワードの空間および時系列分析のパイオニアです。Kineticaは、テレコム業界向けの業界初の大規模言語モデルソリューションであるSQL-GPTを発表しました。このイノベーションは、テレコムの専門家が自然な言語でリアルタイムのデータと対話し、実用的な洞察を得ることを目指しています。

KineticaのCMOであるChad Meleyは、「自然言語からSQLへとフロントエンドを実装しました。これにより、テレコムの組織内の誰もが、通信事業者が行う時系列と空間の結合を活用できるようになります」と説明しています。一般的なテレコムデータセットとユースケースに合わせて翻訳された高性能SQLに対する簡単な英語の質問を行うことで、専門的なデータサイエンスのスキルは必要ありません。

例えば、現場の技術者はシステムに単純に「直ちに対応が必要な機器を表示してください」と尋ねることができ、解決すべき問題の優先順位付けリストを即座に取得することができます。

- 「ChatGPTの新たなライバル:Googleのジェミニ」

- ビデオスワップに会おう:対話型意味ポイント対応でビデオの被写体交換をカスタマイズする人工知能フレームワーク

- エンドツーエンドの労働力管理を取得する: Amazon ForecastおよびAWS Step Functions

より早い洞察を得るためのアナリティクスのボトルネックを克服する

その主な利点は、意思決定に貢献する高速な洞察のアクセスを民主化することです。Meleyは、「希少なリソースはデータから価値を得るためのボトルネックです。多くの企業はまだ表面に触れただけです。それゆえ、人々に直接的な質問をする能力を与えることは解放的です。複雑ではなさそうな質問でも、それに答えるためには多くのコードが必要になることがあります。私たちは以前は回答できなかった質問の答えを企業に提供することを可能にしています。」と詳しく説明しています。

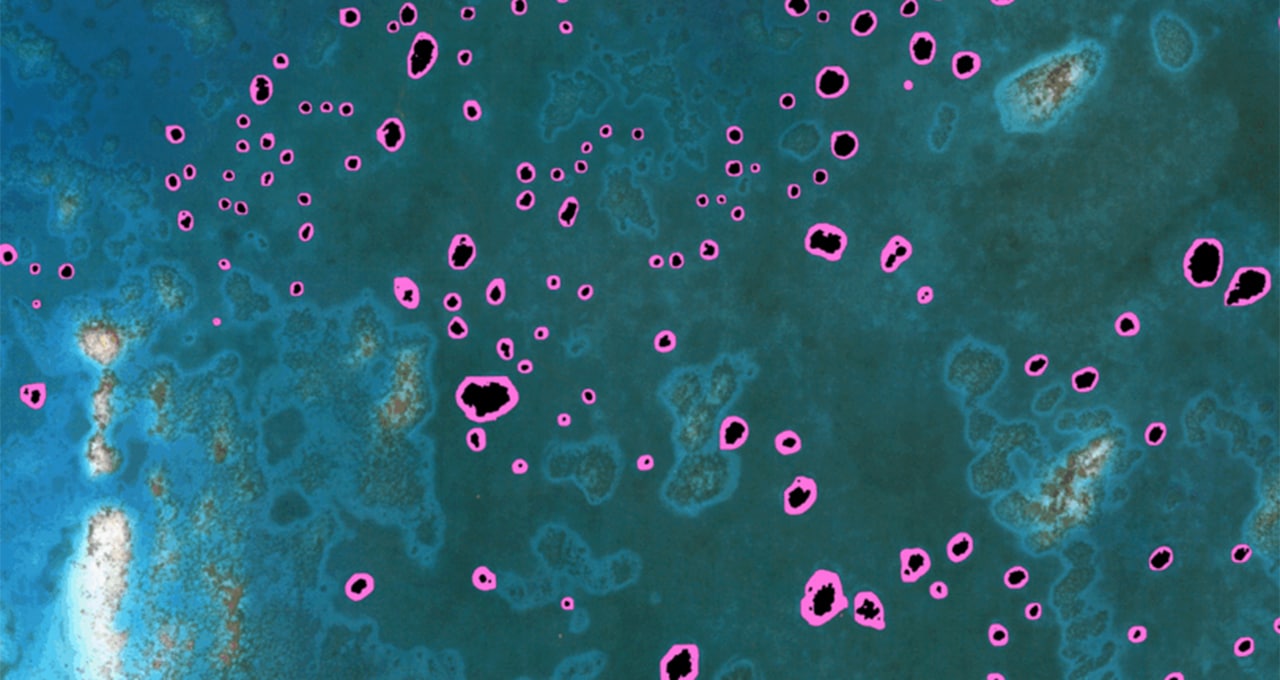

Kineticaの製品VPであるPhil Darringerは、変革的なインサイトへの所要時間を示す顧客の例を提供しました。複雑な地理空間ネットワーク分析では、彼らのソリューションは従来のプラットフォームでは数か月または数年かかるところを30〜45分で結果を提供しました。この大幅な高速化により、顧客に影響を与える前にテルコが新興のネットワーク問題を分析し、対応することが可能になりました。

テルコ業界のデータと専門用語の微調整

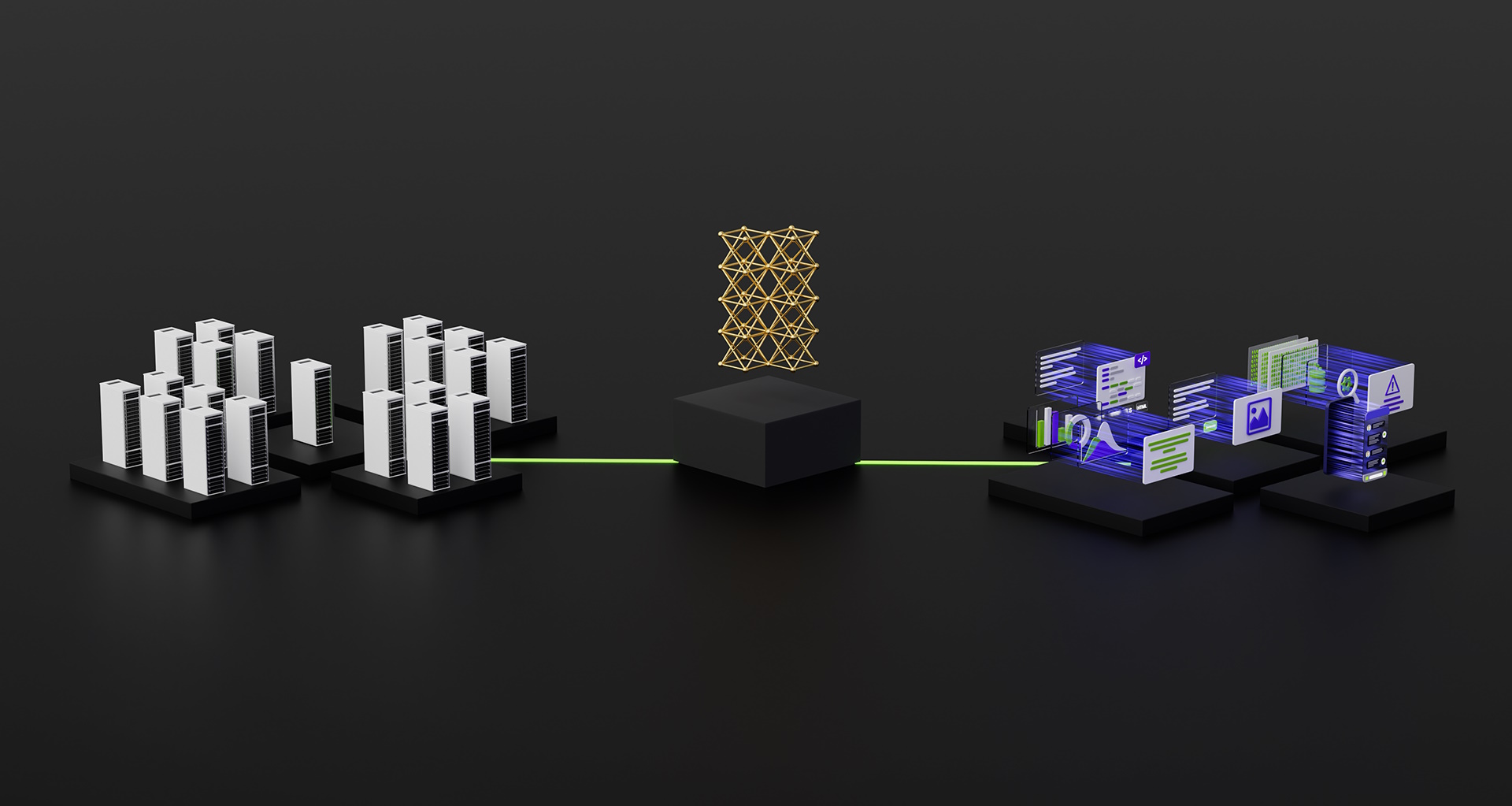

では、SQL-GPTはどのようにこれを実現するのでしょうか? Darringerは、「これにはいくつかのレイヤーがあり、まず基盤モデルから始めます。最初のステップは、Kinetica固有の構文と関数を指示することです。これにより、AIコアがKineticaの機能を学習します。」と説明しています。

「次は、専門用語とテルコに関連するデータセットの知識をもとにこれらの機能を追加していきます。」業界の用語と一般的なテルコのデータスキーマに基づいてモデルをトレーニングすることにより、テルコの実務者が日常的に答える必要がある現実の質問に適した自然な対話が可能となります。

速度と規模に特化した設計

ネットワーク、デバイス、センサからテルコが生成する大量のデータを処理する際に、処理性能とスケールが重要です。Darringerは、「テルコはデータに非常に敏感なため、モデルは彼らの環境に展開されます。それは彼らのデータセンター、またはパブリッククラウド内のVPC、彼ら自身の環境内になるでしょう。」と明確に述べています。

これにより、KineticaのGPUアクセラレーションアーキテクチャを活用しながら、データプライバシーが保護されます。Meleyは、「私たちは、実際にSQLを生成するためにNVIDIAのGPU上で推論を実行しています。それはリクエストの数とそれらがどれくらい頻繁にクエリの生成に使用されるかに比例してスケーリングします。」と述べています。

カスタマイズされたオンプレミス展開は、大規模なパブリック言語モデルに関するテルコのデータ機密性に対する懸念も軽減します。微調整されたモデルを各テルコの環境内で完全に分離することで、データの完全なプライバシーが保持されます。Meleyは、クライアントは「メタデータを含むデータの一部でも、それを公共のAPIに公開したくない」と表現しています。

テレコム向けのSQL-GPTは、自然言語の簡単さとリアルタイムのパフォーマンスを組み合わせて、高度に機密性の高いテルコのデータアセットに対してセキュリティを保証しながらより多くの人々が組織内でデータ分析を行い、ネットワークの品質と顧客満足度を最大化するためのサービス対応を可能にします。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「つながる点 OpenAIの主張されたQ-Starモデルの解明」

- このAI論文は、高品質な3Dセグメンテーションを実現するために、与えられたシーン内の任意のオブジェクトのためのセグメントエニシングのための高品質(SANeRF-HQ)フレームワークを紹介しています

- 「大規模言語モデルをより効率的に最適化できるのか?LLMの効率性に関するアルゴリズムの進化についての包括的な調査をご覧ください」

- 一緒にAIを学ぶ – Towards AI コミュニティニュースレター第4号

- 「大規模言語モデルの微調整方法:ステップバイステップガイド」

- 「GPS ガウシアンと出会う:リアルタイムにキャラクターの新しい視点を合成するための新たな人工知能アプローチ」

- 「Vchitectを紹介します:テキストからビデオ(T2V)およびイメージからビデオ(I2V)アプリケーションに適したオープンソースの大規模一般istビデオ作成システム」