このAI研究は、FireActを提案しますこれは、複数のタスクとエージェントの手法からの軌跡を使用して、言語モデルを微調整するための新しい人工知能の手法です

FireActを提案するAI研究:複数のタスクとエージェントの手法を活用した言語モデルの新たな微調整手法

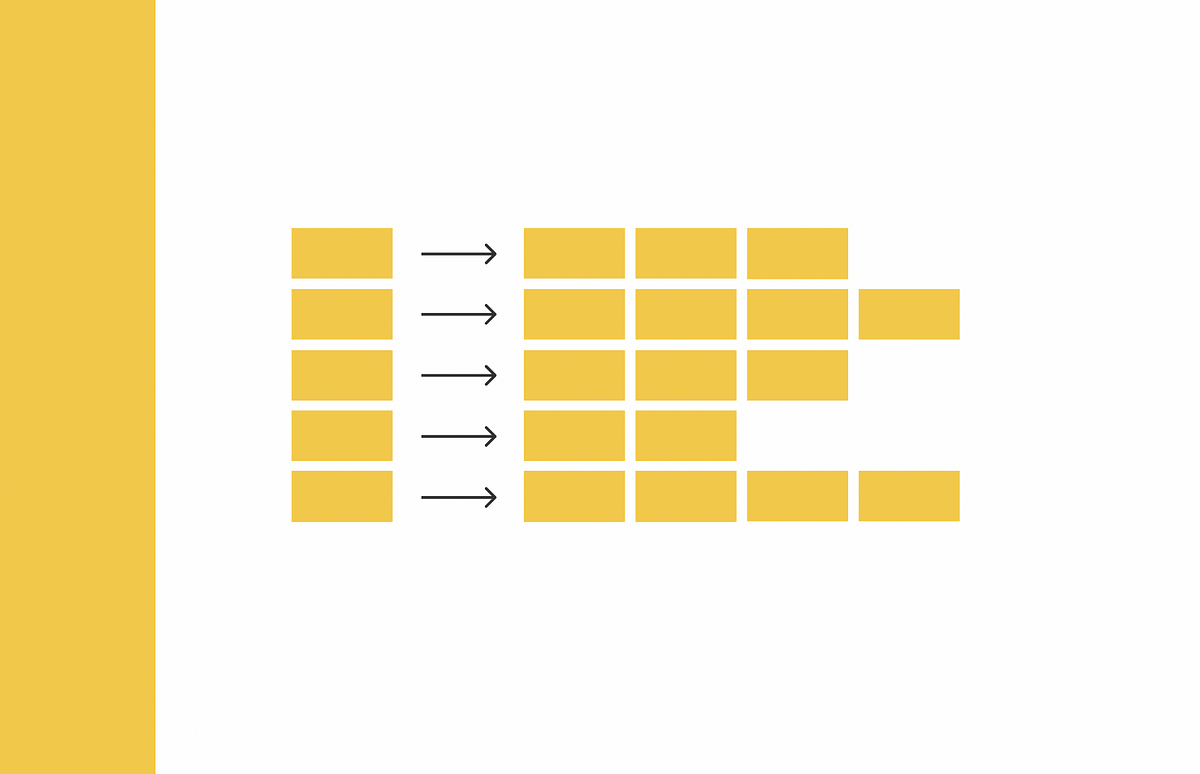

ファインチューニングされた言語モデルは、しばしば言語エージェントを作成する際に軽視され、特にGoogle検索APIを使用して質疑応答の能力を高めることに焦点を当てています。System2 Research、ケンブリッジ大学、モナッシュ大学、およびプリンストン大学の研究者たちは、ファインチューニングされたバックボーン言語モデルがこれらのエージェントのパフォーマンスを一貫して向上させることを示しています。彼らの研究では、複数のタスクや促進手法からの軌道を組み込んだFineActと呼ばれるファインチューニング手法を導入し、多様なファインチューニングデータが言語エージェントの洗練において重要であることを強調しています。

彼らの研究は、言語エージェントとファインチューニングされた事前学習言語モデルの交差点を探っています。先行研究では、言語エージェントとファインチューニングが別々に研究されてきましたが、この研究はそのギャップを埋めるものです。FineActは、言語エージェントのためのファインチューニング手法であり、これらのエージェントにおいて言語モデルのファインチューニングがもたらす利点と結果を系統的に調査しています。彼らの研究には、スケーリング効果、頑健性、汎化性、効率性、およびコストの影響などが含まれ、この新興分野に価値ある洞察を提供しています。

彼らの手法は、これらのエージェントのための言語モデル(LMs)のファインチューニングにおけるより効果的な言語エージェントの必要性に対応しています。既存の言語エージェントは、基本的なLMと限られた数の促進技術に頼っており、パフォーマンスと頑健性の制約があります。実験結果は、LMのファインチューニングがエージェントのパフォーマンスを大幅に高め、推論時間を短縮し、頑健性を向上させることを示しており、実世界の応用に向けた有望な手段となっています。

- アップルとCMUの研究者が新たなUI学習者を披露:連続機械学習を通じてアプリのアクセシビリティを革新

- 「トランスフォーマーは長い入力をどのように扱うのか?CMUとGoogleの研究者が新しいアプローチを発表(FIRE):相対位置エンコーディングのための機能的補間」

- 大規模な言語モデルは本当に行動し思考できるのか?イリノイ大学アーバナ・シャンペーン校の研究者が意思決定の向上のためにLATSを導入

彼らの研究は、Google検索APIを使用した質問応答(QA)での言語エージェントのLMのファインチューニングを探求しています。実験は、LM、データサイズ、ファインチューニング手法に焦点を当て、HotpotQA EMなどの指標を使用してパフォーマンスを評価しています。彼らのアプローチは、従来の促進手法と比べてパフォーマンス、効率性、頑健性、一般化性の向上の利点を示しています。

言語エージェントのLMのファインチューニングによって、HotpotQAパフォーマンスがLlama2-7BおよびGPT-4からの500個のエージェント軌跡を使用して77%向上します。 CoTメソッドは回答の品質を向上させます。混合エージェントメソッドはベースラインの範囲と一致してパフォーマンスを一貫して向上させます。ファインチューニングにより、正確な回答と全体的な回答の品質が向上し、EMスコアとF1スコアに反映された精度が向上します。ただし、F1スコアは4エポックを超えて段階的に減少し、長期的なファインチューニングでは収益の減少が示唆されます。

CoTメソッドの統合によって回答の品質がさらに向上します。ファインチューニングされた複数のタスク軌跡とプロンプトを用いたFireActアプローチは、エージェントのパフォーマンスをさらに向上させます。製品化モデルの固定された一連のタスク解決軌跡、ツールの過剰使用、および逸脱回復の課題など、既存のLMだけに頼る言語エージェントは制約があります。キャリブレーションやメタ論理に関する将来の研究は、ツール使用と反省の課題に対処することでエージェントの設計を改善することができます。

FireActから生じる研究の疑問は、異なるタスク、グラウンディング設定、およびドメインにおける言語エージェントのLMのファインチューニングをさらに拡大することです。APIツールの使用、ウェブの探索、および実世界での統合を網羅した調査が必要です。エージェントのパフォーマンス向上のためには、さまざまなファインチューニングデータソースと技術の探求が重要です。キャリブレーションとメタ論理がエージェントの設計とツールの使用と軌道の逸脱の管理能力に与える影響を取り組むべきです。最後に、拡張性、頑健性、効率性、およびコストの影響の評価には包括的な研究が必要です。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「どのようにして、1ビットのウェイトで大規模な言語モデルを効果的に圧縮できるのか?この人工知能の研究では、PB-LLMを提案しています:部分的にバイナリ化されたLLMの潜在能力を探索する」

- プリンストン大学とメタAIの研究者たちは、長い文脈を要約ノードの木に最初に処理する新しい方法、MemWalkerを導入しました

- マイクロソフトの研究者が「SpaceEvo」を紹介:現実世界のデバイスに対して超効率的で量子化されたニューラルネットワークを設計する画期的なゲームチェンジャー

- カルテックとETHチューリッヒの研究者が画期的な拡散モデルを導入:最先端のビジュアルタスクと異なるドメインへの適応を実現するためのテキストキャプションの活用

- メタ AI 研究者たちは、非侵襲的な脳記録から音声知覚のデコーディングを探求するための機械学習モデルを紹介します

- シャージャ大学の研究者たちは、アラビア語とその方言を自然言語処理に取り入れるための人工知能ソリューションを開発しました

- 「AIが研究論文内の問題のある画像を見つける点で、人間の捜査官を打ち負かす」