「FACTOOLにご紹介いたします:大規模言語モデル(例:ChatGPT)によって生成されたテキストの事実エラーを検出するためのタスクとドメインに依存しないフレームワーク」

FACTOOL A domain-independent framework for detecting factual errors in text generated by large-scale language models (e.g., ChatGPT).

GPT-4は、自然言語処理のいくつかのタスクを1つのシーケンス生成問題に統合した生成型の人工知能(AI)技術の一例です。この統合アーキテクチャは、優れた効率性と対話性を備えており、自然言語インターフェースを使用してコード生成、数学の問題解決、科学論文の作成などのさまざまな活動を実行することができます。ただし、このような生成型のパラダイムには特定の困難もあります。大規模言語モデル(LLM)の制約により、自動生成されたテキストはしばしばエラーや真実からの逸脱を示します。

LLMは説得力のある情報を作成する傾向がありますが、その事実についてはより正確で正確である必要があるかもしれません。この制約により、医療、金融、法律などの高いリスクを伴うさまざまな産業で生成型AIの使用が制限されます。したがって、生成された材料の有用性と信頼性を向上させるために、これらの誤りを体系的に特定することが重要です。たとえば、品質保証のための取得増強検証モデル、テキスト要約のための幻覚検出モデル、およびコードの実行に対する評価モデルなど、機械学習モデルによって生成される事実の誤りを検出および軽減するための現在の文献の焦点となっている特定のタスクがあります。

LLMが処理する活動とドメインの柔軟性の高さを考慮すると、これらのアプローチはそれぞれの分野で成功を収めています。ただし、同様に適応性のあるより包括的な事実性の検出および検証フレームワークも必要です。また、事実性の検出の問題は、現在の文献では次のいずれかの形で簡約されることがしばしばあります。すなわち、(i) 主張が与えられた場合に主張が事実的に正確であるかを評価すること、または(ii) 生成された主張が与えられた証拠によってサポートされているかを検出することです。

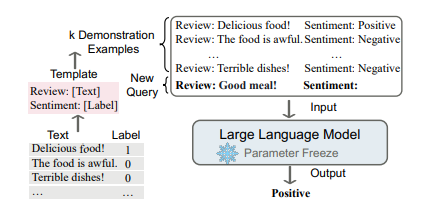

生成型モデル(ChatGPTなど)と関わる際にユーザーが頻繁に行う執筆タスクでは、明示的な主張や証拠がない長文生成の事実性を評価する必要があります。本研究では、上海交通大学、カーネギーメロン大学、香港城市大学、ニューヨーク大学、Meta AI、香港科技大学、上海人工知能研究所の研究者がFACTOOLを提案しています。FACTOOLは、LLMによって生成されたドキュメントの事実誤りを検出するためのタスクおよびドメインに依存しないフレームワークです。利用可能なデータを考慮して、コンテンツの事実性を評価するために、LLMの批判的思考能力を使用します。彼らはベンチマークを作成し、以下の4つのタスクについて実験を行っています:

- 知識ベースの品質保証

- コードの生成

- 数学の問題解決

- 科学文献レビューの執筆

彼らは事実性の識別の仕事に取り組み、最新の生成型AIモデルをより包括的に監査するためにそれを拡張します。さまざまなドメインと活動にわたる事実性の識別のための統一かつ適応可能なフレームワークを提供するために、「ツールの使用」と「事実性の検出」を統合しています。FACTOOLを使用して現代のチャットボットの事実性を分析すると、GPT-4がほとんどの状況で最も高い事実性を持っていることがわかります。KBベースの品質保証テストでは、緻密に調整されたチャットボット(Vicuna-13B)が立派な事実性を持っていることが示されます。ただし、科学文献レビューや算術問題の解答など、より難しいタスクには苦労しています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles