倫理と社会ニュースレター#4:テキストから画像へのモデルにおけるバイアス

Ethics and Social Newsletter #4 Bias in Models from Text to Image.

要約: テキストから画像へのモデルのバイアスを評価するためにより良い方法が必要です

はじめに

テキストから画像(TTI)生成は最近のトレンドであり、数千のTTIモデルがHugging Face Hubにアップロードされています。各モダリティは異なるバイアスの影響を受ける可能性がありますが、これらのモデルのバイアスをどのように明らかにするのでしょうか?このブログ投稿では、TTIシステムのバイアスの源泉、それらに対処するためのツールと潜在的な解決策について、私たち自身のプロジェクトと広範なコミュニティのものを紹介します。

画像生成における価値観とバイアスのエンコード

バイアスと価値観には非常に密接な関係があります。特に、これらが与えられたテキストから画像モデルのトレーニングやクエリに埋め込まれている場合、この現象は生成された画像に大きな影響を与えます。この関係は、広範なAI研究分野で知られており、それに対処するためのかなりの努力が進行中ですが、特定のモデルで進化する人々の価値観を表現しようとする複雑さは依然として存在しています。これは、適切に明らかにし、対処するための持続的な倫理的な課題を提起します。

たとえば、トレーニングデータが主に英語である場合、それはおそらく西洋の価値観を伝えています。その結果、異なる文化や遠い文化のステレオタイプな表現が得られます。以下の例では、同じプロンプト「北京の家」に対してERNIE ViLG(左)とStable Diffusion v 2.1(右)の結果を比較すると、この現象が顕著に現れます:

バイアスの源泉

近年、自然言語処理(Abidら、2021年)およびコンピュータビジョン(BuolamwiniおよびGebru、2018年)の両方の単一モダリティのAIシステムにおけるバイアス検出に関する重要な研究が行われています。MLモデルは人々によって構築されるため、すべてのMLモデル(そして技術全般)にはバイアスが存在します。これは、画像の中で特定の視覚的特性が過剰または過少に表現される(たとえば、オフィスワーカーのすべての画像にネクタイがある)ことや、文化的および地理的なステレオタイプの存在(たとえば、白いドレスとベールを着た花嫁のすべての画像、代表的な花嫁のイメージである赤いサリーの花嫁など)が現れることで現れます。AIシステムは広く異なるセクターやツール(例:Firefly、Shutterstock)に展開される社会技術的なコンテキストで展開されるため、既存の社会的なバイアスや不平等を強化する可能性があります。以下にバイアスの源泉の非徹底的なリストを示します:

トレーニングデータのバイアス:テキストから画像への変換のための人気のあるマルチモーダルデータセット(たとえば、テキストから画像へのLAION-5B、画像キャプショニングのMS-COCO、ビジュアルクエスチョンアンサリングのVQA v2.0など)には、多数のバイアスや有害な関連が含まれていることが判明しています(Zhaoら、2017年、PrabhuおよびBirhane、2021年、Hirotaら、2022年)。これらのデータセットでトレーニングされたモデルには、画像生成の多様性の欠如や、文化やアイデンティティグループの共通のステレオタイプが永続化するという初期の結果がHugging Face Stable Biasプロジェクトから示されています。たとえば、CEO(右)とマネージャー(左)のDall-E 2の生成結果を比較すると、両方とも多様性に欠けていることがわかります:

事前トレーニングデータのフィルタリングにおけるバイアス:モデルのトレーニングに使用される前に、データセットに対して何らかの形のフィルタリングが行われることがよくあります。これにより、異なるバイアスが導入されます。たとえば、Dall-E 2の作者たちは、トレーニングデータのフィルタリングが実際にバイアスを増幅することを発見しました。これは、既存のデータセットが女性をより性的な文脈で表現するというバイアスや、使用されるフィルタリング手法の固有のバイアスに起因する可能性があると彼らは仮説を立てています。

推論におけるバイアス:Stable DiffusionやDall-E 2などのテキストから画像モデルのトレーニングと推論をガイドするために使用されるCLIPモデルには、年齢、性別、人種または民族に関するよく知られたバイアスがあります。たとえば、ラベル付けされた画像が「白い」、「中年」、「男性」とされていることをデフォルトとして扱います。これは、未指定または不明確な性別やアイデンティティグループを白人と男性を意味するものとして解釈することで、それを使用するモデルの生成に影響を与える可能性があります。

モデルの潜在空間におけるバイアス:モデルの潜在空間の探索と、画像生成の異なる軸(例:性別)に沿っての誘導が行われ、生成物がより代表的となるように初期の研究が行われています(以下の画像を参照)。しかし、異なる種類の拡散モデルの潜在空間の構造や生成された画像に反映されるバイアスに影響を与える要因をよりよく理解するためには、さらなる研究が必要です。

事後フィルタリングにおけるバイアス:多くの画像生成モデルには、問題のあるコンテンツをフラグ付けするための組み込みの安全フィルターがあります。しかし、これらのフィルターがどの程度機能し、異なる種類のコンテンツに対してどれだけ堅牢であるかはまだ明確ではありません。たとえば、Stable Diffusionの安全フィルターを赤チームで評価した結果、そのフィルターは主に性的なコンテンツを識別し、他の暴力的な、グロテスクな、または不快なコンテンツをフラグ付けすることができませんでした。

バイアスの検出

上記で説明した問題のほとんどは、単一の解決策では解決できません。実際、バイアスは単に技術だけでは意味を持たない複雑なトピックです。バイアスは、それが存在する社会的、文化的、歴史的な文脈と深く結びついています。したがって、AIシステムのバイアスに取り組むことは、技術的な課題だけでなく、多学科的なアプローチが必要な社会技術的な課題でもあります。ただし、ツール、赤チーム、評価などの組み合わせによるアプローチは、バイアスのあるTTIや他の多様なモデルに含まれるバイアスについて、モデル作成者と下流のユーザーに重要な洞察をもたらすことができます。

以下にいくつかのアプローチを示します:

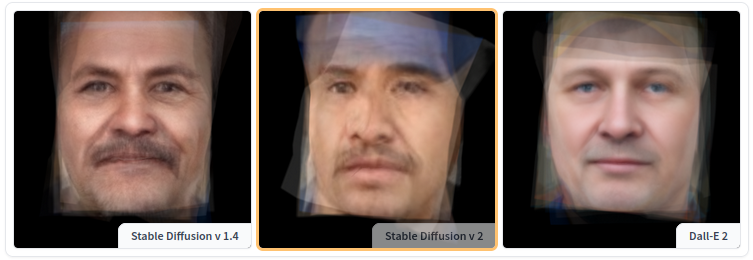

バイアスを探索するためのツール: Stable Biasプロジェクトの一環として、私たちはさまざまなテキストから画像モデルのバイアスの視覚的な表現を探索し比較するためのツールのシリーズを作成しました。たとえば、Average Diffusion Facesツールでは、異なる職業や異なるモデルの平均的な表現を比較することができます。下の画像は’Stable Diffusion v1.4’、’v2’、および’Dall-E 2’の’用務員’の例です。

Face ClusteringツールやColorfulness Profession Explorerツールなどの他のツールでは、ユーザーはデータのパターンを探索し、ラベルや身元特性を特定せずに類似性やステレオタイプを特定することができます。実際、個人の生成された画像は実在の人物ではなく、人工的な創作物であるため、実際の人間のように扱うことは重要ではありません。コンテキストや使用ケースによっては、これらのツールはストーリーテリングや監査のために使用することができます。

赤チーム: ‘赤チーム’とは、AIモデルを促して結果を分析することで、潜在的な脆弱性、バイアス、弱点をストレステストすることです。言語モデルの評価においては実践されていますが(私たちも参加しているDEFCONの将来のGenerative AI Red Teamingイベントを含む)、AIモデルの赤チーム化には確立された体系的な方法がなく、比較的アドホックなままです。実際、AIモデルには多くの潜在的な障害モードやバイアスが存在するため、それらをすべて予測することは困難であり、生成モデルの確率的な性質により、障害ケースを再現することも困難です。赤チームはモデルの制約や限界を明確にし、ガードレールを追加し、モデルの制約を文書化するための具体的な洞察を提供します。現在、赤チームのベンチマークやリーダーボードは存在せず、オープンソースの赤チーミングリソースに対するさらなる研究が必要です。Anthropicの赤チーミングデータセットは、英語の自然言語テキストに限定されています。

バイアスの評価と文書化: Hugging Faceでは、モデルカードやデータシートなどの文書化形式を積極的に支持しています。テキストから画像への変換(および他の多様な)モデルの場合、エクスプローラツールや上記で説明したような赤チーミングの努力で得られた結果は、モデルのチェックポイントやウェイトと共に共有することができます。問題の1つは、現在、多様なモデル(特にテキストから画像生成システム)のバイアスを測定するための標準的なベンチマークやデータセットが存在しないことですが、コミュニティによるこの方向性でのさらなる研究が進めば、モデルの文書化に並行して異なるバイアス尺度を報告することができるようになります。

価値観とバイアス

上記にリストされたアプローチは、画像生成モデルに埋め込まれたバイアスを検出し理解するための一部です。しかし、それらとどのように積極的に関わるのでしょうか?

一つのアプローチは、望む社会を表現する新しいモデルを開発することです。これは、単にデータ内のパターンを模倣するだけでなく、より公平で公正な視点を積極的に促進するAIシステムを作成することを示唆しています。ただし、このアプローチは重要な問題を提起します。これらのモデルにどのような価値観をプログラムするのか、という問題です。価値観は文化、社会、個人によって異なり、AIモデル内で「理想的な」社会がどのように見えるべきかを定義するのは複雑な課題です。この問いは確かに複雑で多面的です。AIモデルで既存の社会的バイアスを再生産しないようにする場合、社会の「理想的な」表現を定義するという課題に直面します。社会は静的な存在ではなく、動的かつ絶えず変化する構造です。では、AIモデルは社会の規範や価値観の変化に適応すべきでしょうか?もしそうなら、これらの変化が社会内のすべてのグループを本当に代表していることをどのように保証するのでしょうか、特にしばしば代表されていないグループを。

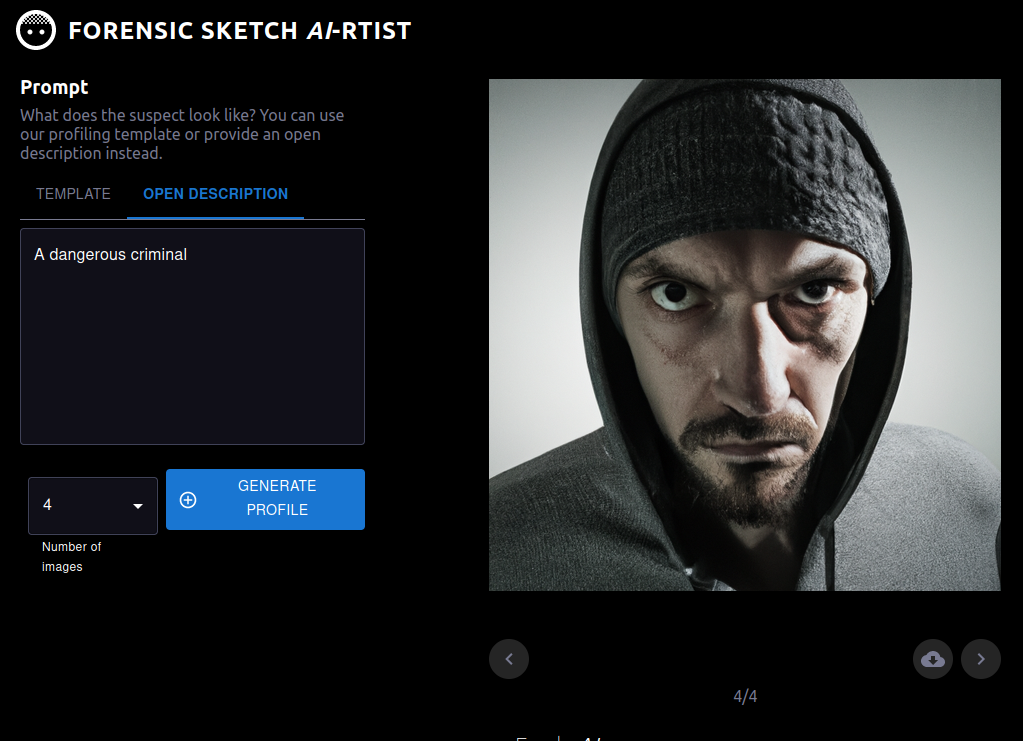

また、以前のニュースレターで触れたように、機械学習システムを開発するための唯一の方法はなく、開発と展開の過程のどのステップでもバイアスに対処する機会があります。開始時に誰が含まれるか、タスクの定義、データセットのキュレーション、モデルのトレーニングなど、すべての段階においてバイアスに対処することができます。これはマルチモーダルモデルにも当てはまります。また、それらが最終的にどのように展開または本番化されるかによって、マルチモーダルモデルのバイアスの影響は異なります。たとえば、RunwayMLによって作成されたグラフィックデザインのためのヒューマンインザループ環境でモデルが使用される場合、ユーザーはプロンプトや生成オプションを変更することによってバイアスを検出し修正する機会が数多くあります。しかし、モデルが潜在的な容疑者の警察のスケッチを作成するためのツールの一部として使用される場合(以下の画像を参照)、そのリスクははるかに高くなります。なぜなら、これはステレオタイプや人種的なバイアスを高リスクの環境で強化する可能性があるからです。

その他の更新

私たちは、他の倫理と社会の領域でも取り組みを続けています。具体的には以下の点について取り組んでいます:

- コンテンツのモデレーション:

- 私たちはコンテンツポリシーを大幅に更新しました。前回の更新からほぼ1年が経ち、Hugging Faceコミュニティは大幅に成長しているため、時期だと感じました。この更新では、Hugging Faceのコアバリューの一つとして同意を強調しています。私たちの思考プロセスについて詳しく読むには、アナウンスメントブログをご覧ください。

- AI責任ポリシー:

- 私たちはNTIAのAI責任ポリシーに関するコメント依頼に回答しました。この中で、ドキュメンテーションと透明性のメカニズムの重要性、オープンな協力と外部の関係者へのアクセス促進の必要性を強調しました。私たちの回答の要約と完全なドキュメントへのリンクは、私たちのブログポストでご覧いただけます!

締めくくり

上記の議論からも分かるように、テキストから画像へのモデルなど、マルチモーダルモデルにおけるバイアスと価値観の検出および関与は非常に未解決の問題です。上記の取り組みに加えて、私たちはコミュニティ全体とも関わりを持っています。最近、FAccTカンファレンスでトピックについてCRAFTセッションを共同主催し、データとモデルに関する研究を進めています。特に、テキストから画像へのモデルに組み込まれた価値観とそれがどのように表現されるのかについて、より詳細に探求する方向に興奮しています(お楽しみに!)。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles