「機械学習リスク管理のための文化的な能力」

Culture for Machine Learning Risk Management

組織の文化は責任あるAIの重要な側面です。

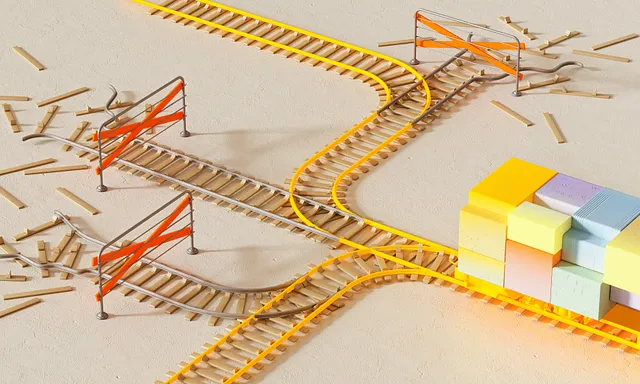

人工知能(AI)が搭載されたシステムが間違いを comit しない世界を想像してみてください。彼らがミスなくタスクを実行し続ける姿勢です。SFの夢のようなものですよね。AIの現実の世界へようこそ、そこでは常に計画通りにはいかないことがあります。責任あるAIの実践の重要な部分は、私たちが「AIインシデント」と呼ぶものを防止し、対処することです。この記事では、責任あるAIの実践を促進する概念を中心に、AIインシデントを防止し軽減することができる文化的な能力について説明します。その後、関連するビジネスプロセスについては、将来の記事で網羅的な視点を提供します。

シリーズに関する注意事項

このシリーズに取り組むにあたり、文脈を提供することが重要です。私は、Patrick HallとJames Curtisと共同執筆した「高リスクアプリケーションのための機械学習」という本の共著者の一人です。このシリーズは、本の広範な内容のわかりやすい読者向けの補完として設計されています。各記事では、本で提供された重要な洞察、概念、実践戦略を簡潔にまとめて、広範な読者に知識を提供することを目指しています。

AIインシデントの定義

MLの安全性に踏み込む前に、AIインシデントに対処することは重要です。理解していないものを効果的に軽減することはできません。AIインシデントとは、潜在的に害を引き起こす可能性のあるAIシステムから生じる結果を指します。これらのインシデントの深刻度は、それらが引き起こす損害の程度に応じて自然に異なります。これらのインシデントは、モールのセキュリティロボットが階段から転落するなどの比較的軽微な不便さから、自動運転車が歩行者の死亡事故や医療資源の大規模な転用などのより重大な事件まで様々です。

AIインシデントとは、潜在的に害を引き起こす可能性のあるAIシステムから生じる結果を指します。

AIインシデントは、主に次の3つのグループに分類できます :

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles