「脱拡散を用いたLLMsにおける強力なクロスモーダルインターフェースのための情報豊富なテキストの生成」

「情報満載なテキスト生成による脱拡散を活用したLLMsにおける強力なクロスモーダルインターフェース」

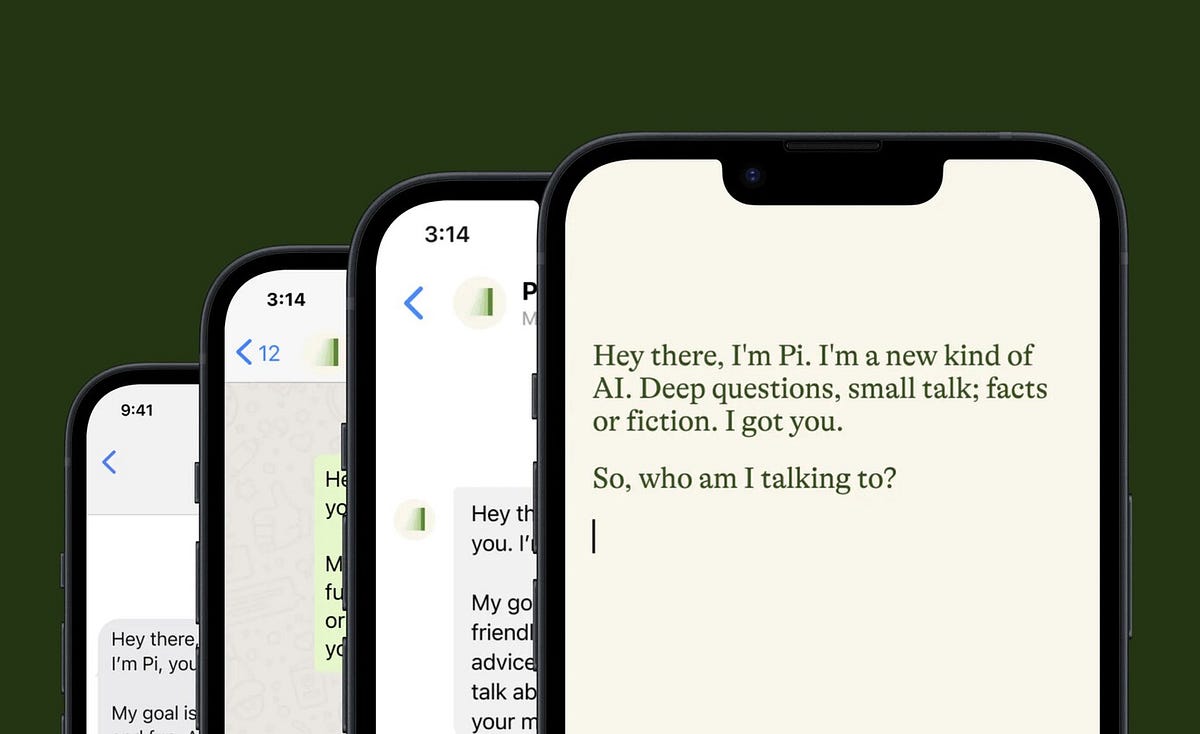

世界的な現象であるLLM(Large Language Model)製品の例として、ChatGPTの広範な採用が注目されています。LLMは自然言語会話を理解し、人間のクリエイティブなタスクを支援する上での利点について、多くの人々の間で一致が生まれています。しかし、この認識にもかかわらず、これらのテクノロジーの進化の先にはどのような展望があるのでしょうか?

顕著な傾向として、画像、動画、音声など、さまざまなモダリティを理解するためのモデルへのシフトが示されています。優れた画像理解能力を持つマルチモーダルモデルであるGPT-4が最近発表され、オーディオ処理能力も付属しています。

ディープラーニングの登場以来、クロスモーダルなインタフェースではしばしばディープエンベディングが使われてきました。これらのエンベディングは、自己符号化器としてトレーニングされた際に画像ピクセルを保持する能力を備えており、最近のモデル(CLIPなど)によって示されているように、意味のある内容を実現することもできます。音声とテキストの関係を考えると、テキストは直感的なクロスモーダルなインタフェースとして自然に機能し、しばしば見落とされがちです。音声オーディオをテキストに変換することにより、コンテンツは効果的に保持され、成熟したテキスト読み上げ技術を使用して音声オーディオを再構築することができます。さらに、転写されたテキストは必要なすべての意味情報を具備していると考えられています。類推して言えば、画像をテキストに同様に「転写」することができます。これは一般的には画像キャプションと呼ばれるプロセスです。ただし、典型的な画像キャプションは内容の保持には短所があり、精度を重視する傾向があります。画像キャプションは、幅広い視覚的な問い合わせに対応するのに苦労しています。

- 「プロンプトエンジニアリングによるAIの潜在能力の解放」

- IIoTとAI:工業の風景を変革するシナジスティックなシンフォニー

- オルカ2の内部:Microsoftが小さな言語モデルに推論を教えるための新しい方法を紹介

画像キャプションの制約にもかかわらず、正確かつ包括的なテキストが実現可能である場合、直感的にも実用的にも有望な選択肢となります。実用的な観点からは、テキストはLLMにとってネイティブな入力ドメインとなります。テキストの使用により、ディープエンベディングとしばしば関連付けられる適応トレーニングの必要性がなくなります。トップパフォーマーのLLMのトレーニングと適応の手間が膨大なコストとなることを考えると、テキストのモジュラーデザインはより多くの可能性を開放します。では、どのようにして画像の正確で包括的なテキスト表現を達成できるのでしょうか?解決策は、古典的なオートエンコーディングのテクニックに頼ることにあります。

従来のオートエンコーダーとは異なり、採用されたアプローチでは、デコーダーとして事前トレーニングされたテキストから画像への変換モデルを使用し、テキストを自然な潜在空間として扱います。エンコーダーは入力画像をテキストに変換するためにトレーニングされ、その後、テキストをテキストから画像への変換モデルに入力して元の入力を再構築します。再構築エラーを最小化することを目的としており、潜在的なテキストが入力画像の「ばらばらのキャプション」として組み合わされる場合でも、正確かつ包括的であることが求められます。

最近のテキストから画像への生成モデルの進歩により、複雑な文章(10語以上)を非常に詳細なイメージに変換する能力が顕著に示されています。これにより、これらの生成モデルが複雑なテキストを視覚的に整合した出力に処理する能力が備わっていることが示されています。デコーダーとしてこのような生成的なテキストから画像モデルを組み込むことで、最適化されたエンコーダーはテキストの広範な潜在空間を探索し、生成モデルに内包された豊富なビジュアル-言語知識を明らかにします。

これらの発見に支えられ、研究者たちはDe-Diffusionというオートエンコーダーを開発し、テキストを堅牢なクロスモーダルインタフェースとして利用しています。そのアーキテクチャの概要は以下のとおりです。

De-Diffusionにはエンコーダーとデコーダーが含まれています。エンコーダーは入力画像を説明的なテキストに変換するためにトレーニングされ、そのテキストは固定された事前トレーニング済みのテキストから画像への拡散デコーダーに供給され、元の入力を再構築します。

提案された手法の実験により、De-Diffusionによって生成されたテキストは、画像の意味的な概念を巧みに捉えることができると確認され、テキストプロンプトとして使用する際にさまざまなビジョン-言語アプリケーションを実現できることが示されました。 De-Diffusionテキストは、さまざまなテキストから画像へのツールのプロンプトとして転用可能な汎化能力を持っています。再構築FIDを使用した定量的評価では、De-Diffusionテキストは、人間の注釈付きキャプションに比べて第三者のテキストから画像モデルへのプロンプトとして有意に優れています。さらに、De-Diffusionテキストは、数少ないタスク固有の例をプロンプトとして提供するだけで、オフシェルフのLLMを使用してオープンエンドのビジョン-言語タスクを実行することを容易にします。これらの結果は、De-Diffusionテキストが人間の解釈とさまざまなドメイン間のさまざまなオフシェルフモデルを効果的に結びつけることを示しています。

これはDe-Diffusionの要約であり、入力画像を豊かな情報を持つテキストに変換する新しいAI技術です。このテキストはさまざまなモダリティ間で柔軟なインターフェースとして機能し、多様な音声、映像、言語のアプリケーションを可能にします。興味がある場合は、以下に引用されたリンクを参照して詳細を学ぶことができます。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- インドのOla CEO、ブハビッシュ・アガルワルがAI開発に進出します

- 「One-2-3-45++に出会ってみましょう:おおよその1分で単一の画像を詳細な3Dテクスチャメッシュに変換する革新的な人工知能手法」

- 中国からのこのAI論文では、「モンキー」という新しい人工知能のアプローチが紹介されていますこれは、大規模なマルチモーダルモデルで入力の解像度と文脈関連性を向上させるための方法です

- 『LEOと出会いましょう:先進的な3Dワールドインタラクションとタスクソルビングのための画期的なエンボディードマルチモーダルエージェント』

- 「スロープ・トランスフォーマーに出会ってください:銀行の言語を理解するために特別に訓練された大規模な言語モデル(LLM)」

- 新しいNVIDIA GPUベースのAmazon EC2インスタンスを3つ紹介します

- 「前方予測デコーディング」:LLM推論を加速するための並列デコーディングアルゴリズム