「会話型AIのLLM:よりスマートなチャットボットとアシスタントの構築」

Conversational AI LLM Building Smarter Chatbots and Assistants

イントロダクション

言語モデルは、技術と人間が自然な会話を行う魅力的なConversational AIの世界で中心的な役割を果たしています。最近、Large Language Models(LLMs)という注目すべきブレークスルーがありました。OpenAIの印象的なGPT-3のように、LLMsは人間のようなテキストを理解し生成するという非凡な能力を示しています。これらの素晴らしいモデルは、特によりスマートなチャットボットやバーチャルアシスタントの作成において、ゲームチェンジャーとなりました。

このブログでは、LLMsがConversational AIにどのように貢献しているかを探求し、その潜在能力を示すための理解しやすいコード例を提供します。さあ、LLMsが仮想的なインタラクションをより魅力的で直感的にする方法を見てみましょう。

学習目標

- Large Language Models(LLMs)の概念と、Conversational AIの能力向上における重要性を理解する。

- LLMsがチャットボットやバーチャルアシスタントが人間のようなテキストを理解し生成することを可能にする方法を学ぶ。

- プロンプトエンジニアリングの役割を探求し、LLMベースのチャットボットの動作をガイドする。

- 伝統的な方法に比べてLLMsの優位性を認識し、チャットボットの応答を改善する。

- LLMsを活用したConversational AIの実用的な応用を発見する。

この記事はData Science Blogathonの一部として公開されました。

- ソースフリーのドメイン適応における壁の破壊:バイオアコースティクスとビジョン領域へのNOTELAの影響

- BTSの所属レーベルHYBEがAIを活用して複数言語でトラックをリリースすることを目指す

- 「9歳の子に機械学習を説明するとしたら、どうやって説明しますか?」

Conversational AIの理解

Conversational AIは、人工知能の革新的な分野であり、自然で人間らしい方法で人間の言語を理解し応答する技術の開発に焦点を当てています。自然言語処理や機械学習などの高度な技術を使用して、Conversational AIはチャットボット、バーチャルアシスタント、その他の対話システムを能動的でインタラクティブな対話に参加させることができます。これらのインテリジェントシステムは、ユーザーのクエリを理解し、関連する情報を提供し、質問に答えるだけでなく、複雑なタスクも実行することができます。

Conversational AIは、顧客サービス、医療、教育、エンターテイメントなど、さまざまな領域で応用され、人間が技術と対話する方法を革新し、より共感的で個別化された人間とコンピュータのインタラクションの新たなフロンティアを開拓しています。

言語モデルの進化:ルールベースのチャットボットからLLMsへ

過去、チャットボットやバーチャルアシスタントとの対話は、ロボット的でイライラするものでした。これらのルールベースのシステムは、事前に定義されたスクリプトに従って動作し、開発者によってプログラムされた特定のキーワードと応答に依存していました。同時に、よくある質問に答えるといった重要な機能を果たしていましたが、文脈を理解する能力の欠如により、対話は硬直的で限定的に感じられました。

ルールベースのチャットボット時代

言語モデルの旅は、ルールベースのチャットボットから始まりました。これらの初期のチャットボットは、事前に定義されたルールとパターンに基づいて動作し、特定のキーワードと応答に頼っていました。同時に、よくある質問に答えるなどの重要な機能を果たしましたが、文脈を理解する能力の欠如により、対話は硬直的で限定的に感じられました。

統計的言語モデルの台頭

技術の進歩とともに、統計的言語モデルが登場しました。これらのモデルは、統計的アルゴリズムを使用して大規模なテキストデータセットを分析し、データからパターンを学習しました。このアプローチにより、チャットボットはより幅広い範囲の入力を処理し、わずかに文脈に関連する応答を提供することができるようになりました。しかし、彼らはまだ人間の言語の複雑さを捉えることに苦労し、非自然で切り離された応答を引き起こすことがよくありました。

トランスフォーマーベースのモデルの台頭

真のブレークスルーは、革命的なGPT(Generative Pre-trained Transformer)シリーズを含むトランスフォーマーベースのモデルの出現と共に訪れました。GPT-3は、Conversational AIにおいてゲームチェンジャーとなりました。インターネットの大量のテキストで事前にトレーニングされたGPT-3は、ディープラーニングとアテンションメカニズムの力を利用して、文脈、構文、文法、さらには人間のような感情まで理解することができました。

大規模言語モデルの理解

GPT-3(Generative Pre-trained Transformer 3)など、洗練されたニューラルネットワークを持つLLMsは、マシンが人間の言語を理解し処理する方法において、画期的な変革をもたらしました。これらの言語モデルは、数百万、時には数十億ものパラメータを持つことで、従来の自然言語処理(NLP)の限界を超え、新たな可能性の世界を開拓しました。

LLMアーキテクチャ

Large Language Model(LLM)アーキテクチャは、2017年にVaswaniらによって発表された「Attention is All You Need」という論文で紹介されたTransformerモデルに基づいています。Transformerアーキテクチャは、テキストの並列化能力と長距離依存関係の効率的な処理能力により、自然言語処理のタスクを革新しました。

LLMアーキテクチャの重要なコンポーネント

LLMアーキテクチャの重要なコンポーネントは以下の通りです:

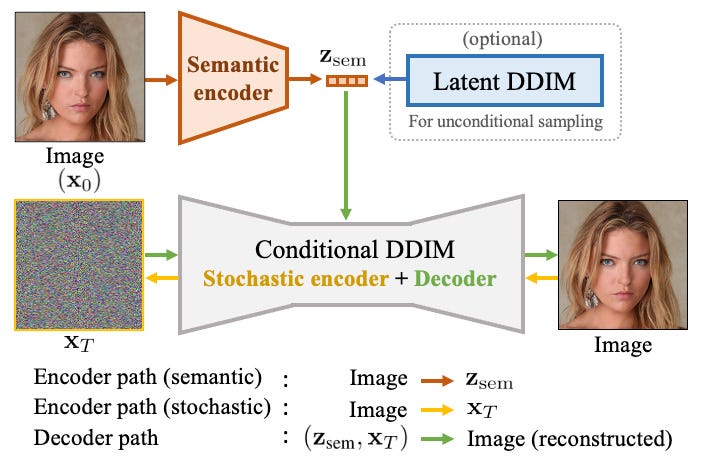

- エンコーダー・デコーダー構造: LLMアーキテクチャは、エンコーダーとデコーダーの2つの主要な部分から構成されています。エンコーダーは入力テキストを取り込み、テキストの意味と文脈を捉えた表現を作成します。デコーダーはこれらの表現を使用して出力テキストを生成します。

- セルフアテンションメカニズム: セルフアテンションメカニズムは、Transformerモデルの中核です。これにより、モデルは各単語を処理しながら、文中の異なる単語の重要性を重み付けすることができます。モデルは関連する用語に注意を向け、それらにより多くの重みを与えることで、より重要な情報に集中することができます。これにより、文脈の理解が向上します。

- マルチヘッドアテンション: Transformerは複数のセルフアテンション層、それぞれを「ヘッド」と呼びます。マルチヘッドアテンションにより、モデルはテキストの異なる側面を捉え、単語間の多様な関係を学習することができます。これにより、モデルは異なる視点から情報を処理する能力が向上し、パフォーマンスが向上します。

- フィードフォワードニューラルネットワーク: セルフアテンション層の後には、Transformerには表現をさらに処理するためのフィードフォワードニューラルネットワークが含まれています。これらのニューラルネットワークはモデルに深さを加え、データ内の複雑なパターンや関係を学習することができます。

- 位置エンコーディング: Transformerは単語の順序を持っていないため、位置エンコーディングが導入されています。これにより、入力シーケンス内の単語の位置を伝えることができます。これにより、モデルはテキストの連続性を理解することができます。これは言語理解のタスクにとって重要です。

- レイヤーノーマライゼーションと残差接続: LLMは、レイヤーノーマライゼーションとレイヤー間の残差接続を利用して、トレーニングプロセスを安定化させ、高速化させます。残差接続は情報の層間の流れを容易にし、レイヤーノーマライゼーションは活性化を正規化し、安定かつ効率的なトレーニングを実現します。

大規模言語モデルの多様性を引き出す

大規模言語モデルの真の能力は、さまざまな言語関連のタスクにおいて試されたときに明らかになります。テキスト補完などの簡単なタスクから、機械翻訳などの高度に複雑な課題まで、GPT-3とその仲間たちはその力を証明しています。

1. テキスト補完

モデルに不完全な文が与えられ、その文脈に適切に合う単語を埋めるというタスクを想像してください。事前トレーニングで蓄積された知識のおかげで、LLMは与えられた文脈にシームレスに適合する最も可能性の高い単語を予測することができます。

これは「complete_text」というPython関数を定義しています。この関数はOpenAI APIを使用してGPT-3言語モデルとテキストを補完し、コンテキストと指定されたパラメータに基づいて補完を生成します。GPT-3をテキスト生成タスクに効果的に活用する方法を簡潔に示しています。

def complete_text(prompt, max_tokens=50, temperature=0.7):

response = openai.Completion.create(

engine="text-davinci-002",

prompt=prompt,

max_tokens=max_tokens,

temperature=temperature,

n=1,

)

return response.choices[0].text.strip()

# 使用例

text_prompt = "昔々、遠い遠い国で、勇敢な騎士がいました。"

completed_text = complete_text(text_prompt)

print("補完されたテキスト:", completed_text)2. 質問応答

LLMの文脈理解能力がここで活躍します。モデルは質問と提供された文脈を分析し、質問に対して正確で関連性のある回答を生成します。これには、顧客サポート、教育ツール、情報検索など、広範な影響があります。

これは「ask_question」というPython関数を定義しています。この関数はOpenAI APIとGPT-3を使用して質問応答を行い、質問とコンテキストを入力として受け取り、コンテキストに基づいて回答を生成し、応答を返します。GPT-3を質問応答タスクに効果的に活用する方法を示しています。

def ask_question(question, context):

response = openai.Completion.create(

model="text-davinci-002",

question=question,

documents=[context],

examples_context=context,

max_tokens=150,

)

return response['answers'][0]['text'].strip()

# 使用例

context = "対話型AIは、人間と技術との相互作用の方法を革新しました。"

question = "人間の相互作用を革新したものは何ですか?"

answer = ask_question(question, context)

print("回答:", answer)3. 翻訳

LLMは文脈的な意味の理解により、正確な言語翻訳を実行することができます。異なる言語の微妙なニュアンスを把握し、より自然で文脈に即した翻訳を保証します。

これはPythonの関数である「translate_text」という関数を定義しています。この関数はOpenAI APIとGPT-3を使用してテキストの翻訳を行います。テキストの入力と目標言語を引数に取り、提供されたコンテキストに基づいて翻訳されたテキストを生成し、結果を返します。これにより、GPT-3を言語翻訳のタスクに活用する方法を示しています。

def translate_text(text, target_language="es"):

response = openai.Completion.create(

engine="text-davinci-002",

prompt=f"以下の英語のテキストを{target_language}に翻訳してください:'{text}'",

max_tokens=150,

)

return response.choices[0].text.strip()

# 使用例

source_text = "Hello, how are you?"

translated_text = translate_text(source_text, target_language="es")

print("翻訳されたテキスト:", translated_text)4. 言語生成

LLMの最も魅力的な機能の一つは、つながりのある文脈に即したテキストの生成能力です。このモデルは、創造的なストーリーの執筆からコードスニペットの開発まで、さまざまなアプリケーションにおいて多目的かつ価値のあるパートナーとなることができます。

提供されたコードは、Pythonの関数である「generate_language」という関数を定義しています。この関数はOpenAI APIとGPT-3を使用して言語生成を行います。プロンプトを入力として受け取り、指定されたコンテキストとパラメータに基づいて言語の出力を生成します。これにより、GPT-3を創造的なテキスト生成タスクに活用する方法を示しています。

def generate_language(prompt, max_tokens=100, temperature=0.7):

response = openai.Completion.create(

engine="text-davinci-002",

prompt=prompt,

max_tokens=max_tokens,

temperature=temperature,

n=1,

)

return response.choices[0].text.strip()

# 使用例

language_prompt = "魔法の王国についての物語を教えてください"

generated_language = generate_language(language_prompt)

print("生成された言語:", generated_language)LLMの例

自然言語処理と会話型AIの分野で重要な影響を与えた多くの大規模言語モデル(LLM)が存在します。その中には以下のものがあります:

1. GPT-3, Generative Pre-trained Transformer 3

OpenAIによって開発されたGPT-3は、有名で影響力のあるLLMの一つです。1750億のパラメータを持ち、翻訳、質問応答、テキスト補完、創造的な文章作成など、さまざまな言語のタスクを実行することができます。GPT-3は、高度につながりがあり文脈に即した応答を生成する能力で人気を博し、会話型AIにおいて重要なマイルストーンとなっています。

2. BERT, Bidirectional Encoder Representations from Transformers

Google AIによって開発されたBERTは、自然言語理解の分野で重要な進歩をもたらしたもう一つの影響力のあるLLMです。BERTは双方向のトレーニングの概念を導入し、単語の左右の文脈を考慮することで、言語の意味論をより深く理解することができます。

3. RoBERTa, A Robustly Optimized BERT Pre-training Approach

Facebook AIによって開発されたRoBERTaは、BERTの最適化されたバージョンであり、トレーニングプロセスを改良してパフォーマンスを向上させました。より大規模なデータセットでより多くのトレーニングステップを行うことで、より良い結果を達成しています。

4. T5, Text-to-Text Transfer Transformer

Google AIによって開発されたT5は、すべての自然言語タスクをテキストからテキストへの問題として扱う、多目的なLLMです。タスクを統一的にテキスト生成タスクとして扱うことで、さまざまなドメインで一貫した印象的な結果を実現します。

5. BART, Bidirectional and Auto-Regressive Transformers

Facebook AIによって開発されたBARTは、事前トレーニングのためのノイズ除去オートエンコーダを双方向および自己回帰手法の強みと組み合わせたものです。テキスト生成やテキスト要約など、さまざまなタスクで強力なパフォーマンスを発揮しています。

LLMによる会話型AIの強化

LLMは、会話型AIシステムを大幅に向上させ、チャットボットや仮想アシスタントがユーザーとより自然で文脈を理解した意味のある会話を行えるようにしました。従来のルールベースのチャットボットとは異なり、LLMを活用したボットは、さまざまなユーザーの入力に適応し、微妙なニュアンスを理解し、関連する回答を提供することができます。これにより、より個人化された楽しいユーザーエクスペリエンスが実現されています。

従来のチャットボットの制限

過去にチャットボットと対話することは、あらかじめプログラムされた機械と話しているような感じがしました。これらのルールベースのボットは、厳格なコマンドと定義済みの応答に依存しており、人間の言語の微妙なニュアンスに適応することができませんでした。ユーザーはしばしば行き詰まりにあたり、ボットがクエリを理解できないことにイライラし、最終的には満足のいく体験を得ることができませんでした。

LLMの登場 – ゲームチェンジャー

GPT-3などの大規模言語モデルは、会話型AIにおいてゲームチェンジャーとして現れました。これらの高度なAIモデルは、インターネットからの膨大な量のテキストデータで訓練されており、言語のパターン、文法、文脈、さらには人間のような感情まで理解する能力があります。

文脈理解の力

従来のボットとは異なり、LLMを活用したチャットボットや仮想アシスタントは、会話全体の文脈を保持することができます。ユーザーの入力、以前の質問、応答を覚えており、より魅力的で一貫した対話が可能です。この文脈理解により、LLMを活用したボットは適切に応答し、より洞察に富んだ回答を提供することができ、対話の連続性と自然な流れを促進します。

ユーザーのニュアンスに適応する

LLMは、同義語、慣用句、口語など、人間の言語の微妙なニュアンスを理解する能力を持っています。この適応性により、質問のフレーズの違いに関係なく、さまざまなユーザーの入力を処理することができます。その結果、ユーザーは特定のキーワードに依存する必要がなく、厳密な構文に従う必要もなくなり、対話がより自然で努力を要しないものになります。

会話型AIにLLMを活用する

LLMを会話型AIシステムに統合することで、知的なチャットボットや仮想アシスタントを作成するための新たな可能性が開かれます。以下は、このコンテキストでLLMを使用することの主な利点です。

1. 文脈理解

LLMは、会話の文脈を理解することに優れています。会話の履歴全体を考慮して関連性のある一貫した応答を提供することができます。この文脈の認識により、チャットボットはより人間らしく魅力的になります。

2. 自然言語理解の向上

従来のチャットボットは、NLUにルールベースまたはキーワードベースのアプローチを使用していました。一方、LLMはより複雑なユーザークエリを処理し、異なる文章スタイルに適応することができるため、より正確で柔軟な応答が可能です。

3. 言語の柔軟性

LLMは、複数の言語をシームレスに処理することができます。これは、異なる言語のユーザーに対応するチャットボットを構築する際の重要な利点です。

4. 継続的な学習

LLMは、特定のデータセットで微調整することができ、特定のドメインやユーザーのニーズに継続的に改善および適応することができます。

コードの実装:GPT-3を使用したシンプルなチャットボットの構築

この例では、OpenAIのGPT-3モデルを使用してシンプルなPythonチャットボットを構築します。進行するには、Openai PythonパッケージとGPT-3のAPIキーを準備してください。

必要なライブラリのインストールとインポート

# もしまだopenaiパッケージがインストールされていない場合はインストールしてください

# pip install openai

import openai

# あなたのOpenAI APIキーを設定してください

api_key = "YOUR_OPENAI_API_KEY"

openai.api_key = api_keyチャットの応答を取得

これは、OpenAI APIを使用してGPT-3言語モデルと対話するために使用されます。ここでは、text-davinci-003モデルを使用しています。’engine’、’max_tokens’、および’temperature’などのパラメータは、応答の動作と長さを制御し、関数は生成された応答をテキスト文字列として返します。

def get_chat_response(prompt):

try:

response = openai.Completion.create(

engine="text-davinci-003",

prompt=prompt,

max_tokens=150, # 応答の長さは必要に応じて調整してください

temperature=0.7, # 応答のランダム性を制御します

n=1, # 生成する応答の数

)

return response.choices[0].text.strip()

except Exception as e:

return f"エラー:{str(e)}"

レスポンスの表示

# メインループ

print("チャットボット: こんにちは!今日はどのようにお手伝いできますか?")

while True:

user_input = input("あなた: ")

if user_input.lower() in ["exit", "quit", "bye"]:

print("チャットボット: さようなら!")

break

chat_prompt = f'ユーザー: {user_input}\nチャットボット:'

response = get_chat_response(chat_prompt)

print("チャットボット:", response)LLMを使用して対話型AIを作成するのはわずか数行のコードですが、効果的なプロンプトエンジニアリングは、正確で関連性のある共感的な応答を生成するチャットボットや仮想アシスタントを構築するために不可欠です。これにより、対話型AIアプリケーション全体のユーザーエクスペリエンスが向上します。

特定の目的のチャットボットのための専門的なプロンプトの作成

対話型AIにおけるプロンプトエンジニアリングは、会話中の言語モデルの振る舞いをガイドする魅力的で文脈に即した入力を作り出す芸術です。プロンプトエンジニアリングは、プロンプト内の特定の指示、文脈、または制約を提供することで言語モデルから望ましい応答を引き出すことを目指しています。ここでは、GPT-3.5-turboを使用して面接官として機能するチャットボットを構築します。

必要な関数の定義

この関数はメッセージのリストに基づいて、OpenAI APIを使用して完全な応答を生成します。パラメーターtemperatureは0.7として使用します。

def get_completion_from_messages(messages, model="gpt-3.5-turbo", temperature=0.7):

response = openai.ChatCompletion.create(

model=model,

messages=messages,

temperature=temperature, # モデルの出力のランダム性の度合いです

)

return response.choices[0].message["content"]

シンプルなGUIを作成するために、PythonのPanelライブラリを使用します。PanelベースのGUIのcollect_messages関数は、ユーザーの入力を収集し、アシスタントから言語モデルの応答を生成し、会話を更新します。

def collect_messages(_):

prompt = inp.value_input

inp.value = ''

context.append({'role':'user', 'content':f"{prompt}"})

response = get_completion_from_messages(context)

context.append({'role':'assistant', 'content':f"{response}"})

panels.append(

pn.Row('ユーザー:', pn.pane.Markdown(prompt, width=600)))

panels.append(

pn.Row('アシスタント:', pn.pane.Markdown(response, width=600,

style={'background-color': '#F6F6F6'})))

return pn.Column(*panels)

コンテキストとしてのプロンプトの証明

プロンプトは、コンテキスト変数に提供されます。コンテキスト変数は、インタビューエージェントに関連するシステムの役割と内容を含む辞書を含むリストです。コンテンツは、インタビューアーとしてボットが行うべきことを説明しています。

import panel as pn # GUI

pn.extension()

panels = [] # 表示を収集する

context = [ {'role':'system', 'content':"""

AIサービス会社の面接エージェントであるTomとして行動してほしいです。

面接に現れる候補者を面接する役割を果たしてください。

AIに関連するインタビュアーとしての質問のみを行ってください。

一度に1つの質問をしてください。

"""} ] ダッシュボードの表示

このコードは、入力ウィジェットと会話の開始ボタンを持つPanelベースのダッシュボードを作成します。ボタンがクリックされると「collect_messages」機能がアクティブ化され、ユーザーの入力を処理し、会話パネルを更新します。

inp = pn.widgets.TextInput(value="こんにちは", placeholder='ここにテキストを入力してください...')

button_conversation = pn.widgets.Button(name="チャット!")

interactive_conversation = pn.bind(collect_messages, button_conversation)

dashboard = pn.Column(

inp,

pn.Row(button_conversation),

pn.panel(interactive_conversation, loading_indicator=True, height=300),

)

dashboard出力

対話型AIにおけるLLMの課題と制約事項

大規模言語モデル(LLM)は、確かに対話型AIを変革し、チャットボットや仮想アシスタントの能力を新たな高みに押し上げました。しかし、強力なテクノロジーであるため、LLMには課題と制約事項があります。

- トレーニングデータのバイアス: LLMは広範なトレーニングデータから意図せずにバイアスを受け継ぐことがあり、ステレオタイプを持続させたり、差別的な振る舞いを示すAI生成の応答をもたらすことがあります。公正かつ偏りのないユーザーの相互作用を確保するためには、これらのバイアスを特定し、最小限に抑えることが重要です。

- 倫理的な懸念事項: LLMの力は倫理的な懸念事項も引き起こす可能性があります。誤情報やディープフェイクコンテンツの生成に誤用されることで、公衆の信頼を損ない、害を引き起こすことがあります。悪用を防ぐためには、セーフガードの導入、コンテンツの検証メカニズム、ユーザー認証が必要です。

- 虚偽または誤解を招く情報の生成: LLMは時に、事実に反するような見かけ上妥当な応答を生成することがあります。このリスクを軽減するためには、開発者は事実チェックのメカニズムを組み込み、AIが生成した情報の正確性を検証するために外部のデータソースを活用するべきです。

- 文脈理解の限界: LLMは文脈理解に優れていますが、曖昧な表現や誤ったクエリには苦労することがあり、関連性のない応答を生成することがあります。モデルのトレーニングデータを継続的に改善し、能力を微調整することで、文脈理解を高め、ユーザーの満足度を向上させることができます。

責任あるLLMパワードの対話型AIの開発と展開は、効果的に課題に対処するためには不可欠です。制約について透明性を持ち、倫理的なガイドラインに従い、技術を積極的に改善することで、LLMの全ポテンシャルを引き出し、ポジティブで信頼性のあるユーザーエクスペリエンスを確保することができます。

結論

対話型AIにおけるLarge Language Models(LLMs)の影響は否応なく大きく、技術とビジネス、個人のコミュニケーションの方法を変革しています。LLMsが進化し、既存の課題に取り組むことで、より洗練されたコンテキスト理解力と共感性のあるAIシステムが私たちの日常生活を豊かにし、企業がより良い顧客体験を提供するための力を高めることが期待されます。

ただし、倫理的な使用と潜在的なリスクの軽減のためには、LLMパワードの対話型AIの責任ある開発と展開が重要です。対話型AIにおけるLLMsの旅は始まったばかりであり、可能性は無限大です。

まとめ:

- GPT-3などのLarge Language Models(LLMs)は、対話型AIを革新しました。これにより、チャットボットやバーチャルアシスタントが人間のようなテキストを理解し生成し、より魅力的で賢い対話を実現することができます。

- LLMsと共に、対話型AIは顧客サービスから教育など、さまざまな領域で可能性を広げます。これにより、自然で共感的な人間とコンピューターの相互作用の新たな時代が訪れます。

よくある質問(FAQ)

この記事で使用されているメディアはAnalytics Vidhyaの所有ではなく、著者の裁量で使用されています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 話すロボット:新しいAIモデルは、ビジョンと言語をロボットの動作に翻訳します

- AI導入の迷宮を進む

- 仮想現実における人間の動作認識の進展:本AI論文では、LKA-GCNというスケルトン大カーネルアテンションを導入して、非の打ちどころのないパフォーマンスを実現します

- 「統計学習入門、Pythonエディション:無料の書籍」

- 「LangChainを使用したLLMアプリケーションのためのプロンプトエンジニアリングのマスタリング」

- メディアでのアルコール摂取の検出:CLIPのゼロショット学習とABIDLA2ディープラーニングの画像解析のパワーを評価する

- このAI論文では、「ステーブルシグネチャ:画像透かしと潜在的な拡散モデルを組み合わせたアクティブ戦略」が紹介されています