CMU(カーネギーメロン大学)およびNYU(ニューヨーク大学)の研究者たちは、大規模言語モデル(LLM)を用いたゼロショット時系列予測のための人工知能メソッド「LLMTime」を提案しています

「CMU(カーネギーメロン大学)およびNYU(ニューヨーク大学)の研究者たちが提案する、大規模言語モデル(LLM)を活用したゼロショット時系列予測のための人工知能メソッド「LLMTime」」

“`html

他のテキストや音声、ビデオなどのシーケンスモデリングの問題といくつかの類似点があるにもかかわらず、時系列データは2つの特徴があり、特に困難であるとされています。集計された時系列データセットには、しばしば異なるソースからのシーケンスが含まれ、場合によっては欠損値があります。これは、通常、均一な入力スケールとサンプルレートを持つビデオや音声とは対照的です。さらに、気象情報や金融データなどの多くの時系列予測アプリケーションでは、通常、情報の一部しか含まれていない観測からの外挿が必要です。これにより、正確なポイント予測が非常に困難になり、不確実性の推定がますます重要になります。

時系列モデリングのための事前学習は頻繁には使用されません。事前学習のデータセットが利用しやすくないためです。ただし、大規模な事前学習は、ビジョンとテキストの大規模ニューラルネットワークのトレーニングの重要な要素となっており、パフォーマンスがデータの利用可能性に直接比例するようになっています。そのため、ARIMAや線形モデルなどの基本的な時系列手法の方が、一般的なベンチマークではディープラーニング手法よりも頻繁に優れたパフォーマンスを示しています。著者は、大規模な言語モデル(LLM)が従来の手法の明確なバイアスと現代の深い理解の複雑な表現学習と生成能力とのギャップを埋める可能性があることを示しています。

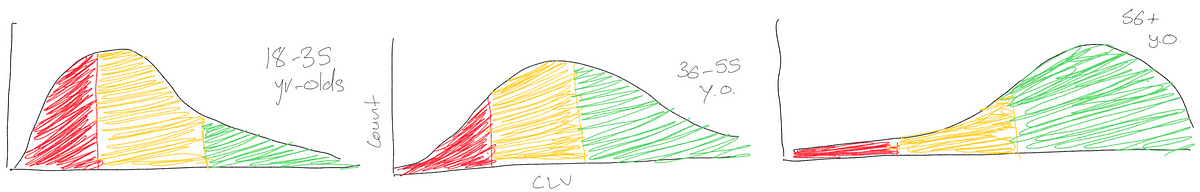

LLMを事前学習済みモデルとして連続的な時系列予測アプリケーションに使用するために、研究者らは「LLMTIME2」という非常にシンプルなアプローチを示しています(図1に概説)。この手法では、時系列予測をテキストの次のトークン予測として扱い、時系列を数値の文字列として表現することで、頑健な事前学習済みモデルや確率的な機能(確率評価やサンプリングなど)を適用することが可能になります。彼らは(1)時系列を数値の文字列として効率的にエンコードする方法、および(2)離散的なLLM分布を連続的な確率密度に変換する方法を提供しています。これにより、多様な複雑な分布を記述することができ、高いパフォーマンスが達成できます。これらの戦略を使用することで、他のモデルが使用するダウンストリームデータを変更することなく、LLMTIMEがさまざまな問題に対して特化した時系列手法を上回るか匹敵することがわかりました。

- シリコンボレー:デザイナーがチップ支援のために生成AIを活用

- バイデン大統領がAI実行命令を発布し、安全評価、市民権のガイダンス、労働市場への影響に関する研究を要求しています

- コロンビア大学とAppleの研究者が『フェレット』を紹介します画像の高度な理解と説明のための画期的な多モーダル言語モデルです

図1: 大規模言語モデル(LLM)を使用して、研究者らは、数値をテキストとしてエンコードし、テキストの補完としての潜在的な外挿を選択する時系列予測手法「LLMTIME」を提案しています。ターゲットデータセットに対してトレーニングされていない(つまり、ゼロショット)の場合でも、LLMTIMEはいくつかのよく知られた時系列アルゴリズムを上回ることができます。基本となるベースモデルの強さは、LLMTIMEのパフォーマンスと共にスケールすることに注意が必要です。RLHFなどのアラインメントを経るモデルはスケーリングトレンドに従わないことも注目すべきです。

たとえば、セクション6では、GPT-4のパフォーマンスがGPT-3よりも悪いことが示されています。

LLMTIMEのゼロショットの性質には、次のような潜在的な利点があります:(1)LLMsのシンプルな適用を可能にし、ファインチューニング手順の専門知識やこれらの手続きに必要な大量の計算リソースの必要性を排除します。(2)トレーニングやファインチューニングに対して少ない情報を持つデータが限られた状況にも適しています。(3)広範な事前学習済みLLMsのパターン抽出能力を利用することで、特殊な時系列モデルの作成に必要なかなりの時間、努力、およびドメイン固有の専門知識を回避できます。彼らは、LLMsが単純または繰り返しのシーケンスに好みを示し、これらのバイアスが時系列の重要な特徴(季節性など)と一致していることを示し、LLMTIMEの優れたパフォーマンスの理由を理解するために詳しく調査しています。これらのバイアスに加えて、LLMsは多様な分布を表現し、容易に欠損データに対応することもできます。それは、時系列に特に役立ちます。

彼らはまた、LLMsが追加の副次的情報を問い合わせたり、LLMsに予測の正当性を説明させたりすることが可能になる方法を示しています。最後に彼らは、パフォーマンスが大きさと共に向上する傾向にあること、ポイント予測の品質も不確実性表現の品質が向上すること、一般的に魅力的な予測性能の増大に加えて、GPT-4の不確実性キャリブレーションがGPT-3よりも悪いことを発見しました。これは、RLHFなどの介入の結果である可能性があります。

“`

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「NYUの研究者たちはゲノミクスのためのニューラルネットワークを作成し、それが予測にどのように辿り着くかを説明できることを示しました」

- 『アクション-ユニオン・ラーニングによる人間-ロボットインタラクションのための弱教師アクションセグメンテーションの改善』と題する 富士通の新しいAIリサーチが発表されました

- 新しいディープラーニングの研究で、抗マラリア薬が骨粗しょう症の可能な治療薬として特定されました

- この中国のAI研究は、ベートーヴェン、クレオパトラ女王、ユリウス・カエサルなど特定の人物として振る舞うようにLLMを教えるCharacter-LLMを紹介しています

- メタAI研究者がGenBenchを導入:自然言語処理の汎化を進める革命的なフレームワーク

- 「非営利研究者による人工知能(AI)の進展リスト」

- 清華大学の研究者たちは、潜在意味モデル(LCM)を提案しました:潜在拡散モデル(LDM)の次世代の生成AIモデル