ChatGPTの基礎を学ぶための優れたリソース

ChatGPTの基礎学習リソース

OpenAI、ChatGPT、GPTシリーズ、および大規模言語モデル(LLM)全般――AIのプロフェッションや技術者として関わりがある場合、これらの言葉を最近のほとんどすべてのビジネスの会話で耳にする可能性が高いです。

そして、その熱狂は本物です。これ以上バブルとは呼べません。なぜなら、今回は熱狂が約束を果たしているからです。

かつては人間の得意分野と考えられていた、音楽の創造的な応用、詩の執筆、さらにはプログラムの開発など、ほとんどすべてのタスクを、機械が人間のような知能を理解し、返答できるようになるとは誰も思いもよりませんでした。

LLMの普及により、この強力な技術の下に何が隠れているのかについて、私たち全員が好奇心を抱いています。

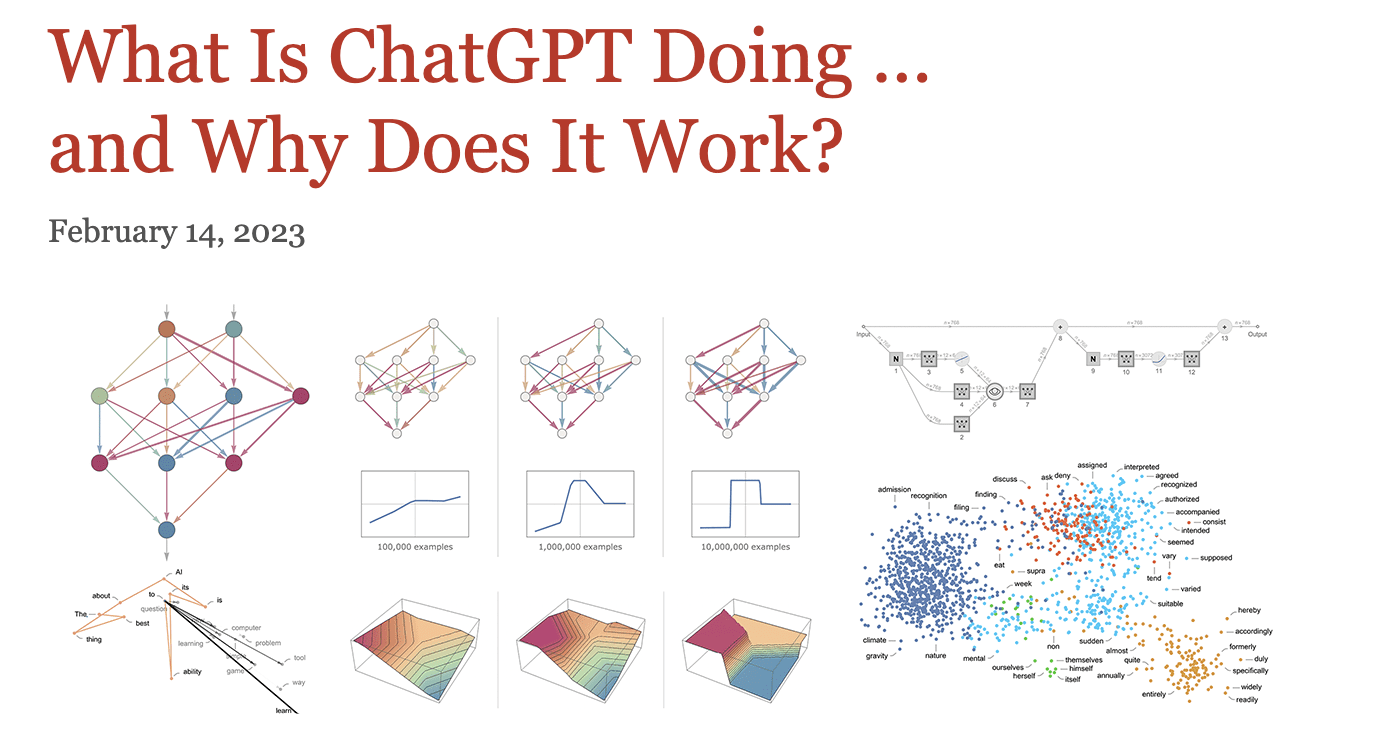

ですので、アルゴリズムの詳細やAIの領域の複雑さに嫌気がさしている場合、私は「ChatGPTが何をしていて…なぜそれが機能するのか」について学ぶためのこのリソースを強くお勧めします。

はい、それがWolframによる記事のタイトルです。

なぜ私がこれをお勧めするのかというと、TransformersやLLM、さらには生成AIを学ぶ前に、機械学習の絶対的な基礎と深層ニューラルネットワークが人間の脳と関連している方法を理解することが重要だからです。

このリソースは、それ自体が文学的なミニブックのように見えますが、このリソースの長さに時間をかけてください。

この記事では、概念を理解しやすくするために、どのように読み始めるかを共有します。

モデルの理解が重要です

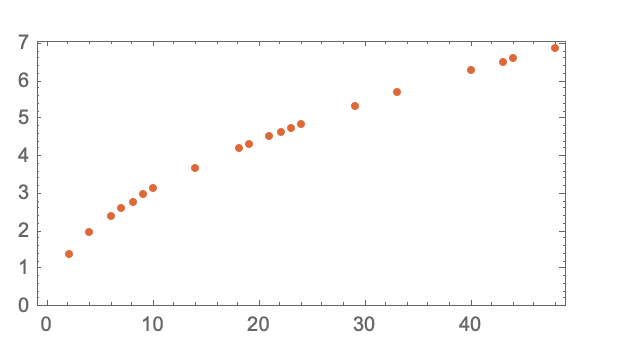

この記事の重要なポイントは、「Large Language Models」の「モデル」部分に焦点を当てており、各階からボールが地面に到達するまでの時間を示す例で説明されています。

これを達成する方法は2つあります――各階からこのエクササイズを繰り返すか、それを計算できるモデルを構築することです。

この例では、計算を容易にする基礎となる数学的な形式が存在しますが、どのようにして「モデル」を使ってこのような現象を推定するのでしょうか?

最も確実な方法は、関心のある変数(この場合は時間)を推定するために、直線を適合させることです。

このセクションをより深く読むと、「モデルのないモデル」という考えについて詳しく説明され、さまざまな深層学習の概念につながります。

深層学習の核心

モデルとは、特定の変数を入力として受け取り、出力として結果を返す複雑な関数であることを学ぶことになります。例えば、数字認識のタスクでは、数字を結果として返します。

この記事は、数字認識から典型的な猫対犬の分類器まで進み、各層がどのような特徴を選択するか、猫の輪郭から始まります。特に、ニューラルネットワークの最初の数層は、物体のエッジなど、画像の特定の側面を抽出します。

キーターミノロジー

複数の層の役割を説明するだけでなく、ディープラーニングアルゴリズムの複数の側面も説明されています。例えば:

ニューラルネットワークのアーキテクチャ

この投稿では、「芸術と科学のミックスですが、主に試行錯誤によって発見され、ニューラルネットワークの操作方法に関する重要な知識が徐々に蓄積されてきました」と述べられています。

エポック

エポックは、モデルに特定の例を「思い出させる」ための効果的な方法です。

同じ例を複数回繰り返すだけでは十分ではないため、異なるバリエーションの例をニューラルネットに示すことが重要です。

重み(パラメータ)

LLMの1つには1750億のパラメータがあると聞いたことがあるでしょう。これは、モデルの構造がノブの調整によってどのように変化するかを示しています。

基本的に、パラメータはデータに合わせるために「回すことができるノブ」です。この投稿では、ニューラルネットワークの実際の学習プロセスは、与えられた学習例を最も適切に捉える重みを見つけることに関わると強調されています。

汎化

ニューラルネットワークは「示された例の間を合理的な方法で補間する」ことを学習します。

この汎化は、複数の入出力例から学習して未知のレコードを予測するのに役立ちます。

損失関数

では、何が合理的であるかをどのように知るのでしょうか?それは、出力値が期待値からどれだけ離れているかによって定義されます。これは損失関数にカプセル化されています。

損失関数は、私たちが得た値と真の値との間の「距離」を与えてくれます。この距離を減らすために、重みは反復的に調整されますが、最短経路を取る方向に重みを系統的に減らす方法があるはずです。

勾配降下法

重みの地形図で最も急な降下経路を見つけることを勾配降下法と呼びます。

それは、重みの地形図をナビゲートすることによって、正しい重みを見つけること全般に関わります。

バックプロパゲーション

損失関数を使用して、逆方向に進んで関連する損失を最小化するための重みを段階的に見つけるバックプロパゲーションの概念を続けて読んでください。

ハイパーパラメータ

パラメータ(つまり重み)に加えて、損失関数の異なる選択肢、損失の最小化、または「バッチ」の例がどれくらい大きくなるかといったハイパーパラメータもあります。

複雑な問題に対するニューラルネットワーク

ニューラルネットワークを複雑な問題に使用することは広く議論されています。ただし、この投稿では、高次元空間内の複数の重み変数が最小値につながるさまざまな方向を可能にすることがどのようにして仮定を裏付けるのかを説明しています。

今、これを変数が少ない場合と比較してみてください。これは、方向がなくなる局所的な最小値に閉じ込められる可能性を意味します。

結論

この読み物では、モデルと人間の脳の仕組みを理解し、それをニューラルネットに応用する方法、その設計、および関連する用語について、多くをカバーしました。

この知識を基に、chatgptの動作を理解するための知識を構築する方法についての追加の投稿をお楽しみに。 Vidhi Chughさんは、製品、科学、エンジニアリングの交差点で働き、スケーラブルな機械学習システムを構築するAI戦略家兼デジタルトランスフォーメーションリーダーです。彼女は受賞歴のあるイノベーションリーダー、著者、国際的な講演者です。彼女は機械学習を民主化し、誰もがこの変革の一部になるための専門用語を打破する使命に取り組んでいます。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「2023年のトップAI画像から動画を生成するツール」

- AI生成コンテンツ:クリエイターにとってこれは何を意味するのか?

- 「ベストインクラスのセッションが開催中:新しいNVIDIA Studioノートパソコンがコンテンツ、ゲーム、教育を超高速化する」

- 品質管理パトロール:スタートアップが車両の故障パターンを検出するためのモデルを構築

- オムニバースへ:Reallusionは、2方向のライブ同期とOpenUSDサポートにより、キャラクターアニメーションのワークフローを向上させます

- 「ChatGPTは、ソフトウェアエンジニアリングの質問の半分以上に対して誤った回答をします」

- X / Twitterでお金を稼ぐ方法