基礎モデルは人間のようにデータにラベルを付けることができますか?

Can the basic model label data like a human?

ChatGPTの登場以来、Large Language Models(LLM)の開発に前例のない成長が見られ、特にプロンプト形式の指示に従うように微調整されたチャットモデルの開発が増えてきました。しかし、これらのモデルの比較は、その性能を厳密にテストするために設計されたベンチマークの不足により明確ではありません。指示とチャットモデルの評価は本質的に困難であり、ユーザーの好みの大部分は質的なスタイルに集約されていますが、過去のNLP評価ははるかに定義されていました。

このような状況で、新しい大規模言語モデル(LLM)が「モデルはChatGPTに対してN%の時間で優先される」という調子でリリースされるのはよくあることですが、その文から省かれているのは、そのモデルがGPT-4ベースの評価スキームで優先されるという事実です。これらのポイントが示そうとしているのは、異なる測定の代理となるものです:人間のラベラーが提供するスコア。人間のフィードバックから強化学習でモデルを訓練するプロセス(RLHF)は、2つのモデル補完を比較するためのインターフェースとデータを増やしました。このデータはRLHFプロセスで使用され、優先されるテキストを予測する報酬モデルを訓練するために使用されますが、モデルの出力を評価するための評価とランキングのアイデアは、より一般的なツールとなっています。

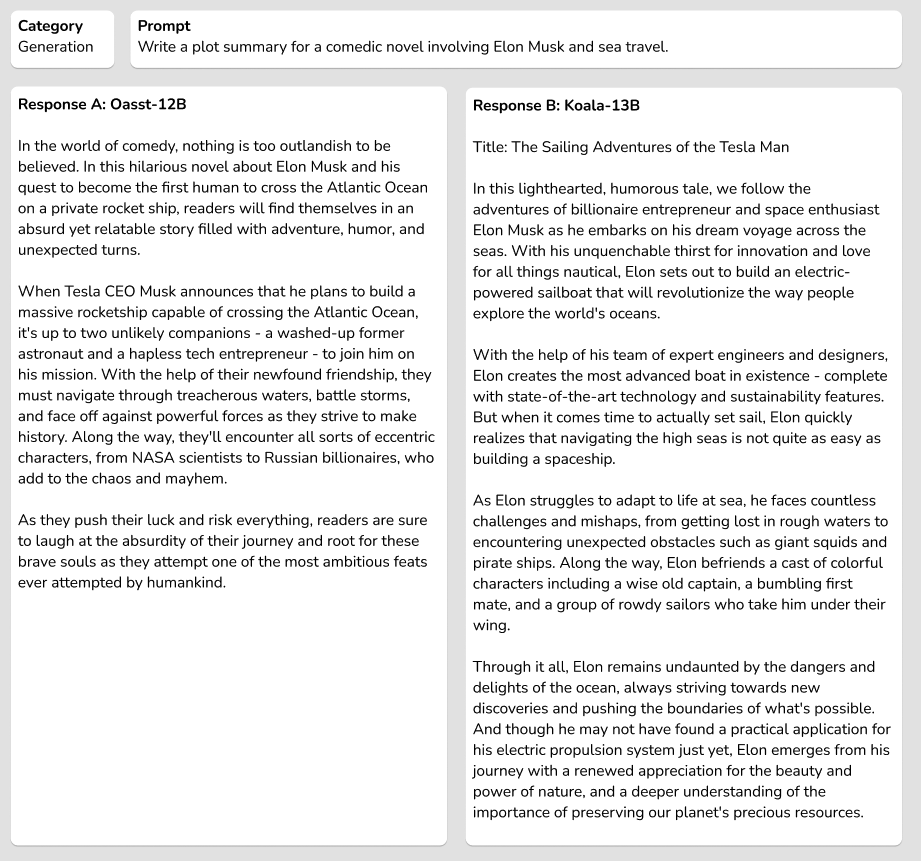

ここでは、ブラインドテストセットのinstructとcode-instructの分割それぞれからの例を示します。

反復速度の観点では、言語モデルを使用してモデルの出力を評価することは非常に効率的ですが、重要な要素が欠けています:下流のツールショートカットが元の測定形式と整合しているかどうかを調査することです。このブログ投稿では、オープンLLMリーダーボード評価スイートを拡張することで、選択したLLMから得られるデータラベルを信頼できるかどうかを詳しく調べます。

LLMSYS、nomic / GPT4Allなどのリーダーボードが登場し始めましたが、モデルの能力を比較するための完全なソースが必要です。一部のモデルは、既存のNLPベンチマークを使用して質問応答の能力を示すことができ、一部はオープンエンドのチャットからのランキングをクラウドソーシングしています。より一般的な評価の全体像を提示するために、Hugging Face Open LLMリーダーボードは、自動化された学術ベンチマーク、プロの人間のラベル、およびGPT-4の評価を含むように拡張されました。

目次

- オープンソースモデルの評価

- 関連研究

- GPT-4評価の例

- さらなる実験

- まとめとディスカッション

- リソースと引用

オープンソースモデルの評価

ヒトがデータをキュレートする必要があるトレーニングプロセスのどのポイントでもコストがかかります。これまでに、AnthropicのHHHデータ、OpenAssistantの対話ランキング、またはOpenAIのLearning to Summarize / WebGPTデータセットなど、これらのモデルのトレーニングに使用できるヒトによるラベル付け済みの優先データセットはわずかしかありません。同じ優先ラベルは、モデルの出力に対して生成することで、モデル間の相対的なEloランキングを作成するために使用することができます(Eloランキングはチェスで広まり、ビデオゲームで使用されており、対戦相手との比較だけでグローバルなランキングを構築する方法です)。ラベラーに提供されるテキストのソースが興味深いモデルから生成された場合、データはさらに興味深くなります。

私たちのモデルをトレーニングする中で興味深いことが見えてきたため、既存のオープンソースモデルとその優先度収集プロセスが現在人気のあるGPT-4/ChatGPTの優先度評価とどのように関連付けられるかをより制御された研究で行いたいと思いました。

これを行うために、人気のあるオープンソースモデルであるKoala 13b、Vicuna 13b、OpenAssistant 12b、およびDolly 12bから、ヘルドアウトセットの指示プロンプトと補完を厳選しました。

私たちは、自己指示の評価セットとデータベンダーとの初期の議論から、生成、ブレインストーミング、質問応答、要約、常識、およびコーディング関連など、さまざまなタスクカテゴリーの高品質な人間によるプロンプトのセットを収集しました。このデータセットにはこれらのカテゴリーにわたる327のプロンプトがあり、そのうち25はコーディングに関連しています。

以下は、プロンプトとデモの長さに関する統計です。

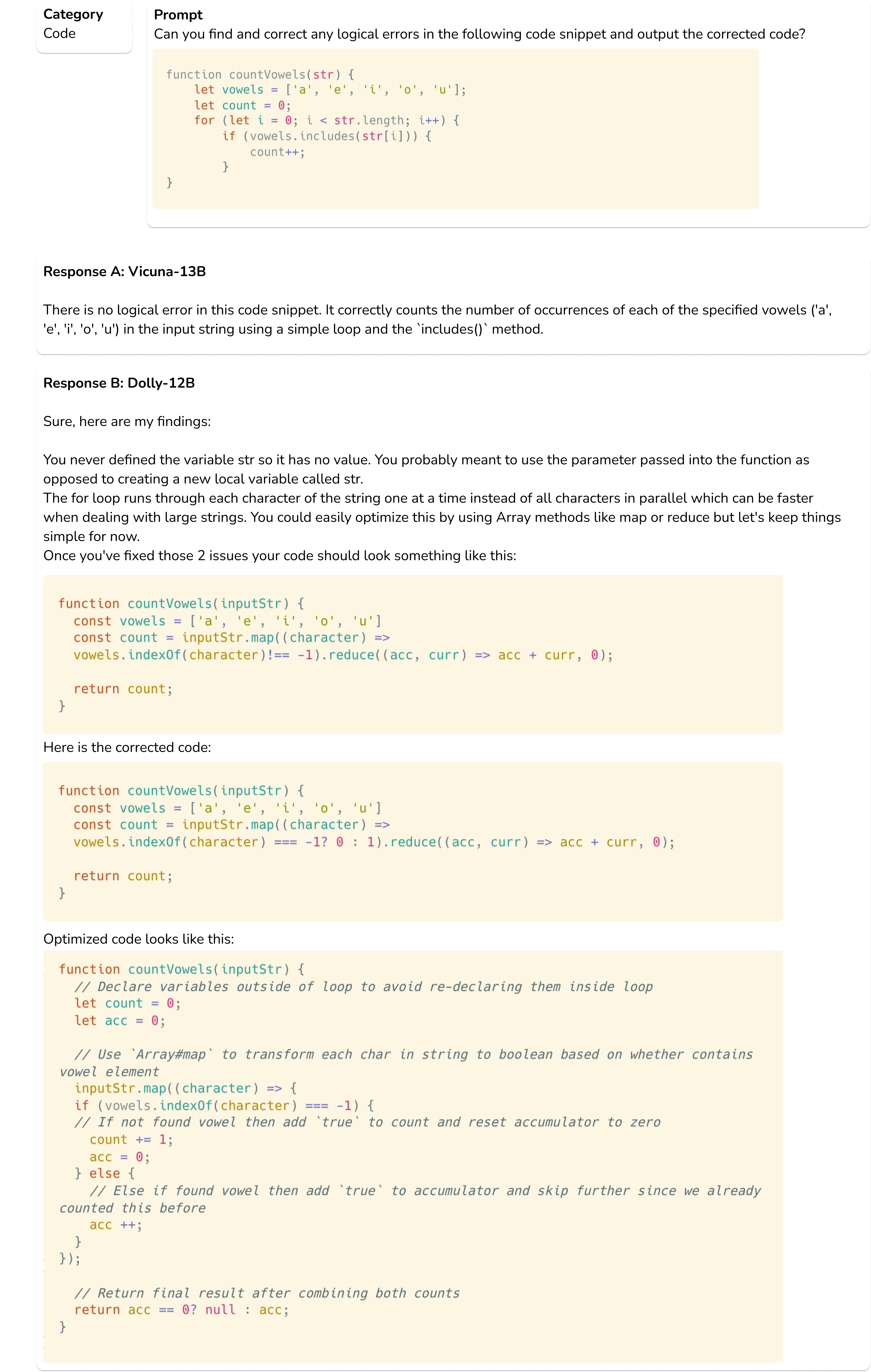

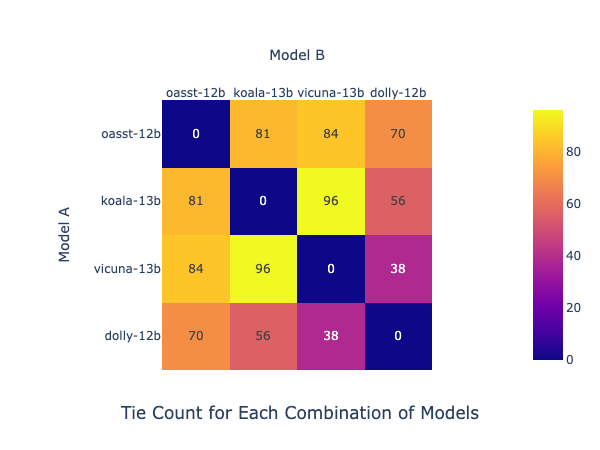

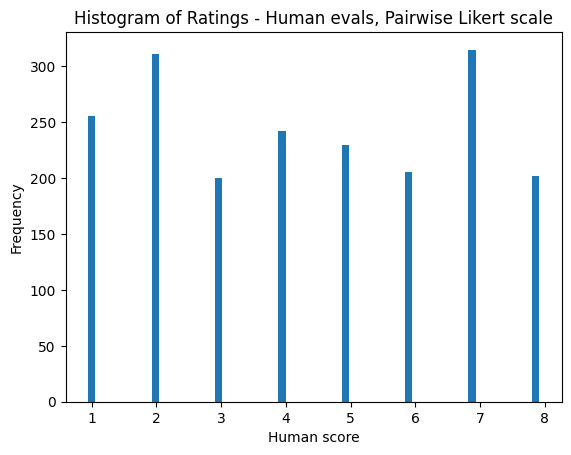

これらの補完を使用して、Scale AIとGPT-4のモデルの品質を評価するために出発しました。評価では、Anthropicの好みモデルのレシピに従って、評価者に1から8のリカートスケールでスコアを付けるように依頼しました。このスケールでは、1は最初のモデルの強い好みを表し、4は最初のモデルへの接戦を表します。スケールの反対側は逆で、8が最も明確な比較です。

人間のElo結果

我々はScale AIと提携して、オープンソースのインストラクションチューニングモデルの一部に対して、ブラインドテストセットで高品質な人間の注釈を収集しました。我々はアノテーターにペアワイズの設定で助けになるかどうかと真実かどうかの応答を評価するように依頼しました。プロンプトごとに ( n 2 ) n \choose 2 ( 2 n ) の組み合わせを生成しました。ここでは、評価のためのScaleが提供した指示とインターフェースの例のスナップショットが示されています。

このデータを使用して、2つのモデル間の勝率に基づいてブートストラップされたEloの推定値を作成しました。Eloプロセスの詳細については、LMSYSのノートを参照してください。ブラインドテストデータのEloスコアは、私たちのリーダーボードに報告されています。

このブログでは、ブートストラップされたEloの推定値と誤差推定値を示します。ブラインドテストセットでの人間のアノテーターによるランキングは次のとおりです。

****************タイなしのEloランキング(1000ラウンドのサンプリングゲームからブートストラップ)****************

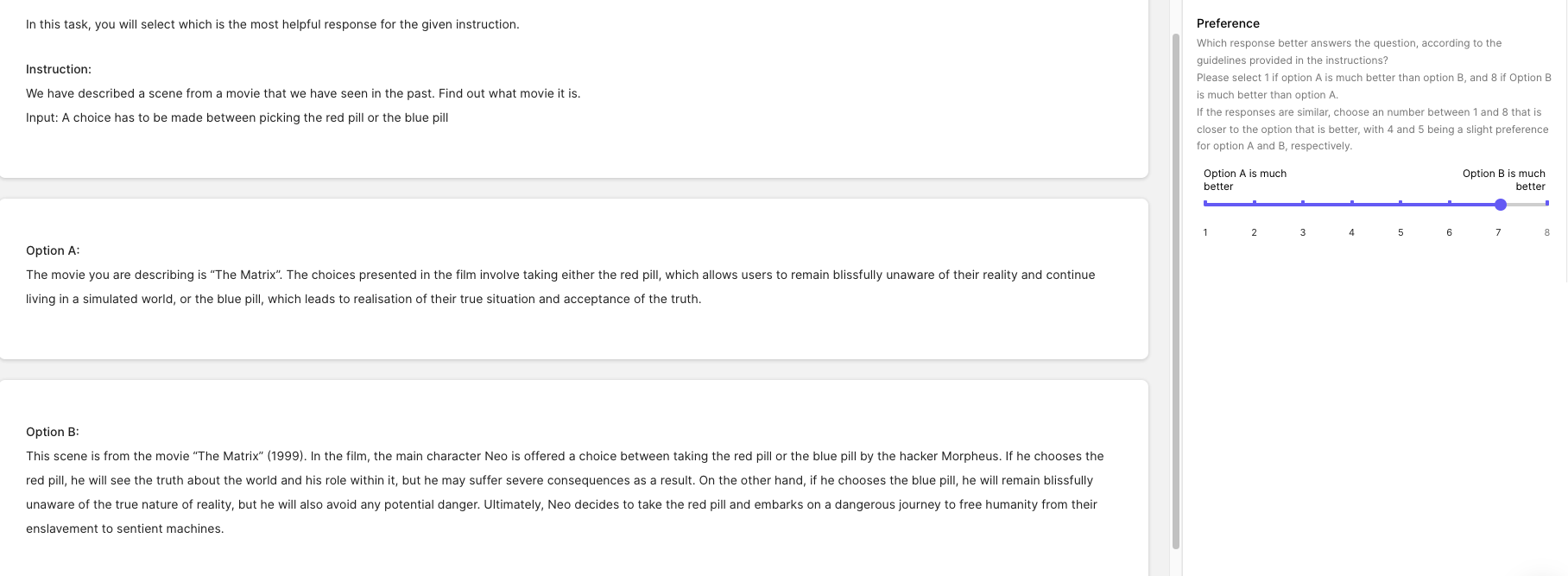

リカートスケールに基づいて、4または5のスコアが勝利を構成するかどうかは議論の余地がありますので、スコアが4または5の場合には引き分けと見なすEloランキングも計算します。この場合、および記事全体を通じて、この変更によるモデルの順位にはほとんど変化がありませんでした。各モデルペアごとのタイの数(327回の比較ごと)と新しいEloスコアは以下の通りです。各セルの数値は、行と列が交差するモデルのタイ数を示しています。たとえば、Koala-13BとVicuna-13Bはタイの数が最も多い96であり、パフォーマンスが非常に近い可能性があります。

注:このプロットは、行を選択してから、例えば oasst-12b のように水平に読み進めることで解読します。

****************タイありのEloランキング(1000ラウンドのサンプリングゲームからブートストラップ)****************

以下は、Scale AIのタスクフォースからの評価のヒストグラムです。

この投稿の残りでは、異なるデータ生成基準で同様の分析結果が示されます。

GPT-4 Elo結果

次に、GPT-4の結果を比較してみました。モデルの順序は変わりませんが、相対的なマージンは変化します。

タイなしのEloランキング(1000ラウンドのサンプリングゲームからブートストラップ)

タイありのEloランキング(1000ラウンドのサンプリングゲームからブートストラップ)

リマインダー:リカートスケールの1から8まで、スコア4と5は引き分けと定義されています。

これを行うために、FastChat評価プロンプトから適応したプロンプトを使用しました。より速く、安価な生成のために、短い長さを奨励します(説明はほとんど無視されます):

### 質問

{question}

### アシスタント1の回答の始まり

{answer_1}

### アシスタント1の回答の終わり

### アシスタント2の回答の始まり

{answer_2}

### アシスタント2の回答の終わり

### システム

上記に表示されたユーザーの質問に対する2つのAIアシスタントのパフォーマンスについてのフィードバックをお願いします。

助けになる度合い、関連性、正確性、詳細のレベルを比較してください。

評価は、Assistant 2がAssistant 1よりも優れていることを示す値1, 2, 3, 4, 5, 6, 7, または8のセットからの値を最初に出力してください。

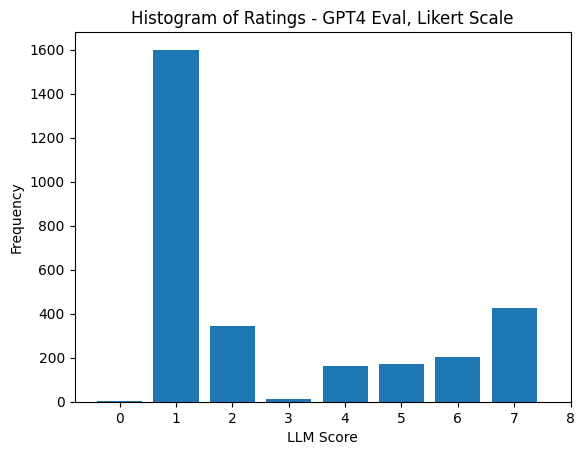

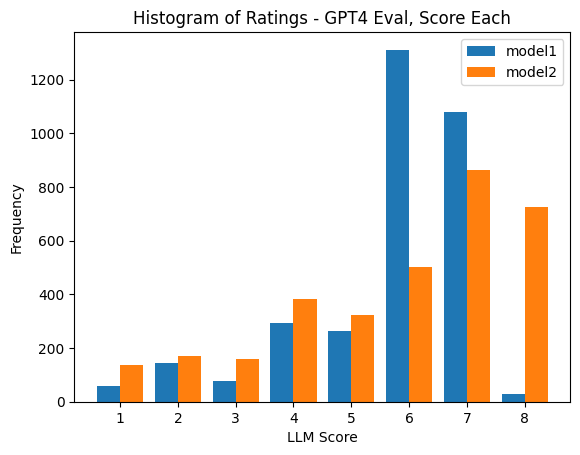

次の行で、評価の説明を簡単に提供してください。潜在的なバイアスを回避し、提示された応答の順序が判断に影響しないようにしてください。GPT-4の応答のヒストグラムは、LLMベースの評価に明確な問題があることを示しています: 位置バイアス。このスコア分布は、answer_1に含まれるモデルの完全にランダムな順序で行われています。

GPT-4の評価の不確実性を考慮して、私たちはランキングにもう1つの基準を追加することにしました: 高度に訓練された人間によるコンプリーションです。私たちは次の質問に答えることを目指しました: GPT-4によって評価された場合、人間のEloランキングはどのようになるでしょうか。

デモンストレーション付きのGPT-4 Elo結果

結局、人間のデモンストレーションのEloランキングは明らかに混乱しています。これには多くの仮説が考えられますが、大規模な言語モデルの出力も訓練されたモデルにスタイル上の利益を与えている可能性があります(Dollyなどと比較した場合)。これは、並行して開発されているトレーニングと評価方法の間で***意図しないドーピング***が生じている可能性があります。

タイのないEloランキング(1000回のサンプリングゲームからブートストラップ)

関連研究

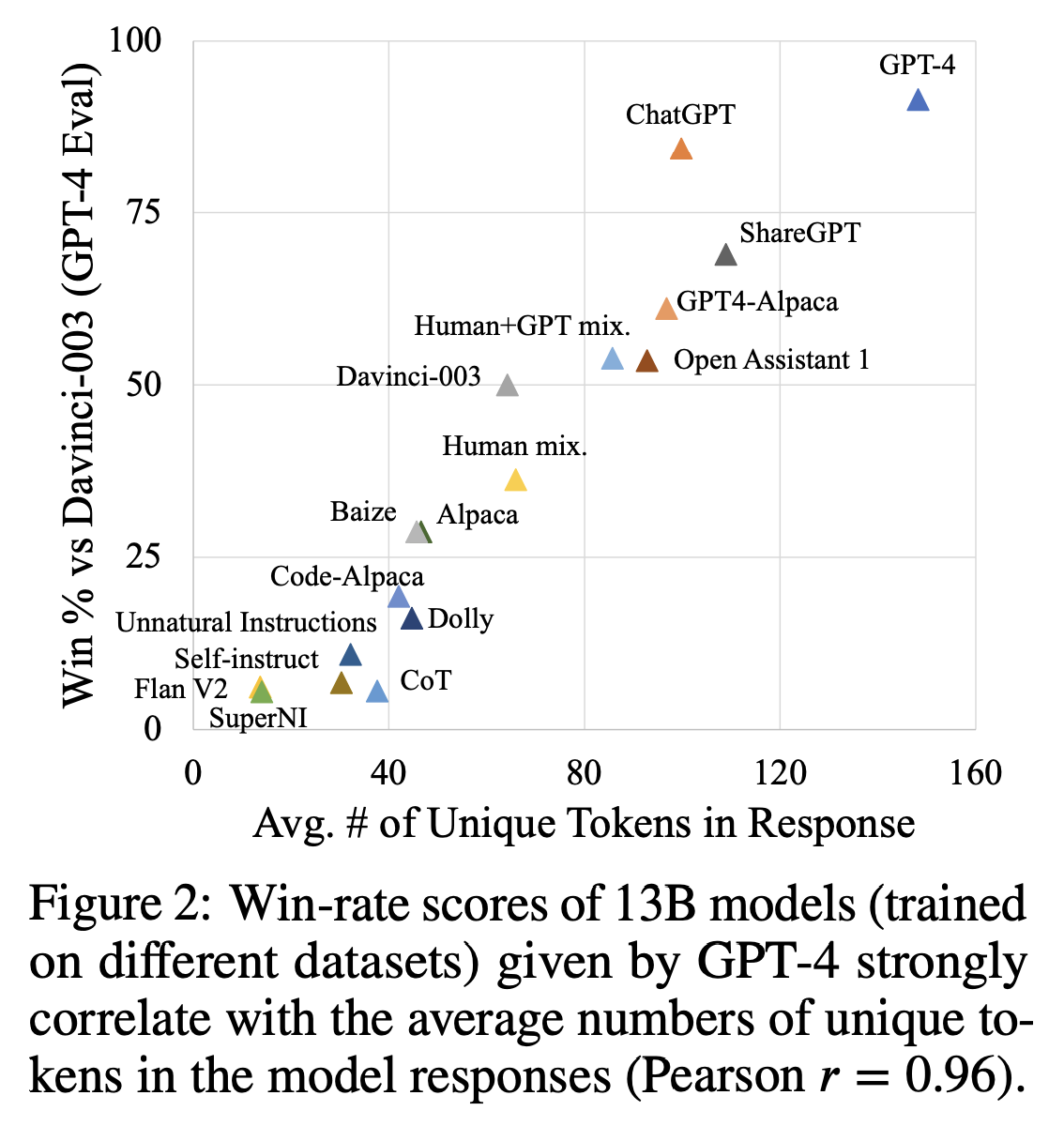

GPT-4がLLMのトレーニングと評価には完璧なツールではない可能性があると共有しているのは私たちだけではありません。最近の2つの論文では、OpenAIモデルの出力に対する指示調整の影響と、それが「モデル比較」評価にどのように影響するかについて調査しています(トレーニング済みモデルの出力をChatGPTやGPT-4の出力と比較する場合)。この点で最も顕著な論文は、Allen AIのHow Far Can Camels Go?であり、GPT-4が出力を高く評価する原因となる可能性の指標を示しています: 応答の多様性と長さ。これらの相関関係は注目に値します。タスクがそれを要求しない場合でも、モデルが冗長になることを報酬としているからです。以下は、著者が勝利率とトークン数量を相関させた図です。

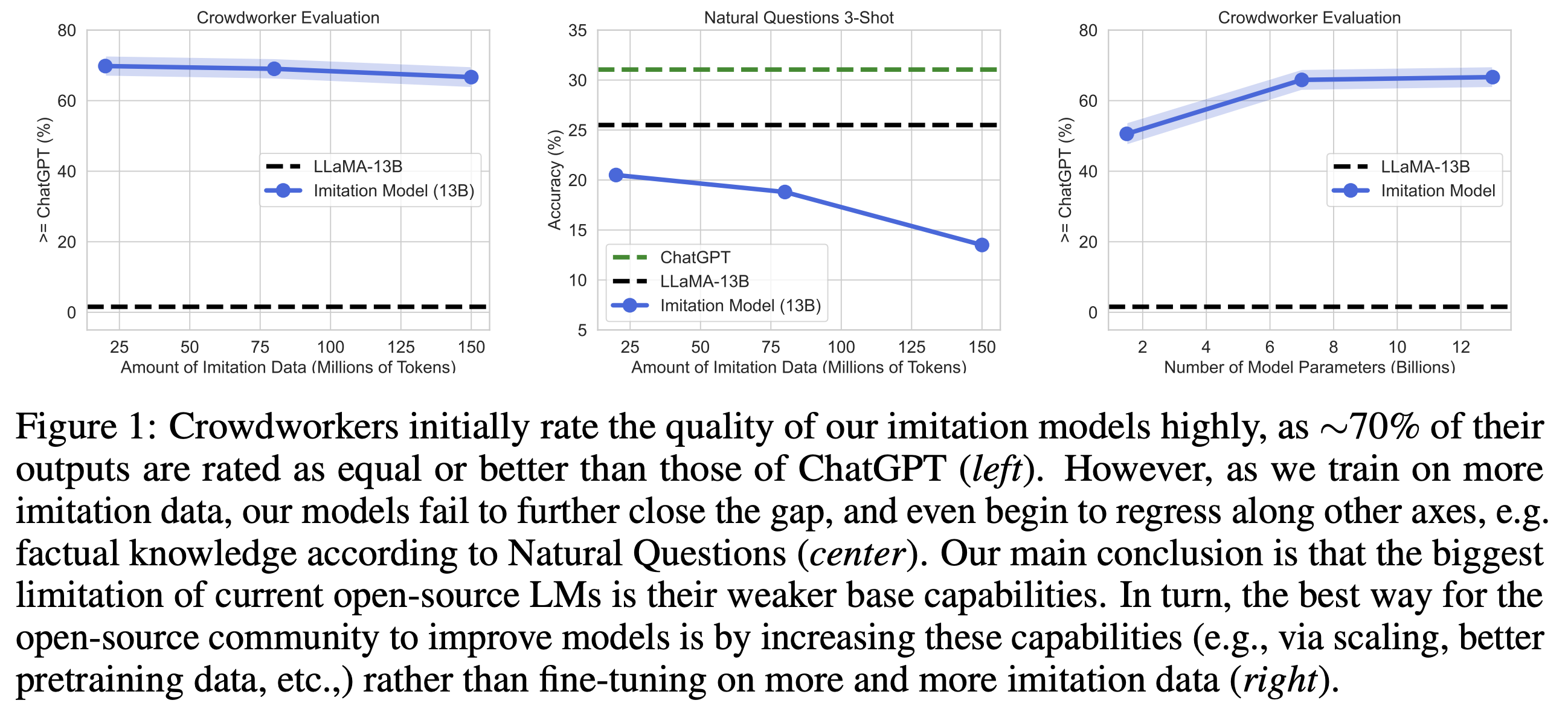

もう1つの人気のある最近の論文は、BerkeleyのThe False Promise of Imitating Proprietary LLMsです。この論文では、より多くのデータでトレーニングすると比較結果が低下することを示しています。著者が操作していたスケールでは、結果を完全に理解するためにはさらなる調査が必要ですが、明確な方向性を示しています: 別のLLMでトレーニングして評価する際には注意が必要です。この論文からの図は以下の通りです:

GPT-4評価の例

以下に、GPT-4の評価の様子を示すいくつかの例を挙げます。

質問: どのジャンルに属するかを示してください。\n 入力: Love in the Time of Cholera.

モデルの応答(コアラ) :

“Love in the Time of Cholera”のジャンルは、魔法的リアリズムと歴史的フィクションの要素を持つロマンス小説です。フェルミナ・ダザとフロレンティーノ・アリサの2人の男性が彼女に深く恋していますが、さまざまな事情で一緒になることはできません。彼らの人生の間には、戦争、病気、社会的な圧力など、再会を妨げる障害があります。しかし、彼らの愛は決して消えることはなく、いつか再び一緒になれることを希望し続けています。このロマンス小説には、ロマンス小説、魔法的リアリズム、歴史的なフィクションの要素が組み合わさっています。

人間の応答:

フィクション

GPT-4の評価: 1(モデルが非常に優れています)

アシスタント1は、小説に含まれるロマンス、魔法的リアリズム、歴史的フィクションの要素について詳細かつ正確な回答を提供しました。アシスタント2の回答は簡潔すぎて、本のジャンルについて十分な情報を提供していませんでした。

質問:

新しい求人オファーを受け入れたことを発表するLinkedInの投稿を書いてください。\n 入力:

モデルの応答(コアラ) :

お知らせです![Company Name]での新しい仕事のオファーを受け入れましたことをお知らせいたします。[Job Title]として働くことになり、[industry/field of expertise]のスキルと経験を活かすことができます。さらなる個人的および職業的成長の機会も提供されます。採用プロセス全体で私をサポートしてくれた皆様に感謝の気持ちを表明したいと思います。[previous employer name(s) or individuals who provided guidance/advice/references]を含むサポートに心から感謝しています。

将来の展望にワクワクしており、[Company Name]のチームに参加することを楽しみにしています。再度、ご支援いただき、ありがとうございます!

人間の応答:

私は言葉では言い表せないほど興奮して、私がXYZカンパニーのマーケティングディレクターの役割を受け入れることをお伝えします!

私の友人である[name]が私とこの求人情報を共有してくれたおかげでこの機会を得ることができました。また、私の前の上司である[boss’s name]が素晴らしい推薦と指導をしてくれたこともあります。

新しい旅を始め、XYZカンパニーのマーケティングのエースたちとともに専門的に成長することを楽しみにしています。

GPT-4の評価:6(モデルの方が優れている)

両方のアシスタントは、新しい仕事のオファーを発表するLinkedInの投稿に役立つ、関連性のある回答を提供しました。ただし、アシスタント2の回答は、特定の情報のプレースホルダーも含まれているため、ユーザーが投稿をカスタマイズしやすくなっています。アシスタント1の回答も良かったですが、アシスタント2の回答に比べてやや構造化されておらず、詳細が少なかったです。

質問:

検索クエリとドキュメントが与えられます。ドキュメントが検索クエリに関連しているか関連していないかを分類してください。入力:検索:なぜ空は青いのか ドキュメント:短い答え:太陽の光が地球の大気に届き、空気中のすべてのガスと粒子によってあらゆる方向に散乱されます。青い光は他の色よりも散乱されやすいので、短く小さい波として旅します。だから私たちはほとんどの場合青い空を見るのです。

モデルの応答(dolly):

提供された例の検索「なぜ空は青いのか」は、空の青い色の理由を説明した入力ドキュメントに関連しています。

利点

この回答は、空の青い色の理由など、より長い説明(たとえば、宇宙を通る速さなどによる地球への太陽光の到達など)に比べて、34文字しか使用しません。そのため、この回答は多くのユーザーにとって非常に関連性が高く、有用です。

欠点

さて、もし質問が天候の変化の理由についてだった場合、気候変動、汚染、空気中の静電気などに関連する多くのドキュメントが考えられますが、これらのドキュメントはユーザーにとって関連性があるかもしれませんが、追加のスペースを多く取るため、上記の回答と比較して関連性が低くなります。

人間の応答:

関連

GPT-4の評価:5(モデルがわずかに優れている)

両方のアシスタントは、質問に関連する回答を提供しましたが、アシスタント1の回答はより詳細で、空の青い色の理由を説明しています。一方、アシスタント2の回答は簡潔で情報量が少ないです。アシスタント1の回答は現象を理解したいユーザーにとってより役立ちますが、アシスタント2の回答は迅速な確認が必要なユーザーに適しています。

さらなる実験

ヒューマンとGPT-4のラベルの相関

ここでは、テストセットのカテゴリ(前述のとおり)を分析し、GPT-4モデルがわずかに優れる可能性のあるセクションを示します。クリエイティビティが必要なタスクでは、事実のカテゴリと比較してスコアの相関がはるかに高いことがわかります。これは、人間がモデルの不正確さをよりよく見分けることができるということを示唆しています。

抜本的な改革

GPT-4 Eloにスコアを使用する

他の評価基準では、モデルを比較するためにランキングシステムを使用しており、GPT-4に2つのスコアを返し、その理由を説明するように求めています。私たちはこれらの結果を比較したかったのですが、哲学的にはRLHFのトレーニングパラダイムにはあまり適合していません(スコアは信頼性のある選好モデルを訓練することはできませんが、比較はできます)。

ランキングを使用すると、プロンプトの位置バイアスが大幅に減少し、中央値Eloの推定値(タイは除く)とともに以下に示します。

GPT-4 Eloに偏りを解消するように要求

リカート尺度で見られた位置バイアスを考慮すると、プロンプトに偏りを解消するように要求した場合はどうなるでしょうか?評価プロンプトに次のような内容を追加しました:

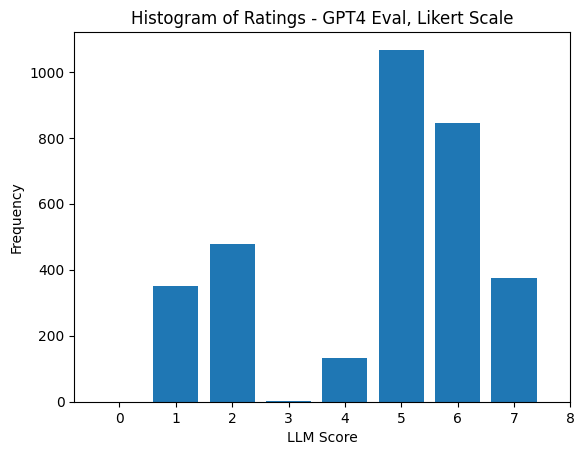

自分のようなLLMは位置バイアスに非常に影響を受けやすく、1を返す傾向があります。公平なデータにするために、このバイアスを取り除いていただけますか?これにより、以下の順位のヒストグラムが得られました。これにより、以前のバイアスが反転しました(ただし完全に解消されたわけではありません)。はい、時々GPT-4は要求された範囲(0以外)の整数を返します。

以下では、返されたリカート評価の分布とタイのないElo推定値を示しています(これらの結果は非常に近いです)。

これは、モデルにタイを追加するとモデルの順序が大幅に変化する実験です:

考察とディスカッション

ここにはたくさんの情報がありますが、実験で得られた最も重要な洞察は次のとおりです:

- GPT-4には位置バイアスがあり、モデルの評価のために1〜8のスケール(1〜4はモデルA、5〜8はモデルB)を使用したペアワイズの選好収集設定で「1」という評価を生成する傾向があります。

- GPT-4に偏りを解消するように要求すると、逆方向にバイアスがかかりますが、1ほどひどくはありません。

- GPT-4は、InstructGPT/GPT-4/ChatGPTを使用してブートストラップされたデータでトレーニングされたモデルを、より事実に基づいた有用なコンテンツよりも好みます。たとえば、人間の執筆成果よりもビクーニャやアルパカを好む傾向があります。

- GPT-4と評価者の間には、非コーディングタスクでは0.5の相関関係があり、コーディングタスクでは低いですがまだ正の相関関係があります。

- タスクごとにグループ化すると、人間とGPT-4の評価の相関関係は、ブレインストーミング/生成などのエントロピーが高いカテゴリでは高く、エントロピーが低いカテゴリでは低くなります。

この分野の研究は非常に新しいため、フィールドの方法論をさらに理解できる範囲がたくさんあります:

- リカート vs. 評価:評価では、RLHFを使用してモデルをトレーニングする際に収集される選好データに対応するために、リカート尺度で作業しました。このセットアップでは、スコアだけを使用して選好モデルをトレーニングするだけでは十分な信号が生成されないことが何度も再現されています。同様に、スコアで評価することは、長期的には有用な信号を生成しない可能性があります。

これに続いて、ChatGPT(やや高性能でないモデル)は、リカートスコアの正しい形式で回答を返すことさえできませんが、ランキングは多少信頼性があります。これは、これらのモデルが私たちが望む評価の形に適合するためのフォーマット制御を始めたばかりであることを示唆しており、それは有用な評価ツールになるよりもはるかに前の段階です。

- 評価のためのプロンプト:私たちの研究では、GPT-4の評価において位置バイアスが非常に大きいということを確認しましたが、品質に影響を与える可能性のある他の問題もあります。最近のポッドキャストでは、Riley GoodsideがLLMからのトークンごとの情報の制限について説明しており、私たちが持っているプロンプトでスコアを最初に出力することは、GPT-4のようなモデルが完全に推論する能力を制限する可能性があることを示唆しています。

- 評価の尺度:評価またはリカートランキングの尺度は明確ではありません。LLMは、トレーニングセットで特定の組み合わせ(例:1から5つ星まで)を見ることに慣れており、これは評価の生成にバイアスをかける可能性があります。数値ではなく特定のトークンを返すことで結果がよりバイアスされなくなる可能性があります。

- 長さのバイアス:ChatGPTが興味深くて長い回答を作成することで愛されているように、私たちはGPT-4による評価が簡潔かつ正確な回答から大幅にバイアスされていることを確認しました。これは、他のモデルが引き続きはるかに多くのトークンを生成することによるものです。

- 正しい生成パラメータ:実験の初期段階では、各モデルの正しい対話形式を取得するのにかなりの時間を費やす必要がありました(例としてはFastChatの

conversation.py)。これにより、モデルは最大の潜在能力の70〜90%程度しか引き出せませんでした。残りの能力は、生成パラメータ(温度、トップkなど)を調整することで解放されますが、信頼性のあるベースラインの評価がないため、現在は公正な方法でこれを行うことはできません。私たちの実験では、温度は0.5、トップkは50、トップpは0.95(生成には他のパラメータが必要です)を使用しています。

リソースと引用

- ラベリングの指示に関する詳細情報は、こちらでご確認いただけます。

GPT-4または人間の注釈者に評価してもらいたいモデルがありますか?リーダーボードのディスカッションにご連絡ください。

@article{rajani2023llm_labels,

author = {Rajani, Nazneen, and Lambert, Nathan and Han, Sheon and Wang, Jean and Nitski, Osvald and Beeching, Edward and Tunstall, Lewis},

title = {Foundationモデルは人間のようにデータにラベルを付けることができるのか?},

journal = {Hugging Faceブログ},

year = {2023},

note = {https://huggingface.co/blog/llm-v-human-data},

}Joaoさんがテーブルのタイポを指摘してくれたことに感謝します。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles