「生成型AI:CHATGPT、Dall-E、Midjourneyなどの背後にあるアイデア」

Behind the ideas of generative AI CHATGPT, Dall-E, Midjourney, etc.

芸術、コミュニケーション、現実の認識方法は急速に変化しています。人間のイノベーションの歴史を振り返ると、車輪の発明や電気の発見を画期的な飛躍と考えるかもしれません。今日、新たな革命が起こっています。それは人間の創造性と機械の計算の隔たりを埋めるものです。それが生成AIです。

生成モデルは人間と機械の境界を曖昧にしました。トランスフォーマーモジュールを使用するGPT-4のようなモデルの登場により、自然でコンテキスト豊かな言語生成に近づきました。これらの進歩は、文書作成、チャットボットの対話システム、さらには合成音楽の作曲などのアプリケーションを促進しました。

最近のビッグテック企業の決定はその重要性を示しています。マイクロソフトはすでにCortanaアプリを今月廃止し、Bing Chatなどの新しい生成AIのイノベーションに優先順位を与えています。アップルもCEOティム・クックの発言からわかるように、226億ドルのR&D予算のかなりの部分を生成AIに割り当てています。

新しいモデルの時代:生成対識別

生成AIの物語は、その応用だけでなく、根本的には内部の仕組みについても語られます。人工知能のエコシステムでは、識別モデルと生成モデルの2つのモデルが存在します。

- ピクセルを説明的なラベルに変換する:TensorFlowを使ったマルチクラス画像分類のマスタリング

- 「Pythonデコレーターは開発者のエクスペリエンスをスーパーチャージします🚀」

- 「オーディオ機械学習入門」

識別モデルは、ほとんどの人が日常生活で遭遇するものです。これらのアルゴリズムは、テキストや画像などの入力データと、単語の翻訳や医療診断のような目的の出力とを組み合わせます。これらはマッピングと予測に関するものです。

一方、生成モデルは創造者です。単に解釈や予測を行うだけでなく、現実世界の値と関係のない数値のベクトルから新しい複雑な出力を生成します。

生成モデルの技術

生成モデルの存在は、人間の脳の機能を模倣するように設計された洗練された構造であるディープニューラルネットワークに負うところがあります。これらのネットワークは、データの多様な変化を捉えて処理することで、数多くの生成モデルの基盤となっています。

これらの生成モデルはどのように生み出されるのでしょうか?通常、ディープニューラルネットワークを使用して、データの多様な変化を捉えるように最適化されたモデルが構築されます。典型的な例は、生成対抗ネットワーク(GAN)です。GANでは、生成器と識別器の2つのニューラルネットワークが独自の師弟関係で競い合い、お互いから学びます。絵画からスタイルの転送、音楽の作曲からゲームのプレイまで、これらのモデルは想像を超える方法で進化し拡大しています。

GANにとどまらず、生成モデルのフィールドで重要な役割を果たすもう一つの要素がVariational Autoencoders(VAE)です。VAEは、見かけ上ランダムな数値から写真のような写実的な画像を作成する能力で注目されています。これはどのように実現されるのでしょうか?これらの数値を潜在ベクトルを介して処理することで、人間の美学の複雑さを反映した芸術が生まれます。

生成AIのタイプ:テキストからテキスト、テキストから画像

トランスフォーマーとLLM

Google Brainによる論文「Attention Is All You Need」は、テキストモデリングについての考え方の変化を示しました。再帰型ニューラルネットワーク(RNN)や畳み込みニューラルネットワーク(CNN)のような複雑で順次的なアーキテクチャではなく、トランスフォーマーモデルはコンテキストに応じて入力テキストの異なる部分に焦点を当てるアテンションの概念を導入しました。これにより、並列化が容易になりました。テキストを順次処理するRNNとは異なり、トランスフォーマーはテキストの一部を同時に処理できるため、大規模なデータセットでのトレーニングがより速く効率的に行えるのです。

- トランスフォーマーモデルのアーキテクチャ

長いテキストでは、読む毎にすべての単語や文が同じ重要性を持つわけではありません。コンテキストに基づいて関連性に応じて焦点を変える能力が、アテンションメカニズムが模倣するものです。

これを理解するために、次の文を考えてみてください。「Unite AI Publish AI and Robotics news.」次の単語を予測するには、前のコンテキストで重要な事柄を理解する必要があります。「Robotics」という用語は、次の単語がロボティクス分野の特定の進歩やイベントに関連している可能性があることを示唆しています。「Publish」は、次のコンテキストが最近の出版物や記事について掘り下げる可能性があることを示唆しています。

- 自己注意のイラスト

Transformerにおけるアテンションメカニズムは、この選択的な焦点を実現するために設計されています。入力テキストの異なる部分の重要性を測定し、応答を生成する際の「注目すべき場所」を決定します。これは、RNNなどの古いアーキテクチャとは異なり、すべての入力テキストの本質を1つの「状態」または「メモリ」に詰め込もうとするものではありません。

アテンションの働きは、キーと値の検索システムに喩えることができます。文の次の単語を予測しようとする際、それぞれの前の単語は「キー」としてその潜在的な関連性を示し、これらのキーが現在のコンテキスト(またはクエリ)とどれだけ一致するかに基づいて、予測に「値」または重みを貢献します。

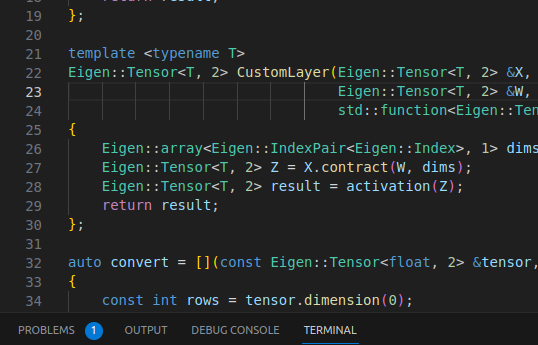

これらの高度なAIディープラーニングモデルは、BERTを使用したGoogleの検索エンジンの強化から、GitHubのCopilotに至るまで、さまざまなアプリケーションにシームレスに統合されています。Copilotは、大規模言語モデル(LLM)の能力を利用して、単純なコードスニペットを完全なソースコードに変換します。

GPT-4、Bard、LLaMAなどの大規模言語モデル(LLM)は、人間の言語、コードなどを解読および生成するために設計された巨大な構築物です。その巨大なサイズは、数十億から数兆のパラメーターに及ぶものであり、その特徴の1つです。これらのLLMは膨大な量のテキストデータを与えられ、人間の言語の複雑さを理解する能力を持っています。これらのモデルの印象的な特徴の1つは、「フューショット」学習の能力です。通常のモデルは特定のトレーニングデータの大量の必要がありますが、LLMは非常に限られた数の例(または「ショット」)から一般化することができます。

2023年中盤以降の大規模言語モデル(LLM)の状況

| モデル名 | 開発者 | パラメーター | 利用可能性とアクセス | 注目すべき特徴と備考 |

| GPT-4 | OpenAI | 1.5兆 | オープンソースではなく、APIアクセスのみ | さまざまなタスクで印象的なパフォーマンスを発揮し、画像やテキストを処理できます。最大入力長は32,768トークンです。 |

| GPT-3 | OpenAI | 1750億 | オープンソースではなく、APIアクセスのみ | フューショットおよびゼロショット学習の能力を実証しました。自然言語でのテキスト補完を行います。 |

| BLOOM | BigScience | 1760億 | ダウンロード可能なモデル、ホステッドAPIが利用可能 | グローバルなコラボレーションによって開発された多言語対応のLLMです。13のプログラミング言語をサポートしています。 |

| LaMDA | 1730億 | オープンソースではなく、APIやダウンロードは提供されていません | 対話を基にトレーニングされ、ほとんど何にでも話すことを学ぶことができます | |

| MT-NLG | Nvidia/Microsoft | 5300億 | 申請によるAPIアクセス | さまざまなNLPタスクに対してトランスフォーマーベースのMegatronアーキテクチャを利用します。 |

| LLaMA | Meta AI | 70億から650億 | 申請によるダウンロード可能 | 研究、政府、学界の人々にアクセスを提供することで、AIの民主化を目指しています。 |

LLMの使い方は?

LLMは、次のような複数の方法で使用することができます:

- 直接利用:事前学習済みのLLMをテキスト生成や処理に使用する方法です。例えば、追加の微調整なしでGPT-4を使用してブログ記事を書くことができます。

- 微調整:特定のタスクに事前学習済みのLLMを適応させる方法で、転移学習として知られています。例えば、特定の業界のドキュメントの要約を生成するためにT5をカスタマイズすることです。

- 情報検索:BERTやGPTなどのLLMを使用して、情報を取得し分類するシステムを開発するための大規模なアーキテクチャの一部として使用する方法です。

- ChatGPTの微調整アーキテクチャ

マルチヘッドアテンション:一つではなく複数を使う理由

ただし、単一のアテンション機構に頼ることは制限があります。テキスト内の異なる単語やシーケンスは、異なる関連性や関連性の種類を持つ場合があります。ここで、マルチヘッドアテンションが登場します。マルチヘッドアテンションは、1つのアテンション重みのセットではなく、複数のセットを使用し、モデルが入力テキストのより豊富な関係性を捉えることができるようにします。各アテンション “ヘッド”は、入力の異なる部分や側面に焦点を当てることができ、それらの組み合わせた知識が最終的な予測に使用されます。

ChatGPT:最も人気のある生成AIツール

2018年のGPTの発表以来、モデルは基本的に12層、12のアテンションヘッド、1億2000万のパラメータを基に構築され、主にBookCorpusと呼ばれるデータセットでトレーニングされました。これは言語モデルの未来を垣間見るものでした。

2019年に発表されたGPT-2では、層数とアテンションヘッド数が4倍に増加しました。重要なのは、パラメータ数が15億に跳ね上がったことです。この強化バージョンはWebTextと呼ばれるデータセットからトレーニングされ、様々なRedditのリンクから収集された40GBのテキストで充実させられました。

2020年5月に発表されたGPT-3は、96層、96のアテンションヘッド、1750億の巨大なパラメータ数を持っていました。GPT-3の特徴は、CommonCrawl、WebText、英語のWikipedia、書籍コーパスなどの多様なトレーニングデータで、合計570GBをカバーしていたことです。

ChatGPTの動作の詳細は、秘密にされています。ただし、「人間のフィードバックからの強化学習」(RLHF)と呼ばれるプロセスが重要であることは知られています。以前のChatGPTプロジェクトから発展したこの技術は、GPT-3.5モデルを書かれた指示とより一致させるために重要な役割を果たしました。

ChatGPTのトレーニングは、次の3つの段階で行われます:

- 教師付き微調整:人間が書いた会話の入出力を選定し、基礎となるGPT-3.5モデルを改良します。

- 報酬モデリング:人間がさまざまなモデルの出力を品質に基づいてランク付けし、会話の文脈を考慮に入れて各出力をスコアリングする報酬モデルをトレーニングします。

- 強化学習:会話の文脈は背景として機能し、基礎モデルが応答を提案します。この応答は報酬モデルによって評価され、近接方策最適化(PPO)というアルゴリズムを使用してプロセスが最適化されます。

ChatGPTに初めて触れる方には、こちらで包括的なスタートガイドが見つかります。ChatGPTとのプロンプトエンジニアリングにより深く探求したい場合は、最新の最先端のプロンプト技術についての高度なガイドもご用意しています。『ChatGPT&高度なプロンプトエンジニアリング:AI進化を推進する』で入手可能です。

拡散とマルチモーダルモデル

VAEやGANのようなモデルは単一のパスで出力を生成しますが、拡散モデルでは「反復的な改善」という概念を導入しました。この方法では、前のステップでの誤りを修正し、徐々により洗練された結果を生み出すために、再度戻ってきます。

拡散モデルの中心にあるのは、「破損」と「改善」というアートです。トレーニングフェーズでは、典型的な画像は段階的にノイズを加えることで進行的に破損させられます。このノイズの入ったバージョンは、モデルに供給され、ノイズを取り除くことを試みます。これを複数回繰り返すことで、モデルは修復に長け、微妙な変化や重要な異常を理解することができるようになります。

- Midjourneyから生成された画像

トレーニング後に新しい画像を生成するプロセスは興味深いものです。完全にランダム化された入力から始まり、モデルの予測を使って絶えず改善されます。目的は、最小限のステップで完璧な画像を得ることです。汚染レベルのコントロールは、「ノイズスケジュール」というメカニズムを通じて行われます。このメカニズムは、異なるステージでどれだけのノイズが適用されるかを制御します。さまざまなアルゴリズムに基づいてノイズの変奏を行う「diffusers」などのライブラリで見られるスケジューラが、これらのノイズの変奏の性質を定めます。

多くの拡散モデルにとって重要なアーキテクチャのバックボーンは、UNetです。これは、入力と同じ空間次元の出力を必要とするタスクに適した畳み込みニューラルネットワークです。ダウンサンプリングとアップサンプリングのレイヤーが組み合わされ、高解像度のデータを保持するために複雑に接続されており、画像関連の出力に重要な役割を果たします。

生成モデルの領域により深く入り込むと、OpenAIのDALL-E 2は、テキストとビジュアルのAIの能力の融合の光る例として現れます。それは3層の構造を採用しています:

DALL-E 2は、以下の3つの構成で構成されます:

- テキストエンコーダ:テキストプロンプトを潜在空間内の概念的な埋め込みに変換します。このモデルはゼロから始めるのではありません。OpenAIのコントラスティブ言語-画像事前トレーニング(CLIP)データセットを基盤としています。CLIPは、自然言語を使用して視覚的な概念を学習することにより、視覚的データとテキストデータの間の橋渡し役となります。対照学習というメカニズムを介して、それは画像をそれに対応するテキストの説明と一致させます。

- 事前モデル:エンコーダから得られたテキストの埋め込みは、次に画像の埋め込みに変換されます。DALL-E 2では、このタスクに対して自己回帰モデルと拡散モデルの両方をテストしましたが、後者の方が優れた結果を示しました。トランスフォーマーやPixelCNNなどで見られる自己回帰モデルは、シーケンスで出力を生成します。一方、DALL-E 2で使用されている拡散モデルは、テキストの埋め込みの助けを借りて、ランダムなノイズを予測された画像の埋め込みに変換します。

- デコーダ:このプロセスのクライマックスとなる部分で、テキストプロンプトと事前フェーズからの画像の埋め込みに基づいて最終的な視覚的な出力を生成します。DALL.E 2のデコーダは、もう1つのモデルであるGLIDEのアーキテクチャに負っており、テキストの手がかりからも現実的な画像を生成することができます。

- DALL-Eモデルの簡略化されたアーキテクチャ

Langchainに興味のあるPythonユーザーは、基礎から高度な技術までを網羅した詳細なチュートリアルをチェックする必要があります。

生成AIの応用

テキスト領域

テキストを出発点として、ChatGPTなどのチャットボットによって生成AIは根本的に変革されています。自然言語処理(NLP)と大規模言語モデル(LLM)に重点を置いており、これらのエンティティはコード生成や言語翻訳、要約、感情分析などのタスクを実行するために力を発揮しています。例えば、ChatGPTは広範な採用を見ており、何百万ものユーザーにとって重要な存在となっています。これに加えて、GPT-4、PaLM、BLOOMなどのLLMに基づく会話型AIプラットフォームがあり、テキストを容易に生成し、プログラミングを支援し、数学的な推論を提供します。

商業的な観点から見ると、これらのモデルは非常に貴重な存在となっています。企業は、リスク管理、在庫最適化、需要予測などのさまざまな操作にこれらを活用しています。Bing AI、GoogleのBARD、ChatGPT APIなどがその代表的な例です。

アート

DALL-E 2の登場以来、生成AIによって画像の世界は劇的な変革を遂げています。テキストのプロンプトから画像を生成するこの技術には、芸術的な側面と専門的な側面の両方があります。例えば、midjourneyはこの技術を活用して非常に現実的な画像を生成しています。この最近の記事では、Midjourneyを詳細に紹介し、プラットフォームとプロンプトエンジニアリングの複雑さを解説しています。さらに、Alpaca AIやPhotoroom AIなどのプラットフォームは、背景の削除、オブジェクトの削除、さらには顔の修復など、高度な画像編集機能に生成AIを利用しています。

ビデオ制作

ビデオ制作は、生成AIの領域ではまだ初期の段階にありますが、有望な進展を見せています。Imagen Video、Meta Make A Video、Runway Gen-2などのプラットフォームは、可能な範囲を広げており、まだ本当に現実的な出力は遠い将来の話です。これらのモデルは、デジタルヒューマンビデオを作成するために大きな効用を提供しており、SynthesiaやSuperCreatorなどのアプリケーションが先導しています。特に、Tavus AIは個々の視聴者に対してビデオをパーソナライズするというユニークなセールスポイントを提供しており、企業にとって重要な利点となっています。

コード作成

コーディングは、私たちのデジタルワールドにおいて欠かせない要素であり、Generative AIによっても無視されていません。ChatGPTは好まれるツールですが、コーディングの目的で開発された他のAIアプリケーションもあります。GitHub CopilotやAlphacode、CodeCompleteなどのプラットフォームは、コーディングの補助をするだけでなく、テキストのプロンプトからコードを生成することさえ可能です。興味深いのは、これらのツールの適応性です。GitHub Copilotの背後にあるCodexは、個々のコーディングスタイルに合わせてカスタマイズすることができ、Generative AIの個人化の可能性を強調しています。

結論

人間の創造性と機械の計算を融合させることで、ChatGPTやDALL-E 2などのプラットフォームは、考えられる範囲の限界を押し上げた貴重なツールに進化しました。テキストコンテンツの作成から視覚的な傑作の制作まで、その応用範囲は広範かつ多様です。

どんな技術にも倫理的な影響が重要です。Generative AIは無限の創造性を約束している一方で、潜在的な偏見やデータ操作の力に気をつけることが重要です。

ChatGPTのようなツールがよりアクセスしやすくなっている今、今が試してみる絶好の機会です。アーティスト、コーダー、テクノロジーエンスージアストであろうと、Generative AIの領域には探求すべき可能性が豊富に存在しています。革命は遠い未来ではなく、今ここにあります。ですから、飛び込んでください!

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「Retroformer」をご紹介します:プラグインの回顧モデルを学習することで、大規模な言語エージェントの反復的な改善を実現する優れたAIフレームワーク

- 「集団行動のデコード:アクティブなベイズ推論が動物グループの自然な移動を支える方法」

- このAI論文では、これらの課題に対処しながらMoEsの利点を維持するために、完全に微分可能な疎なTransformerであるSoft MoEを提案しています

- 「生成モデルを本番環境に展開する際の3つの課題」

- 「Javaプログラミングの未来:2023年に注目すべき5つのトレンド」

- 「人工知能(AI)とWeb3:どのように関連しているのか?」

- AWSは、大規模なゲーミング会社のために、Large Language Model (LLM) を使って有害なスピーチを分類するためのファインチューニングを行います