大規模なMLライフサイクルの統治、パート1:Amazon SageMakerを使用してMLワークロードを設計するためのフレームワーク

大規模なMLライフサイクルの統治、パート1:Amazon SageMakerを活用したMLワークロードの設計フレームワーク

あらゆるサイズと産業の顧客は、機械学習(ML)を製品やサービスに取り入れることでAWS上で革新的な取り組みをしています。生成AIモデルの最近の発展は、産業全体でのMLの採用の必要性をさらに高めています。ただし、安全性、データプライバシー、ガバナンスのコントロールを実施することは、MLワークロードの展開時に顧客が直面する主要な課題です。これらの課題に取り組むことは、リスクの緩和とML駆動の製品の責任ある利用のためのフレームワークと基盤を構築するものです。生成AIには追加のコントロールが必要な場合がありますが、セキュリティとガバナンスのための基本要素は従来のMLと同じです。

顧客からは、は自社のビジネス部門(LOB)やMLチームのためのスケーラブルで信頼性のある、安全かつガバナンスされたML環境を確保するために、最大12ヶ月の専門知識と投資が必要だという声を聞いています。スケールでMLライフサイクルをガバンするためのフレームワークがない場合、チームレベルのリソースの分離、実験リソースの拡張、MLワークフローの業務運用化、モデルのガバナンスのスケーリング、MLワークロードのセキュリティとコンプライアンスの管理などの課題に直面する可能性があります。

スケールでMLライフサイクルをガバンするためのフレームワークは、業界のベストプラクティスとエンタープライズの標準に基づいて、埋め込まれたセキュリティとガバナンスのコントロールを備えたMLプラットフォームを構築するのに役立つフレームワークです。このフレームワークは以下のMLプラットフォームの機能に対して具体的なガイダンスを提供します:

- マルチアカウント、セキュリティ、およびネットワーキングの基盤 – この機能は、AWS Control Towerとウェルアーキテクチュアの原則を使用して、マルチアカウント環境、セキュリティ、およびネットワーキングサービスを設定および運用します。

- データとガバナンスの基盤 – この機能は、データレイク、中央のフィーチャーストア、およびデータガバナンスの基盤を設定および運用するためのデータメッシュアーキテクチャを使用します。

- MLプラットフォームの共有とガバナンスサービス – この機能は、CI/CDや環境のプロビジョニングのためのAWS Service Catalog、モデルのプロモーションとラインナップのための中央モデルレジストリなど、共通のサービスの設定および運用を可能にします。

- MLチーム環境 – この機能は、セキュリティとガバナンスのコントロールを埋め込みながら、MLチームがモデルの開発、テスト、展開を行うための環境の設定と運用を可能にします。

- MLプラットフォームの可観測性 – この機能は、ログの集中化とログ分析可視化ツールの提供によって、MLモデルのトラブルシューティングと問題の原因特定を支援します。さらに、MLユースケースのコストと使用状況レポートの生成についてのガイダンスも提供します。

このフレームワークはすべての顧客に利益をもたらすことができますが、特に大手、成熟、規制された、またはグローバル企業の顧客にとって有益です。制御された、コンプライアンスを備えた組織全体でのML戦略の拡大を支援します。このフレームワークは以下のような顧客に役立ちます:

- MLを使用したいと考えている多くのLOBや部門を持つ大企業の顧客。このフレームワークでは、異なるチームが独自のMLモデルを構築・展開することができる一方で、中央のガバナンスを提供します。

- MLにおける中程度から高い成熟度を持つエンタープライズの顧客。彼らはすでにいくつかの初期のMLモデルを展開しており、MLの取り組みを拡大しようとしています。このフレームワークは組織全体でのMLの採用を加速させるのに役立ちます。また、アクセス制御、データ使用、モデルのパフォーマンス、不公平なバイアスなど、ガバナンスの必要性も認識しています。

- 金融サービス、ヘルスケア、化学、民間セクターなどの規制業界の企業。これらの企業は、ビジネスプロセスで使用されるMLモデルに対して強力なガバナンスと監査能力が必要です。このフレームワークの採用は、現地のモデル開発を許容しながらコンプライアンスを支援するのに役立ちます。

- 集中化と現地のコントロールをバランスさせる必要があるグローバル組織。このフレームワークの連邦アプローチにより、中央のプラットフォームエンジニアリングチームがいくつかのハイレベルなポリシーと標準を設定することができますが、LOBチームは現地のニーズに応じて適応する柔軟性を持つことができます。

このシリーズの最初の部分では、MLプラットフォームの参照アーキテクチャを設定するためのガイドを紹介します。後の投稿では、参照アーキテクチャのさまざまなモジュールを組織内で実装するための具体的なガイダンスを提供します。

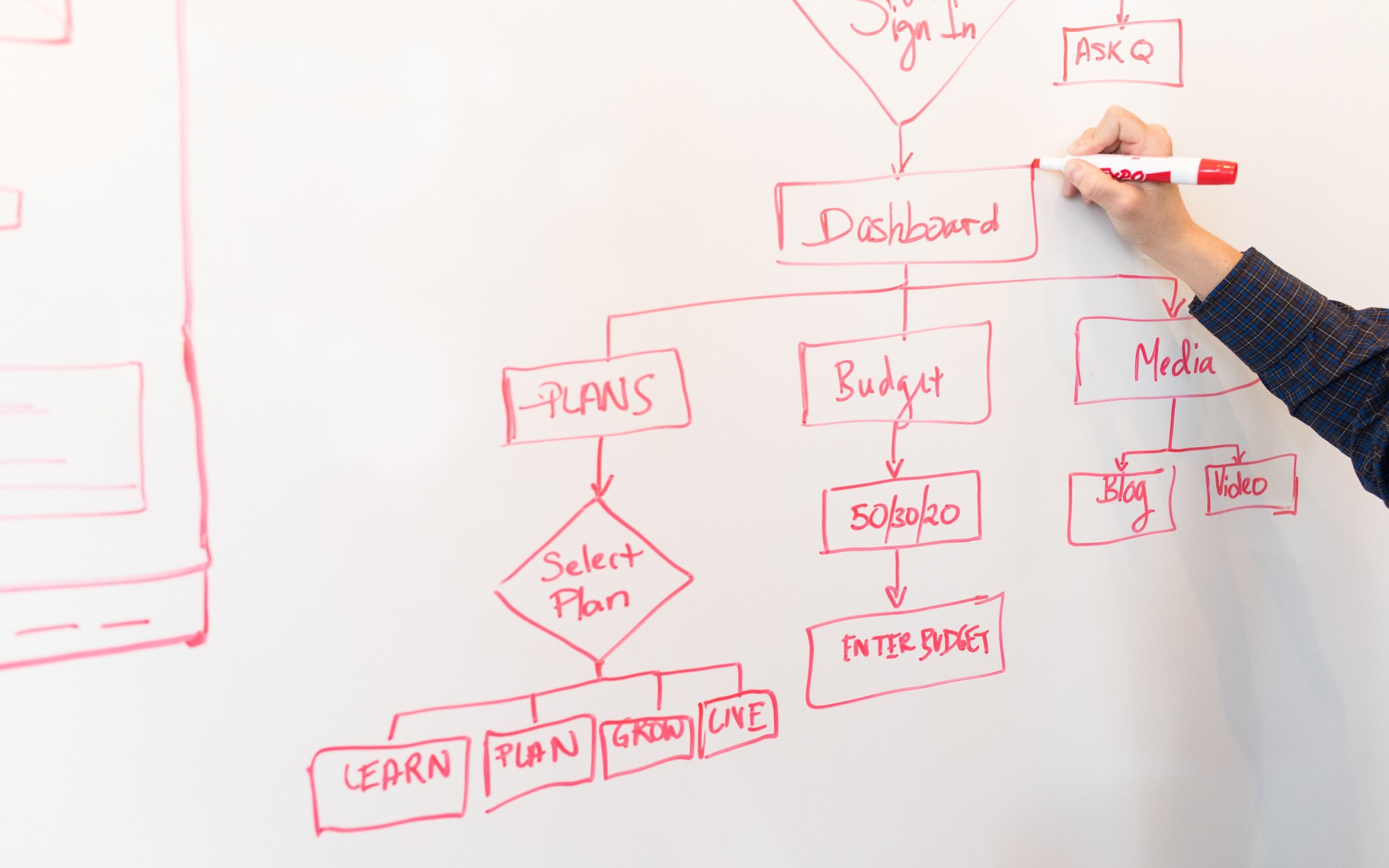

MLプラットフォームの機能は以下の図に示すように、4つのカテゴリに分類されます。これらの機能は、後の投稿で詳しく説明される参照アーキテクチャの基盤となります:

- MLの基盤を構築する

- MLの運用をスケールする

- MLを観察する

- MLを保護する

解決策の概要

スケールに対応したMLライフサイクルのガバナンスフレームワークは、セキュリティとガバナンスのコントロールを埋め込むことで、組織がMLを製品やサービスに組み込みながらリスクを削減し、ML環境をセキュアかつスケーラブルで信頼性のあるものにするためのフレームワークです。このフレームワークによって以下の機能が可能となります:

- 組織ポリシーに準拠したインフラリソースのアカウントとインフラストラクチャのプロビジョニング

- データサイエンス環境とエンドツーエンドのML操作(MLOps)テンプレートのセルフサービスデプロイメント

- セキュリティとプライバシーのコンプライアンスを考慮したLOBレベルまたはチームレベルの資源の分離

- 実験や本番用のワークフローに対する製品グレードのデータへのガバナンスされたアクセス

- コードリポジトリ、コードパイプライン、デプロイされたモデル、データの特徴量の管理とガバナンス

- ガバナンスを向上させるモデルレジストリと特徴量ストア(ローカルと中央のコンポーネント)

- エンドツーエンドのモデル開発とデプロイプロセスのセキュリティとガバナンスのコントロール

このセクションでは、AWS上にセキュリティとガバナンスのコントロールを組み込んだこのMLプラットフォームを構築するための具体的なガイダンスの概要を提供します。

MLプラットフォームに関連する機能アーキテクチャは以下のダイアグラムに示されています。このアーキテクチャは、MLプラットフォームのさまざまな機能をAWSアカウントにマッピングしています。

さまざまな機能を持つ機能アーキテクチャは、AWS Organizations、SageMaker、AWS DevOpsサービス、およびデータレイクを含む複数のAWSサービスを使用して実装されます。さまざまなAWSサービスを使用したMLプラットフォームの参照アーキテクチャは、次のダイアグラムに示されています。

このフレームワークでは、複数の人物とサービスがスケールに対応したMLライフサイクルをガバナンスします。チームとサービスを組織するために以下の手順をお勧めします:

- AWS Control Towerと自動化ツールを使用して、クラウド管理者が組織とAWS IAM Identity Center(AWS Single Sign-Onの後継)やAWS Key Management Service(AWS KMS)やService Catalogなどのセキュリティとガバナンスサービスを含むマルチアカウントの基盤を設定します。また、管理者はMLと分析のワークフローをサポートするためのさまざまな組織単位(OU)と初期アカウントを設定します。

- データレイク管理者はデータレイクとデータカタログを設定し、MLプラットフォーム管理者と協力して中央の特徴量ストアを設定します。

- MLプラットフォーム管理者は、MLチーム向けにAWS CodeCommit、AWS CodePipeline、Amazon Elastic Container Registry(Amazon ECR)、中央のモデルレジストリ、SageMaker Model Cards、SageMaker Model Dashboard、およびMLチーム向けのService Catalog製品などのML共有サービスをプロビジョニングします。

- MLチームリーダーはIAM Identity Centerを介して認証し、Service Catalog製品を使用してMLチームの開発環境にリソースをプロビジョニングします。

- MLチームのデータサイエンティストは、それぞれのチームの開発環境にフェデレーションし、モデルパイプラインを構築します。

- データサイエンティストは、中央の特徴量ストアカタログから特徴量を検索して取得し、実験を通じてモデルを構築し、プロモーションのための最適なモデルを選択します。

- データサイエンティストは、新しい特徴量を中央の特徴量ストアカタログに作成して共有します。

- MLエンジニアは、共有サービスのCI/CDプロセスを使用して、MLチームのテスト環境にモデルパイプラインをデプロイします。

- 利害関係者の検証後、MLモデルはチームの本番環境にデプロイされます。

- セキュリティとガバナンスのコントロールは、このアーキテクチャの各レイヤーに埋め込まれ、AWS Security Hub、Amazon GuardDuty、Amazon Macieなどのサービスを使用して実現されます。

- セキュリティコントロールは、セキュリティツールアカ

次に、このフレームワークの参照アーキテクチャのモジュールについて詳しく説明します。

参照アーキテクチャモジュール

参照アーキテクチャには、特定の問題を解決するために設計された8つのモジュールが含まれています。これらのモジュールは、インフラストラクチャ、データ、モデル、コストなど、さまざまな側面でガバナンスを実現しています。各モジュールは異なる機能セットを提供し、他のモジュールと相互運用して組み込みのセキュリティとガバナンスコントロールを備えた統合エンドツーエンドのMLプラットフォームを提供します。このセクションでは、各モジュールの機能の概要を短く紹介します。

マルチアカウントの基盤

このモジュールは、クラウド管理者がAWS Control Tower着陸ゾーンを基礎としたフレームワークを構築するのに役立ちます。これには、マルチアカウント構造、IAM Identity Centerによる認証および承認、ネットワークのハブアンドスポーク設計、集中化されたログサービス、および標準化されたセキュリティおよびガバナンスのベースラインを持つ新しいAWSメンバーアカウントが含まれます。

さらに、このモジュールでは、MLおよび分析ワークフローをサポートするために適切なOUとアカウント構造に関するベストプラクティスのガイダンスが提供されます。クラウド管理者は、必要なアカウントとOUの目的、それらの展開方法、およびセキュリティとコンプライアンスのために中央でガバナンスを行うために使用すべき主要なサービスについて理解することができます。

新しいアカウントの販売フレームワークも取り上げられており、アカウントがプロビジョニングされるときに新しいアカウントのベースラインを自動化するための方法が説明されています。自動化されたアカウントプロビジョニングプロセスを設定することで、クラウド管理者はMLおよび分析チームに必要なアカウントをより迅速に提供できるだけでなく、堅牢なガバナンスの基盤を犠牲にすることなく提供することができます。

データレイクの基盤

このモジュールでは、データレイク管理者がデータを取り込み、データセットを編成し、AWS Lake Formationガバナンスモデルを使用してアカウントとユーザー間での詳細なデータアクセスを管理するためのデータレイクを構築するのに役立ちます。これには、集中化されたデータカタログ、データアクセスポリシー、タグベースのアクセス制御を使用します。証明概念やいくつかの小規模なワークロードに対しては、データプラットフォームの基礎となる1つのアカウントから始めることができます。VoAGIから大規模な本番ワークロードの実装には、マルチアカウント戦略の採用をおすすめします。このような設定では、LOBは異なるAWSアカウントを使用してデータプロデューサーおよびデータコンシューマーの役割を担い、データレイクのガバナンスは中央共有のAWSアカウントから運営されます。データプロデューサーは、データドメインからデータを収集、処理、保管し、データ資産の品質を監視および確保します。データコンシューマーは、中央カタログによって共有されたデータを使用してデータプロデューサーからデータを消費します。中央カタログは、データプロデューサーアカウントのための共有データカタログを保存および管理します。

MLプラットフォームサービス

このモジュールは、データサイエンスチームがチームアカウントで使用する共有サービスを設定するためにMLプラットフォームエンジニアリングチームをサポートします。これらのサービスには、SageMakerドメインの展開に使用されるService Catalogポートフォリオ、SageMakerドメインユーザープロファイルの展開、モデル構築と展開のためのデータサイエンスモデルテンプレートが含まれます。このモジュールには、中央モデルレジストリ、モデルカード、モデルダッシュボード、およびモデル開発と展開ワークフローのオーケストレーションと自動化に使用されるCI/CDパイプラインの機能もあります。

さらに、このモジュールでは、パーソナベースのセルフサービス機能を実現するために必要なコントロールとガバナンスの実装方法についても詳しく説明されており、データサイエンスチームが自律的に必要なクラウドインフラストラクチャとMLテンプレートを展開できるようにしています。

MLユースケース開発

このモジュールでは、LOBおよびデータサイエンティストが開発環境でチームのSageMakerドメインにアクセスし、モデル構築テンプレートをインスタンス化してモデルを開発するのに役立ちます。このモジュールでは、データサイエンティストは、中央データレイク上で利用可能なデータと対話し、中央のフィーチャストアからフィーチャを再利用および共有し、ML実験を作成および実行し、MLワークフローを構築およびテストし、開発環境のデベロップアカウントモデルレジストリにモデルを登録します。

実験のトラッキング、モデルの説明可能性レポート、データとモデルのバイアスモニタリング、モデルレジストリなどの機能もテンプレート内で実装されており、データサイエンティストが開発したモデルを迅速に適応させることができます。

MLオペレーション

このモジュールは、LOB(Line of Business)およびML(Machine Learning)エンジニアが、モデル展開テンプレートの開発用インスタンスで作業するのを支援します。候補モデルが登録および承認された後、彼らはCI/CDパイプラインを設定し、MLワークフローをチームのテスト環境で実行します。これにより、モデルがプラットフォームの共有サービスアカウントで実行されている中央モデルレジストリに登録されます。中央モデルレジストリでモデルが承認されると、これによってCI/CDパイプラインがトリガーされ、モデルがチームの本番環境に展開されます。

集中型フィーチャーストア

最初のモデルが本番環境に展開され、複数のユースケースが同じデータから作成されたフィーチャーを共有するようになると、フィーチャーストアは重要になります。これにより、ユースケース間での協力と重複作業の削減が保証されます。このモジュールは、MLプラットフォームエンジニアリングチームが、MLユースケースによって作成されたMLフィーチャーのためのストレージとガバナンスを提供する、集中型フィーチャーストアの設定を支援します。これにより、プロジェクト間でのフィーチャーの再利用が可能になります。

ログと可観測性

このモジュールは、LOBおよびMLの実践者が、CloudTrail、CloudWatch、VPCフローログ、およびMLワークロードログなどのログアクティビティを統合することにより、ML環境全体の状態を可視化するのを支援します。チームはログをフィルタリング、クエリ、可視化して分析することができ、セキュリティポジションの向上にも役立ちます。

コストとレポート

このモジュールは、さまざまな関係者(クラウド管理者、プラットフォーム管理者、クラウドビジネスオフィス)が、MLユーザー、MLチーム、およびML製品レベルのコストを分解し、ユーザー数、インスタンスタイプ、エンドポイントなどの使用状況を追跡するためのレポートとダッシュボードを生成するのを支援します。

お客様からは、どれくらいのアカウントを作成し、それらのアカウントをどのように構成するかについてのガイダンスが求められています。次のセクションでは、エンタープライズガバナンスの要件に従って、必要に応じてカスタマイズできる、アカウント構造についてのガイダンスを提供します。

参考アカウント構造

このセクションでは、アカウント構造の組織化についての推奨事項を説明します。ベースラインの参考アカウント構造を共有しますが、MLおよびデータ管理者は、組織のコントロールに基づいて、このアカウント構造をカスタマイズするためにクラウド管理者と密接に連携することをお勧めします。

セキュリティ、インフラ、ワークロード、および展開のためにOU(組織単位)ごとにアカウントを組織化することをお勧めします。さらに、各OU内ではプロダクションと非プロダクションのOUで組織化することをお勧めします。なぜなら、それらのアカウントと展開されたワークロードには異なるコントロールが存在するためです。次に、これらのOUについて簡単に説明します。

セキュリティOU

このOU内のアカウントは、組織のクラウド管理者またはセキュリティチームによって、セキュリティイベントの監視、識別、保護、検出、および対応を行うために管理されます。

インフラストラクチャOU

このOU内のアカウントは、組織のクラウド管理者またはネットワークチームによって、エンタープライズレベルの共有リソースとネットワークの管理を行うために管理されます。

次のアカウントをインフラストラクチャOUの下に設定することをお勧めします:

- ネットワーク – AWS Transit Gatewayなど、集中化されたネットワーキングインフラストラクチャの設定

- 共有サービス – 集中化されたADサービスとVPCエンドポイントの設定

ワークロードOU

このOU内のアカウントは、組織のプラットフォームチームの管理者によって管理されます。各プラットフォームチームごとに異なるコントロールを実装する必要がある場合は、MLワークロードOU、データワークロードOUなどの目的に応じた他のレベルのOUをネストすることができます。

ワークロードOUの下には、次のアカウントをお勧めします:

- チームレベルのML開発、テスト、および本番アカウント – ワークロードの分離要件に基づいて設定してください

- データレイクアカウント – データドメインごとにアカウントを分割してください

- 中央データガバナンスアカウント – データアクセスポリシーを集中管理してください

- 中央フィーチャーストアアカウント – チーム間での共有のためのフィーチャーを集中管理してください

展開OU

このOU内のアカウントは、組織のプラットフォームチームの管理者によって、ワークロードと可観測性の展開を行うために管理されます。

MLプラットフォームチームがデプロイメントOUの下におすすめのアカウントをご紹介します。このOUレベルでさまざまなコントロールをセットアップしてデプロイメントを管理できます。

- テストおよび本番用のML共有サービスアカウント – プラットフォーム共有サービスのCI/CDとモデルレジストリをホストします

- テストおよび本番用のML監視アカウント – CloudWatchログ、CloudTrailログ、およびその他の必要なログをホストします

次に、インフラストラクチャリソースを監視するためにメンバーアカウントに埋め込む必要がある組織のコントロールについて簡単に説明します。

AWS環境コントロール

コントロールは、AWS環境全体の持続的なガバナンスを提供する高レベルのルールです。これは平易な言葉で表現されます。このフレームワークでは、以下のコントロールを実装するためにAWS Control Towerを使用します。これにより、AWSアカウントのグループ全体でリソースをガバナンスし、コンプライアンスを監視することができます。

- 予防的なコントロール – 予防的なコントロールは、ポリシー違反につながるアクションを許可せず、アカウントのコンプライアンスを維持するようにします。これはサービスコントロールポリシー(SCP)を使用して実装されます。たとえば、AWSアカウントやリージョンでCloudTrailの削除や停止が不可能となる予防的なコントロールを設定できます。

- 探知的なコントロール – 探知的なコントロールは、アカウント内のリソースの非コンプライアンス(ポリシー違反など)を検出し、ダッシュボードを通じてアラートを提供します。これはAWS Configのルールを使用して実装されます。たとえば、ログアーカイブ共有アカウントのAmazon Simple Storage Service(Amazon S3)バケットにパブリックの読み取りアクセスが有効化されていないかどうかを検出する探知的なコントロールを作成できます。

- プロアクティブなコントロール – プロアクティブなコントロールは、リソースのプロビジョニング前にそのコントロールに準拠していることを確認し、コンプライアンスでない場合はリソースをプロビジョニングしないようにします。これはAWS CloudFormationフックを使用して実装されます。たとえば、SageMakerのノートブックインスタンスに対して直接インターネットアクセスが許可されていないことを確認するプロアクティブなコントロールを設定できます。

MLプラットフォームサービス、MLユースケース、およびMLオペレーション間の相互作用

データサイエンス責任者(主任データサイエンティスト)、データサイエンティスト、およびMLエンジニアなどの異なる人物がMLプラットフォームサービスやMLユースケースの開発、MLオペレーション、データレイクの基盤、および中央特徴ストアを使用してモジュール2〜6を操作します。

以下の表は、さまざまな人物に対するオペレーションフローの活動とセットアップフローのステップをまとめたものです。人物がオペレーションフローの一環としてMLアクティビティを開始すると、セットアップフローのステップに従ってサービスが実行されます。

人物 オペレーションフローの活動 – 番号 オペレーションフローの活動 – 説明 セットアップフローのステップ – 番号 セットアップフローのステップ – 説明 データサイエンス責任者またはMLチームリード 1 MLプラットフォームサービスアカウントのサービスカタログを使用して以下をデプロイします:

-

- MLインフラストラクチャー

- SageMaker

プロジェクト – SageMaker

モデルレジストリ

1-A - LOB向けの開発、テスト、および本番環境を設定します

- MLプラットフォームサービスアカウントにSageMaker Studioを設定します

1-B - 必要な構成でSageMaker Studioを設定します

データサイエンティスト 2 SageMakerノートブックでML実験を実施・追跡します 2-A - データをデータレイクから使用します

Formation – 特徴を中央特徴ストアに保存します

3 SageMakerプロジェクトとパイプラインで成功したML実験を自動化します 3-A -

- 開発環境でSageMakerパイプライン(前処理、トレーニング、評価)を開始します

開発アカウントでCodePipelineを使用してCI/CDプロセスを開始します

3-B SageMakerパイプラインが実行された後、モデルをローカル(開発)モデルレジストリに保存します データサイエンス責任者またはMLチームリード 4 ローカル(開発)モデルレジストリでモデルを承認します 4-A モデルのメタデータとモデルパッケージをローカル MLプラットフォームの異なるモジュールとのパーソナとの対話

各モジュールは、特定の部門内で最も頻繁にモジュールを利用する特定の対象パーソナに対して主要なアクセス権限を提供します。その後、モジュールの一時的な使用が必要な他の部門にはセカンダリなアクセス権限が付与されます。これらのモジュールは、特定の職務またはパーソナのニーズに合わせて最適な機能を提供するようにカスタマイズされています。

以下のチームについて説明します:

- セントラルクラウドエンジニアリング – このチームは、企業クラウドレベルでのすべてのワークロードに対して、エンタープライズレベルのネットワーキング、アイデンティティ、権限、アカウント管理などの共通クラウドインフラストラクチャサービスの設定を行います

- データプラットフォームエンジニアリング – このチームは、エンタープライズデータレイク、データ収集、データキュレーション、データガバナンスを管理します

- MLプラットフォームエンジニアリング – このチームは、MLプラットフォームレベルでLOB全体にわたる共有MLインフラストラクチャサービス(MLインフラストラクチャのプロビジョニング、実験の追跡、モデルガバナンス、デプロイメント、観測可能性など)を提供します

次のテーブルは、各モジュールのターゲットパーソナに基づいて、各部門が主要およびセカンダリのアクセス権限を持っているかどうかを詳細に示しています。

モジュール番号 モジュール 主要アクセス セカンダリアクセス 対象パーソナ アカウント数 1 マルチアカウントファウンデーション セントラルクラウドエンジニアリング 個別のLOB - クラウド管理者

- クラウドエンジニア

数人 2 データレイクファウンデーション セントラルクラウドまたはデータプラットフォームエンジニアリング 個別のLOB - データレイク管理者

- データエンジニア

複数 3 MLプラットフォームサービス セントラルクラウドまたはMLプラットフォームエンジニアリング 個別のLOB - MLプラットフォーム管理者

- MLチームリード

- MLエンジニア

- MLガバナンスリード

1人 4 MLユースケース開発 個別のLOB セントラルクラウドまたはMLプラットフォームエンジニアリング - データサイエンティスト

- データエンジニア

- MLチームリード

- MLエンジニア

複数 5 MLオペレーション セントラルクラウドまたはMLエンジニアリング 個別のLOB - MLエンジニア

- MLチームリード

- データサイエンティスト

複数 6 集中型フィーチャーストア セントラルクラウドまたはデータエンジニアリング 個別のLOB - データエンジニア

- データサイエンティスト

1人 7 ログと観測性 セントラルクラウドエンジニアリング 個別のLOB - クラウド管理者

- IT

監査

1人 8 コストとレポート 個別のLOB セントラルプラットフォームエンジニアリング - LOBエグゼクティブ

- MLマネージャー

1人 結論

この投稿では、セキュリティとガバナンスのコントロールが組み込まれたウェルアーキテクチャなMLワークロードを実装するためにスケールするMLライフサイクルのガバナンスフレームワークを紹介しました。データガバナンス、モデルガバナンス、およびエンタープライズレベルのコントロールを考慮したMLプラットフォームを構築するために、このフレームワークは包括的なアプローチを取ります。この投稿で紹介されたフレームワークと概念を試してみて、フィードバックを共有することをお勧めします。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 大規模言語モデルにおける推論力の向上:正確かつ転送可能なルールベース学習のための仮説から理論へ(HtT)フレームワークをご覧ください

- 「LlamaIndex vs LangChain 比較分析」

- RAGのNLPにおける検索と生成の統一的な革新的アプローチ

- 『Langchainを使って履歴書のランキングをマスターする方法』

- 探索的なノートブックの使い方[ベストプラクティス]

- 「高解像度画像を使用したAmazon Rekognitionカスタムラベルモデルによる欠陥検出」

- 私たちはハイパーリアルな人物画像を生成できるのか? このAI論文は、HyperHumanと呼ばれるテキストから画像へのモデルでの飛躍を提案しています