「AIフィードバックループ:AI生成コンテンツの時代におけるモデルの製品品質の維持」

AIフィードバックループ:AI生成コンテンツのモデル製品品質の維持

製品展開されたAIモデルには、堅牢かつ継続的なパフォーマンス評価メカニズムが必要です。これがAIフィードバックループが適用される場所であり、一貫したモデルのパフォーマンスを確保するために使用されます。

イーロン・マスクの言葉を借りましょう:

「自分が行ったことを常に考え、それをより良くできる方法について常に考えることが非常に重要だと思います。」

すべてのAIモデルに対して、標準的な手順はモデルを展開し、最新の現実世界のデータで定期的に再トレーニングしてパフォーマンスの低下を防ぐことです。しかし、ジェネレーティブAIの急速な台頭により、AIモデルのトレーニングは異常でエラーの発生しやすいものになりました。なぜなら、オンラインデータソース(インターネット)は人間が生成したデータとAIが生成したデータの混合になってきているからです。

- レコメンダーシステムにおけるマルチタスク学習:入門

- 「インコンテキスト学習について知っておくべきことすべて」

- PaLM-Eをご紹介します:新たな5620億パラメータの具現化された多モーダル言語モデルで、ロボットの操作計画やビジュアルQAなどのタスクを実行します

たとえば、多くのブログでは、ChatGPTやGPT-4のようなLLM(大規模言語モジュール)によって動作するAI生成のテキストが表示されています。多くのデータソースには、DALL-E2やMidjourneyを使用して作成されたAI生成の画像が含まれています。さらに、AI研究者はモデルのトレーニングパイプラインで生成されたジェネレーティブAIを使用した合成データを使用しています。

そのため、AIモデルの品質を確保するためには、堅牢なメカニズムが必要です。ここで、AIフィードバックループの必要性がより強調されています。

AIフィードバックループとは何ですか?

AIフィードバックループは、AIモデルの意思決定と出力が連続的に収集され、同じモデルを強化または再トレーニングするために使用される反復的なプロセスです。これにより、連続的な学習、開発、およびモデルの改善が行われます。このプロセスでは、AIシステムのトレーニングデータ、モデルのパラメータ、およびアルゴリズムがシステム内で生成された入力に基づいて更新および改善されます。

主に2種類のAIフィードバックループがあります:

- ポジティブなAIフィードバックループ: AIモデルがユーザーの期待と好みと一致した正確な結果を生成した場合、ユーザーはフィードバックループを通じて肯定的なフィードバックを提供し、将来の結果の正確性を強化します。このようなフィードバックループはポジティブと呼ばれます。

- ネガティブなAIフィードバックループ: AIモデルが不正確な結果を生成した場合、ユーザーはフィードバックループを通じて欠陥を報告し、欠陥を修正してシステムの安定性を向上させます。このようなフィードバックループはネガティブと呼ばれます。

両方のタイプのAIフィードバックループは、時間の経過とともにモデルの開発とパフォーマンスの改善を可能にします。そして、それらは単独では使用または適用されません。共に、製品展開されたAIモデルが正しいか間違っているかを知るのに役立ちます。

AIフィードバックループのステージ

AIモデル内のフィードバックメカニズムの高レベルなイラスト。出典

AIフィードバックループがどのように機能するかを理解することは、AI開発の全ポテンシャルを引き出すために重要です。以下でAIフィードバックループのさまざまなステージを探ってみましょう。

- フィードバックの収集: 評価のために関連するモデルの結果を収集します。通常、ユーザーはモデルの結果にフィードバックを提供し、それが再トレーニングに使用されます。または、システムのパフォーマンスを微調整するためにWebから収集された外部データも使用できます。

- モデルの再トレーニング: 収集した情報を使用して、AIシステムはモデルのパラメータまたは重みを微調整することにより、より良い予測、回答、または特定の活動を行うために再トレーニングされます。

- フィードバックの統合とテスト: 再トレーニング後、モデルは再びテストおよび評価されます。この段階では、Subject Matter Experts(SMEs)からのフィードバックも含まれ、データを超えた問題を強調します。

- 展開: 変更を検証した後、モデルは再展開されます。この段階では、新しい現実世界のデータでモデルのパフォーマンスが向上し、ユーザーエクスペリエンスが向上します。

- モニタリング: モデルはメトリクスを使用して連続的に監視され、ドリフトなどの潜在的な劣化を特定します。そして、フィードバックサイクルは続きます。

製品データとAIモデルの出力の問題

堅牢なAIシステムを構築するには、製品データ(現実世界のデータ)とモデルの結果に関する潜在的な問題を徹底的に理解する必要があります。AIシステムの正確性と信頼性を確保する上で障害となるいくつかの問題を見てみましょう:

- データドリフト: モデルがトレーニングデータの分布と異なる分布から現実世界のデータを受け取り始めると、データドリフトが発生します。

- モデルドリフト: モデルの予測能力と効率が時間の経過とともに減少し、現実世界の環境の変化によるものです。これをモデルドリフトと呼びます。

- AIモデルの出力と現実世界の意思決定: AIモデルが現実世界の利害関係者の意思決定と一致しない不正確な出力を生成する場合があります。

- バイアスと公平さ: AIモデルはバイアスや公平さの問題を引き起こすことがあります。たとえば、Janelle ShaneのTEDトークでは、ジェンダー差別のためにAmazonが履歴書の分類アルゴリズムの開発を中止したことが説明されています。

AIモデルがAI生成コンテンツで訓練を開始すると、これらの問題はさらに増加する可能性があります。これについて詳しく説明しましょう。

AI生成コンテンツの時代のAIフィードバックループ

急速な生成型AIの採用の後、研究者はモデル崩壊として知られる現象を研究しています。モデル崩壊を次のように定義しています。

「生成型モデルの世代に影響を与える退行的なプロセスであり、生成されたデータが次世代のモデルのトレーニングセットを汚染することで、汚染されたデータで訓練されたモデルは現実を誤解することになります。」

モデル崩壊は2つの特殊なケースで構成されています。

- 早期のモデル崩壊は、「モデルが分布のテールに関する情報を失い始める」つまり、トレーニングデータ分布の極端な末尾を指します。

- 遅延モデル崩壊は、「モデルが元の分布の異なるモードを絡ませ、非常に小さな分散を持つ元の分布とはほとんど似ていない分布に収束する」ことを指します。

モデル崩壊の原因

この問題に対処するために、AI実践者がモデル崩壊の原因を理解することは重要です。原因は主に2つのカテゴリに分類されます:

- 統計的な近似誤差:これは、有限なサンプル数によって引き起こされる主要な誤差であり、サンプル数が無限に近づくと消失します。

- 機能的な近似誤差:これは、ニューラルネットワークなどのモデルがデータから学ぶべき真の基礎関数を捉えられない場合に生じる誤差です。

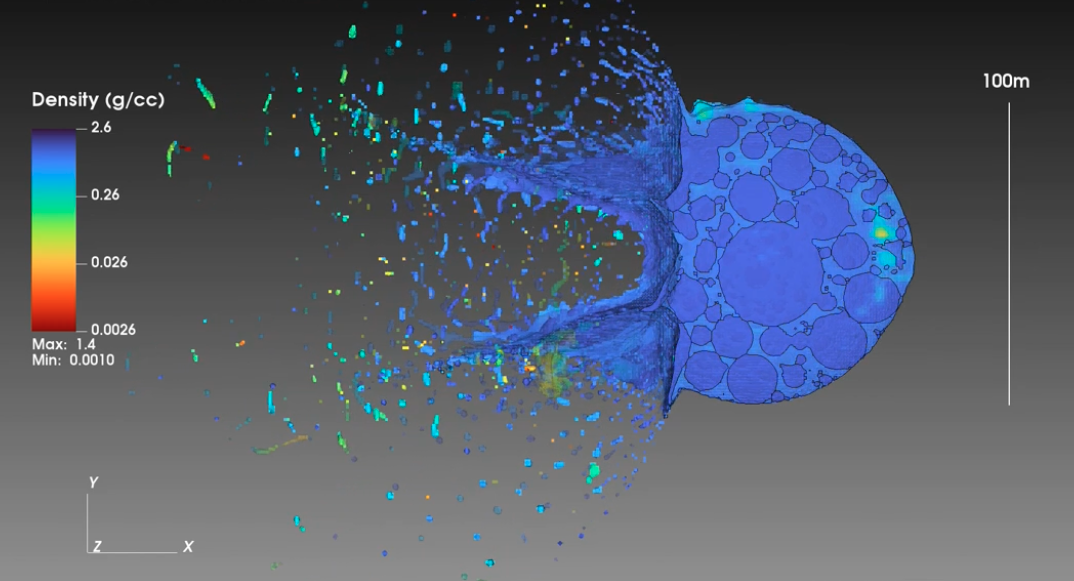

モデル崩壊に影響を受けた複数のモデル世代の結果のサンプル。出典

AI生成コンテンツによるAIフィードバックループへの影響

AIモデルがAI生成コンテンツで訓練されると、AIフィードバックループに破壊的な影響を与え、再訓練されたAIモデルに多くの問題を引き起こす可能性があります。これには以下のようなものがあります:

- モデル崩壊:上記で説明したように、AIフィードバックループにAI生成コンテンツが含まれている場合、モデル崩壊が起こる可能性があります。

- カタストロフィックフォーゲッティング:継続的な学習の典型的な課題は、モデルが新しい情報を学習する際に以前のサンプルを忘れることです。これをカタストロフィックフォーゲッティングと呼びます。

- データ汚染:これは、操作的な合成データをAIモデルに供給し、性能を損ない、正確な出力を生成させることを指します。

ビジネスはAIモデルのために堅牢なフィードバックループを作成する方法

ビジネスはAIのワークフローでフィードバックループを使用することで利益を得ることができます。以下の3つの主要なステップに従って、AIモデルのパフォーマンスを向上させることができます。

- 専門家からのフィードバック:専門家は自分の領域に高い知識を持ち、AIモデルの使用方法を理解しています。彼らは現実世界の設定とモデルの整合性を高めるための洞察を提供することができ、正しい結果の可能性を高めることができます。また、AI生成データの管理と監視をより良く行うことができます。

- 適切なモデル品質メトリクスの選択:適切な評価メトリックを選択し、これらのメトリックに基づいてモデルを本番で監視することで、モデルの品質を確保することができます。AI実践者はまた、MLOpsツールを使用して自動評価とモニタリングを行い、モデルのパフォーマンスが本番で悪化し始めた場合にはすべての関係者に警告を送ることができます。

- 厳格なデータキュレーション:本番のモデルは新しいデータで再訓練されるため、過去の情報を忘れる可能性があります。そのため、モデルの目的とよく一致する高品質なデータを選別することが重要です。このデータは、品質を確保するために、次世代のモデルの再訓練に使用されることができます。ユーザーフィードバックも含めることで、品質を保証することができます。

AIの進展について詳しくは、Unite.aiにアクセスしてください。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 学習曲線の航行:AIの記憶保持との闘い

- 「事前学習済みのテキストからイメージへの拡散モデルを用いたポイントクラウドの補完」

- OpenAIがBaby Llamaを発表 – 低電力デバイス向けのLLM!

- ジョージア工科大学のこのAI論文は、より速く信頼性の高い方法で潜在的な超伝導体の新しい候補を特定するための人工知能手法を提案しています

- 「ChatGPTなどの大規模言語モデル(LLM)がファインチューニングにおいて教師あり学習ではなく強化学習を使用する理由」の5つの理由

- 「はい!OpenTelemetryはシステムのセキュリティを確保するための重要な要素です」

- 「さまざまな深層学習を用いた天気予測モデルに関する研究」