Learn more about Search Results T5

- You may be interested

- 製造でのトピックモデリング

- プラグ可能な回折ニューラルネットワーク...

- Hugging Face Hubへようこそ、Stable-base...

- 「初心者におすすめの副業5選(無料のコー...

- 「空気圧コンピューティングが重要性を増す」

- 「AIと自動化ソフトウェアがビール業界を...

- 「お知らせ:フォーカスエンターテイメン...

- PythonとRにおける機械学習アルゴリズムの...

- 20/11〜26/11の間におけるコン...

- ディープAIの共同創業者兼CEO、ケビン・バ...

- 「テキストから音声を生成する方法:AIモ...

- 「サプライチェーンにおける生成型AIの役割」

- In Japanese ゼファー7Bベータ:必要な...

- 「AIと産業のデジタル化の時代に、開かれ...

- 「365データサイエンスは、11月20日まで無...

トランスフォーマーモデルでのNLPの台頭 | T5、BERT、GPTの包括的な分析

自然言語処理(NLP)は、近年、トランスフォーマーアーキテクチャのおかげで最も効果的なブレークスルーを経験してきましたこれらの進展は、機械が人間の言語を理解し生成する能力を向上させるだけでなく、検索エンジンから対話型AIまで、多くのアプリケーションの領域を再定義しました完全に[…]

グーグルサーチは、Googleサーチで文法チェック機能を備えた革新的なテキスト編集AIモデルであるEdiT5を導入しました

画期的な進歩として、Googleはその検索エンジンに革新的なEdiT5モデルによる最先端の文法修正機能を導入しました。この革新的なアプローチは、複雑な文法エラー修正(GEC)がもたらす課題に対処し、高い精度とリコールを確保しながら、素晴らしい速さで結果を提供します。 従来、GECは翻訳の問題としてアプローチされ、オートリグレッシブなトランスフォーマーモデルが利用されてきました。効果はあるものの、この方法ではオートリグレッシブなデコーディングによる並列化の制限が効率性に影響を与えます。より効率的なプロセスの必要性を認識し、EdiT5の開発チームは、GECをテキスト編集の問題として再構築しました。T5トランスフォーマーエンコーダデコーダーアーキテクチャを活用することで、デコーディングステップを大幅に削減し、レイテンシを最小限に抑えました。 EdiT5モデルは、文法エラーが含まれた入力を受け取り、エンコーダを使用して保持または削除するトークンを決定します。保持されたトークンはドラフトの出力を形成し、ノンオートリグレッシブなポインタネットワークを使用して必要に応じて再順序付けすることができます。その後、デコーダは文法的に正しい出力を生成するために、ドラフトに存在しないトークンを挿入します。重要なことは、デコーダはドラフトにないトークンのみに対して操作を行い、従来の翻訳ベースのGECと比較して処理時間を大幅に削減する点です。 デコード速度をさらに向上させるために、チームはデコーダを単層に絞り込み、同時にエンコーダのサイズを拡張しました。この戦略的な調整により、作業負荷が均衡化され、レイテンシが大幅に削減されます。具体的には、EdiT5モデルは驚異的な平均レイテンシ4.1ミリ秒で素晴らしい結果を達成することを意味します。 公開Bea文法エラー修正ベンチマークで行われたパフォーマンス評価は、EdiT5の優位性を示しています。パラメータ数が3億9100万である大規模なEdiT5モデルは、パラメータ数が2億4800万であるT5ベースモデルよりも高いF0.5スコア(修正の正確性を測定するもの)を出し、驚異的な9倍の高速化を実現しています。これは、モデルの効率性が非常に優れていることを示しています。 さらに、研究はモデルサイズが正確な文法修正の生成において重要な役割を果たすことを強調しています。大規模言語モデル(LLM)の利点とEdiT5の低レイテンシを組み合わせるために、ハード蒸留と呼ばれる技術を活用しています。教師LLMをトレーニングし、それを学生EdiT5モデルのトレーニングデータ生成に利用することで、正確さと速度の強力なシナジーを実現しています。 開発プロセスでは、最適なパフォーマンスを確保するためにトレーニングデータを洗練しました。非文法的なソースと文法的なターゲット文のペアから成るトレーニングセットは、厳格なセルフトレーニングと反復的な改善が行われました。この入念なアプローチにより、不要な言い換え、アーティファクト、文法エラーが排除され、クリーナーでより一貫性のあるトレーニングデータが得られました。 最終的な実装では、EdiT5ベースのモデルが2つトレーニングされました。文法エラー修正モデルと文法正当性分類器です。ユーザーが文法チェック機能を利用すると、クエリはモデルによる修正を受けた後、分類器によって検証されます。この2段階のプロセスにより、正確な修正のみがユーザーに提示され、誤ったまたは混乱を招く提案のリスクが軽減されます。 EdiT5を活用した文法チェック機能の導入により、Google検索は効率的かつ正確な文法修正の新たな基準を確立しました。ユーザーは単に検索時に「文法チェック」というフレーズを含めることで、クエリの文法的正当性を自信をもって評価することができます。自然言語処理のこのマイルストーンは、Googleのユーザーエクスペリエンスの向上と信頼性のある正確な検索結果に対する取り組みを再確認しています。

『LangChain & Flan-T5 XXL の解除 | 効率的なドキュメントクエリのガイド』

はじめに 大規模言語モデル(LLM)として知られる特定の人工知能モデルは、人間のようなテキストを理解し生成するために設計されています。”大規模”という用語は、それらが持つパラメータの数によってしばしば定量化されます。たとえば、OpenAIのGPT-3モデルは1750億個のパラメータを持っています。これらのモデルは、テキストの翻訳、質問への回答、エッセイの執筆、テキストの要約など、さまざまなタスクに使用することができます。LLMの機能を示すリソースやそれらとチャットアプリケーションを設定するためのガイダンスが豊富にありますが、実際のビジネスシナリオにおける適用可能性を徹底的に検討した試みはほとんどありません。この記事では、LangChain&Flan-T5 XXLを活用して、大規模言語ベースのアプリケーションを構築するためのドキュメントクエリングシステムを作成する方法について学びます。 学習目標 技術的な詳細に踏み込む前に、この記事の学習目標を確立しましょう: LangChainを活用して大規模言語ベースのアプリケーションを構築する方法を理解する テキスト対テキストフレームワークとFlan-T5モデルの簡潔な概要 LangChain&任意のLLMモデルを使用してドキュメントクエリシステムを作成する方法 これらの概念を理解するために、これらのセクションについて詳しく説明します。 この記事は、データサイエンスブログマラソンの一部として公開されました。 LLMアプリケーションの構築におけるLangChainの役割 LangChainフレームワークは、チャットボット、生成型質問応答(GQA)、要約など、大規模言語モデル(LLM)の機能を活用したさまざまなアプリケーションの開発に設計されています。LangChainは、ドキュメントクエリングシステムを構築するための包括的なソリューションを提供します。これには、コーパスの前処理、チャンキングによるこれらのチャンクのベクトル空間への変換、クエリが行われたときに類似のチャンクを特定し、適切な回答にドキュメントを洗練するための言語モデルの活用が含まれます。 Flan-T5モデルの概要 Flan-T5は、Googleの研究者によって商業的に利用可能なオープンソースのLLMです。これはT5(Text-To-Text Transfer Transformer)モデルの派生モデルです。T5は、”テキスト対テキスト”フレームワークでトレーニングされた最先端の言語モデルです。さまざまなNLPタスクを実行するために、タスクをテキストベースの形式に変換することでトレーニングされます。FLANは、Finetuned Language Netの略です。 ドキュメントクエリシステムの構築に入りましょう LangChainとFlan-T5 XXLモデルを使用して、Google Colabの無料版でこのドキュメントクエリシステムを構築することができます。以下の手順に従ってドキュメントクエリシステムを構築しましょう: 1:必要なライブラリのインポート 以下のライブラリをインポートする必要があります:…

「トランスフォーマーアーキテクチャとBERT、GPT、T5の台頭:初心者向けガイド」

「人工知能(AI)の広大で絶えず進化する領域において、印象を残すだけでなく、その全体の軌道を再定義する革新が存在しますこれらの画期的な…」

OpenAIの進化:GPT5への競争

最近、自然言語処理(NLP)の分野では、生成事前学習トランスフォーマー(GPT)モデルが最も強力なものとして登場し、重要な進展が見られています

このAI論文では、COLT5という新しいモデルを提案していますこのモデルは、より高品質かつ高速な処理のために条件付き計算を使用する、長距離入力のためのものです

様々な自然言語処理タスクにおいて、長い文章をエンコードするためには、機械学習モデルが必要です。例えば、長い文書の要約や質問に対する回答などです。Transformerモデルを使用して長いテキストを処理すると、入力の長さに比例して注意コストが二次的に増加し、各入力トークンに対してフィードフォワードやプロジェクション層を適用する必要があり、計算コストが高くなります。近年、長い入力の注意機構の負荷を軽減するための「効率的なTransformer」戦略がいくつか提案されています。しかし、フィードフォワードやプロジェクション層は、特に大きなモデルの場合には計算負荷の大部分を占め、長い入力の解析が不可能になることがあります。本研究では、COLT5という新しいモデルファミリーを紹介します。COLT5は、注意機構とフィードフォワード層の両方にアーキテクチャの改良を組み込むことで、LONGT5をベースにして長い入力の高速処理を可能にします。 COLT5の基盤となる考え方は、特定のトークンが他のトークンよりも重要であるということ、そして重要なトークンにより多くの計算リソースを割り当てることで、より高品質な結果を低コストで得ることができるということです。例えば、COLT5は、各フィードフォワード層と各注意層を、すべてのトークンに適用する軽いブランチと、その入力と要素に特に選ばれた重要なトークンのために使用される重いブランチに分けています。通常のLONGT5に比べて、軽いフィードフォワードブランチの隠れ次元は重いフィードフォワードブランチよりも小さくなっています。また、重要なトークンの割合は文書の長さに応じて減少し、長いテキストの処理を可能にします。 図1:条件付き計算COLT5 Transformerレイヤーの概要。 図1にはCOLT5の条件付きメカニズムの概要が示されています。COLT5のおかげで、LONGT5アーキテクチャはさらに2つの変更が加わりました。重い注意ブランチは、慎重に選ばれた重要なトークンの異なるセットに対して完全な注意を行い、軽い注意ブランチはより少ないヘッドを持ち、ローカルな注意を適用します。COLT5が導入するマルチクエリクロスアテンションは、推論を劇的に高速化します。さらに、COLT5はUL2の事前学習ターゲットを使用し、長い入力にわたる文脈における学習を可能にします。 Google Researchの研究者たちは、パフォーマンスと高速処理のために条件付き計算を使用する遠隔入力向けの新しいモデルであるCOLT5を提案しています。彼らは、COLT5がarXivの要約データセットやTriviaQAの質問応答データセットでLONGT5を上回り、SCROLLSベンチマークでもSOTAに達することを示しています。COLT5は「フォーカス」トークンの非線形スケーリングにより、長い入力の品質とパフォーマンスを大幅に向上させます。COLT5は、同じまたは優れたモデル品質で、非常に高速なファインチューニングと推論を行うことも可能です。COLT5の軽いフィードフォワード層と注意層はすべての入力に適用されますが、重いブランチは学習済みのルータによって選択された重要なトークンにのみ影響を与えます。彼らは、COLT5がさまざまな長い入力データセットでLONGT5を上回り、64kトークンまで非常に長い入力を効果的かつ効率的に処理できることを示しています。

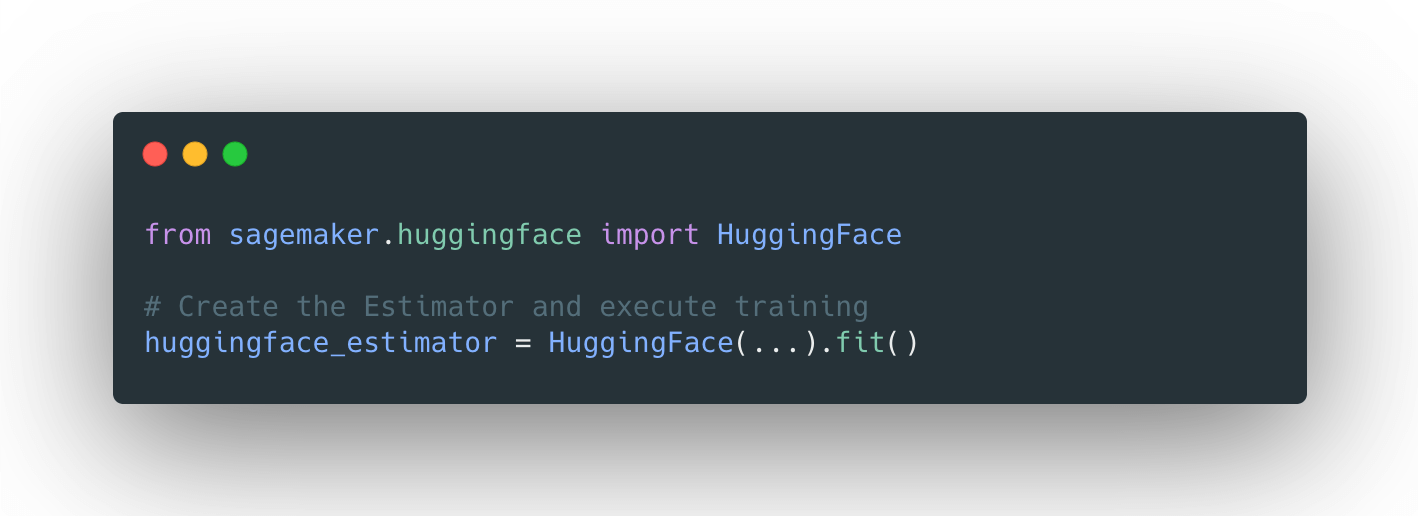

分散トレーニング:🤗 TransformersとAmazon SageMakerを使用して、要約のためにBART/T5をトレーニングする

見逃した場合: 3月25日にAmazon SageMakerとのコラボレーションを発表しました。これにより、最新の機械学習モデルを簡単に作成し、先進的なNLP機能をより速く提供できるようになりました。 SageMakerチームと協力して、🤗 Transformers最適化のDeep Learning Containersを構築しました。AWSの皆さん、ありがとうございます!🤗 🚀 SageMaker Python SDKの新しいHuggingFaceエスティメーターを使用すると、1行のコードでトレーニングを開始できます。 発表のブログ投稿では、統合に関するすべての情報、”はじめに”の例、ドキュメント、例、および機能へのリンクが提供されています。 以下に再掲します: 🤗 Transformers ドキュメント: Amazon SageMaker サンプルノートブック Hugging Face用のAmazon SageMakerドキュメント Hugging Face用のPython…

音声合成、音声認識、そしてSpeechT5を使ったその他の機能

私たちは喜んでお知らせします。SpeechT5は🤗Transformersで利用可能になりました。これは最先端の機械学習モデルの簡単に使用できる実装を提供するオープンソースライブラリです。 SpeechT5はもともと、Microsoft Research Asiaによって開発された論文「SpeechT5: Unified-Modal Encoder-Decoder Pre-Training for Spoken Language Processing」で説明されています。論文の著者が公開した公式のチェックポイントはHugging Face Hubで利用可能です。 すぐに試してみたい場合は、以下のデモがあります: 音声合成(TTS) 音声変換 自動音声認識 はじめに SpeechT5は、1つのアーキテクチャに3つの異なる種類の音声モデルを組み込んでいます。 以下のことができます: 音声からテキストへの変換(自動音声認識や話者識別に使用) テキストから音声への変換(音声を合成) 音声から音声への変換(異なる声や音声の強調を行う) SpeechT5の基本的なアイデアは、テキストから音声、音声からテキスト、テキストからテキスト、音声から音声までのデータの混合で単一のモデルを事前学習することです。これにより、モデルはテキストと音声の両方から同時に学習します。この事前学習アプローチの結果は、テキストと音声の両方に共有される統一された隠れ表現の空間を持つモデルです。…

T5 テキストからテキストへのトランスフォーマー(パート2)

BERT [5] の提案により、自然言語処理(NLP)のための転移学習手法の普及がもたらされましたインターネット上での未ラベル化されたテキストの広範な利用可能性により、私たちは...

Google AIがFlan-T5をオープンソース化 NLPタスクにおいてテキスト対テキストアプローチを使用するトランスフォーマーベースの言語モデル

大規模な言語モデル、例えばPaLM、Chinchilla、およびChatGPTは、自然言語処理(NLP)のタスクを実行する新たな可能性を開いています。先行研究では、指示に基づくさまざまなNLPタスクで言語モデルを微調整する指示調整が、指示を与えられた未知のタスクを実行する能力をさらに向上させることが示されています。本論文では、オープンソースの指示一般化イニシアティブのアプローチと結果を比較し、彼らの微調整手順と戦略を評価しています。 この研究では、指示調整方法の詳細に焦点を当て、個々の要素を取り除いて直接比較しています。彼らは、「Flan 2022 Collection」という用語で、データ収集やデータと指示調整プロセスに適用される手法に焦点を当て、Flan 2022をPaLM 540Bと組み合わせた新興かつ最先端の結果に重点を置いたデータ収集の最も包括的なコレクションを公開しています。このコレクションには、数千のプレミアムなテンプレートとより良いフォーマットパターンが追加されています。 彼らは、評価ベンチマークのすべてで、このコレクションで訓練されたモデルが、オリジナルのFlan 2021 their、T0++ their、Super-Natural Instructions their、およびOPT-IML theirのような他の公開コレクションよりも優れたパフォーマンスを発揮することを示しています。同じサイズのモデルにおいて、MMLUおよびBIG-Bench Hardの評価ベンチマークにおいて4.2%以上および8.5%の改善が見られます。Flan 2022のアプローチの分析によると、これらの堅牢な結果は、より大きくより多様なタスクのコレクションと、ゼロショット、フューショット、およびチェーンオブソートのプロンプトを使用したトレーニングなど、いくつかの直感的な戦略による微調整とデータ拡張の結果であると言えます。 例えば、フューショットプロンプトの10%の増加は、ゼロショットプロンプトの結果を2%以上改善します。また、入出力対の反転を行うことでタスクのソースをバランスさせ、タスクの多様性を向上させることが、パフォーマンスにとって重要であることも示されています。シングルタスクの微調整では、得られたFlan-T5モデルはT5モデルよりも収束が速く、より優れた性能を発揮するため、指示調整済みのモデルは後続のアプリケーションにおいてより効率的な計算的な出発点を提供します。これらの結果とツールを公開することで、指示の調整に利用できるリソースが効率的になり、より汎用性の高い言語モデルの開発を加速することが期待されています。 本研究の主な貢献は以下の通りです: • 方法論的な貢献:ゼロショットおよびフューショットのキューを混合してトレーニングすることで、両環境で有意に優れた結果を生み出すことを示す。 • 効率的な指示調整のための主要な手法を測定および示し、セクション3.3のスケーリング、入力反転を使用したタスクの多様化の向上、チェーンオブソートのトレーニングデータの追加、およびさまざまなデータソースのバランスを取ることを含む。 • 結果:これらの技術的な決定により、利用可能なオープンソースの指示調整コレクションと比較して、保留中のタスクパフォーマンスが3〜17%向上します。 •…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.