Learn more about Search Results RLHF

- You may be interested

- GitHubトピックススクレイパー | Pythonに...

- CMU(カーネギーメロン大学)と清華大学の...

- ナノタトゥーは、電池やワイヤーが必要あ...

- 「データは言語モデルの基盤です」

- アルゴリズムのバイアスの理解:タイプ、...

- 「LLMsを使用して、ロボットの新しいタス...

- 中国の研究者が「FreeMan」という大規模な...

- 書評:Cogniteの「産業向けジェネラティブ...

- データの汚染を防ぐためのサイバーセキュ...

- 「ODSC West 2023の優れたバーチャルセッ...

- 画像処理におけるノイズとは何ですか? &#...

- 「AIがPowerPointと出会う」

- 「CG ギークが VFX を楽々に作ります 今週...

- 「大規模な言語モデルを使ったフェイクニ...

- 「2023年のトップコンピュータビジョンツ...

「Huggingface 🤗を使用したLLMsのためのRLHFトレーニングパイプライン」

今や、誰もが話しているのは生成AIや大規模言語モデルですChatGPTやGrokなどのモデルは、今日ではすっかりおなじみの名前になり、多くの人々が解決策を取り入れたいと考えています...

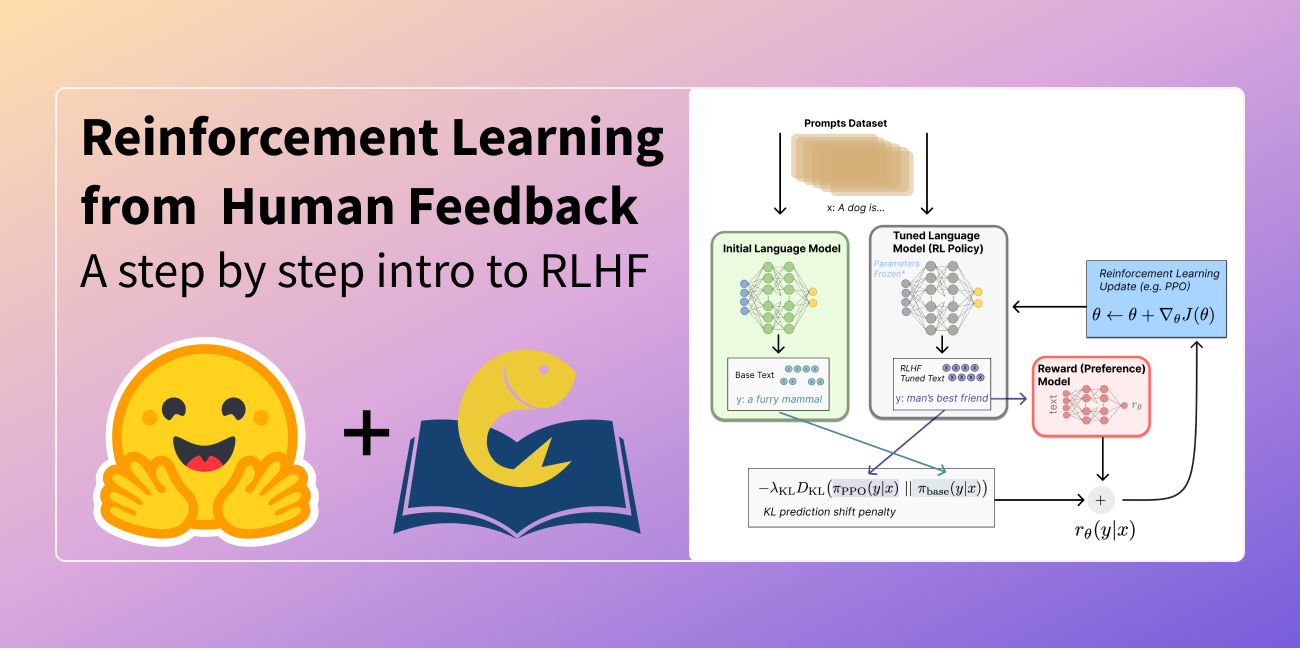

人間のフィードバックからの強化学習(RLHF)

たぶん、あなたはこの技術について聞いたことがあるかもしれませんが、完全には理解していないかもしれません特にPPOの部分についてですこの説明がお手伝いできるかもしれません私たちはテキストからテキストへの言語モデルに焦点を当てます 📝 例えば...

スタンフォード大学とUTオースティンの研究者は、Contrastive Preference Learning (CPL)を提案します:RLHFのためのRL-Freeな方法であり、任意のMDPsとオフポリシーのデータと一緒に動作します

モデルがパフォーマンスを向上させるにつれて、人間の好みと大規模事前トレーニング済みモデルの一致は、研究の中で注目を集めています。大きなデータセットには避けられない不適切な振る舞いがある場合、この調整は特に困難になります。そのため、人間の入力による強化学習(RLHF)が人気を集めています。RLHFアプローチでは、人間の好みを使用して受け入れ可能な行動と悪い行動を区別し、既知のポリシーを改善します。このアプローチは、ロボットのルールの調整、画像生成モデルの向上、そして理想的ではないデータを使用して大規模言語モデル(LLM)を微調整する際に、励みになる結果を示しています。 RLHFアルゴリズムの大部分には、この手続きには2つの段階があります。 まず、ユーザーの好みデータを収集して報酬モデルをトレーニングします。オフシェルフの強化学習(RL)アルゴリズムがその報酬モデルを最適化します。残念ながら、この二段階のパラダイムでは、この基礎に修正が必要です。人間の好みは、アルゴリズムが好みのデータから報酬モデルを開発するための各行動セグメントの割引された報酬の合計または部分的なリターンによって割り当てられる必要があります。しかし、最近の研究では、人間の好みは、専門家の報酬関数の理想的なポリシーの下での各アクションの後悔に基づいているべきだというこの理論を否定し、人間の評価はおそらく報酬より最適性に焦点を当てていると主張しています。 したがって、最適な利点関数、すなわち後悔の否定は、フィードバックから学ぶための理想的な数値である可能性があります。二段階のRLHFアルゴリズムは、最初のフェーズで既知の報酬関数を最適化するためにRLを使用します。実世界の応用では、時間的な信用割り当ては、近似動的プログラミングの不安定性やポリシーグラデーションの高い分散など、RLアルゴリズムにさまざまな最適化の困難をもたらします。その結果、以前の研究ではこれらの問題を回避するために範囲を制限しています。たとえば、RLHFアプローチでは、LLMの場合にはコンテキストバンディット形式が想定されており、ユーザーの質問に対して単一の報酬値がポリシーに与えられます。 ユーザーのLLMsとの相互作用は、マルチステップで連続的であるため、単一ステップのバンディットの仮定は破られています。これにより、長期的な信用割り当ての要件が軽減され、ポリシーグラデーションの高い分散も軽減されます。もう1つの例は、低次元の状態ベースのロボティクスの問題にRLHFを適用することであり、近似動的プログラミングに適しています。ただし、より現実的な連続的な制御領域と画像入力を持つ高次元の制御領域にスケーリングすることはまだできていません。一般的に、RLHFアプローチでは、問題の連続性または次元に関する制約を緩和することで、RLの最適化の制約を軽減する必要があります。彼らは一般的に報酬関数のみが人間の好みを決定すると誤解しています。 この研究では、合計報酬を考慮する一部のリターンモデルとは異なり、Stanford University、UMass Amherst、UT Austinの研究者らは、後悔ベースの好みモデルを使用するこの新しいRLHFアルゴリズムの一族を提供しています。部分的なリターンモデルとは異なり、後悔ベースのアプローチは、最適な行動の正確な情報を提供します。幸いなことに、これによりRLの必要性がなくなり、汎用MDPフレームワークにおいて、高次元の状態とアクション空間のRLHF問題に対処することができます。彼らの基本的な発見は、後悔ベースの好みフレームワークを最大エントロピー(MaxEnt)の原理と組み合わせることによって、利点関数とポリシーの間の双写像を作成することです。 利点関数を最適化する代わりにポリシーを最適化することで、彼らは純粋な教師あり学習の目的を確立することができます。その最適は、専門家の報酬に基づく最良のポリシーです。彼らの手法は広く認識されている対照的な学習目的に似ているため、コントラスティブな好み学習と呼ばれます。CPLには、先行の取り組みと比べて3つの主な利点があります。まず、CPLは動的プログラミングやポリシーグラデーションを使用せずに、教師ありゴールのみを使用して最適な利点を一致させるため、教師あり学習と同じくらいスケーリングすることができます。第二に、CPLは完全にオフポリシーであり、オフラインの理想的でないデータソースを使用することが可能です。最後に、CPLは、任意のMarkov決定プロセス(MDP)の学習のためのシーケンシャルデータ上の好み検索を可能にします。 彼らによると、これまでのRLHFの技術はこの3つの要件を同時に満たすことができていません。CPLの性能を示すため、彼らはサブオプティマルな高次元オフポリシー入力を使用して連続的な意思決定問題でCPLの遵守度を証明します。興味深いことに、彼らは、対話モデルと同じRLHF微調整プロセスを使用して、MetaWorld Benchmarkで時間的に延長された操作ルールを効果的に学習することができるCPLをデモンストレーションしています。より具体的には、高次元の画像観測からの教師あり学習を使用してポリシーを事前トレーニングし、その後好みを使用して微調整します。CPLは、動的プログラミングやポリシーグラデーションなしで既存のRLベースの技術と同等のパフォーマンスを発揮することができます。また、パラメータの効率性が4倍高く、同時に1.6倍速くなります。より密な優先データを使用する場合、CPLはRLベースラインを6つのタスクのうち5つで上回ることができます。研究者は、報酬関数を学習することなく、好みから最適なポリシーを学習するために、最大エントロピーの概念を利用することで強化学習(RL)の必要性を回避することができます。

RLHF:人間のフィードバックからの強化学習

最近、尊敬している元同僚のソフトウェアエンジニアの一人と話をしました彼はChatGPTがAGIの表れだと考えており、その能力を複雑なものを簡単にする点を指摘していました

「Amazon SageMakerを使用したRLHFによるLLMsの改善」

このブログ投稿では、人気のあるオープンソースのRLHFリポTrlxを使用して、Amazon SageMaker上でRLHFを実行する方法を説明します私たちの実験を通じて、Anthropicが提供する公開可能なHelpfulness and Harmlessness(HH)データセットを使用して、大規模な言語モデルの役立ち度または無害性を向上させるためにRLHFを使用する方法を示しますこのデータセットを使用して、ml.p4d.24xlargeインスタンスで実行されているAmazon SageMaker Studioノートブックを使用して実験を行います最後に、私たちの実験を再現するためのJupyterノートブックを提供します

高性能意思決定のためのRLHF:戦略と最適化

はじめに 人間の要因/フィードバックからの強化学習(RLHF)は、RLの原則と人間のフィードバックを組み合わせた新興の分野です。これは、現実世界の複雑なシステムにおいて意思決定を最適化し、パフォーマンスを向上させるように設計されます。高性能のRLHFは、さまざまなドメインの設計、使いやすさ、安全性を向上させるために、人間の行動、認知、文脈、知識、相互作用を理解することに焦点を当てています。 RLHFは、機械中心の最適化と人間中心の設計のギャップを埋めるために、RLアルゴリズムと人間要因の原則を統合することを目指しています。研究者は、人間のニーズ、好み、能力に適応するインテリジェントシステムを作成し、ユーザーエクスペリエンスを最適化することを目指しています。RLHFでは、計算モデルが人間の反応をシミュレート、予測、予測し、個人が情報に基づいた意思決定を行い、複雑な環境との相互作用をどのように行うのかについての洞察を得ることができます。これらのモデルを強化学習アルゴリズムと組み合わせることを想像してみてください! RLHFは、意思決定プロセスを最適化し、システムのパフォーマンスを向上させ、今後数年間で人間と機械の協力を向上させることを目指しています。 学習目標 RLHFの基礎と人間中心の設計における重要性を理解することが最初で最も重要なステップです。 さまざまなドメインでの意思決定の最適化とパフォーマンスを向上させるためのRLHFの応用を探求します。 強化学習、人間要因工学、適応インターフェースなど、RLHFに関連する主要なトピックを特定します。 知識グラフがデータ統合とRLHFの研究および応用における洞察を促進する役割を認識します。 RLHF:人間中心のドメインを革新する 人間要因を活用した強化学習(RLHF)は、人間要因が重要なさまざまな分野を変革する可能性があります。人間の認知的制約、行動、相互作用の理解を活かして、個別のニーズに合わせた適応的なインターフェース、意思決定支援システム、支援技術を作成します。これにより、効率性、安全性、ユーザー満足度が向上し、業界全体での採用が促進されます。 RLHFの進化の中で、研究者は新しい応用を探求し、人間要因を強化学習アルゴリズムに統合する課題に取り組んでいます。計算モデル、データ駆動型アプローチ、人間中心の設計を組み合わせることで、RLHFは高度な人間と機械の協力、意思決定の最適化、パフォーマンスの向上を可能にしています。 なぜRLHFが重要なのか? RLHFは、ヘルスケア、金融、交通、ゲーム、ロボティクス、サプライチェーン、顧客サービスなど、さまざまな産業にとって非常に価値があります。 RLHFにより、AIシステムは人間の意図とニーズにより合わせて学習できるため、広範なアプリケーションでの快適で安全かつ効果的な使用が可能になります。 なぜRLHFが価値があるのか? 複雑な環境でのAIの活用はRLHFの得意とするところです。多くの産業では、AIシステムが運用する環境は通常複雑でモデル化が難しいです。一方、RLHFではAIシステムが人間の要因から学び、効率と精度の面で従来のアプローチが失敗する複雑なシナリオに適応することができます。 RLHFは責任あるAIの行動を促進し、人間の価値観、倫理、安全性に合わせることができます。これらのシステムへの継続的な人間のフィードバックは、望ましくない行動を防ぐのに役立ちます。一方、RLHFは人間の要因、判断、優先順位、好みを組み込むことで、エージェントの学習の旅をガイドする別の方法を提供します。 効率の向上とコストの削減知識グラフやAIシステムのトレーニングによる試行錯誤の必要性があります。特定のシナリオでは、両方ともダイナミックな状況で迅速に採用できます。 リアルタイム適応のためのRPAと自動化を可能にするほとんどの産業は既にRPAまたは一部の自動化システムを使用しており、AIエージェントが迅速に状況の変化に適応する必要があります。 RLHFはこれらのエージェントが人間のフィードバックを受けて即座に学習し、不確実な状況でもパフォーマンスと精度を向上させるのに役立ちます。私たちはこれを「意思決定インテリジェンスシステム」と呼んでいます。RDF(リソース開発フレームワーク)は同じシステムにセマンティックウェブ情報をもたらすことさえでき、情報に基づいた意思決定に役立ちます。 専門知識のデジタル化:すべての産業領域で専門知識は重要です。RLHFの助けを借りて、AIシステムは専門家の知識から学ぶことができます。同様に、知識グラフとRDFを使用すると、専門家のデモンストレーション、プロセス、問題解決の事実、判断能力からこの知識をデジタル化することができます。 RLHFは知識をエージェントに効果的に伝達することもできます。 ニーズに合わせたカスタマイズ:AIシステムは通常、ユーザーや専門家からのフィードバックを収集し、現実世界のシナリオで運用されるため、継続的な改善が必要です。フィードバックと意思決定に基づいてAIを継続的に改善することができます。…

マイクロソフトの研究者たちは、人間のフィードバックを用いた強化学習のためのメモリ効率の高い解決策であるHydra-RLHFを紹介しました

知名度が高まった以来、ChatGPT、GPT-4、Llama-2ファミリーモデルは、さまざまな仕事の有用な助手としての汎用性により、ユーザーを魅了してきました。RLHFを使用したモデルの整列と、他の多くの基盤モデルは、その効果の一因です。巨大な言語モデルをトレーニングすると、多くの知識を持つネットワークが作成されます。ただし、ネットワークがその情報を区別するように教えられていないため、望ましくない行動を示す場合があり、社会的な害を引き起こすことさえあります。モデルの振る舞いを変えることにより、整列はこの問題に対処し、安全で管理可能な基盤モデルの開発において重要な要素となっています。 RLHFはモデルの整列を向上させますが、PPO中に多数のモデルを読み込みおよびトレーニングする際の高い複雑さと大きなメモリ要件により、使用は制限されています。この適用はまだ初期段階であるため、RLHFの速度とパフォーマンスの変動を評価することが重要です。彼らはこの目標を達成するために、一般的なRLHFPPOのトレーニング手順とモデルアーキテクチャを調査しました。彼らの調査では、参照/報酬モデルとアクター/クリティックモデル間でのモデル共有によるメモリ/計算コストの削減の可能性が明らかになりました。 Microsoftの研究者は、これらの結果に基づいて、PPO中に学習されたモデルと静的モデルの保存量を最小化するHydra-PPOを提案しています。これにより、これらのメモリの節約は、ランタイムとパフォーマンスの比較によれば、PPOのパーサンプルのレイテンシを最大で65%減少させるために使用できます。彼らはHydra-RLHFと呼ばれる一連のRLHFの改良を提案しています。彼らは、2つの線形ヘッドを持つデコーダベースのモデルであるHydraを作成します: 1)シーケンスの後に来るトークンを予測する因果関係ヘッド 2)同じ入力に関連する即時報酬を提供する報酬モデルヘッド マルチヘッドモデルは、一般的に研究が進められ、強化学習においても詳細に研究されています。 彼らは、GPT-4によって測定されるいくつかのモデル整列手法の効果を評価する比較研究を実施しました。彼らは、LoRA-PPOがFFTよりも優れた整列を持つが、より高価であることを発見しました。彼らは、メモリ使用量を削減しながら速度を維持するための方法として、参照モデルと報酬モデルを組み合わせ、PPO中に現在のLoRAモジュールを動的に切り替えるHydra-RLHFを紹介しています。Hydra-RLHFにより、追加のRAMを使用してより大きなバッチサイズでトレーニングすることで、パーサンプルのレイテンシを最大で65%高速化することができます。Hydra-RLHFのおかげで、コミュニティはより広範なモデルとアプリケーションにRLHFを使用することができるようになりました。

「非常にシンプルな数学が大規模言語モデル(LLMs)の強化学習と高次関数(RLHF)に情報を提供できるのか? このAIの論文はイエスと言っています!」

人間の入力を取り入れることは、ChatGPTやGPT-4などの大規模言語モデル(LLM)の能力の近年の印象的な向上の鍵要素です。人間のフィードバックを効果的に活用するためには、人間の好み、価値観、倫理的な問題を組み込んだ報酬モデルをまず訓練する必要があります。その後、報酬モデルの指示の下で強化学習を用いてLLMを調整します。この手順は、人間の目的とLLMを成功裏に調整し、対人間コミュニケーションの質を大幅に向上させるものです。 人間の好みに基づいた機能的な報酬システムを作成するのは簡単ではありません。特に、人間のラベラーが特定のプロンプトに対して数値の評価を提供できない場合、課題となります。代わりに、品質に関する補完についてのペアワイズ比較は、人々にとってははるかに簡単です。InstructGPTの作成においてもこのアプローチが使用されました。具体的には、人間のラベラーは同じプロンプトに対してLLMによって生成された多くの補完を示した後、品質が最も高いものから最も低いものまで並べます。 その後、補完は、人間の好みのランクにほぼ近いように訓練されたニューラルネットワークによって開発された報酬モデルに基づいて報酬を受けます。順位付けは、キャリブレーションの問題を解消するなどの特定の利点がありますが、複数のプロンプトの異なる報酬分布を適切に反映していません。これにより、上位にランク付けされた補完が別の補完よりもどれだけ優れているかが明確になりません。一部のRLHFプロンプトは開放的であるか、つまりユーザーの履歴に依存しているため、報酬分布は広範囲にわたる可能性があります。したがって、この懸念は特に関連性があります。 一方、いくつかのプロンプトは閉じた形式であり、高いまたは低いスコアを受けるべき応答を生成します。これにより、報酬分布には約2つのポイントマス分布が生じます。最初の種類のプロンプトの例には、「ピタゴラスの定理を証明する」や「鶏は恐竜ですか」といったものがあります。2番目の種類の例には、「ピタゴラスの定理を証明する」と「100年後のAIの姿についての短編を書く」といったものがあります。プロンプトに関連する細微な手がかりを考慮に入れることで、報酬モデルはLLMが不確実性を適切に測定するのに役立つかもしれません。 スタンフォード大学、プリンストン大学、ペンシルベニア大学の研究者たちは、好みの順位に基づいて報酬モデルを訓練することで、プロンプトに独立した報酬分布を提供することができるという予期しない現象を文書化しています。この現象は、訓練の最後の段階で起こるもので、報酬の崩壊として知られています。興味深いことに、この現象は実証的に証明される前に、理論的な分析で予測されていました。彼らは、報酬の崩壊の報酬分布を数値的に推定するために、簡単な最適化プログラム、あるいはもっと簡単には閉形式の式を使用できることを示しています。報酬の崩壊の予測は、実証的な結果と非常に良い一致を示しています。 彼らの2番目の主要な貢献は、報酬の崩壊を防ぐためにその発生を予測するための同じ最適化プログラムからのデータを使用する原則的な戦略を紹介することです。報酬の崩壊は望ましくないものであり、異なるプロンプト間の微細な違いを無視する可能性があります。これにより、LLMが強化学習と報酬モデルを使用して訓練される際に、人間の選択の誤校正が生じる可能性があります。報酬モデルの訓練の早期終了は、この問題に対する単純な解決策ですが、かなり任意的であり、終了時期の決定が困難な場合があります。 要するに、彼らはプロンプトに基づいて異なるユーティリティ関数を使用して報酬モデルを訓練することを提案しています。これにより、結果として得られる報酬分布は、プロンプトが開放的な場合と閉じた形式の場合に応じて広範に分散するか、集中するかが決まります。このプロンプトに対応したテクニックは、報酬分布の構造を必要に応じて完全にカスタマイズすることができるという明らかな利点があります。彼らの研究結果は、このプロンプトに対応したテクニックを使用することで報酬の崩壊を大幅に減少させることができることを示しています。

RLHF(Reinforcement Learning from Human Feedback)において本当に強化学習(RL)は必要ですか?スタンフォード大学の新しい研究では、DPO(Direct Preference Optimization)を提案していますこれは、RLを使用せずに言語モデルを好みに基づいて訓練するためのシンプルなトレーニング方法です

巨大な教師なしLM(言語モデル)は、大量のデータセットで訓練されると、その創造者さえ驚かせるほどの能力を獲得します。ただし、これらのモデルは、多様な動機、目標、能力を持つ人々によって作成された情報で訓練されます。これらの目標や能力をすべて模倣することはできないかもしれません。信頼性の高い、効果的で管理しやすいシステムを作成するためには、モデルの望ましい応答と振る舞いを、膨大な情報とスキルの中から慎重に選択することが重要です。 スタンフォード大学とCZ研究者は、明示的な報酬モデリングや強化学習を使用せずに、言語モデルを人間の好みに合わせる方法を示しています。彼らの研究は、現在のアプローチで使用されている強化学習ベースの目標を、単純なバイナリクロスエントロピー目標で最適化する方法を示しており、好み学習プロセスを大幅に簡略化し、これを実際に行う方法を示しています。 彼らは、Direct Preference Optimization(DPO)を提案しています。この新しいアルゴリズムは、既存の強化学習ベースのアルゴリズム(報酬の最大化とKLダイバージェンス制約)と同じ目標を暗黙的に達成しますが、構築とトレーニングが容易です。DPOのアップデートは、好ましい回答と好ましくない回答の対数比を直感的に向上させる一方で、モデルの悪化を防ぐために動的な例ごとの重みも含まれています。 DPOは、他のアルゴリズムと同様に、理論的な優先モデルを使用して報酬関数の一貫性を実証的な優先データと評価します。従来のアプローチでは、優先モデルを使用して報酬モデルを訓練するために優先損失を定義しますが、DPOは代わりに変数スイッチを使用して学習された報酬モデルを最大化するポリシーを訓練します。したがって、DPOは、トレーニング中に報酬関数を明示的に学習することなく、モデルの応答に対する人間の嗜好のデータセットを使用して、単純なバイナリクロスエントロピーの目標を持つポリシーを最適化することができます。 この研究の結果は、DPOが感情調節、要約、対話などのさまざまなタスクで、6Bパラメータを含む言語モデルに対して、PPOベースのRLHF(好みに基づく学習)などの最新のアプローチと同等に効果的であることを示しています。人間の評価では、58%の人がDPOの要約をPPOの要約よりも好みます。テストセットでは、61%の人がDPOの要約を人間の評価よりも好みます。Anthropic HHでは、DPOの単一ターンの応答が選択的な補完よりも好まれる場合が60%あります。 チームは、DPOが人間の好みに基づいて言語モデルを訓練するだけでなく、さまざまなモダリティで生成モデルを訓練するためにも多くの潜在的な用途があると述べています。 提案されたモデルの評価は、6Bパラメータまで高まりますが、チームは、オーダーオブマグニチュードのデータを持つ最新のモデルにDPOをスケーリングするためのさらなる研究が必要だと考えています。研究者たちはまた、プロンプトがGPT-4の計算された勝率に影響を与えることを発見しました。将来的には、機械から専門家の意見を引き出すための最も効果的な手段を調査する予定です。

人間のフィードバックからの強化学習(RLHF)の説明

この記事は以下の言語に翻訳されています:中国語(簡体字)とベトナム語。他の言語に翻訳に興味がありますか?nathan at huggingface.co までお問い合わせください。 言語モデルは、過去数年間に人間の入力プロンプトから多様で魅力的なテキストを生成する能力を示してきました。しかし、「良い」テキストとは何かは、主観的で文脈に依存するため、本質的に定義するのは難しいです。創造性を求める物語の執筆などの多くのアプリケーションでは、真実であるべき情報の断片、または実行可能なコードのスニペットなどが必要です。 これらの属性を捉えるための損失関数を作成することは困難であり、ほとんどの言語モデルはまだ単純な次のトークン予測の損失(例:クロスエントロピー)で訓練されています。損失自体の欠点を補うために、人々はBLEUやROUGEなど、人間の優先順位をより適切に捉えるように設計されたメトリクスを定義しています。これらのメトリクスは、パフォーマンスを測定する上で損失関数自体より適しているものの、生成されたテキストを単純なルールで参照テキストと比較するだけなので、制約もあります。生成されたテキストに対する人間のフィードバックをパフォーマンスの指標として使用するか、さらに進んでそのフィードバックを損失としてモデルを最適化することができれば、素晴らしいことではないでしょうか?それが「人間のフィードバックによる強化学習(RLHF)」のアイデアです。強化学習の手法を使用して、言語モデルを人間のフィードバックで直接最適化するのです。RLHFにより、言語モデルは一般的なテキストデータのコーパスで訓練されたモデルを複雑な人間の価値に合わせることができるようになりました。 RLHFの最近の成功例は、ChatGPTでの使用です。ChatGPTの印象的な能力を考慮して、RLHFについて説明してもらいました: それは驚くほどうまくいっていますが、すべてをカバーしているわけではありません。それらのギャップを埋めましょう! 人間のフィードバックによる強化学習(RL from human preferencesとも呼ばれます)は、複数のモデルのトレーニングプロセスと異なる展開の段階を伴うため、難しい概念です。このブログ記事では、トレーニングプロセスを次の3つの主要なステップに分解します: 言語モデル(LM)の事前トレーニング データの収集と報酬モデルのトレーニング 強化学習によるLMの微調整 まず、言語モデルの事前トレーニングについて見ていきましょう。 言語モデルの事前トレーニング RLHFの出発点として、クラシカルな事前トレーニング目標で既に事前トレーニングされた言語モデルを使用します(詳細については、このブログ記事を参照してください)。OpenAIは、最初の人気のあるRLHFモデルであるInstructGPTに対して、より小さなバージョンのGPT-3を使用しました。Anthropicは、このタスクのためにトレーニングされた1,000万から520億のパラメータを持つトランスフォーマーモデルを使用しました。DeepMindは、2800億のパラメータモデルGopherを使用しました。 この初期モデルは、追加のテキストや条件で微調整することもできますが、必ずしも必要ではありません。たとえば、OpenAIは「好ましい」とされる人間が生成したテキストを微調整し、Anthropicは彼らの「助けになり、正直で無害な」基準に基づいて元のLMを蒸留することで、RLHFのための初期LMを生成しました。これらは共に、私が高価な増強データと呼ぶものの一部ですが、RLHFを理解するために必要なテクニックではありません。 一般的に、「どのモデル」がRLHFの出発点として最適かは明確な答えがありません。このブログ記事では、RLHFのトレーニングにおけるオプションの設計空間が完全に探索されていないという共通のテーマになります。 次に、言語モデルが必要なデータを生成して、人間の優先順位がシステムに統合される「報酬モデル」をトレーニングする必要があります。 報酬モデルのトレーニング 人間の優先順位に合わせてキャリブレーションされた報酬モデル(RM、優先モデルとも呼ばれます)を生成することは、RLHFの比較的新しい研究の出発点です。その基本的な目標は、テキストのシーケンスを受け取り、数値で人間の優先順位を表すべきスカラー報酬を返すモデルまたはシステムを取得することです。システムはエンドツーエンドのLMであるか、報酬を出力するモジュラーシステム(例:モデルが出力をランク付けし、ランキングが報酬に変換される)である場合があります。出力がスカラーの報酬であることは、既存のRLアルゴリズムが後のRLHFプロセスにシームレスに統合されるために重要です。 報酬モデリングのためのこれらの言語モデルは、別の微調整された言語モデルまたは好みのデータでスクラッチからトレーニングされた言語モデルのいずれかです。例えば、Anthropicは、これらのモデルを事前トレーニング(好みモデルの事前トレーニング、PMP)の後に初期化するために専門の微調整方法を使用しています。彼らは、これが微調整よりもサンプル効率が高いと結論付けましたが、報酬モデリングのバリエーションの中で明確な最良の選択肢はありません。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.