Learn more about Search Results MLPerf

- You may be interested

- AIがYouTubeの多言語吹替を開始します

- AWSにおける生成AIとマルチモーダルエージ...

- 「AI戦略にデータ管理を実装する方法」

- より速い治療:Insilico Medicineが生成型...

- 「スマートフォンアプリが肝臓手術におけ...

- 「先天性とは何か、そしてそれは人工知能...

- 「AIがPowerPointと出会う」

- フィールドからフォークへ:スタートアッ...

- ハッギングフェイスのオートトレインを使...

- ロジスティック回帰における行列とベクト...

- コンピュータ科学の研究者たちは、モジュ...

- NLP で仕事検索を強化しましょう

- 「データリテラシーのあるワークフォース...

- 「Nemo-Guardrailsを自分のやり方で設定す...

- 「インダストリー4.0 メタバースの解放:A...

テストに合格する:NVIDIAがMLPerfベンチマークでジェネラティブAIのトレーニングをターボチャージします

NVIDIAのAIプラットフォームは、最新のMLPerf業界ベンチマークにおいて、AIトレーニングとハイパフォーマンスコンピューティングの基準を引き上げました。 多くの新記録やマイルストーンの中で、ジェネラティブAIの分野で特に注目されているのは、NVIDIA Eosです。これは、驚異的な10752基のNVIDIA H100 Tensor Core GPUとNVIDIA Quantum-2 InfiniBandネットワーキングを搭載したAIスーパーコンピュータで、GPT-3モデルに基づいた1750億個のパラメータを持つ1億トークンのトレーニングベンチマークをたったの3.9分で完了しました。 これは、約3倍の速さで、NVIDIAがわずか6か月前に記録した10.9分を大幅に上回るものです。 このベンチマークは、人気のChatGPTサービスのフルGPT-3データセットの一部を使用しており、推定によれば、Eosはたった8日間でトレーニングを完了させることができます。これは、512基のA100 GPUを使用した従来の最先端システムに比べて73倍高速です。 トレーニング時間の短縮は、コスト削減、エネルギー節約、およびマーケット投入までの時間短縮につながります。大規模な言語モデルを広く利用できるようにする重要な取り組みであり、NVIDIA NeMoといったツールを使用して、すべての企業がカスタマイズ可能なLLMを採用できるようにしています。 今回の新しいジェネラティブAIのテストでは、1024基のNVIDIA HopperアーキテクチャGPUが、2.5分でStable Diffusion text-to-imageモデルに基づいたトレーニングベンチマークを完了し、この新たなワークロードにおいてハイバーな成績を収めました。 これらの二つのテストを採用することで、MLPerfはAIのパフォーマンスを測定する業界の標準としてのリーダーシップを強化しており、ジェネラティブAIが現在の私たちの時代で最も変革的な技術であることを裏付けています。 システムの拡張が飛躍 今回の最新の結果は、MLPerfベンチマークに適用されたアクセラレータがこれまでで最も多く使用されたことによるものです。10752基のH100 GPUは、今年6月のAIトレーニングでNVIDIAが使用した3584基のHopper GPUを大幅に上回りました。 GPU数の3倍のスケーリングが、パフォーマンスの2.8倍のスケーリングをもたらしたことで、ソフトウェアの最適化にも一部助けられ、93%の効率率を実現しました。…

「NVIDIAのグレース・ホッパー・スーパーチップがMLPerfの推論ベンチマークを席巻する」

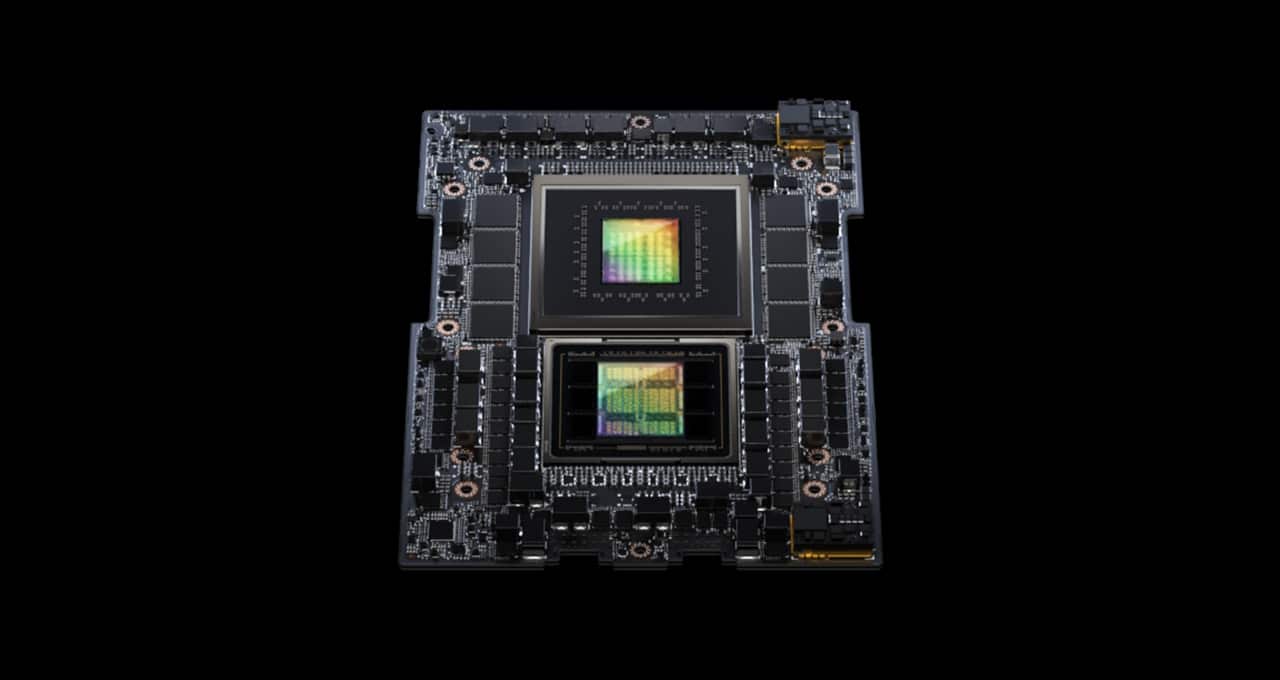

MLPerf業界ベンチマークに初登場したNVIDIA GH200 Grace Hopperスーパーチップは、すべてのデータセンターインファレンステストを実行し、NVIDIA H100 Tensor Core GPUのリーディングパフォーマンスを拡張しました。 全体的な結果は、NVIDIA AIプラットフォームの卓越したパフォーマンスと多機能性を示しており、クラウドからネットワークのエッジまでの幅広い領域で活躍しています。 別途、NVIDIAは性能、エネルギー効率、総所有コストの向上をユーザーにもたらすインファレンスソフトウェアを発表しました。 GH200スーパーチップがMLPerfで輝く GH200は、Hopper GPUとGrace CPUを1つのスーパーチップに結合しています。この組み合わせにより、より多くのメモリ、帯域幅、およびCPUとGPUの間で自動的に電力を切り替えてパフォーマンスを最適化する能力が提供されます。 また、8つのH100 GPUを搭載したNVIDIA HGX H100システムは、今回のMLPerfインファレンステストのすべての項目で最も高いスループットを実現しました。 Grace HopperスーパーチップとH100 GPUは、コンピュータビジョン、音声認識、医療画像などのMLPerfのデータセンターテスト全般でリードし、推薦システムや生成AIにおける大規模言語モデル(LLM)など、より要求の厳しいユースケースでも優れたパフォーマンスを発揮しました。 全体的に、これらの結果は、2018年のMLPerfベンチマークの開始以来、NVIDIAがAIトレーニングとインファレンスのパフォーマンスリーダーシップを証明し続ける記録を続けています。 最新のMLPerfラウンドでは、推薦システムのテストが更新され、AIモデルのサイズの大まかな指標である6兆パラメータを持つGPT-Jの最初のインファレンスベンチマークが実施されました。…

NVIDIA H100 GPUがMLPerfベンチマークのデビューで生成型AIの標準を設定

主要のユーザーと業界標準のベンチマークによれば、NVIDIAのH100 Tensor Core GPUは特に生成型AIを駆動する大規模言語モデル(LLMs)において、最高のAIパフォーマンスを提供しています。 H100 GPUは、最新のMLPerfトレーニングベンチマークのすべての8つのテストで新記録を樹立し、生成型AIの新しいMLPerfテストでも優れた性能を発揮しました。この優れた性能は、単一のアクセラレータあたりの性能だけでなく、大規模サーバーでの性能も提供されています。 たとえば、スタートアップのInflection AIとGPUアクセラレートワークロードに特化したクラウドサービスプロバイダーであるCoreWeaveが共同開発した3,584台のH100 GPUを搭載した商用クラスターでは、GPT-3ベースの大規模トレーニングベンチマークを11分以下で完了しました。 「当社のお客様は、数千のH100 GPUが高速で低レイテンシのInfiniBandネットワーク上で稼働しているため、現在スケールで最先端の生成型AIおよびLLMを構築しています。」と、CoreWeaveの共同設立者でありCTOであるブライアン・ベンチュロ氏は述べています。「NVIDIAとの共同MLPerfサブミッションにより、お客様が享受できる優れたパフォーマンスが明確に示されました。」 本日利用可能な最高のパフォーマンス Inflection AIは、そのパフォーマンスを活用して、パーソナルAI「Pi」の先進的なLLMを構築しました。同社はAIスタジオとして、ユーザーが簡単で自然な方法で対話できるパーソナルAIを作成します。 「当社の最先端の大規模言語モデルは、CoreWeaveの強力なH100 GPUネットワークでトレーニングされたものであり、誰でも今日からパーソナルAIの力を体験できます。」と、Inflection AIのCEOであるムスタファ・スレイマン氏は述べています。 2022年初頭にMustafaとDeepMindのKarén Simonyan、Reid Hoffmanが共同設立したInflection AIは、NVIDIA GPUを使用して世界で最大のコンピューティングクラスターの1つを構築するためにCoreWeaveと協力することを目指しています。 トップパフォーマンスが利用可能に これらのユーザー体験は、今日発表されたMLPerfベンチマークで示されたパフォーマンスを反映しています。…

なぜGPUはAIに適しているのか

GPUは人工知能の希少な地球の金属、さらには金そのものとも呼ばれています。それは、今日の生成的AI時代において基盤となる存在であるためです。それは3つの技術的理由と数多くのストーリーによって説明され、それぞれの理由には多くの側面がありますが、大まかに言えば次のようなものです。 GPUは並列処理を使用します。 GPUシステムはスーパーコンピュータの高さにまでスケールアップします。 AIのためのGPUソフトウェアスタックは幅広く深いです。 その結果、GPUはCPUよりも高速かつエネルギー効率が優れており、AIのトレーニングおよび推論においても優れたパフォーマンスを提供し、高速計算を使用するさまざまなアプリケーションにおいても利益をもたらします。 スタンフォード大学のヒューマンセンタードAIグループの最近のレポートによれば、GPUのパフォーマンスは「2003年以来約7000倍」向上し、価格性能比は「5600倍」増加していると報告されています。 2023年のレポートは、GPUのパフォーマンスと価格性能の急激な上昇を捉えています。 レポートはまた、AIの進展を測定し予測する独立系の研究グループであるエポックの分析も引用しています。 「GPUは、機械学習ワークロードを高速化するための主要なコンピューティングプラットフォームであり、過去5年間のほとんど(もしくはすべて)の最大のモデルがGPU上でトレーニングされています… それにより、AIの最近の進歩に重要な貢献をしています」とエポックはサイトで述べています。 また、米国政府のためにAI技術を評価した2020年の研究も同様の結論を導いています。 「製造および運用コストを含めた場合、最先端のAIチップは生産性と運用コストをリーディングノードCPUよりも1〜3桁高いと予想されます」と述べています。 「NVIDIAのGPUは、過去10年間にAI推論のパフォーマンスを1000倍向上させました」と同社の首席科学者であるビル・デーリー氏は、半導体およびシステムエンジニアの年次集会であるHot Chipsの基調講演で述べています。 ChatGPTがニュースを広める ChatGPTは、GPUがAIにとって優れたものであることを強力に示した例です。数千のNVIDIA GPUでトレーニングされ、実行される大規模な言語モデル(LLM)は、1億人以上の人々が利用する生成的AIサービスを提供しています。 その2018年のリリース以来、AIの業界標準ベンチマークであるMLPerfは、NVIDIA GPUのトレーニングおよび推論のリーディングパフォーマンスを詳細に示しています。 例えば、NVIDIA Grace Hopper Superchipsは最新の推論テストで圧倒的な成績を収めました。そのテスト以降にリリースされたNVIDIA TensorRT-LLM推論ソフトウェアは、パフォーマンスを最大8倍向上させ、エネルギー使用量と総所有コストを5倍以上削減します。実際、NVIDIA…

「加速、効率的なAIシステムの新しいクラスがスーパーコンピューティングの次の時代を示す」

エヌビディアは、今日のSC23で、科学や産業の研究センターを新たなパフォーマンスとエネルギー効率のレベルに引き上げる次世代のテクノロジーを発表しました。 同社の高性能コンピューティングおよびハイパースケールデータセンター事業の副社長であるイアン・バックは、この会議での特別なスピーチで、「エヌビディアのハードウェアとソフトウェアのイノベーションは、新しいAIスーパーコンピュータのクラスを創り出しています」と述べました。 これらのシステムの一部は、メモリ強化型のNVIDIA Hopperアクセラレータを搭載し、他のシステムは新しいNVIDIA Grace Hopperシステムアーキテクチャを搭載しています。すべてのシステムは、拡張された並列処理を使用して、生成AI、HPCおよびハイブリッド量子コンピューティングのためのスタックを実行するための加速ソフトウェアを使用します。 バックは新しいNVIDIA HGX H200を「世界最高のAIコンピューティングプラットフォーム」と表現しました。 NVIDIA H200 Tensor Core GPUsは、成長する生成AIモデルを実行するためのHBM3eメモリを搭載しています。 このGPUは、最初のAIアクセラレータとして超高速技術を使用した141GBのHBM3eを搭載しています。GPT-3などのモデルを実行する場合、NVIDIA H200 Tensor Core GPUsは前世代のアクセラレータに比べて18倍のパフォーマンス向上を提供します。 ほかの生成AIベンチマークの中でも、彼らはLlama2-13Bの大規模な言語モデル(LLM)で1秒あたり12,000トークンを処理します。 バックは、4つのNVIDIA GH200 Grace Hopper…

AIのオリンピック:機械学習システムのベンチマーク

何年もの間、4分以内で1マイルを走ることは、単なる困難な課題ではなく、多くの人にとっては不可能な偉業と考えられていましたそれは心理的、身体的な目標であり、多くの人がそうだと思っていました...

「MLCommonsがAIモデルを実行するための新しいベンチマーク速度テストを公開しました」

月曜日、AIのベンチマークグループであるMLCommonsが、最高のハードウェアがAIモデルをどれくらい高速に実行できるかを判断するための新しいテストの結果を発表しましたReutersによると、このテストのトップパフォーマーはNvidiaのチップでしたテストは大規模な言語...

「NVIDIA H100 Tensor Core GPUを使用した新しいMicrosoft Azure仮想マシンシリーズが一般利用可能になりました」

Microsoft Azureのユーザーは、最新のNVIDIAの高速計算技術を利用して、生成型AIアプリケーションのトレーニングと展開ができるようになりました。 本日から利用可能なMicrosoft Azure ND H100 v5 VMは、NVIDIA H100 Tensor Core GPUとNVIDIA Quantum-2 InfiniBandネットワーキングを使用しており、ブラウザからのクリック操作で生成型AI、高性能コンピューティング(HPC)などのアプリケーションをスケーリングできます。 全米の顧客に提供されるこの新しいインスタンスは、開発者や研究者が大規模な言語モデル(LLM)と高速計算を使用して新しい消費者およびビジネスのユースケースを見つけ出している時期に登場しました。 NVIDIA H100 GPUは、第4世代のTensor Cores、LLMの加速化に使用される新しいTransformer Engine、および各GPU間で900GB/secで通信できる最新のNVLink技術などのアーキテクチャイノベーションにより、スーパーコンピュータクラスのパフォーマンスを提供します。 また、NVIDIA Quantum-2 CX7 InfiniBandの採用により、3,200…

SiMa.aiが世界最強のAIチップをインドに持ち込む

アメリカのAIチップスタートアップ、SiMa.aiは、初代AIチップの量産を発表し、画期的な進展を遂げました。TSMC 16nmテクノロジーを利用し、SiMa.aiは産業界にAI革命をもたらすことを目的としています。一般的な手法が一つのチップで全てを対応するのに対し、SiMa .aiのMLSoC(Chip on a Machine Learning System)はエッジコンピューティングに特化して設計されています。この重要な進展により、産業分野において転換期を迎えることになります。 同様に読まれている記事:台湾企業が現代AIのバックボーンになった経緯 AIと機械学習で産業界を21世紀に引き上げる 創設者兼CEOのKrishna Rangasayee氏は、AIと機械学習によって物理的な世界に大きな改善がもたらされる可能性に興奮しています。SiMa.aiは、最先端の技術で産業界を21世紀に導くことを目指しています。彼らのビジョナリーなアプローチは、スマートカー、ドローン、高度なロボットなど多岐にわたる分野での革新を促進することを目的としています。 同様に読まれている記事:DeepMind RoboCat: 自己学習型ロボットAIモデル SiMa.aiが生成AI埋め込みエッジの未来に備える Rangasayee氏は声明で、SiMa.aiが生成AI埋め込みエッジの未来に備えていることを明らかにしました。クラウド、エッジ、またはモバイル電話の空間で作業しているかどうかに関係なく、生成AIと大規模言語モデル(LLM)が誰の革新にとっても不可欠なものになると信じているRangasayee氏は、これらの技術を採用することの重要性を強調しました。SiMa.aiの生成AIを先駆的に推進する取り組みは、産業界を革新する先見性のあるアプローチを示しています。 埋め込みエッジスペースにおける生成AIの台頭 生成AIは、近年著しい進展を遂げ、現在は埋め込みエッジスペースへ進出しています。Rangasayee氏は、生成AIがエンタープライズやエッジアプリケーションを含む実世界のアプリケーションへ移行していることに興味を持っています。生成AIの認知度と採用の拡大に伴い、この技術の変革的なポテンシャルはますます明らかになっています。生成AIの影響は急速に拡大し、世界中の10億人を魅了し、産業を再構築しています。 詳しくはこちら:DataHack Summit 2023にて、Diffusion Modelsによる生成AIの無限の世界を学ぶ非凡な学習体験に参加してください。 AIエッジデバイス上でLLMを実行することは有望なトレンド…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.