Learn more about Search Results Descript

- You may be interested

- サンディープ・シンと組んでGen AIの次の...

- 事例研究:Hugging Face Infinityとモダン...

- ソフトウェア開発の進化:ウォーターフォ...

- このAIの論文は、FELM:大規模な言語モデ...

- 「データ管理におけるメタデータの役割」

- 「高度な生成型AIの探求 | 条件付きVAEs」

- AWSとPower BIを使用して、米国のフライト...

- 高度なPython ドット演算子

- ジョージア工科大学の研究者が「ChattyChe...

- 「AIイメージジェネレータとは何ですか?2...

- Pythonでトレーニング済みモデルを保存す...

- 「テキスト生成推論によるコンピュータか...

- 「あなたのLLMアプリを守る必読です!」

- 『BOSSと出会ってください:新しい環境で...

- 「初心者であることを知られずに伝える、6...

「AIと産業のデジタル化の時代に、開かれたUSDに開発者が注目」 Note OpenUSD refers to an open-source software library called USD (Universal Scene Description), which is commonly used in computer graphics and animation.

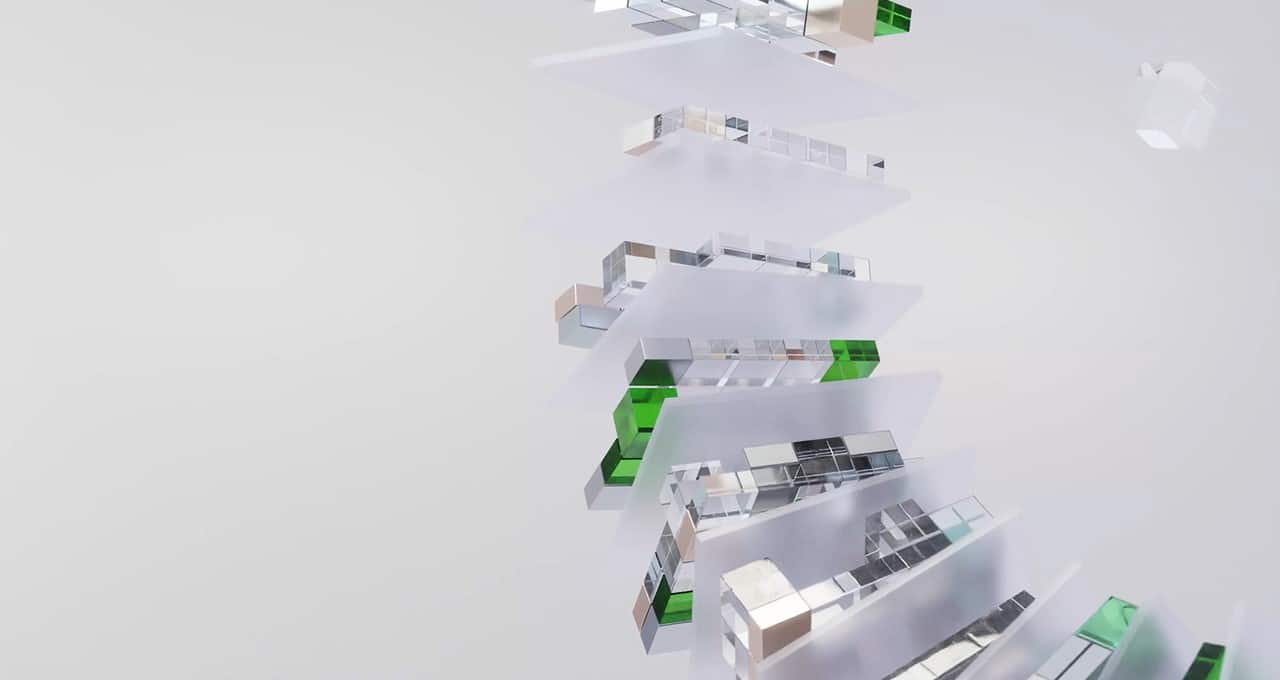

スマートファクトリーから次世代の鉄道システムまで、世界中の開発者と企業は、あらゆるスケールで産業のデジタル化の機会を追いかけています。 その鍵となるのは、オープンソースのUniversal Scene Description(USD)フレームワークであるOpenUSDと、AIによって駆動されたメタバースアプリケーションです。 OpenUSDは、元々ピクサーが大規模な映画パイプラインのために開発したもので、高品質な3Dワールドに強力なエンジンを提供するだけでなく、AIとメタバースの時代に対応した広範なエコシステムも提供しています。自動車、医療、製造など、さまざまな産業で、OpenUSDがさまざまなアプリケーションに採用されています。 開発者がOpenUSDを使用する方法 開発者はOpenUSDの拡張性を活用して、最新のAIツールやトップのデジタルコンテンツ作成ソリューションをカスタムの3Dワークフローとアプリケーションに統合することができます。 BMW Groupなどの企業では、社内の開発者がデジタルツインのユースケースを最適化し、相互作用するためのカスタムアプリケーションを開発しています。この自動車メーカーは、NVIDIA Omniverseを使用した仮想工場上でのリアルタイムの協力を可能にするアプリケーションを開発しました。NVIDIA Omniverseは、3Dツールを構築し接続するためのOpenUSD開発プラットフォームです。 Move.ai、SmartCow、ipologなどのスタートアップもOpenUSDを使用して画期的なメタバース技術を開発しています。Omniverseのモジュラー開発プラットフォームでUSDを使用することにより、スタートアップや中小企業は簡単にメタバース向けの新しいツールを立ち上げ、大企業が使用できるようにすることができます。 さらに、Esri、Bentley Systems、Vectorworksなどの主要な3Dソリューションプロバイダーは、OpenUSDと連携して新しい能力をメタバースに提供し、より多くの顧客にアプローチしています。OpenUSDを活用することで、彼らのアプリケーションは産業メタバースの進化するニーズに連続的に拡大することができます。 「USDのおかげで、3D設計プロセスにおいて顧客により柔軟性を提供することができます」と、VectorworksのシニアディレクターであるDave Donleyは述べています。「USDを受け入れることで、Vectorworksとそのユーザーは建築、景観デザイン、エンターテイメントなどの産業で、より協力的で革新的な未来を牽引することができます。」 開発者がOpenUSDを使用する理由 かつては、3Dコンテンツの作成では直線的で孤立したワークフローが一般的でした。今日、企業は多様で分散した高度なスキルを持つチームを統合し、競争力を維持するためにオファリングを拡大する必要があります。特に、生成型AIにおいてはそうです。 このためには、柔軟なデザインの共同作業が重要であり、開発者がオープンでモジュール化された拡張性のあるフレームワークで作業する能力も重要です。AIとメタバースのイノベーションのペースが加速するにつれて、閉じた環境で新機能や機能を構築しようとする企業は遅れを取る可能性があります。 メタバースの3Dワールドは、デザイン、シミュレーション、AIの進歩をもたらす新しい時代を迎えていますが、スケーラビリティと相互接続を可能にする共通のフレームワークが必要です。2Dウェブと同様に、メタバースの成功はオープンスタンダードとプロトコルによって規定される相互運用性に依存します。 OpenUSDは、拡張性とオブジェクトの定義とレンダリングのためのさまざまなプロパティをサポートする能力により、多様なメタバースアプリケーションに適しています。単なるファイルフォーマット以上のものであるこのインターチェンジフレームワークは、クリエイティブと開発者のツールのロバストなエコシステムを結びつけています。 3D地理空間ワークフローのプラットフォームであるCesiumは、建設、ロボット工学、シミュレーション、気候変動のためのデジタルツインなど、産業メタバースアプリケーションを構築するためにUSDを使用しています。 「USDの相互運用性を3D TilesとglTFと組み合わせることで、Bentley…

オムニバースへ:マーベラスデザイナーのためのUniversal Scene Descriptionサポートにより、ユーザーは3Dキャラクターのためのデジタルアセットや衣服をカスタマイズできます

注記:この記事は、アーティスト、開発者、企業が、Universal Scene DescriptionおよびNVIDIA Omniverseの最新の進歩を利用して、ワークフローを変換する方法に焦点を当てた月刊シリーズであるInto the Omniverseの一部です。 魚のヒレをアニメーションさせたり、デジタルキャラクターのおしゃれな衣装を作ったりする場合でも、クリエイターは、Marvelous Designerソフトウェアを利用して、3Dワークフローのためのアセット、衣服、その他の素材を作成および調整することができます。 Marvelous Designerは最近、Omniverse Connectorを発売しました。これは、そのソフトウェアとNVIDIA Omniverseの間で行われる協働ワークフローを強化するツールであり、3Dツールおよびアプリケーションを接続および構築するための開発プラットフォームであるNVIDIA Omniverseとの連携を図っています。 Connectorは、3Dツール間で共通の言語であるUniversal Scene DescriptionフレームワークであるOpenUSDをサポートするため、設計プロセスを大幅にスピードアップし、簡易化することができます。 通常のコンピューターグラフィックスパイプラインでは、アーティストは、作品を完成させるためにソフトウェア間を行き来する必要があります。新しいOmniverse Connectorにより、Marvelous DesignerのOpenUSDを介した改良されたインポートおよびエクスポート機能により、クリエイターは時間を節約することができます。 最近のライブストリームで、3DデザイナーのBrandon Yuは、新しいConnectorとOpenUSDを使用して、協働ワークフローを改善し、生産性を向上させ、創造的な可能性を拡大し、デザインプロセスを合理化する方法を共有しました。 MH Tutorials YouTubeチャンネルで15万人以上の登録者を持つMike…

バイトダンスAI研究がStemGenを紹介:音楽の文脈を聞いて適切に反応するためにトレーニングされたエンドツーエンドの音楽生成ディープラーニングモデル

音楽生成は、既存の音楽に存在するパターンと構造を模倣するためにモデルを訓練することで行われるディープラーニングの一環です。RNN、LSTMネットワーク、トランスフォーマーモデルなど、ディープラーニングの技術が一般的に使用されます。この研究では、音楽のコンテキストに応じて反応する非自己回帰型のトランスフォーマーベースのモデルを使用して音楽音声を生成する革新的なアプローチを探求しています。従来のモデルが抽象的な調整に頼っているのに対し、この新しいパラダイムは聞くことと反応することを重視しています。この研究では、フィールドの最新の進歩を取り入れ、アーキテクチャの改良について議論しています。 SAMIと字節跳動社の研究者は、音楽コンテキストに反応する非自己回帰型のトランスフォーマーベースのモデルを紹介し、MusicGenモデルのための公開されたエンコードチェックポイントを活用しています。評価には、Frechet Audio Distance(FAD)やMusic Information Retrieval Descriptor Distance(MIRDD)などの標準的な指標や音楽情報検索ディスクリプタのアプローチが使用されています。その結果、このモデルは客観的な指標と主観的MOSテストを通じて、競争力のある音声品質と強固な音楽のコンテキストに対する整合性を示しています。 この研究は、画像と言語処理からの技術を借用して、ディープラーニングを通じたエンドツーエンドの音楽音声生成の最新の進展を強調しています。音楽作曲におけるステムの整合性の課題を重視し、抽象的な調整に頼る従来のモデルに対する批判を行っています。音楽のコンテキストに対して反応するためのモデルに非自己回帰型のトランスフォーマーベースのアーキテクチャを使用するトレーニングパラダイムを提案しています。モデルの評価には、客観的な指標、音楽情報検索ディスクリプタ、および聴取テストが必要です。 この手法では、音楽生成に非自己回帰型のトランスフォーマーベースのモデルを使用し、別個の音声エンコーディングモデルで残差ベクトル量子化を組み合わせています。複数の音声チャンネルを連結された埋め込みを介して単一のシーケンス要素に組み合わせます。トレーニングにはマスキング手法が使用され、強化された音声コンテキストの整合性を向上させるためにトークンサンプリング中にクラシファイアフリーガイダンスが使用されます。フレーシェ音声距離や音楽情報検索ディスクリプタ距離などの客観的な指標によってモデルのパフォーマンスが評価されます。生成されたサンプルを実際のステムと比較することで評価が行われます。 この研究では、標準的な指標や音楽情報検索ディスクリプタアプローチ(FADやMIRDDなど)を使用して生成されたモデルを評価しています。実際のステムとの比較により、モデルは最先端のテキスト条件付きモデルと同等の音声品質を達成し、音楽のコンテキストに強い音楽的な整合性を示しています。音楽のトレーニングを受けた参加者を対象としたMean Opinion Scoreテストは、このモデルが現実的な音楽の結果を生成する能力を確認しています。生成されたステムと実際のステムの分布整合性を評価するMIRDDは、音楽の一貫性と整合性の尺度となります。 まとめると、行われた研究は以下のように要約できます: この研究では、音楽のコンテキストに応答できる生成モデルの新しいトレーニングアプローチを提案しています。 このアプローチは、トランスフォーマーバックボーンを持つ非自己回帰言語モデルと、未検証の2つの改良点(マルチソースのクラシファイアフリーガイダンスと反復デコーディング中の因果バイアス)を導入しています。 これらのモデルは、オープンソースおよび独自のデータセットでトレーニングすることで最先端の音声品質を達成しています。 標準的な指標や音楽情報検索ディスクリプタのアプローチによって最先端の音声品質が検証されています。 Mean Opinion Scoreテストは、モデルが現実的な音楽の結果を生成する能力を確認しています。

Sudowriteのレビュー:AIが人間らしい小説を書けるのか?

「AIは本当に人間のように小説を書くことができるのか? Sudowriteの詳細を知り、このSudowriteのレビューで真実を解明しましょう」

「Langchainの使い方:ステップバイステップガイド」

LangChain(ラングチェーン)は、プログラマーが大きな言語モデルを使用してアプリケーションを開発するための人工知能フレームワークです。LangChainの使用方法について詳しく見ていきましょう。 ステップ1: セットアップ LangChainを始める前に、適切に構成された開発環境があることを確認してください。PythonまたはJavaScriptなどの必要な依存関係をインストールしてください。LangChainは両方の言語に対応しており、開発者に柔軟性を提供します。 pip install langchain conda install langchain -c conda-forge ステップ2: LLM(Language Models) LangChainを効果的に使用するためには、モデルプロバイダーやデータストア、APIなどのさまざまなコンポーネントと統合することがしばしば必要です。ここでは、LangChainをOpenAIのモデルAPIと統合します。また、Hugging Faceを使用しても同様に行うことができます。 !pip install openaiimport osos.environ["OPENAI_API_KEY"] ="YOUR_OPENAI_TOKEN" from langchain.llms…

「AGIに向かって:LLMと基礎モデルが人生の学びの革命で果たす役割」

過去10年間、特にディープラーニングの成功を受けて、人工汎用知能(AGI)の構築の可能性について議論が続いています最終目標は...

「オープンソースツールを使用して、プロのように音声をクローンし、リップシンク動画を作る方法」

紹介 AI音声クローンはソーシャルメディアで大流行しています。これにより、創造的な可能性が広がりました。ソーシャルメディアで有名人のミームやAI声の上書きを見たことがあるかもしれません。それがどのように行われているのか疑問に思ったことはありませんか?Eleven Labsなど、多くのプラットフォームがAPIを提供していますが、オープンソースソフトウェアを使用して無料で行うことはできるのでしょうか?短い答えは「YES」です。オープンソースには音声合成を実現するためのTTSモデルとリップシンクツールがあります。したがって、この記事では、音声クローンとリップシンクのためのオープンソースのツールとモデルを探求してみましょう。 学習目標 AI音声クローンとリップシンクのためのオープンソースツールを探求する。 FFmpegとWhisperを使用してビデオを転写する。 Coqui-AIのxTTSモデルを使用して声をクローンする。 Wav2Lipを使用してビデオのリップシンクを行う。 この技術の実世界での使用例を探求する。 この記事はData Science Blogathonの一環として公開されました。 オープンソーススタック 既にご存じのように、私たちはOpenAIのWhisper、FFmpeg、Coqui-aiのxTTSモデル、およびWav2lipを私たちの技術スタックとして使用します。しかし、コードに入る前に、これらのツールについて簡単に説明しましょう。そして、これらのプロジェクトの作者に感謝します。 Whisper: WhisperはOpenAIのASR(自動音声認識)モデルです。これは、多様なオーディオデータと対応するトランスクリプトを用いて、650,000時間以上のトレーニングを受けたエンコーダ-デコーダトランスフォーマーモデルです。そのため、オーディオからの多言語の転写に非常に適しています。 エンコーダは、30秒のオーディオチャンクのログメルスペクトログラムを受け取ります。各エンコーダブロックは、オーディオ信号の異なる部分を理解するためにセルフアテンションを使用します。デコーダは、エンコーダからの隠れ状態情報と学習済みの位置エンコーディングを受け取ります。デコーダはセルフアテンションとクロスアテンションを使用して次のトークンを予測します。プロセスの最後に、認識されたテキストを表すトークンのシーケンスを出力します。Whisperの詳細については、公式リポジトリを参照してください。 Coqui TTS: TTSはCoqui-aiのオープンソースライブラリです。これは複数のテキスト読み上げモデルをホストしています。Bark、Tortoise、xTTSなどのエンドツーエンドモデル、FastSpeechなどのスペクトログラムモデル、Hifi-GAN、MelGANなどのボコーダなどがあります。さらに、テキスト読み上げモデルの推論、調整、トレーニングのための統一されたAPIを提供しています。このプロジェクトでは、xTTSというエンドツーエンドの多言語音声クローニングモデルを使用します。これは英語、日本語、ヒンディー語、中国語などを含む16の言語をサポートしています。TTSについての詳細情報は、公式のTTSリポジトリを参照してください。 Wav2Lip: Wav2Lipは、「A Lip Sync…

ChatGPTが知能的ですか? 科学的なレビュー

約1年前、OpenAIはChatGPTをリリースし、世界中を席巻しましたChatGPTは、コンピュータとの対話を、従来のより制約の少ない、より自然な言語で行うという完全に新しいアプローチを取り入れました

「ニュースレコメンデーションのための大規模な言語モデルとベクトルデータベース」

大規模言語モデル(LLM)は、Chat-GPTやBardなどの生成型AIツールの最新リリースにより、機械学習コミュニティ全体で大きな話題となりましたその中核となるアイデアの1つは...

「Amazon SageMaker Pipelines、GitHub、およびGitHub Actionsを使用して、エンドツーエンドのMLOpsパイプラインを構築する」

機械学習(ML)モデルは孤立して動作するものではありません価値を提供するためには、既存の製造システムやインフラに統合する必要がありますそのため、設計と開発の過程でMLライフサイクル全体を考慮する必要がありますMLオペレーション(MLOps)は、MLモデルの生涯にわたって効率化、自動化、およびモニタリングを重視しています堅牢なMLOpsパイプラインを構築するには、異なる部門間の協力が求められます[…]

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.